Un modello neuromorfico di visione attiva mostra come la codifica spatiotemporale nei neuroni lobula delle api faciliti il riconoscimento di pattern complessi, offrendo un quadro che integra neuroscienze, comportamento animale e calcolo computazionale. Lo studio, guidato da HaDi MaBouDi e pubblicato su eLife, evidenzia come insetti con risorse neurali limitate riescano a raggiungere capacità visive e di apprendimento di sorprendente efficacia. Attraverso la simulazione di reti neurali ispirate alla biologia, i ricercatori hanno ricreato l’interazione tra dinamiche di volo, scansione visiva e rappresentazione neurale, ipotizzando che strategie di campionamento attivo abbiano co-evoluto con meccanismi di codifica efficiente.

Il modello ispirato al percorso visivo delle api

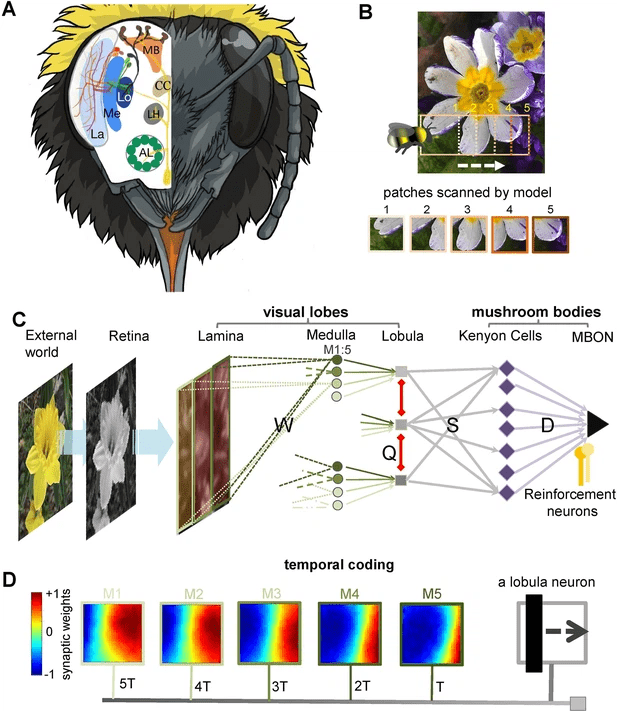

Il framework simula l’intero percorso visivo delle api, dalla retina fino al corpo fungiforme. I ricercatori hanno modellato una matrice di 75 x 75 fotorecettori verdi, proiettati su 625 neuroni della lamina, successivamente ridotti a 250 neuroni della medulla a campo ristretto e infine integrati nei neuroni lobula con ritardi temporali progressivi. Questo schema riproduce la scansione sequenziale tipica del volo.

Una componente cruciale è l’introduzione di inibizione laterale nei neuroni lobula, che rafforza la selettività e riduce la ridondanza. Questi neuroni proiettano sulle cellule Kenyon del corpo fungiforme, connesse in modo sparso e casuale, e da lì a un singolo neurone di output che integra le informazioni. Le regole di apprendimento utilizzate combinano la plasticità Hebbiana (Oja) con la spike-timing dependent plasticity (iSTDP), modulata da neuromodulatori come dopamina e octopamina per distinguere segnali premianti e punitivi.

Addestrato su 50.000 patch visive tratte da 100 immagini naturali di fiori e ambienti, il modello riproduce l’evoluzione delle risposte neuronali in condizioni realistiche. L’apprendimento non associativo nei neuroni lobula induce l’emergere di cellule selettive per orientamento, mentre l’integrazione con il corpo fungiforme consente discriminazioni associative di pattern complessi.

Risultati sulla selettività e sparsità neurale

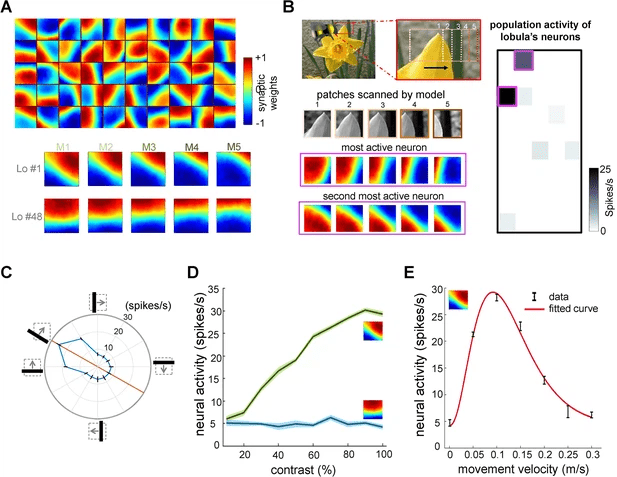

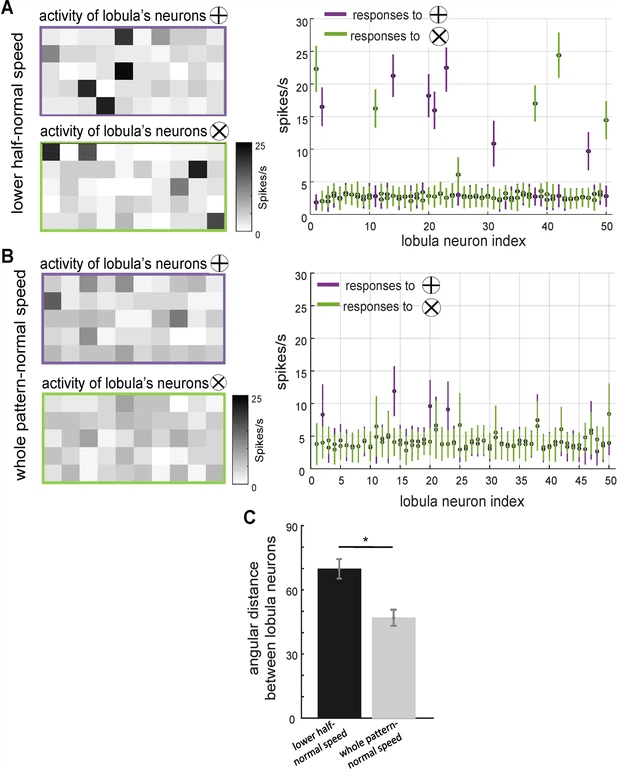

Il modello mostra neuroni lobula che si auto-organizzano in cellule specializzate per specifici orientamenti visivi. Questi neuroni rispondono in modo sparso e decorrelato, aumentando l’efficienza del processamento. Le simulazioni indicano tuning preferenziali a determinati angoli, sensibilità a variazioni di contrasto e modulazioni in base alla velocità del movimento.

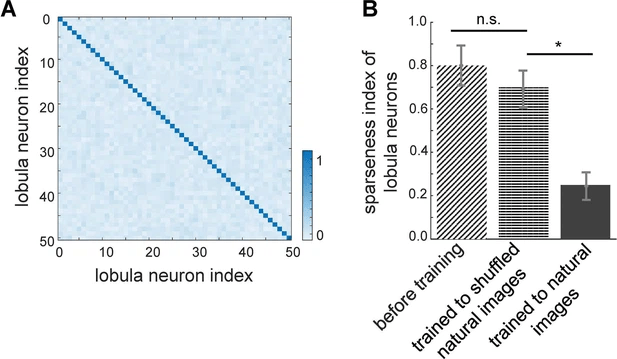

La codifica risulta più robusta quando l’input proviene da scene naturali, confermando che la struttura statistica dell’ambiente gioca un ruolo chiave nell’ottimizzazione delle rappresentazioni neurali. L’indice di Treves-Rolls quantifica l’aumento della sparsità, dimostrando una riduzione della ridondanza informativa. Le matrici di correlazione post-addestramento risultano quasi diagonali, evidenziando la capacità del modello di comprimere le feature visive in rappresentazioni compatte.

Performance in compiti di riconoscimento pattern

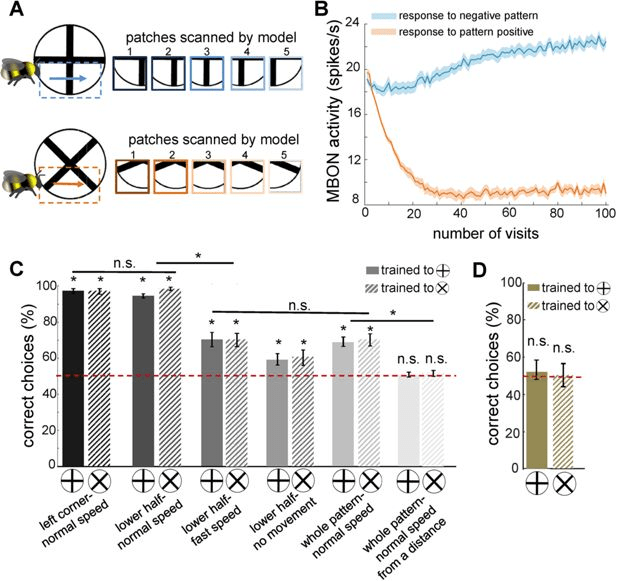

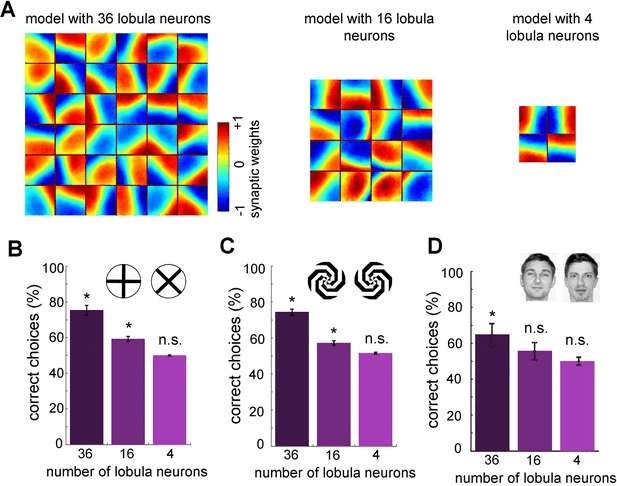

Il modello esteso al corpo fungiforme consente il riconoscimento di pattern visivi complessi, replicando esperimenti comportamentali sulle api. Raggiunge accuratezza superiore al 96% nella discriminazione di figure come barre inclinate, croci e spirali, e mostra persino la capacità di distinguere volti umani, pur fallendo in arrangiamenti più astratti come i quadranti combinati.

La performance migliora in modo significativo quando la scansione visiva è localizzata su porzioni specifiche dell’immagine, ad esempio la metà inferiore, suggerendo che il comportamento di volo attivo contribuisca a potenziare la selettività neurale. Con solo 36 neuroni lobula, il modello mantiene prestazioni sopra la media, confermando che la sparsità e la plasticità sono sufficienti a garantire riconoscimenti efficaci.

Implicazioni per la codifica efficiente

Il modello supporta la teoria della codifica efficiente, secondo cui i sistemi sensoriali evolvono per sfruttare le regolarità statistiche delle scene naturali, comprimendo l’informazione con il minimo dispendio energetico. Le strategie di scansione attiva e la plasticità neurale rendono le rappresentazioni più robuste, migliorano la discriminazione di pattern e riducono la ridondanza.

Le implicazioni si estendono oltre il mondo degli insetti: i principi individuati sono potenzialmente generalizzabili ad altri sistemi sensoriali, inclusi quelli dei mammiferi. Inoltre, i risultati offrono spunti per lo sviluppo di sistemi bio-ispirati di visione artificiale, utili in robotica autonoma e droni, dove risorse computazionali e consumo energetico devono essere ottimizzati.

Approfondimenti sul corpo fungiforme

L’integrazione del corpo fungiforme nel modello mostra come le connessioni sparse con le cellule Kenyon e la modulazione dopaminergica/octopaminergica supportino l’apprendimento associativo. I pattern premianti riducono la risposta del neurone output tramite octopamina, mentre quelli punitivi la amplificano con dopamina. Questo schema rispecchia le osservazioni neurobiologiche sulle api reali, che utilizzano questi meccanismi per distinguere fiori utili da quelli dannosi durante il foraggiamento.

Il modello, pur basato su una semplificazione bidimensionale e sull’uso di soli fotorecettori verdi per efficienza computazionale, apre prospettive di ricerca verso simulazioni più realistiche in 3D e con l’inclusione del colore. L’accesso al codice su GitHub e la disponibilità di protocolli completi di simulazione garantiscono la riproducibilità, rendendo questo lavoro un punto di riferimento per le neuroscienze computazionali.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU...