L’ingresso di Google Quantum AI nel DARPA Quantum Benchmarking Initiative (QBI) segna un passaggio strategico per accelerare lo sviluppo di un computer quantistico fault-tolerant con valore computazionale reale entro il 2033. Il programma, distinto dal precedente Quantum Benchmarking e in continuità con US2QC, punta a validare con benchmark imparziali piattaforme e algoritmi che offrano quantum advantage verificato su problemi industriali e scientifici, superando il rapporto costi/benefici delle soluzioni classiche. La Fase A affida a performer come Google la definizione di concetti plausibili e di una roadmap utility-scale, seguita da R&D e prototipi con verifiche di terze parti. La sfida centrale riguarda la correzione degli errori quantistici, la scalabilità dei qubit logici, l’integrazione ibrida classico-quantistica e la sicurezza dell’intero ciclo di vita, dall’hardware criogenico alle API in cloud. L’iniziativa mira a impatti concreti su sicurezza nazionale, medicina, energia e machine learning, riducendo l’hype e aumentando la misurabilità dell’utilità.

Che cos’è il DARPA Quantum Benchmarking Initiative?

Il DARPA QBI nasce per rispondere a una domanda precisa: quando un sistema quantistico può dirsi utile su scala industriale, cioè quando il valore computazionale eccede i costi prodotti dall’hardware, dal controllo e dall’energia necessaria a mantenerlo operativo. Per evitare metriche autoreferenziali, il programma impone benchmark terzi, riproducibili e significativi per casi d’uso reali. L’obiettivo non è dimostrare un record accademico, ma certificare utilità misurabile su problemi che i sistemi classici affrontano con tempi, costi o consumi proibitivi. In questo quadro, QBI differenzia chiaramente la misurazione della performance dall’esplorazione teorica: ogni risultato deve collegare fidelity, tasso d’errore e quantum volume a un TCO sostenibile, includendo supply chain, manutenzione e personale qualificato.

Perché la selezione di Google Quantum AI conta

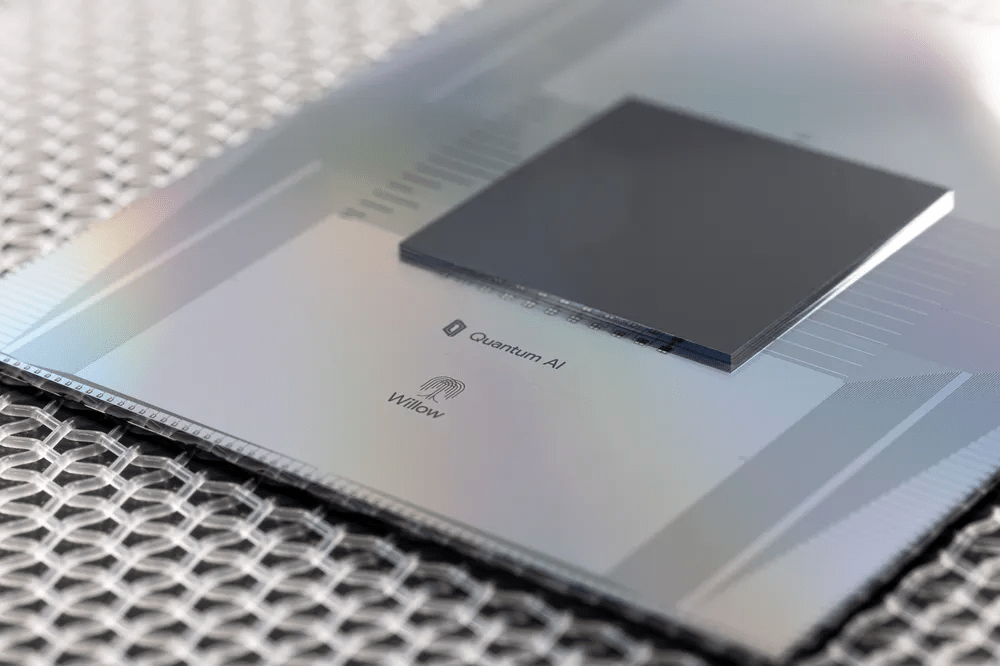

La scelta di Google Quantum AI come performer in Fase A riflette la maturità di un approccio centrato su superconducting qubits, controllo di precisione e codici di superficie per l’error correction. L’esperienza sul processore Sycamore e la disponibilità di strumenti open source come Cirq abilitano un ecosistema in cui dataset, pipeline di calibrazione ML-driven e protocolli di mitigazione degli errori alimentano un ciclo di miglioramento continuo. La camera di diluizione a millikelvin, la riduzione del crosstalk nei cablaggi e l’adozione di AI per il tuning dei gate sono elementi tecnici che spostano il focus dal semplice conteggio dei qubit alla qualità dei qubit logici generati via surface code. In prospettiva QBI, questo significa partire con una base hardware e software già auditabile, riducendo l’incertezza sulla scalabilità e sulla ripetibilità delle prove.

Roadmap 2033: fasi, metriche e verifica indipendente

Il percorso QBI prevede una Fase A di definizione del concetto utility-scale e del percorso di fattibilità, una Fase B di R&D focalizzata su prototipi e mitigazione dei rischi, e una Fase C di validazione indipendente fino al 2033. L’accento cade su metriche oggettive: fidelity di gate nell’ordine del 99,9%, error rate spinto verso 10^-6 per comporre qubit logici stabili, coerenza sufficiente a sostenere circuiti profondi e quantum volume che indichi progressi non solo quantitativi ma utili. La verifica di terze parti e la separazione tra chi progetta e chi certifica evitano conflitti d’interesse e consolidano la fiducia dei decisori pubblici e industriali.

Governance e neutralità delle valutazioni

QBI impone una governance trasparente per scongiurare bias. La validazione esterna standardizza condizioni di test, dataset e criteri di accettazione. La pubblicazione di whitepaper metodologici, l’allineamento con NIST, ETSI e IEEE e l’adozione di audit indipendenti rendono i risultati trasferibili tra laboratori e provider, creando un linguaggio comune per misurare l’utilità quantistica in termini operativi e finanziari.

Metriche tecniche e soglie di utilità

La soglia utility-scale non coincide con un numero “magico” di qubit fisici, ma con la capacità di mantenere qubit logici con tassi d’errore sotto soglia, sostenere circuiti profondi e dimostrare speedup su problemi di riferimento, a parità di costo e vincoli energetici. QBI incorpora nel calcolo energia di raffreddamento, overhead di controllo, orchestrazione ibrida e costi di personale, così da evitare dimostrazioni brillanti ma economicamente insostenibili.

Errori, decoerenza e codici di superficie

La correzione degli errori quantistici rappresenta il cuore tecnico della fault-tolerance. La decoerenza su scale di millisecondi, il rumore di controllo e il crosstalk impongono strategie multilivello: codici di superficie per costruire qubit logici robusti, mitigazione software per ridurre errori residui e ottimizzazione ML per tarare più rapidamente pulse e sequenze di gate. La realtà operativa è l’overhead: per un qubit logico affidabile servono spesso centinaia o migliaia di qubit fisici. In questo contesto, la qualità dei materiali, la fabbricazione con yield elevati, la stabilità criogenica e la razionalizzazione dei cablaggi determinano la scalabilità più della sola architettura. Il Threshold Theorem fornisce il quadro teorico: sotto una certa soglia di errore, la scalabilità è possibile; sopra, l’aumento dei qubit peggiora il sistema. QBI traduce questa teoria in milestone verificabili, incentivando progressi che abbassino error rate senza far esplodere costi e consumo energetico.

Use case ad alta utilità: difesa, salute, energia

L’utilità richiesta dal QBI guarda a casi d’uso concreti. Nella sicurezza nazionale, simulazioni quantum-accelerated per la modellazione di materiali avanzati, l’analisi di reti complesse e la ricerca operativa su scenari tattici richiedono qubit logici stabili e pipeline ibridi che sfruttino l’HPC classico per il pre- e post-processing. In medicina, la simulazione molecolare può ridurre tempi di drug discovery, soprattutto in chimica quantistica dove lo scaling classico è proibitivo. Nell’energia, l’ottimizzazione di reti elettriche, storage e cattura CO₂ beneficia di routine variational e algoritmi ibridi che impiegano il quantistico sul nucleo intractable del problema e il classico per l’execution massiva. Il QBI, definendo benchmark verificabili, separa ambizioni da utilità reale, chiarendo quando un quantum advantage diventa vantaggio economico.

Implicazioni geostrategiche e regolatorie

La traiettoria QBI si incastra con la National Quantum Initiative, il CHIPS Act e la cooperazione con DOE, NSA e alleanze come Five Eyes e NATO. L’obiettivo è presidiare supply chain, IP e standard per evitare lock-in tecnologici e dipendenze critiche. In Europa, il Quantum Flagship, Horizon Europe e i quadri NIS2, GDPR ed ENISA delineano un perimetro che, pur distinto, può interoperare su metriche, benchmark e best practice. La convergenza tra PQC standardizzata da NIST e QKD in contesti sensibili offre un ponte tra protezione attuale e preparazione post-quantum, limitando rischi di harvest-now, decrypt-later.

Rischi cyber e misure di sicurezza operative

L’avanzamento quantistico apre superfici d’attacco nuove e note. La sicurezza QBI non si limita al laboratorio: include firmware dei controllori, API per job submission, gestione delle identità, telemetria e supply chain di componenti criogenici. La combinazione di zero trust, segmentazione tra domini classico e quantistico, monitoraggio comportamentale su control-plane e hardening contro side-channel riduce il rischio di abusi di fiducia e esfiltrazione. A livello umano, le campagne di awareness, la protezione di MFA e la riduzione delle frodi vocali e del vishing diventano indispensabili in ambienti ad alto valore informativo. L’adozione di PQC nelle dorsali e di HSM conformi FIPS per il key management crea un baseline robusto in attesa della piena maturità fault-tolerant.

Ecosistema industriale e formazione del talento

QBI non mira a un unico vincitore, ma a una rete di performer che condividano metodi e risultati verificabili. Il finanziamento diffuso abbassa l’incertezza per startup e grandi vendor, favorisce la collaborazione con le università e stimola programmi PhD mirati a error correction, materiali superconduttivi, criogenia e compilatori quantistici. Strumenti come Cirq e l’integrazione con ambienti cloud-quantum abbassano la barriera d’ingresso per l’industria, mentre dataset condivisi accelerano la riproducibilità. In questo contesto, la selezione di Google Quantum AI funge da volano per investimenti privati e per la creazione di competenze verticali lungo tutta la filiera.

Come misurare il quantum advantage senza hype

Il quantum advantage non è un proclama, ma un delta misurabile rispetto al migliore riferimento classico, a parità di costo, energia e SLA. QBI richiede protocolli di confronto che includano ottimizzazioni classiche avanzate, simulatori tensor-network e HPC multi-GPU, evitando strawman antiquati. La metrica composita deve pesare tempo-al-risultato, energia consumata, affidabilità del risultato e costo per job, producendo una curva costo-prestazioni che indichi quando e dove il quantistico conviene davvero. In ambito operativo, l’affidabilità e la ripetibilità contano quanto il throughput: un sistema utility-scale è quello che fornisce risposte corrette con SLA e budget coerenti con l’uso industriale.

Cosa aspettarsi nei prossimi step

La Fase A definisce entro breve una roadmap plausibile con milestone, riskiest assumptions e criteri di uscita. La Fase B costruisce prototipi per ridurre l’incertezza tecnica su error rate, coerenza e overhead dei qubit logici, portando evidenze su scalabilità e stabilità di medio periodo. La Fase C porta a validazioni indipendenti, report anonimizzati e metriche armonizzate per settori critici. Nell’arco 2028-2033, la traiettoria punta a sistemi fault-tolerant su task mirati, con integrazione ibrida in workflow professionali e presidi di sicurezza allineati a standard federali e internazionali.

Selezione di Google e approccio tecnico: punti qualificanti

La proposta di Google Quantum AI enfatizza error correction con surface code, qubit logici già dimostrati su scala decine e pipeline AI per l’autotuning. L’uso di cryogenics avanzata, l’attenuazione del crosstalk e l’automazione delle calibrazioni riducono i tempi morti e migliorano l’uptime utile per i benchmark. La condivisione di dataset, la pubblicazione peer-review e l’adozione di Cirq come base riproducibile offrono a DARPA una piattaforma auditabile su cui innestare test indipendenti, riducendo lo scarto tra demo e operatività. In ottica QBI, questo bilanciamento tra teoria e ingegneria eleva la probabilità di raggiungere utility-scale entro la finestra 2033, soprattutto su domini come simulazioni chimiche e ottimizzazione combinatoria.

Implicazioni per policy, supply chain e standard

La spinta su standard aperti, metriche armonizzate e audit esterni aiuta a evitare silos proprietari che rallentano l’adozione industriale. La sicurezza della supply chain, dai substrati superconduttivi ai controllori RF, diventa requisito per affidabilità e conformità. Sul lato policy, la convergenza tra standard PQC NIST, linee guida ENISA e specifiche ETSI prepara migrazioni quantum-safe graduali, riducendo il rischio di backward incompatibility. QBI, definendo benchmark trasparenti, può fungere da ponte tra ecosistemi normativi, favorendo interoperabilità e scalabilità internazionale.

Per dimostrare fault-tolerance utility-scale in linea con gli obiettivi QBI, un protocollo di prova tecnicamente robusto dovrebbe integrare tre pilastri. Primo, calibrazione continua guidata da AI con telemetria su fidelity di gate, tasso d’errore, T₁/T₂ e crosstalk, legando ogni miglioramento a qubit logici contabilizzati via surface code. Secondo, benchmark applicativi su chimica quantistica e ottimizzazione dove il frontier classico rappresenta davvero il best-in-class (HPC multi-GPU, tensor network avanzati), con confronto su tempo-al-risultato, energia e costo per job. Terzo, validazione indipendente con dataset pubblici, report firmati da terze parti e riproducibilità cross-lab, includendo fault injection e test di resilienza a disturbi controllati. Un tale impianto traduce la retorica del quantum advantage in evidenza ingegneristica e sostenibilità economica, minimizzando l’hype e massimizzando il transfer in produzione.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.