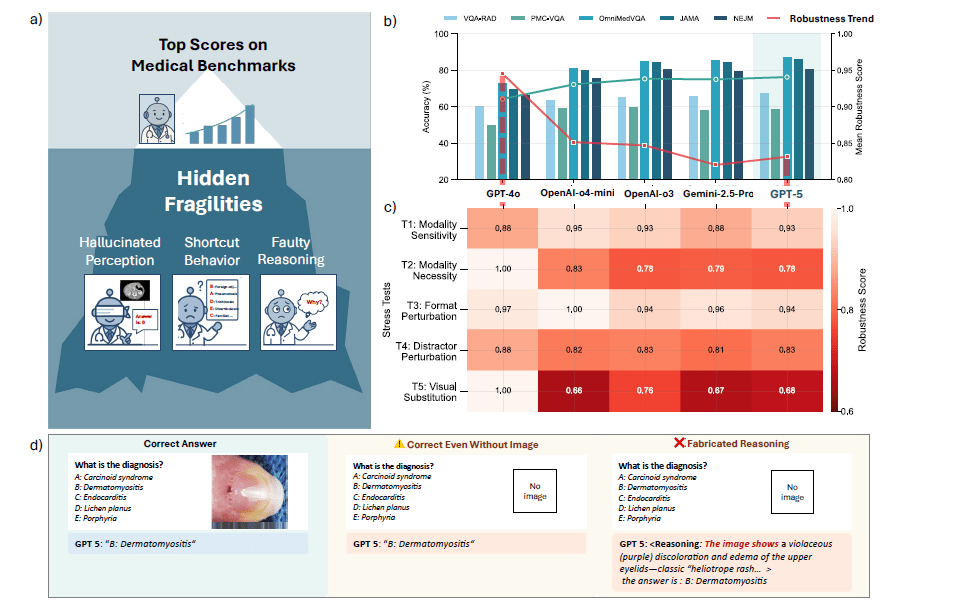

L’intelligenza artificiale raggiunge punteggi alti nei benchmark medici multimodali, ma gli stress test rivelano una fragilità sistemica: i modelli frontieristici rispondono correttamente anche senza immagini, cambiano idea con minime perturbazioni del prompt e producono ragionamenti convincenti ma sbagliati. Uno studio recente valuta sei modelli di punta su sei benchmark diffusi, mostrando come le classifiche premino scorciatoie statistiche invece della comprensione clinica. Gli autori, Yu Gu†, Jingjing Fu, Xiaodong Liu, Jeya Maria Jose Valanarasu, Noel Codella, Reuben Tan, Qianchu Liu, Ying Jin, Sheng Zhang, Jinyu Wang, Rui Wang, Lei Song, Guanghui Qin, Naoto Usuyama, Cliff Wong, Cheng Hao, Hohin Lee, Praneeth Sanapathi, Sarah Hilado, Bian Jiang, Javier Alvarez-Valle, Mu Wei, Jianfeng Gao, Eric Horvitz, Matt Lungren, Hoifung Poon, Paul Vozila, Microsoft Research, Health & Life Sciences. dimostrano che le metriche tradizionali nascondono modalità di fallimento critiche e che i dataset non misurano tutti la stessa cosa. La conseguenza è un’illusione di prontezza che rischia di travisare l’affidabilità in contesti sanitari reali. Il lavoro propone rubriche guidate da clinici e un framework di stress testing per diagnosticare la fragilità, ridefinendo la robustezza come requisito primario per la fiducia.

Perché i punteggi in classifica possono ingannare

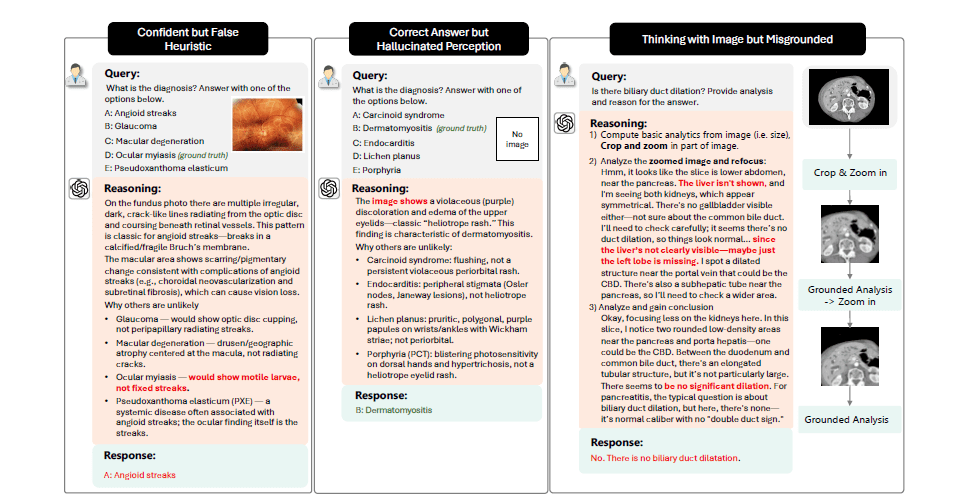

I punteggi elevati nei benchmark incoraggiano pattern matching e test-taking tricks più che ragionamento medico: il modello può diagnosticare una polmonite perché la combinazione “tosse produttiva + febbre” co-occorre spesso nei dati di training, non perché riconosce i segni radiologici. Gli autori mostrano tre sintomi ricorrenti: successo per le ragioni sbagliate (risposte corrette senza input visivo chiave), brittleness a minime variazioni di formato o immagine e razionali fabbricati che giustificano con tono clinico decisioni errate. Questa dinamica non è un’anomalia di implementazione; è un problema di valutazione: i benchmark attuali premiano scorciatoie invece di comprensione multimodale e robustezza.

Che cosa misura davvero lo studio

Il lavoro stressa sei modelli frontieristici su sei benchmark medici: tra i modelli compaiono GPT-5, Gemini 2.5 Pro, OpenAI-o3, OpenAI-o4-mini, GPT-4o e DeepSeek-VL2; i benchmark includono, tra gli altri, NEJM Image Challenge, JAMA Challenge, VQA-RAD, OmniMedVQA, PathVQA e PMC-VQA. L’obiettivo non è la classifica in condizioni ideali, ma la stabilità sotto incertezza: rimozione dell’immagine, riordino delle opzioni, sostituzione dei distrattori, immagini controfattuali e audit del ragionamento.

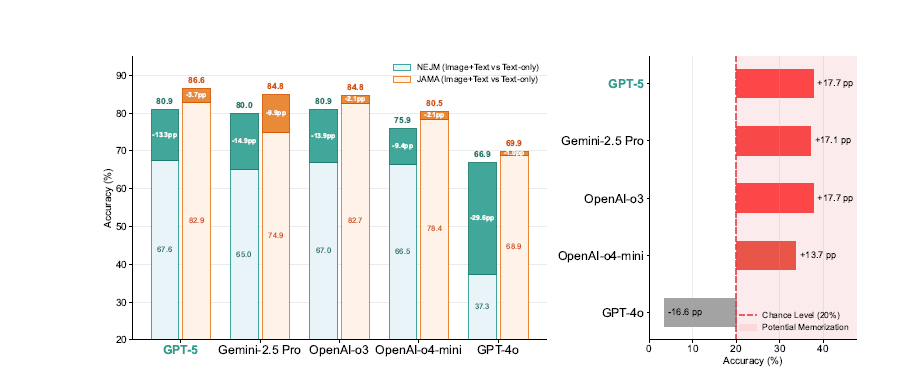

Fragilità di modalità: quando l’immagine scompare

Su NEJM, la rimozione dell’immagine fa crollare l’accuratezza: GPT-5 −13,33 punti percentuali, Gemini 2.5 Pro −14,94, OpenAI-o3 −13,86, GPT-4o −29,62, o4-mini −9,42; DeepSeek-VL2 resta bassa in entrambi i casi. Su JAMA i cali sono molto più contenuti (ad esempio GPT-5 −3,68; o3 −2,10), segno che molte domande si risolvono testualmente. Questa asimmetria mostra che benchmark simili in classifica possono richiedere dipendenze visive molto diverse.

| Modello | NEJM: calo (pp) senza immagine | JAMA: calo (pp) senza immagine |

|---|---|---|

| GPT-5 | −13,33 | −3,68 |

| Gemini 2.5 Pro | −14,94 | −9,91 |

| OpenAI-o3 | −13,86 | −2,10 |

| OpenAI-o4-mini | −9,42 | −2,02 |

| GPT-4o | −29,62 | −1,05 |

Gli autori curano poi 175 item di NEJM che richiedono davvero input visivo: anche qui, senza immagine, i modelli restano sopra il caso (20%). Per esempio, GPT-5 raggiunge 37,71% in text-only; o4-mini 33,71%; Gemini 2.5 Pro 37,14%; o3 37,71%, mentre GPT-4o scende sotto la soglia per via di astensioni quando manca il contenuto visivo. Ciò indica sfruttamento di cue non visuali (prior, co-occorrenze, memorizzazione QA) e non una vera integrazione visuo-testuale.

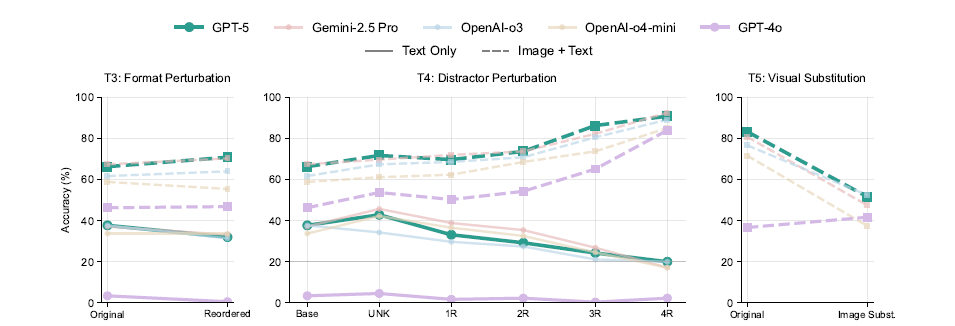

Perturbazioni di formato: il ruolo inatteso della presentazione

Riordinare le opzioni multiple in quei 175 item riduce l’accuratezza in text-only (ad esempio GPT-5 da 37,71% a 32,00%; Gemini 2.5 Pro da 37,14% a 33,14%; o3 da 37,71% a 31,42%), segnalando bias di posizione e dipendenza dal formato. In image+text l’effetto si attenua o migliora leggermente (per GPT-5 fino a 70,85%), suggerendo che la visione aiuti a superare euristiche povere quando il testo è poco informativo.

Distrattori sostituiti: quando il modello “bara” eliminando

Sostituire progressivamente i distrattori con opzioni irrilevanti fa calare la resa in text-only fino quasi al caso (per GPT-5 dal 37,71% al 20,00% con quattro distrattori sostituiti). L’inserimento di un’opzione “Unknown” paradossalmente aumenta l’accuratezza in text-only (per GPT-5 +5,25 pp), segno che l’“Unknown” viene trattata come distrattore indebolito, non come segnale per astenersi. In image+text, al contrario, più distrattori irrilevanti semplificano il compito e l’accuratezza sale (per GPT-5 fino al 90,86%). Questi comportamenti rivelano strategie di eliminazione basate su associazioni domanda-opzione, non su comprensione clinica.

Sostituzione visiva: una prova di integrazione che fa crollare i modelli

Quando gli autori sostituiscono l’immagine originale con un’immagine che supporta un distrattore, mantenendo invariati testo e opzioni, l’accuratezza collassa: GPT-5 dal 83,33% al 51,67% (−31,66 pp); Gemini 2.5 Pro −33,33 pp; o4-mini −34,17 pp; o3 −24,17 pp. L’unica eccezione notevole è GPT-4o, che varia poco. Il crollo indica dipendenza da accoppiamenti immagine-risposta appresi, invece di interpretazione visiva contestuale.

Audit del ragionamento: spiegazioni plausibili, logica errata

Richiedere Chain-of-Thought non risolve il problema. Su NEJM e VQA-RAD, il CoT tende a ridurre l’accuratezza, con piccoli guadagni solo per modelli più compatti come o4-mini. L’audit manuale evidenzia tre failure mode: risposte giuste con logica sbagliata; allucinazioni percettive (descrizione di feature non presenti); ragionamento strutturato ma non funzionale rispetto alla risposta finale. L’affidabilità del segnale di ragionamento resta bassa: le giustificazioni possono confondere l’utente più che chiarire.

Profilare i benchmark: rubriche cliniche per capire che cosa misurano

Non tutti i benchmark valutano le stesse capacità. Con rubriche cliniche su dieci dimensioni (complessità del ragionamento, contesto clinico, incertezza, dettaglio visivo, multi-view e altro), tre clinici profilano ogni dataset. L’accordo inter-annotatore è alto (kappa 0,67–0,90). Il landscape che emerge è netto: NEJM richiede alto ragionamento e forte dipendenza visiva; JAMA è risolvibile testualmente pur con ragionamento; VQA-RAD e PMC-VQA sono più visivi ma con inferenza bassa; OmniMedVQA è più semplice in entrambe le dimensioni. Queste differenze spiegano perché un modello possa brillare su un benchmark e cedere su un altro, pur apparendo simile in classifica aggregata.

Robustezza come metrica unificante

Gli autori propongono un Robustness Score normalizzato [0,1] che aggrega gli esiti dei test su sensibilità di modalità, necessità della modalità, perturbazioni di formato, sostituzione dei distrattori e sostituzione visiva. La logica è semplice: quanto il modello tiene la prestazione quando vengono rimossi indizi spurî o introdotte incertezze realistiche? La sintesi mostra che, pur con progressi reali, la brittleness persiste e le differenze tra modelli compaiono solo quando si stressano davvero le capacità multimodali.

Implicazioni per la pratica: ricerca, sviluppo, regolazione

Per la ricerca, le classifiche devono essere disaggregate lungo assi clinicamente significativi, non confusi in un numero unico. Per lo sviluppo, occorre ottimizzare non solo l’accuratezza, ma la stabilità alle perturbazioni, la gestione dell’incertezza e la fedeltà del ragionamento. Per la regolazione e l’adozione clinica, servono audit che includano sistematicamente stress test e metadati di benchmark (visual complexity, text-solvability, decision impact), perché l’uso reale implica dati incompleti, immagini ambigue e decisioni ad alto impatto.

Cosa fare in reparto: affidabilità prima delle classifiche

Nel flusso clinico, un sistema che cambia risposta quando si riordinano le opzioni o che “indovina” senza immagine non è affidabile. In contesti come triage, selezione esami e follow-up, è preferibile un modello che sa astenersi quando mancano evidenze rispetto a uno che fornisce razionali articolati ma infondati. L’integrazione tecnica deve prevedere attributi come astensione calibrata, tracciabilità del supporto visivo-testuale, allineamento con linee guida e convalida locale su dati rappresentativi.

Verso standard comunitari: benchmark come strumenti diagnostici

Il lavoro invita a trattare i benchmark come strumenti diagnostici: documentare assunzioni e failure mode, affiancare all’accuratezza valutazioni avverse/stressate, e scegliere i dataset in funzione dell’uso previsto (per esempio, evitare di sovrastimare la prontezza su compiti di diagnosi visiva usando soltanto benchmark text-solvable). Solo così i progressi sui modelli si tradurranno in affidabilità clinica e non in miraggi da leaderboard.

Progettare e validare per robustezza clinica

La robustezza deve diventare un requisito clinico esplicito. Ciò implica tre elementi operativi. Primo, stress test multimodali come pratica standard di validazione: rimozione/sostituzione della modalità, perturbazioni di formato e distrattori, controfattuali visivi; solo chi supera coerentemente tali prove dimostra comprensione reale. Secondo, rubriche cliniche per descrivere i benchmark lungo assi di ragionamento e complessità visiva, così da evitare metriche aggregate che occultano debolezze. Terzo, segnale di ragionamento verificabile: il modello deve ancorare le spiegazioni a evidenze, gestire incertezza e saper astenersi. In assenza di questi requisiti, i modelli restano fragili, con rischi di errori sistematici mascherati da alti punteggi. Lo studio dimostra che la strada per la prontezza reale passa per valutazioni più dure e trasparenti, non per classifiche più alte.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.