L’articolo confronta CPU e GPU nel 2025 mettendo a fuoco le architetture AI di punta come Huawei Ascend 950, Nvidia H200 e AMD MI300 Instinct, l’evoluzione del mercato tra AMD e Intel e la scoperta di un Pentium 4 estremo e non rilasciato. Le differenze tra GPU emergono su precisione numerica, bandwidth e ecosistemi software; le CPU si distinguono per single-thread, multithread e valore per il gaming. La spinta verso efficienza energetica e processi produttivi avanzati cambia scelte di piattaforma. Il pezzo analizza specifiche tecniche, trade-off operativi, implicazioni geopolitiche e consigli pratici per utenti, sviluppatori e centri di calcolo, offrendo inoltre un approfondimento tecnico sulla modellazione della memoria e della bandwidth per carichi AI.

Panorama generale delle GPU AI: architetture e priorità diverse

Il mercato GPU per AI evidenzia tre priorità distinte: efficienza in bassa precisione orientata all’inference, ecosistemi software completi per training e inferenza e bandwidth massima per carichi memory-bound. Huawei Ascend 950 punta su ottimizzazioni per bassa precisione e formati proprietari come HiF8 per ridurre perdita di accuratezza; Nvidia H200 offre un ecosistema maturo con CUDA e supporto per FP16/FP32/FP64 e tensor core dedicati; AMD MI300 Instinct capitalizza su chiplet MCM e ampia bandwidth HBM3 per HPC e modelli massivi. Queste differenze riflettono strategie: Huawei cerca efficienza e sovranità tecnologica; Nvidia monetizza compatibilità e strumenti; AMD investe su throughput dati e scalabilità chiplet.

Confronto tecnico: memoria, throughput e precisioni numeriche

Nel confronto tecnico, la bandwidth di memoria rappresenta il collo di bottiglia per molti modelli AI. AMD dichiara valori elevati con 6,55 TB/s, offrendo vantaggi per modelli memory-intensive e simulazioni scientifiche. Nvidia posiziona H200 con circa 4,89 TB/s e un insieme di tensor core ottimizzati per FP16 e FP8, puntando su performance per training generale. Huawei dichiara 4 TB/s con HiZQ 2.0 e sostiene efficienza su FP8 fino a 1–2 PFLOPS in formati MXFP4, privilegiando inference. Le metriche FP32 e FP16 mostrano differenze: Nvidia evidenzia robuste prestazioni FP16, AMD mira a picchi più alti in FP16 grazie al suo approccio chiplet, mentre Huawei enfatizza la validità della bassa precisione nella produzione di modelli generativi con costi energetici inferiori.

Core count, tensor core e chiplet: come cambia la scala

La scala delle GPU si misura con core, tensor core e organizzazione die. Nvidia cita conteggi di transistor e architetture SIMT con decine di miliardi di transistor e centinaia di tensor core, ottimizzati per throughput matriciale. AMD sceglie la via del chiplet MCM per aumentare la densità e la bandwidth complessiva, distribuendo workload su più die e riducendo latenza intra-package. Huawei adotta architetture proprietarie che bilanciano SIMD e SIMT per massimizzare performance su formati a bassa precisione. Il risultato pratico è che Nvidia domina per ecosistema e compatibilità; AMD primeggia su memory-bound e HPC; Huawei propone alternative competitive su inference e strategie di decoupling dalle supply chain occidentali.

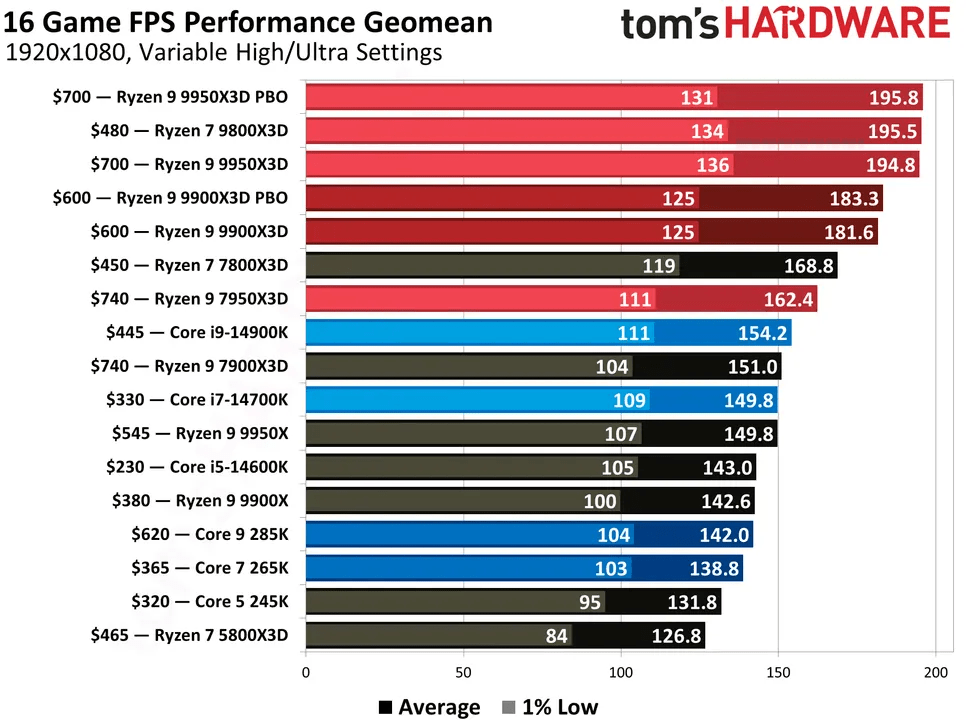

Migliori CPU 2025: scelte per gaming, produttività e valore

Il 2025 vede proposte CPU mirate: per gaming e valore, il Ryzen 7 9800X3D emerge per la combinazione di 3D V-Cache e efficienza, con cache L3 ampia e bassa latenza per carichi gaming; per chi cerca equilibrio tra prezzo e prestazioni, il Ryzen 7 9700X e il Core i7-14700K forniscono soluzioni valide. In fascia medio-bassa, il Ryzen 5 9600X e il Core i5-14600K offrono ottimo rapporto prezzo/prestazioni. Per workload intensivi, il Ryzen 9 9950X3D propone alto thread count e V-Cache, mentre il Core i9-14900K punta su boost elevati per single-thread. Le differenze chiave restano consumo energetico, supporto piattaforma (AM5 vs socket Intel), e capacità di overclocking. AMD mantiene vantaggi nel gaming puro grazie a X3D, mentre Intel conserva margini in latenze e sviluppi di piattaforma.

AMD vs Intel: dove si gioca la competizione nel 2025

| Categoria | Intel | AMD |

|---|---|---|

| Prezzo e rapporto qualità/prezzo | X | |

| Prestazioni gaming | X | |

| Prestazioni in produttività e content creation | X | X |

| Specifiche e funzionalità | X | |

| Consumo energetico e calore | X | |

| Driver e software CPU | X | |

| Sicurezza | X | |

| Totale punti | 3 | 5 |

La contesa AMD vs Intel si sviluppa su più fronti. AMD sfrutta piattaforme longeve (AM5), architetture Zen 5 e 3D V-Cache per migliorare gaming e multi-thread. Intel reponde con processi ibridi e boost elevati per single-thread, oltre a ecosistemi software consolidati. Sul prezzo, AMD tende a offrire value superiori sotto MSRP; Intel mantiene posizioni forti nella fascia enthusiast con K-series e in alcuni segmenti professionali.

| Family | AMD Zen 5 ‘Granite Ridge’ Ryzen 9000 | Intel ‘Arrow Lake’ Core 200S Ultra Series |

|---|---|---|

| Threadripper / Xeon W | $2,399 – $10,000 | $949 – $5,889 |

| Ryzen 9 / Core i9 | $469 – $699 | $549 – $599 |

| Ryzen 7 / Core i7 | $359 – $480 | $384 – $404 |

| Ryzen 5 / Core i5 | $250 – $279 | $270 – $319 |

| Ryzen 3 / Core i3 | $95 – $120 | $97 – $154 |

Sul piano energetico, AMD mostra consumi più contenuti su molti modelli, mentre Intel spinge su performance a scapito di TDP più alti in scenari turbo. Per l’utente finale, la scelta dipende da priorità: gaming, produttività multi-thread o compatibilità software.

Impatto geopolitico e posizionamento di Huawei contro i giganti USA

La presenza di Huawei Ascend 950 nel confronto solleva questioni geopolitiche. Huawei propone architetture focalizzate su efficienza e formati a bassa precisione, riducendo la dipendenza da ecosistemi USA. Questo introduce una dinamica dove fornitori di hardware non-americani offrono alternative per inference e deployment locali, influenzando scelte di procurement in contesti regolamentati. Nvidia mantiene forti barriere grazie a CUDA e all’ecosistema, ma la disponibilità di opzioni diverse aumenta la resilienza globale delle supply chain e alimenta tensioni commerciali e tecnologiche tra aree.

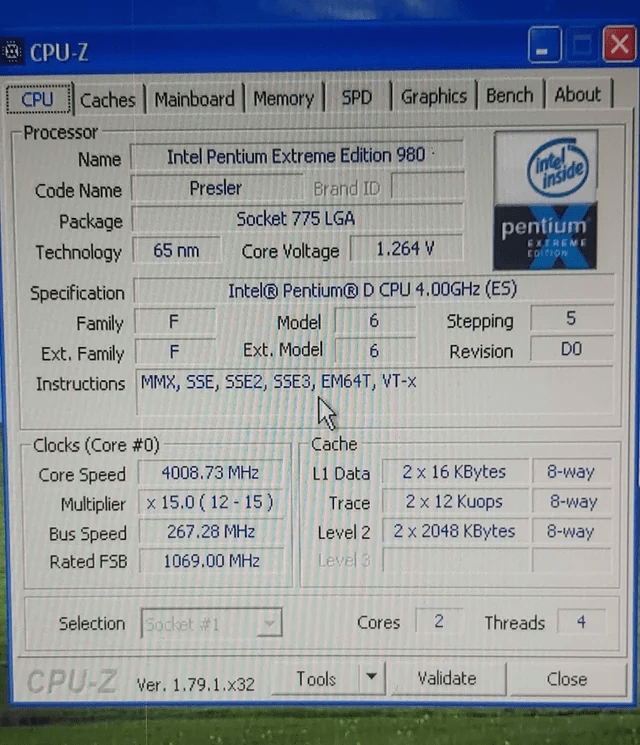

Pentium 4 estremo: rarità storica e lezioni tecniche

La scoperta di un Pentium 4 Extreme Edition 980 non rilasciato evidenzia un capitolo storico di NetBurst e il passaggio verso microarchitetture orientate all’efficienza. Il Pentium 4 EE 980, con clock a 4,0 GHz e caratteristiche particolari, rappresenta un esempio di come la ricerca di frequenze elevate si sia scontrata con limiti termici e di efficienza. La transizione a Core 2 evidenziò che performance per watt e IPC crescenti risultano più sostenibili nel tempo. Per i collezionisti la CPU è un reperto raro; per gli ingegneri resta una lezione sulla necessità di equilibrio tra clock, efficienza e architettura.

Consigli pratici per utenti, sviluppatori e data center

Le scelte hardware devono seguire il carico applicativo. Per training di grandi modelli si privilegerà GPU con alta bandwidth e scalabilità chiplet (tendenza AMD), mentre per inferenze distribuite conviene adottare soluzioni ottimizzate per bassa precisione (strategie Huawei). Per workstation gaming, scegliere CPU con ampia cache e ottimizzazioni single-thread come X3D porta vantaggi concreti. I data center devono bilanciare TCO, efficienza energetica e compatibilità software: ecosistemi maturi garantiscono tooling e migrazione più rapida, mentre architetture alternative possono abbattere costi in scenari regolamentati o locali.

Approfondimento tecnico: modellazione della bandwidth per workload AI

La bandwidth efficace percepita dai modelli dipende non solo dal valore teorico di TB/s, ma da latenza, organizzazione del prefetcing, stride di accesso e coerenza tra die in MCM. Un’approssimazione pratica richiede modellare il working set attivo, la frequenza di accesso alla memoria e la hit-rate della cache L3 o HBM. In scenari transformer, la dimensione del contesto e il batch size determinano se la GPU opera in regime compute-bound o memory-bound. Incrementare la banda senza ottimizzare access patterns rischia di lasciare risorse inutilizzate; perciò le strategie software che riducono regolarità di accesso e migliorano il blocking risultano decisive per sfruttare al meglio GPU con elevata TB/s. Il confronto fra CPU e GPU nel 2025 mostra che la differenziazione tecnologica si basa su trade-off tra throughput, precisione e ecosistema. Le GPU dominano l’accelerazione AI, ma si segmentano: bandwidth-centric (AMD) per modelli memory-intensive, ecosystem-centric (Nvidia) per compatibilità e tool, e efficiency-centric (Huawei) per inference a bassa precisione. Le CPU rimangono centrali per workload a bassa latenza e per orchestrazione; la scelta tra AMD e Intel dipende da priorità di prezzo, durata piattaforma e consumi. Dal punto di vista progettuale, ottimizzare access patterns memoria e dimensionare working set rimane la leva più redditizia per sfruttare le GPU moderne. Infine, la scoperta storica del Pentium 4 EE 980 ricorda che la ricerca di frequenze estreme deve sempre conciliarsi con limiti termici e rendimenti reali dell’architettura.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.