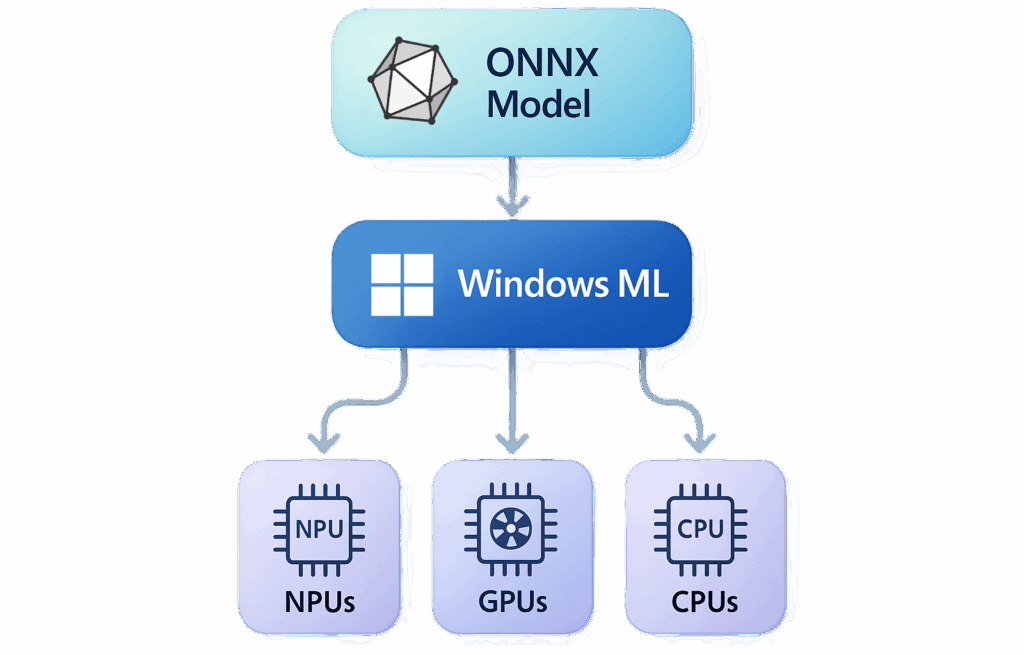

Microsoft accelera l’integrazione dell’intelligenza artificiale nel proprio ecosistema con l’introduzione di Windows Machine Learning (Windows ML), una piattaforma progettata per consentire agli sviluppatori di eseguire modelli ONNX su PC Windows sfruttando automaticamente CPU, GPU e NPU. L’obiettivo è democratizzare l’accesso all’AI locale, rendendo più semplice l’adozione di modelli avanzati senza la complessità tipica dei framework dedicati. Windows ML nasce per offrire una esperienza unificata e nativa, dove l’intelligenza artificiale diventa parte integrante del sistema operativo. Gli sviluppatori in C#, C++ e Python possono ora integrare modelli di machine learning direttamente nelle proprie applicazioni, beneficiando di ottimizzazioni hardware automatiche, gestione semplificata dei provider di esecuzione e compatibilità estesa con framework come PyTorch e TensorFlow.

Windows Machine Learning e ONNX Runtime

Al centro della piattaforma si trova ONNX Runtime, il motore d’inferenza che consente a Windows ML di gestire i diversi provider di esecuzione in base all’hardware disponibile. In pratica, Windows rileva il dispositivo — CPU, GPU o NPU — e assegna automaticamente il carico computazionale al componente più efficiente. Questa architettura consente un vantaggio decisivo: gli sviluppatori non devono più includere i runtime specifici dei vendor nelle loro applicazioni. Windows ML distribuisce i provider dinamicamente, riducendo la dimensione delle app e garantendo aggiornamenti indipendenti dal sistema operativo. In questo modo, ogni PC Windows 11 (versione 24H2 o successive, architettura x64 o ARM64) può diventare una piattaforma AI-ready.

L’infrastruttura è “write once, run anywhere”: lo stesso modello ONNX può essere eseguito su hardware differenti, ottenendo prestazioni comparabili a SDK specializzati come TensorRT o AI Engine Direct. Gli sviluppatori possono convertire modelli dai principali framework tramite i toolkit dedicati ONNX e utilizzare Windows App SDK per il deployment automatico.

Potenza e efficienza con le NPU di nuova generazione

Un elemento chiave di questa rivoluzione è la Neural Processing Unit (NPU), che consente di eseguire oltre 40 trilioni di operazioni al secondo (TOPS). Le NPU gestiscono in parallelo compiti complessi come traduzioni in tempo reale, generazione d’immagini e riconoscimento vocale, mantenendo un consumo energetico minimo.

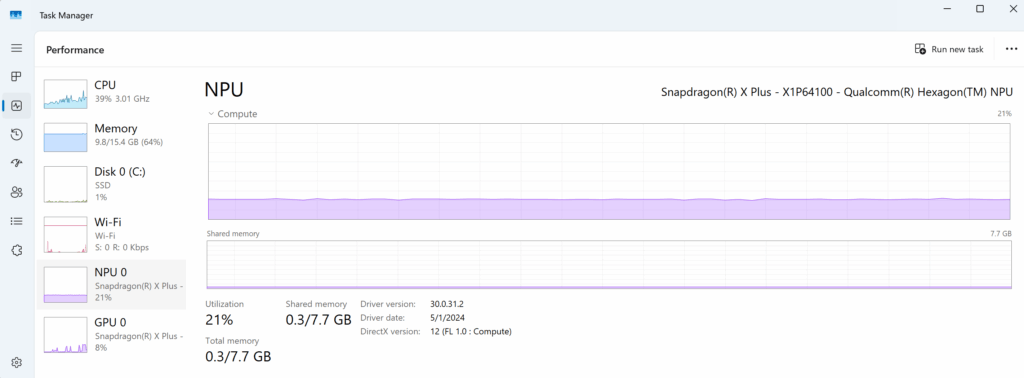

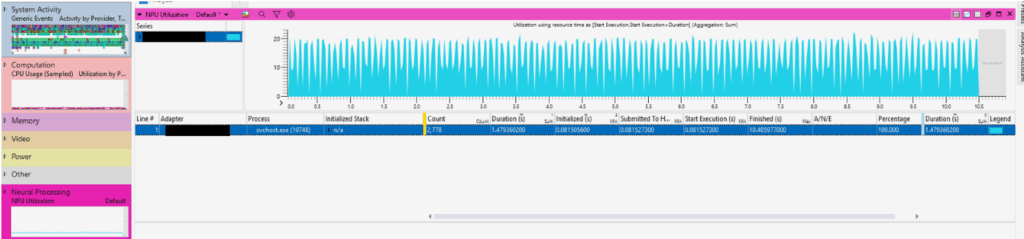

Windows 11 assegna automaticamente i task AI al componente più efficiente, bilanciando CPU, GPU e NPU per garantire massima performance e autonomia energetica. Questa ottimizzazione si traduce in una esperienza on-device più rapida, sicura e sostenibile. La nuova generazione di Copilot+ PCs sfrutta appieno queste capacità. I dispositivi basati su Snapdragon X Elite di Qualcomm offrono la prima NPU a 45 TOPS, con Intel e AMD pronte a seguire con soluzioni equivalenti. Microsoft integra nativamente la gestione dell’accelerazione AI: nel Task Manager, gli sviluppatori possono ora monitorare in tempo reale l’utilizzo delle NPU, verificando percentuale di carico, memoria e driver.

I provider di esecuzione come QNNExecutionProvider di Qualcomm e OpenVINO EP di Intel vengono caricati automaticamente da Windows ML, consentendo un’inferenza nativa senza intervento manuale. In assenza di NPU, il sistema esegue il fallback su GPU o CPU, garantendo compatibilità universale.

Toolkit AI per Visual Studio Code

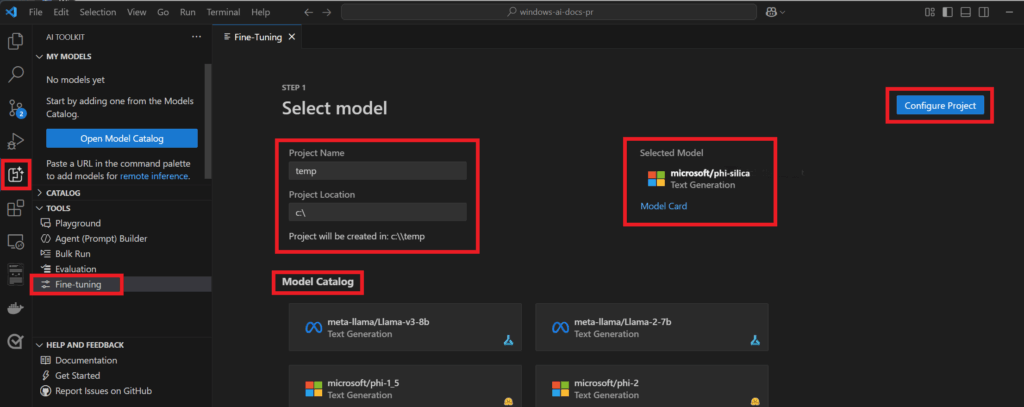

La strategia AI di Microsoft non si limita al runtime, ma si estende agli strumenti di sviluppo. Il nuovo AI Toolkit per Visual Studio Code consente di creare, ottimizzare e testare applicazioni AI generative in modo semplice. L’estensione integra modelli da Azure AI Foundry, Hugging Face e da repository open come Ollama, supportando sia esecuzioni locali sia in cloud. Il toolkit permette di scaricare modelli ottimizzati per le piattaforme Windows, sfruttando DirectML per la GPU e ONNX Runtime per la CPU o la NPU. Gli sviluppatori possono avviare sessioni di fine-tuning, testare prompt in un playground integrato e distribuire modelli personalizzati direttamente sui loro dispositivi. Tra i modelli compatibili spiccano Phi-3, Mistral e DeepSeek R1 Distilled, ottimizzati per NPU sui Copilot+ PCs. L’approccio “Bring Your Own Model” consente inoltre di importare modelli personalizzati e adattarli alle proprie esigenze applicative, favorendo una AI modulare e trasparente.

Fine-tuning locale con Phi Silica LoRA

Un’innovazione significativa è rappresentata da Phi Silica LoRA, modello linguistico locale sviluppato da Microsoft per Windows. Grazie alla tecnica Low-Rank Adaptation (LoRA), gli sviluppatori possono addestrare “adapter” specializzati per domini specifici, migliorando l’accuratezza dei risultati senza dover riaddestrare l’intero modello. Il processo di fine-tuning, gestito tramite l’AI Toolkit di VS Code, consente di addestrare gli adapter su dataset personalizzati in formato JSON, testarli su AI Dev Gallery e integrarli nelle app Windows tramite le API Microsoft.Windows.AI.Text.

Questa soluzione rappresenta un passo avanti verso l’AI personalizzata on-device, dove modelli come Phi Silica possono essere raffinati per casi d’uso verticali — dal customer service alle analisi di dati tecnici — mantenendo privacy e sicurezza grazie all’elaborazione locale.

Integrazione con .NET e GitHub Copilot

Nel mondo dello sviluppo .NET, l’AI diventa un partner operativo. Con l’integrazione di GitHub Copilot, i team di sviluppo sfruttano l’intelligenza artificiale per generare, revisionare e rifinire codice in modo collaborativo. Gli sviluppatori agiscono come revisori e mentori del codice AI, garantendo coerenza, manutenibilità e qualità architetturale. Questa collaborazione uomo-macchina consente di ridurre i tempi di sviluppo del 20-40%, migliorando il ciclo di revisione e la qualità delle pull request. Copilot genera snippet, test e suggerimenti, mentre i revisori umani guidano l’ottimizzazione e mantengono lo stile del progetto coerente con gli standard interni. Il risultato è un approccio ibrido in cui l’AI gestisce i compiti ripetitivi, liberando gli sviluppatori per attività di design e architettura ad alto livello.

Ecosistema unificato per l’AI in Windows

L’introduzione di Windows ML e delle API AI integrate segna la maturità dell’ecosistema Windows AI, che ora unisce strumenti, hardware e modelli in un’unica piattaforma coerente. Dalla potenza delle NPU al fine-tuning locale, fino alla produttività potenziata in .NET, Microsoft propone una visione olistica dell’intelligenza artificiale: accessibile, trasparente e completamente locale. Con l’approccio write-once-run-anywhere, gli sviluppatori possono distribuire modelli AI su qualsiasi dispositivo Windows senza preoccuparsi dell’hardware sottostante. L’inferenza automatica, l’ottimizzazione energetica e i tool di osservabilità (Task Manager, Performance Analyzer, GPUView) completano un ecosistema che punta all’efficienza, alla sicurezza e alla libertà di sviluppo. La convergenza tra Windows ML, ONNX Runtime, AI Toolkit e Copilot+ PCs trasforma Windows in una piattaforma AI nativa, pronta per alimentare la prossima generazione di applicazioni intelligenti, generative e personalizzate.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.