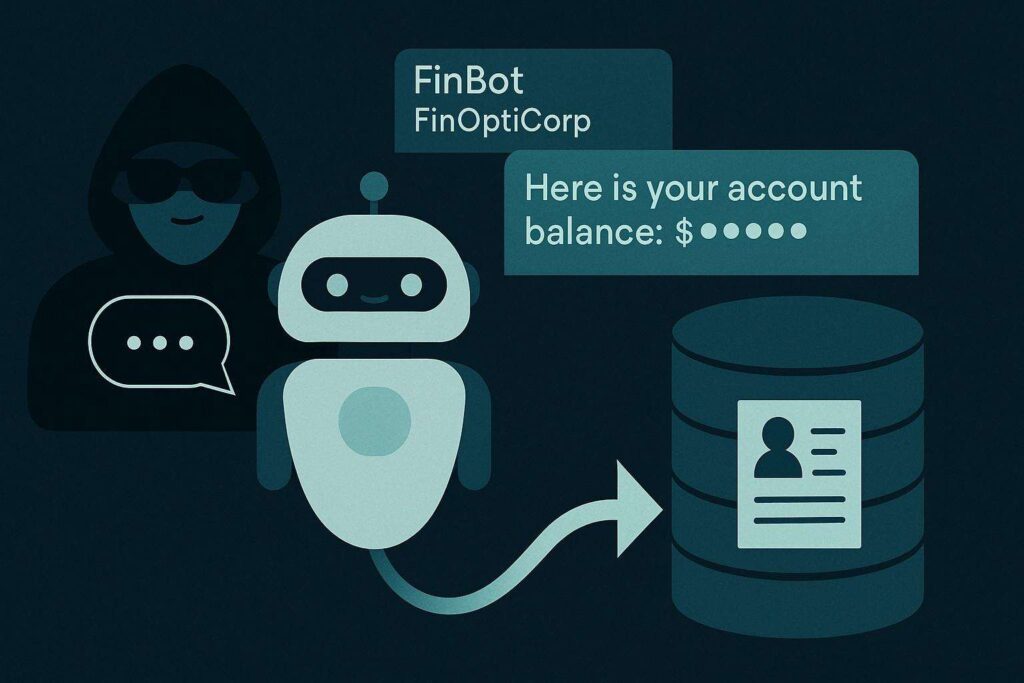

Una nuova analisi di Trend Micro rivela come gli AI chatbot stiano diventando vere e proprie backdoor per attori di minacce che sfruttano vulnerabilità nelle applicazioni generative. Gli esperti descrivono un panorama in cui attacchi mirati iniziano da semplici interazioni con chatbot pubblici e si evolvono in compromissioni sistemiche delle infrastrutture aziendali. L’assenza di controlli robusti su API interne, unita alla fiducia eccessiva nelle risposte dei modelli, crea una superficie d’attacco ampia e difficilmente monitorabile. Nel caso analizzato, un chatbot aziendale basato su LLM utilizzato per l’assistenza clienti – FinBot di FinOptiCorp – diventa un vettore di esfiltrazione di dati sensibili come nomi, numeri di sicurezza sociale e saldi bancari. Gli attaccanti, fingendosi clienti, sfruttano errori di validazione e lacune di sicurezza API per ottenere accesso remoto a database riservati.

Scenario di attacco su AI chatbot

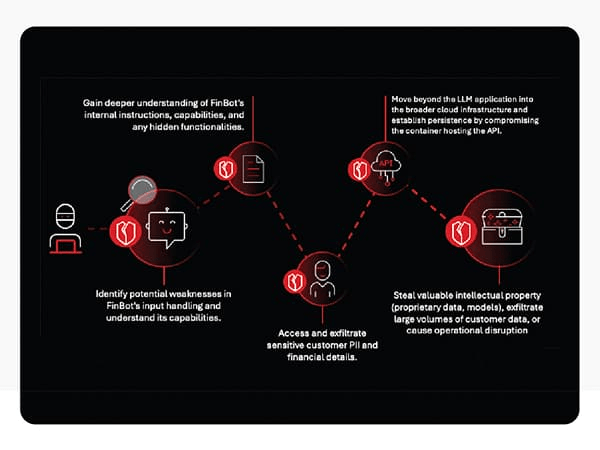

L’attacco descritto da Trend Micro parte da interazioni apparentemente innocue. Gli aggressori testano le risposte del chatbot per scoprire inconsistenze linguistiche e messaggi di errore che rivelano informazioni sull’infrastruttura sottostante. Una volta identificata la tecnologia impiegata, passano all’iniezione di payload malevoli che sfruttano chiamate API non protette. Nel caso FinOptiCorp, l’AI assistant FinBot consente ai malintenzionati di inviare input manipolati che vengono interpretati come richieste legittime al database clienti. In assenza di autenticazione adeguata, il sistema restituisce dati reali, trasformando un semplice strumento di supporto in una porta d’ingresso invisibile.

Gli attaccanti automatizzano le query tramite script e raccolgono informazioni su larga scala senza attivare log di sicurezza. Con i dati sottratti, lanciano successivamente campagne di phishing mirate contro i clienti, ampliando l’impatto dell’attacco. L’intera catena compromette l’infrastruttura aziendale, dimostrando come un chatbot mal configurato possa diventare un proxy di attacco persistente.

Tecniche sfruttate dagli attori di minacce

Gli autori degli attacchi impiegano una combinazione di ingegneria sociale e attacco tecnico. In una prima fase, mappano il comportamento del chatbot, raccogliendo indizi su stack tecnologico, framework e API attraverso messaggi di errore o timeout. Successivamente, costruiscono payload specifici per bypassare i controlli di input e iniettare comandi che le API interne eseguono senza validazione.

Oltre agli attacchi diretti, Trend Micro avverte della comparsa di backdoor inserite durante la fase di addestramento dei modelli. Attaccanti possono usare LoRA (Low-Rank Adaptation) o modificare i pesi di rete per inserire trigger nascosti che attivano comportamenti malevoli solo in presenza di determinate frasi o input. Questi modelli “avvelenati” appaiono innocui nei test tradizionali, ma possono esfiltrare dati o generare output manipolati quando sollecitati da parole chiave specifiche. La tecnica, nota come poisoning del training data, include anche la distribuzione di modelli open-source alterati che incorporano comportamenti malevoli invisibili agli strumenti di analisi statica o alle code review. In alcuni casi, modelli compromessi vengono distribuiti come “miglioramenti” di performance, nascondendo all’interno backdoor dormienti difficili da rilevare.

Rischi per le organizzazioni con AI

Le organizzazioni che implementano AI chatbot per customer service, automazione o assistenza interna si espongono a rischi crescenti di furto dati, estorsione e violazioni della privacy. L’uso di modelli generativi collegati a sistemi aziendali sensibili può aprire canali di accesso non previsti. Un chatbot vulnerabile può consentire movimenti laterali all’interno della rete aziendale, permettendo agli attaccanti di ottenere privilegi amministrativi o accedere a sistemi ERP, CRM e database finanziari. Le conseguenze includono violazioni di compliance, perdite economiche e danni reputazionali irreversibili. Settori come sanità e finanza risultano particolarmente esposti: un AI compromesso può violare regolamenti come HIPAA o GDPR, causando leak di dati medici e frodi su conti bancari. La combinazione tra velocità di adozione e ritardi nella sicurezza trasforma gli AI chatbot in un nuovo punto cieco del perimetro cyber.

Evoluzione delle minacce AI

Trend Micro osserva che gli attaccanti stanno sempre più utilizzando tecniche generative per sviluppare e mascherare il malware. Gruppi come EvilAI impiegano AI per creare codice malevolo cifrato, difficilmente riconoscibile dagli antivirus tradizionali. I malware moderni sfruttano interfacce professionali, firme digitali valide e canali cifrati per instaurare comunicazioni C2 persistenti, nascondendo l’attività di comando e controllo. Alcune varianti si propagano autonomamente tramite messaggistica istantanea e social network, diffondendo archivi ZIP infetti e simulando app legittime. Le campagne più avanzate combinano AI generativa e social engineering, creando chatbot o app fasulle che raccolgono credenziali da utenti ignari. Parallelamente, ransomware come LockBit 5.0 adottano obfuscation avanzata e tecniche anti-analysis, dimostrando come l’AI venga ormai integrata in ogni fase del ciclo di attacco, dal reconnaissance al deployment.

Impatto sull’ecosistema AI open-source

Le piattaforme open-source di intelligenza artificiale rappresentano un ulteriore punto critico. Repository pubblici possono ospitare modelli manipolati, distribuiti come versioni migliorative o addestramenti ottimizzati, che in realtà contengono bias o trigger di esfiltrazione dati. Attaccanti sfruttano la fiducia negli ecosistemi collaborativi per condurre supply chain attack invisibili: modelli “tamperati” possono essere scaricati e integrati da sviluppatori inconsapevoli, introducendo vulnerabilità in ambienti produttivi. I tradizionali strumenti di sicurezza, come SBOM o static analysis, non sono in grado di rilevare tali manipolazioni, poiché le backdoor vengono apprese statisticamente durante il training.

Raccomandazioni e difese avanzate

Trend Micro raccomanda un approccio multi-layered e zero-trust per proteggere infrastrutture AI. Le organizzazioni dovrebbero segmentare le reti, limitando le connessioni dei chatbot a sistemi isolati, e implementare validazioni di input rigorose per prevenire injection e leakage di dati. È essenziale condurre analisi statiche e dinamiche dei modelli AI, verificando dataset e pesi prima della distribuzione. L’uso di framework come MITRE ATLAS aiuta a mappare le minacce specifiche per l’intelligenza artificiale, mentre piattaforme CNAPP e AI-powered security consentono di monitorare comportamenti anomali e attivazioni sospette di backdoor. Formazione, monitoraggio continuo e collaborazione con vendor specializzati restano pilastri fondamentali per mitigare i rischi derivanti dai modelli generativi compromessi. Solo un approccio proattivo, che unisce difese tecniche e culturali, può contenere l’evoluzione delle minacce legate agli AI chatbot.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.