Google Cloud introduce una nuova generazione di strumenti basati su intelligenza artificiale per lo storage, l’analisi dati e la resilienza infrastrutturale, trasformando i dati non strutturati in risorse intelligenti. Le novità includono Auto Annotate per la generazione automatica di metadata, il lancio di AI Agent Marketplace, la piattaforma LLM-Evalkit per prompt engineering, l’evoluzione della sanitizzazione dei media con cryptographic erasure e una guida dedicata al chaos engineering per testare la resistenza dei sistemi. L’obiettivo è un ecosistema cloud più scalabile, sostenibile e AI-driven, capace di ridurre tempi di sviluppo e rafforzare la sicurezza dei dati.

Feature AI per dati non strutturati in Cloud Storage

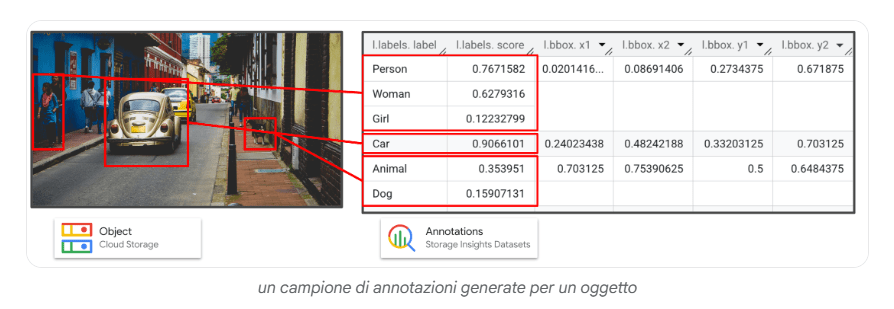

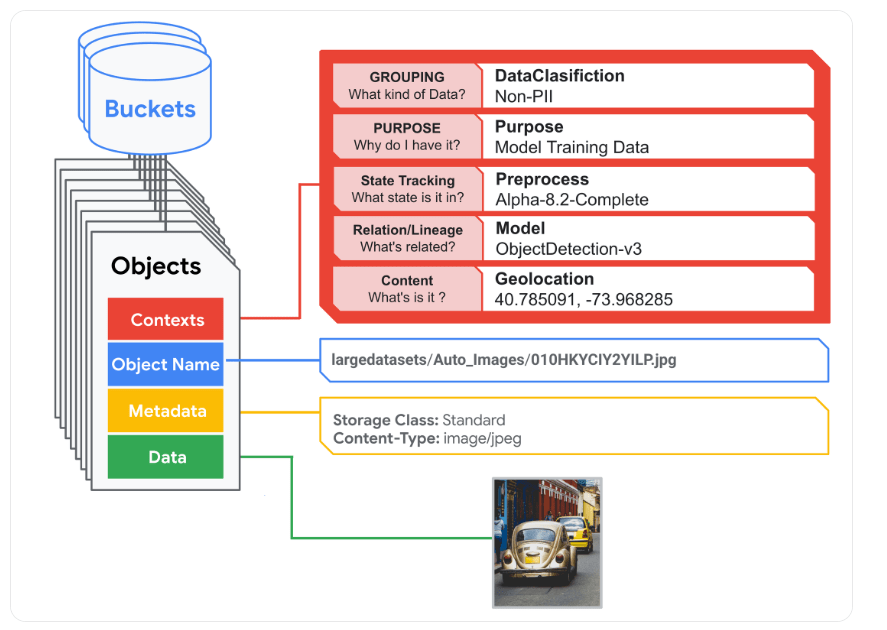

Google Cloud potenzia Cloud Storage con la funzione Auto Annotate, che genera automaticamente metadata intelligenti per gli oggetti archiviati. I modelli pretrained eseguono rilevamento di oggetti, etichettatura semantica e identificazione di contenuti sensibili, producendo informazioni utili per governance, ricerca e analisi. Gli utenti possono attivare la funzione su bucket specifici e accedere ai risultati tramite le API Cloud Storage, integrandoli in dataset interrogabili con BigQuery o analizzabili via Storage Insights.

La nuova funzione Object Contexts consente invece di associare metadata personalizzati key-value a ciascun oggetto, con controllo degli accessi tramite IAM e tracciamento temporale per creazione e modifica. In caso di migrazione da Amazon S3, i tag vengono convertiti automaticamente, semplificando la transizione. Google evidenzia come queste innovazioni rispondano a una sfida cruciale: gestire il 61% dei dati aziendali non strutturati. Le imprese possono così applicare ricerca semantica, curare dataset per modelli AI, ridurre bias e migliorare la governance dei dati sensibili.

Soluzioni come BigID integrano Object Contexts per la classificazione dei dati, mentre analisi di Enterprise Strategy Group indicano riduzioni del time-to-insight da mesi a settimane. Aziende retail e automotive già sfruttano queste tecnologie per ottimizzare cataloghi, footage video e dataset multimodali integrati con Gemini e Vertex AI, aprendo la strada a flussi di lavoro basati su Retrieval-Augmented Generation (RAG). Auto Annotate è al momento in release sperimentale.

AI Agent Marketplace: nuova frontiera per agenti intelligenti

Google Cloud presenta AI Agent Marketplace, un portale che connette le aziende a migliaia di agenti AI pre-vettati provenienti da partner certificati. Gli agenti integrano nativamente Gemini Enterprise, offrendo soluzioni per analisi comportamentale, compliance, automazione e gestione documentale. Tra i partner figurano Amplitude, Avalara, Box, Dynatrace, Elastic, HubSpot, UiPath e S&P Global, a testimonianza di un ecosistema diversificato che unisce dati, marketing e operation. Ogni agente è accompagnato da una Agent Card JSON che ne descrive le funzioni, la compatibilità e le API di integrazione. Le aziende possono acquistare e distribuire agenti con billing consolidato, governance IAM e interoperabilità tramite protocollo A2A. I partner con designazione Google Cloud Ready – Gemini Enterprise garantiscono standard qualitativi elevati e sicurezza verificata. Secondo Futurum Research, le imprese che adottano questi agenti registrano crescita del 112% nelle dimensioni dei deal e maggiore retention dei clienti grazie a processi più rapidi e automatizzati. Il marketplace abilita così un time-to-value accelerato e un modello di monetizzazione flessibile per i provider.

Sistemi agili per data center AI-ready

Google Cloud rinnova la propria infrastruttura con sistemi agili e modulari progettati per abilitare innovazioni AI su larga scala. I nuovi server rack MGX raffreddati a liquido integrano midplane PCB per assemblaggio rapido e supportano networking ConnectX-9 a 800 GB/s. L’alimentazione a 800 VDC migliora l’efficienza del 150%, riducendo il consumo energetico e l’uso di rame. Le lame compute verticali con switch NVLink integrato eliminano la necessità di cavi, semplificando la manutenzione e migliorando la connettività tra GPU. Queste soluzioni partecipano al progetto Open Compute Project, favorendo la standardizzazione dell’hardware AI sovrano e la compatibilità con piattaforme come Vera Rubin NVL144, Oracle OCI Zettascale10 e Nvidia Spectrum-X. Il risultato è una riduzione della complessità nei data center, unita a costi operativi inferiori e maggiore sostenibilità energetica, con scalabilità fino a infrastrutture da gigawatt per supportare i carichi di lavoro AI futuri.

LLM-Evalkit: ingegnerizzare il prompt engineering

Google Cloud lancia LLM-Evalkit, un toolkit open-source che rende il prompt engineering una disciplina sistematica. Lo strumento, integrato con Vertex AI SDK, permette di tracciare metriche oggettive sulle performance dei prompt, confrontare versioni e documentare miglioramenti. L’interfaccia no-code consente anche ai non tecnici di collaborare nella creazione e valutazione di prompt, favorendo un approccio data-driven allo sviluppo di modelli linguistici.

Gli utenti definiscono problemi, raccolgono dataset e impostano benchmark per testare diverse formulazioni, riducendo la dipendenza da giudizi soggettivi. LLM-Evalkit accelera il ciclo di iterazione e semplifica la condivisione tra team, permettendo di passare da esperimenti isolati a pipeline collaborative. Lo strumento è disponibile su GitHub, con tutorial dedicati e integrazione diretta nella console Google Cloud, segnando un passo verso un prompt engineering ingegnerizzato e scalabile.

Cryptographic erasure: nuova era per la sanitizzazione media

Google introduce la cryptographic erasure come metodo standard per la sanitizzazione dei media nei propri data center. Il processo elimina le chiavi crittografiche associate ai dati invece di sovrascriverli, rendendo il contenuto irrecuperabile in modo istantaneo e sicuro. La transizione, prevista da novembre 2025, risponde all’impatto crescente delle dimensioni dei supporti e alla necessità di ridurre le pratiche di distruzione fisica. Il sistema si basa su layered encryption con rotazioni multiple delle chiavi e verifiche indipendenti, in linea con le linee guida NIST 800-88. Oltre a garantire sicurezza e sostenibilità, questa metodologia consente di riutilizzare hardware e recuperare materiali rari come il neodimio, contribuendo all’economia circolare. L’eliminazione delle chiavi riduce i tempi di decommissioning, ottimizza la gestione del key management e rafforza la fiducia degli utenti nella tutela dei dati sensibili.

Chaos engineering e resilienza cloud

Google Cloud introduce una guida ufficiale al chaos engineering, un approccio proattivo che prevede fallimenti controllati per testare la resilienza dei sistemi. Derivato dalle pratiche Netflix Chaos Monkey e Google DiRT, questo metodo permette di identificare vulnerabilità prima che incidano sull’operatività. Il processo segue principi chiave come la definizione dello steady state, la formulazione di ipotesi, l’iniezione di guasti simulati e l’automazione degli esperimenti per garantirne la ripetibilità. Google PSO offre una serie di ricette su GitHub con esempi pratici, tra cui la simulazione di outage di rete da Cloud Run a Cloud SQL tramite ToxiProxy. Gli utenti possono iniziare con Chaos Toolkit e le sue estensioni per GCP e Kubernetes, migliorando il tempo di risposta, riducendo downtime e integrando la metodologia nei processi SRE. Questo approccio consolida la readiness operativa e promuove una cultura di innovazione resiliente nel cloud.

AI più sostenibile e governata

Le novità di Google Cloud delineano un ecosistema in cui AI, governance e sostenibilità convergono per creare infrastrutture più intelligenti e sicure. La combinazione di strumenti come Auto Annotate, AI Agent Marketplace e LLM-Evalkit con pratiche avanzate di gestione e resilienza posiziona Google come punto di riferimento per l’adozione responsabile dell’intelligenza artificiale. Le imprese ottengono vantaggi in termini di governance, rapidità di sviluppo e fiducia nei processi, riducendo costi e impatto ambientale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.