Nel terzo trimestre del 2025, Google Cloud presenta un’ondata di innovazioni che rafforzano la leadership dell’azienda nel mercato dell’intelligenza artificiale e del calcolo ad alte prestazioni. Gli aggiornamenti interessano l’intero ecosistema cloud, con miglioramenti a AI Hypercomputer, G4 VMs con GPU NVIDIA RTX 6000 Blackwell, Vertex AI Agent Engine e Dataproc 2.3. La piattaforma mira a ottimizzare i workload AI su larga scala, potenziando l’efficienza, la sicurezza e la scalabilità. Le nuove soluzioni introducono strumenti per la creazione di agenti AI modulari, un’infrastruttura più potente per modelli di linguaggio di grandi dimensioni e funzionalità avanzate di integrazione con NVIDIA Omniverse per la digitalizzazione industriale. Parallelamente, Gemini conquista la posizione di leader nel report IDC MarketScape 2025 dedicato ai software AI generativi.

Vertex AI Agent Engine e gli agenti scalabili

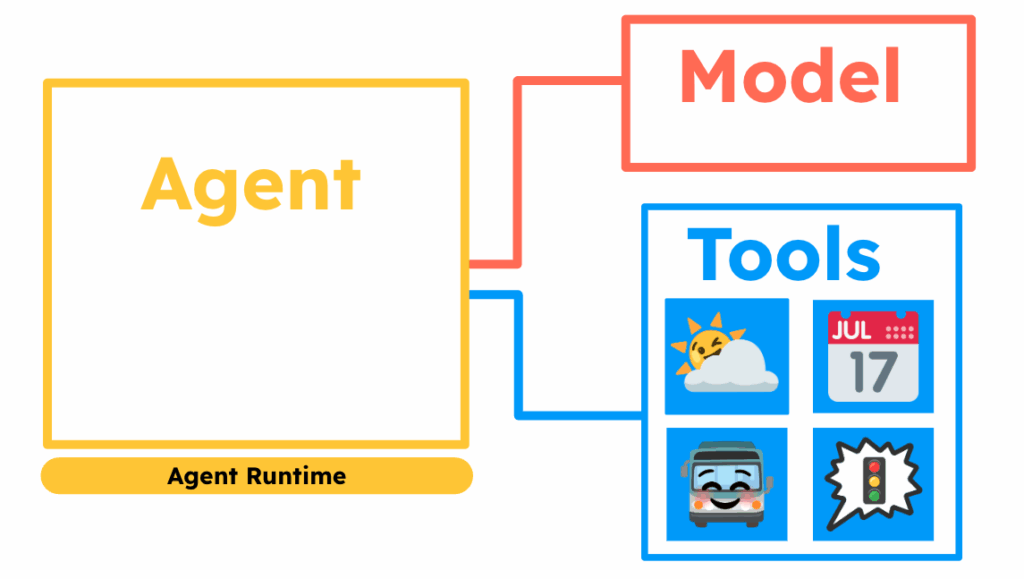

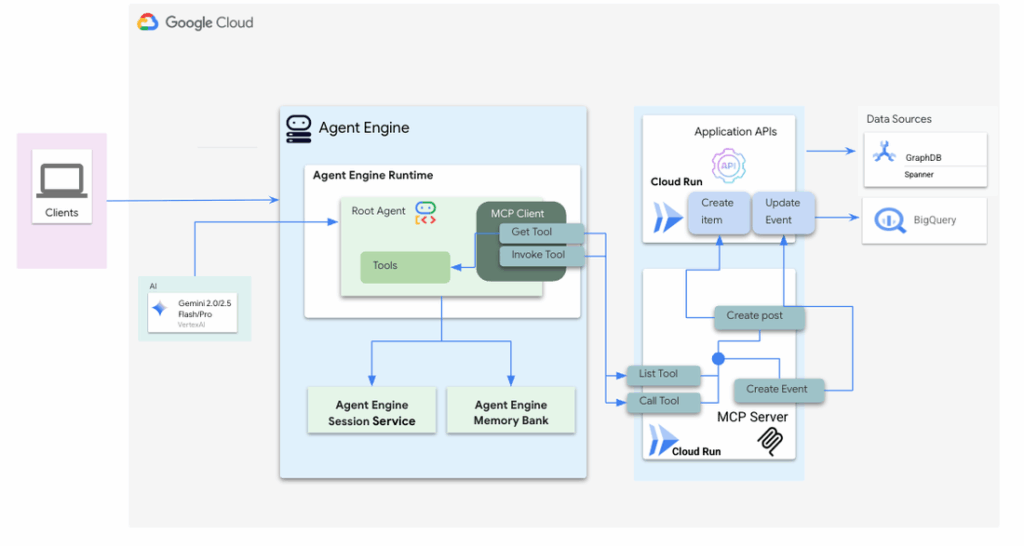

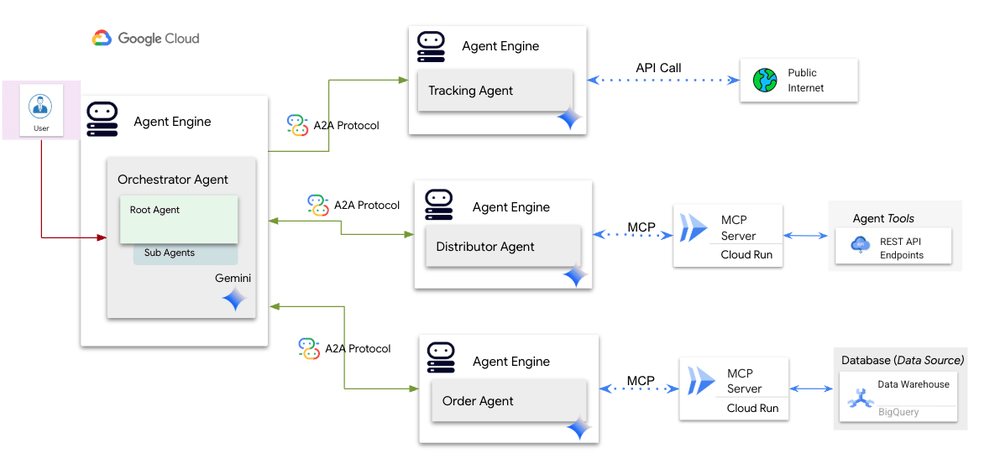

Il nuovo Vertex AI Agent Engine rappresenta la spina dorsale delle architetture agentiche di Google Cloud. Gestisce l’intero ciclo di vita degli agenti AI, offrendo strumenti di sicurezza, osservabilità e gestione del contesto tramite un banco memoria persistente e un sistema di sessioni contestuali. Gli sviluppatori possono orchestrare agenti che comunicano tra loro grazie al protocollo A2A (Agent-to-Agent), pubblicando “agent cards” che ne descrivono le capacità per facilitare il routing dinamico dei compiti.

Agent Engine separa i componenti server MCP su infrastrutture serverless, garantendo scalabilità automatica tramite GKE e Cloud Run. L’ambiente include sandbox di esecuzione isolata, strumenti di quality assurance come Example Store, e un modulo di Evaluation Services per valutare le prestazioni degli agenti in produzione.

Le aziende come Deloitte e Quantiphi hanno già implementato soluzioni basate su questa architettura: Deloitte utilizza un sistema multi-agente per il retail, integrando dati di inventario e generando raccomandazioni in tempo reale, mentre Quantiphi applica un framework analogo nel settore manifatturiero per automatizzare le quotazioni e migliorare l’esperienza cliente. Questi casi d’uso dimostrano come gli agenti AI stiano superando i limiti dell’automazione tradizionale, abilitando flessibilità e adattamento a mercati volatili.

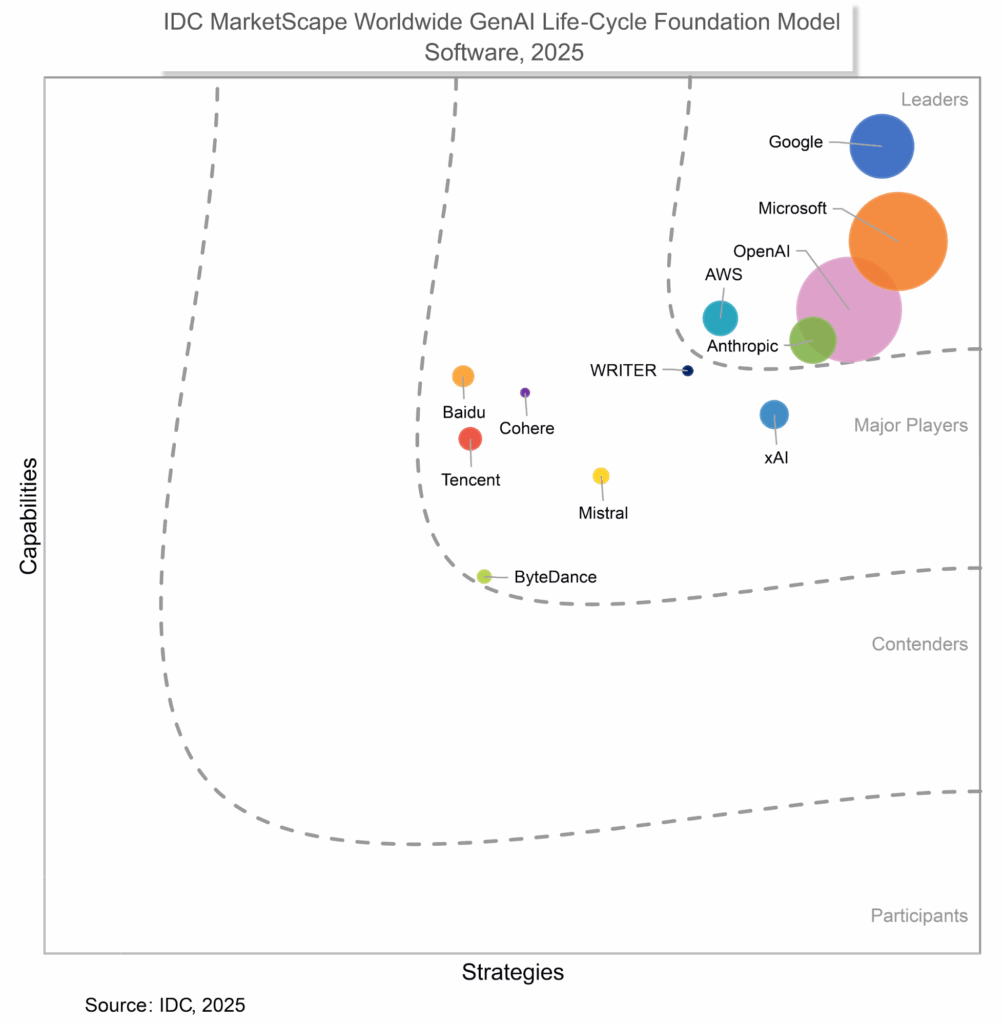

Gemini riconosciuto leader nel report IDC MarketScape 2025

Il modello Gemini 2.5 conquista il titolo di leader nel report IDC MarketScape 2025 per la gestione completa del ciclo di vita AI generativo. Il modello spicca per capacità di ragionamento complesso, gestione trasparente dei costi di calcolo e funzionalità multimodali native che integrano testo, codice, immagini e audio.

La versione Gemini 2.5 Flash, rilasciata a settembre 2025, ottimizza le prestazioni per attività interattive e conversazionali, mentre Gemini 2.5 Pro eccelle nella generazione di codice e problem-solving agentico. Le innovazioni come Nano Banana per l’editing conversazionale e la gestione tramite Gemini CLI estendono l’uso della piattaforma da scenari low-code a implementazioni ad alta complessità.

Vertex AI Model Garden unifica modelli proprietari, open-source e di terze parti, mentre Supervised Fine-Tuning, BigQuery Grounding e Vertex AI Search integrano funzioni di personalizzazione e connettività con Google Search e Google Maps. Questa coesione rende Gemini una soluzione centrale per imprese che desiderano passare da prototipi sperimentali ad applicazioni AI su scala industriale.

AI Hypercomputer: inferenza vLLM su TPU e ottimizzazione multi-framework

Il AI Hypercomputer evolve come piattaforma convergente di hardware e software per il calcolo AI intensivo. L’aggiornamento del Q3 2025 introduce vLLM su TPU, integrando JAX e PyTorch in un unico ambiente. La nuova architettura tpu-inference funge da plugin hardware, migliorando l’efficienza di inferenza per modelli come Gemma e Llama.

La suite XProf Profiler si espande con Cloud Diagnostics, fornendo strumenti di profiling unificato che identificano colli di bottiglia nei modelli e riducono i tempi di debug. Le nuove ricette NVIDIA Dynamo supportano un’architettura disaggregata per l’inferenza, separando prefill e decode su pool GPU orchestrati da GKE Inference Gateway, ora disponibile in General Availability. Le configurazioni per il reinforcement learning sfruttano NVIDIA NeMo RL su A4 VMs, ottimizzando algoritmi GRPO e PPO per modelli Llama 3.1 8B. Il risultato è una riduzione significativa dei tempi di risposta (TTFT e TPOT) e una gestione più prevedibile dei carichi AI complessi.

G4 VMs con GPU NVIDIA RTX 6000 Blackwell

Le nuove G4 Virtual Machines con GPU NVIDIA RTX PRO 6000 Blackwell ampliano le opzioni di calcolo per workload AI e grafici. Ogni istanza supporta fino a 8 GPU, con 768 GB di memoria GDDR7, Tensor Core di quarta generazione e RT Core di quarta generazione per il rendering real-time. Le G4 offrono miglioramenti del 168% nel throughput e riduzione del 41% nella latenza rispetto alla generazione G2, grazie a un interconnect PCIe P2P Fabric che accelera le comunicazioni multi-GPU. Le istanze multi-tenant includono il supporto Multi-Instance GPU (MIG) per isolare risorse, migliorando la sicurezza e l’efficienza dei carichi condivisi.

L’integrazione con Omniverse, Isaac Sim e GKE Autopilot consente simulazioni di robotica, rendering 3D e inferenza distribuita. Il nuovo Hyperdisk ML fornisce storage ad alte prestazioni, mentre il Managed Lustre ottimizza lo storage condiviso per training di modelli su larga scala.

Collaborazione NVIDIA e digitalizzazione industriale

La collaborazione tra NVIDIA e Google Cloud consolida l’integrazione tra AI enterprise e physical AI. L’inclusione di NVIDIA Omniverse su Google Marketplace permette la creazione di digital twin industriali con standard OpenUSD, integrando la simulazione robotica di Isaac Sim e i microservizi NIM per l’inferenza. L’ecosistema condiviso sfrutta GPU RTX PRO 6000 Blackwell, GB200 NVL72 e HGX B200, combinando performance grafiche e capacità computazionali per settori come manifattura, automotive e logistica. Use case reali includono digital twin per fabbriche, ottimizzazione logistica e simulazioni fotorealistiche per progettazione e advertising 3D.

Trasformazione dei dati nello stato dell’Oklahoma

La Oklahoma Employment Security Commission migra da un mainframe legacy a un’infrastruttura moderna basata su Google Cloud Public Sector. Grazie a BigQuery, Looker e Analytics Hub, i tempi di reporting per il Department of Labor passano da mesi a ore. I dati su richieste di disoccupazione, tasse e attività dei datori di lavoro vengono ora analizzati in tempo quasi reale, migliorando la trasparenza, la governance e la capacità decisionale. La nuova architettura prepara la base per futuri use case AI nel settore pubblico, riducendo la dipendenza dai sistemi legacy e rafforzando la fiducia dei cittadini.

Impatto strategico

Le innovazioni introdotte nel 2025 posizionano Google Cloud come motore dell’intelligenza artificiale globale. L’integrazione di Gemini, Vertex AI, G4 VMs e Hypercomputer consolida un ecosistema capace di scalare dall’esperimento al deployment industriale, offrendo prestazioni, sicurezza e costi ottimizzati. L’approccio di Google riflette una visione olistica dell’AI come servizio operativo, in grado di trasformare dati, agenti e infrastrutture in un unico continuum intelligente.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.