Google e Meta potenziano l’infrastruttura di privacy e tracciabilità dei dati per sostenere la GenAI su larga scala, mentre Netflix introduce A-SFT, un finetuning supervisionato con pesi di advantage che allinea i recommender generativi alle preferenze reali degli utenti. Le due strategie rispondono a sfide comuni: volumi di dati in crescita, requisiti di compliance sempre più stringenti e necessità di mantenere performance elevate senza amplificare bias o rumore. Meta integra controlli automatici nel ciclo di sviluppo prodotti tramite PAI e componenti come PrivacyLib, Policy Zones e Privacy Probes, così da ottenere lineage end-to-end e enforcement programmabile. Netflix dimostra che l’A-SFT migliora metrica di ranking come NDCG, Hit Rate e MRR, riducendo la dipendenza da reward model imprecisi e stabilizzando l’ottimizzazione offline su dataset con miliardi di token. Queste scelte, complementari per obiettivo, fissano nuovi standard industriali: GenAI più sicura, recommender più accurati e una pipeline di sviluppo capace di evolvere rapidamente senza sacrificare fiducia e qualità.

Infrastruttura privacy di Meta per GenAI: PAI come spina dorsale

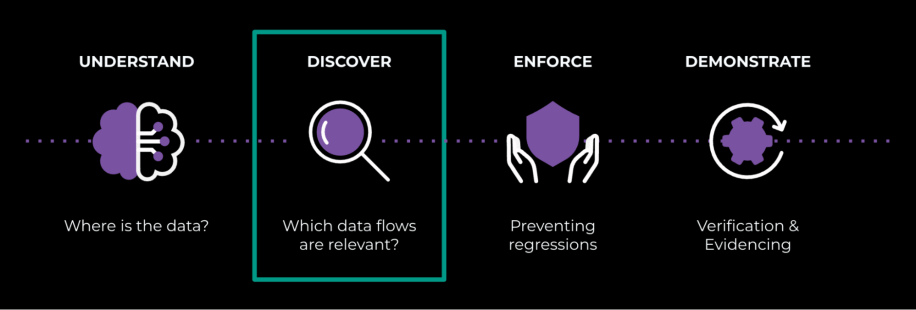

Meta costruisce un’architettura che mette privacy-by-design al centro della GenAI, trasformando la governance dei dati in un fattore abilitante e non in un freno all’innovazione. Il cuore è PAI, una piattaforma che combina data discovery in tempo reale, lineage end-to-end e enforcement automatico delle policy, riducendo interventi manuali e tempi di audit. PAI scompone i workflow in fasi sequenziali che riflettono il ciclo prodotto: comprendere che cosa sono i dati e da dove provengono, mappare i flussi tra microservizi, applicare vincoli attraverso API e dimostrare compliance con evidenze verificabili. In questo modo, i team prodotto iterano rapidamente su funzionalità di GenAI sapendo che controlli coerenti e ripetibili presidiano ogni passaggio.

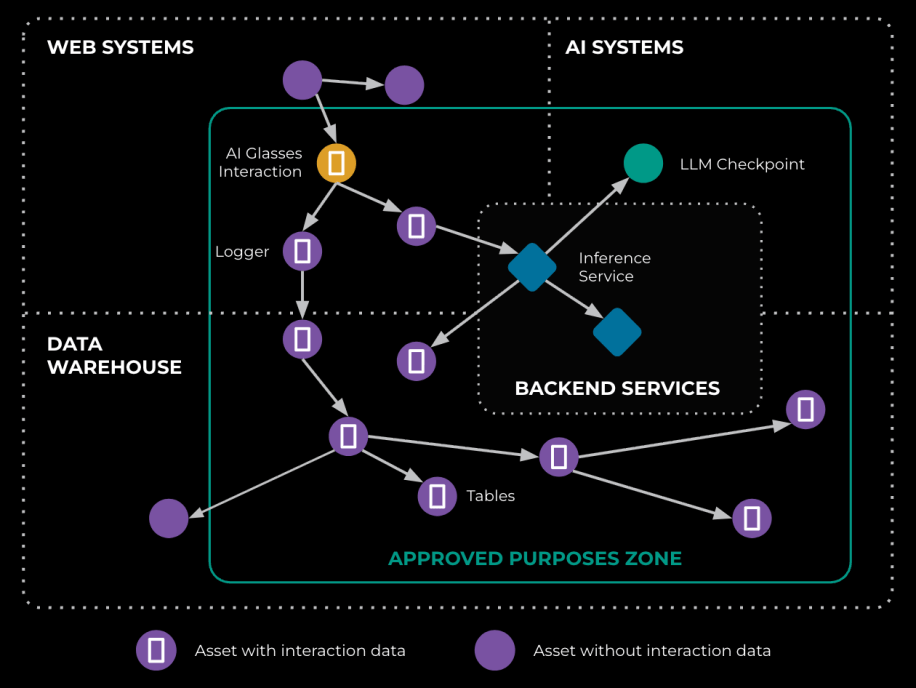

PrivacyLib, Policy Zones e Privacy Probes: i tre pilastri operativi

La libreria PrivacyLib fornisce un logging standardizzato che propaga policy e metadati di consenso attraverso servizi eterogenei, assicurando uniformità semantica tra componenti che elaborano dati web, stream sensoriali e chiamate a LLM. Le Policy Zones definiscono confini d’uso per i dataset: limitano l’impiego in training, fine-tuning o inference in base all’origine, ai vincoli regionali e allo scopo dichiarato, bloccando automaticamente combinazioni non autorizzate. Le Privacy Probes inseriscono punti di osservazione lungo la pipeline per misurare in tempo reale la conformità dei flussi, identificare deviazioni e generare grafi di lineage utili ad audit e controlli interni. L’effetto congiunto è una tracciabilità completa dal dato grezzo fino al modello e ai prodotti che lo utilizzano.

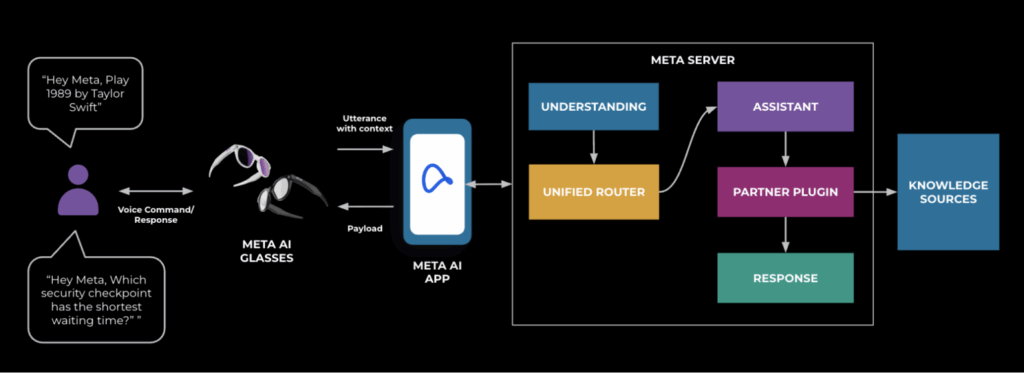

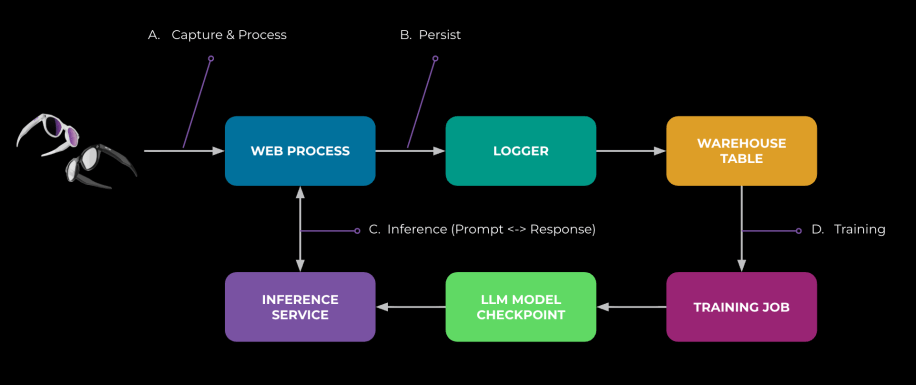

Applicazioni pratiche: dagli occhiali AI al multimodale

Nei dispositivi indossabili, come gli occhiali AI con overlay contestuali e comprensione di scena in tempo reale, PAI traccia le interazioni multimodali dal sensore alla inference, garantendo che i dati rispettino le Policy Zones geografiche e funzionali. In presenza di input audio-video sensibili, PrivacyLib collega le operazioni di read/write ai consensi e alle basi giuridiche, mentre le Privacy Probes sorvegliano i passaggi più critici per prevenire deriva d’uso. Questo approccio riduce i rischi in feature ad alta intensità di dati e consente a Meta di mantenere cicli d’innovazione rapidi senza rinunciare a enforcement e osservabilità.

Scalabilità e adattabilità normativa

La crescita dei volumi e la varietà dei formati richiedono una piattaforma che scala orizzontalmente e si integra con sistemi SQL e non-SQL. PAI si lega agli strumenti developer già in uso e si aggiorna a nuove categorie di dati, così da recepire requisiti normativi emergenti—dal livello regionale fino a quello settoriale—senza costringere i team a rifattorizzazioni invasive. La promessa è convertire la compliance da costo a vantaggio competitivo, con rollout globali più veloci e rischio di violazioni drasticamente ridotto.

Il metodo A-SFT di Netflix: finetuning supervisionato con pesi di advantage

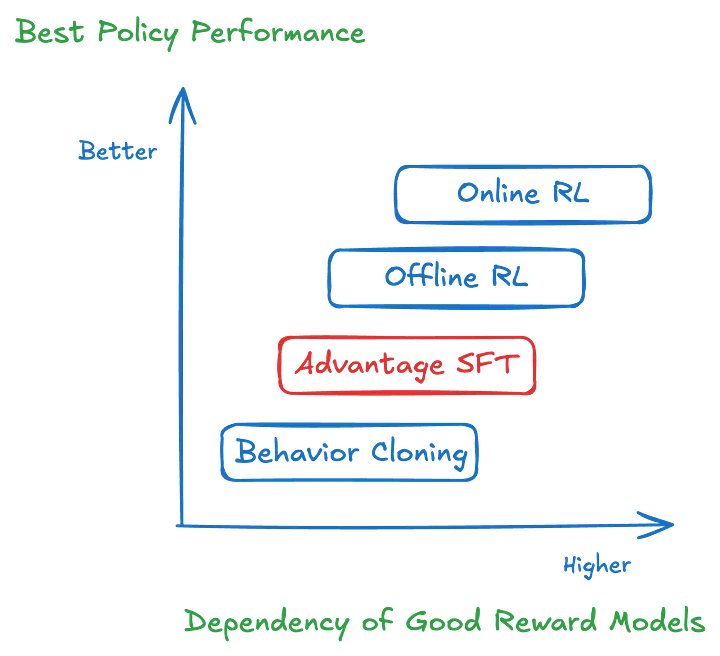

Nel dominio dei recommender generativi, Netflix introduce A-SFT, un metodo che conserva la semplicità del Supervised Fine-Tuning e integra la potenza delle idee di Reinforcement Learning attraverso un advantage che pesa la loss in modo direzionale. Invece di affidarsi a reward model iper-precisi—spesso rumorosi e costosi—A-SFT usa un segnale più robusto: la differenza tra il valore di un’azione raccomandata e una baseline (ad esempio, media o mediana condizionata all’utente). Questo advantage enfatizza le azioni high-reward e de-enfatizza quelle low-reward, riducendo varianza e overfitting al rumore di log.

Allineamento con preferenze reali e riduzione della dipendenza dal reward

L’advantage-weighted SFT bilancia behavior cloning e ottimizzazione del reward: impara dalle sequenze storiche senza restare intrappolato nei loro bias, e al tempo stesso orienta il modello verso scelte che massimizzano engagement e soddisfazione. A-SFT non richiede importance sampling né inverse propensity scoring, evitando i problemi di bias da policy logging che affliggono molte pipeline offline. Il risultato è un allineamento più stabile, che conserva la qualità linguistica dei modelli generativi e ne migliora la coerenza con i gusti latenti degli utenti.

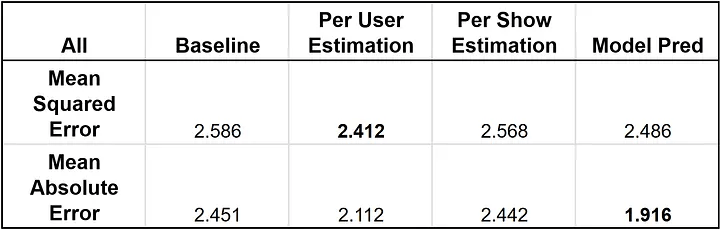

Training su larga scala e confronto con le baseline

Nei test di Netflix, condotti su dataset con miliardi di token e milioni di utenti, A-SFT supera baseline come PPO, DPO, CQL e approcci di reward-weighted BC su metriche di ranking quali NDCG, Hit Rate e MRR. L’uso di un ensemble di reward per la valutazione—anziché un unico giudice—mitiga l’impatto di proxy imperfetti e conferisce robustezza statistica ai risultati. In pratica, il modello raccomanda contenuti più pertinenti, riduce raccomandazioni irrilevanti e migliora indicatori di business come retention e tempo di visione, senza crescite esponenziali di costo computazionale.

Perché A-SFT è semplice da mettere in produzione

La forza di A-SFT sta nella semplicità d’integrazione con pipeline esistenti: basta calcolare un advantage affidabile per peso della loss supervisionata, senza dover costruire infrastrutture complesse di RL on-policy. Il metodo evita il fragile equilibrio tra esplorazione e sfruttamento tipico degli algoritmi di RL classici, e si adatta bene a contesti con feedback limitato o rumoroso, dove i controfattuali sono scarsi o assenti. La stabilità dell’ottimizzazione offline accelera il ciclo di sperimentazione e riduce i tempi di deploy.

Convergenze tra Meta e Netflix: fiducia, qualità e velocità

Meta e Netflix affrontano lati diversi dello stesso problema: come garantire fiducia e qualità quando la GenAI opera su scala globale. Il lineage e l’enforcement automatico di Meta proteggono l’origine e l’uso dei dati senza rallentare i team; l’A-SFT di Netflix coniuga performance e robustezza riducendo la dipendenza da segnali di reward imperfetti. Entrambi i percorsi migliorano il rapporto tra ricerca, prodotto e regolazione, massimizzando la velocità di apprendimento con guardrail chiari.

Bias, rumore e derisking dei sistemi

Un punto di contatto cruciale è la gestione di bias e rumore. Meta limita la deriva d’uso attraverso Policy Zones e Privacy Probes che salvaguardano consenso e scopo; Netflix riduce la varianza usando advantage e validando i guadagni con ensemble di reward. In entrambi i casi, la trasparenza operativa non è un vincolo astratto, ma un meccanismo per ridurre inciampi nella fase di scaling.

Implicazioni normative e di governance

La regolazione—dalla privacy alla AI governance—richiede auditabilità e accountability. Con PAI, Meta produce evidenze verificabili sui flussi e consente risposte rapide a data subject requests e ispezioni. Sul fronte dei recommender, l’adozione di A-SFT facilita la produzione di report tecnici ripetibili sulle scelte del sistema: la ponderazione per advantage esplicita quali raccomandazioni ricevono enfasi e perché, favorendo pratiche di explainability utili verso utenti e regolatori.

Roadmap tecnica: isolamento, latenza e metriche di qualità

Per mantenere comfort e sicurezza, i sistemi devono migliorare su tre assi. Primo, l’isolamento: Meta estende PAI a nuovi modelli multimodali, mantenendo policy uniformi tra addestramento e inference. Secondo, la latenza: Netflix ottimizza i recommender generativi per risposte tempestive anche con context window ampie e reranking multi-stadio. Terzo, le metriche: entrambe le aziende consolidano KPI che combinano qualità percepita, equità e robustezza, andando oltre l’accuratezza di superficie.

Adozione in impresa: dal design del dato all’allineamento del modello

Le organizzazioni che vogliono replicare questi risultati dovrebbero partire dal design del dato. Senza lineage e policy coerenti, ogni miglioramento di GenAI rischia di incontrare colli di bottiglia legali e reputazionali. Implementare librerie analoghe a PrivacyLib, adottare zone d’uso dei dataset e strumentare pipeline con probe riduce i tempi di audit e sblocca iterazioni rapide. Sul versante modelli, un percorso A-SFT-like consente di allineare i recommender alle preferenze effettive, preservando stabilità e contenendo i costi di sperimentazione.

Come funziona davvero l’advantage in A-SFT

Dal punto di vista tecnico, l’A-SFT assegna a ogni esempio un peso proporzionale all’advantage A, calcolato come differenza tra un reward osservato o stimato e una baseline (spesso specifica per utente o contesto). La loss supervisionata L viene moltiplicata per una funzione crescente di A, così che esempi high-reward guidino l’ottimizzazione più di quelli low-reward. Questo schema trasferisce i benefici del policy gradient in un’impostazione supervisionata, riducendo il problema della stima ad alta varianza tipico del RL classico. La scelta della baseline—ad esempio una mediana per robustezza a outlier—risulta decisiva per la stabilità del training e la generalizzazione.

Come si costruisce il lineage end-to-end in PAI

Sul versante privacy, l’elemento chiave è un grafo di lineage che collega fonti dati, trasformazioni, feature store, job di training e servizi di inference. Ogni arco porta metadati su finalità, consenso, regioni e policy applicate. Quando un job legge un dataset, PrivacyLib propaga la policy effettiva; le Policy Zones determinano se l’uso è consentito; le Privacy Probes registrano evidenze a supporto di audit. Questo grafo permette enforcement automatico, rollback selettivi e risposta immediata a richieste di removal o portabilità, abilitando compliance continua su scala globale.

Rischi residui e limiti noti

Nessun approccio elimina totalmente il rischio. Con PAI, la sfida resta coprire nuove sorgenti e tipi di dato emergenti, evitando erosione semantica delle policy quando più team integrano componenti eterogenei. Con A-SFT, l’accuratezza dell’advantage dipende dalla qualità dei proxy di reward e dalla scelta della baseline; scorrettezze sistematiche possono pesare la loss in direzioni subottimali. Per mitigare, Meta rafforza la verifica continua dei flussi e Netflix combina ensemble di reward con validazioni offline-online per rilevare drift e regressioni.

Impatto sullo standard industriale

L’allineamento tra tutela dei dati e qualità del ranking definisce un nuovo standard: modelli che apprendono rapidamente rimanendo governabili, prodotti che evolvono senza compromettere fiducia e performance. Le soluzioni di Meta e Netflix mostrano che è possibile scalare GenAI e recommender generativi mantenendo trasparenza operativa, auditabilità e risultati misurabili sulle metriche che contano davvero per il business.

Il quadro che emerge unisce architetture data-centric e tecniche di allineamento model-centric. Sul lato dati, un grafo di lineage con enforcement automatizzato—supportato da PrivacyLib, Policy Zones e Privacy Probes—consente compliance continua e riduce il rischio di uso improprio nelle pipeline di GenAI. Sul lato modelli, l’A-SFT introduce una ponderazione per advantage nella loss supervisionata, portando la direzionalità del policy gradient in un setting più stabile e scalabile: così si migliorano NDCG, Hit Rate e MRR senza costosi loop di RL e senza affidarsi ciecamente a reward model perfetti. Insieme, questi approcci definiscono un framework pratico per costruire sistemi affidabili, auditable e ad alte prestazioni, pronti per la produzione su scala globale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.