Il nuovo report del Google Threat Intelligence Group segna una svolta cruciale nel panorama della sicurezza informatica globale. Gli analisti hanno documentato come attori malevoli, inclusi gruppi sponsorizzati da stati come Iran, Cina e Corea del Nord, abbiano iniziato a sfruttare modelli di intelligenza artificiale generativa non più come strumenti di supporto, ma come componenti attivi nei loro malware dinamici e nelle operazioni di cyber attacco avanzato. Pubblicato il 5 novembre 2025, lo studio aggiorna una ricerca precedente e mostra come l’AI sia ormai integrata in ogni fase della catena d’attacco, dalla reconnaissance fino all’esfiltrazione dei dati, passando per l’obfuscazione del codice e la manipolazione delle difese automatiche. Secondo Google, il passaggio dall’uso dell’AI come strumento di produttività alla sua integrazione diretta nel codice operativo dei malware rappresenta un’evoluzione senza precedenti. I modelli linguistici non vengono più impiegati soltanto per scrivere script o migliorare l’efficienza dei processi, ma per generare codice malevolo in tempo reale, creando minacce capaci di mutare comportamento durante l’esecuzione. Questo rende obsolete molte strategie di difesa basate su firme statiche, poiché il codice risulta sempre nuovo, imprevedibile e adattivo.

Malware generati e gestiti con AI

Il report evidenzia la comparsa di famiglie di malware che sfruttano l’intelligenza artificiale in modo attivo. Tra i casi più significativi, PROMPTFLUX utilizza la Gemini API per rigenerare porzioni di codice ogni ora, rendendo inefficaci gli antivirus tradizionali. Scritto in VBScript, questo dropper registra le risposte del modello gemini-1.5-flash-latest e le usa per riscrivere in modo continuo la propria struttura interna, mantenendo persistenza anche in ambienti monitorati. Accanto a esso, PROMPTSTEAL rappresenta un’evoluzione ulteriore: si serve della Hugging Face API e del modello Qwen2.5-Coder-32B-Instruct per generare comandi Windows volti a raccogliere informazioni di sistema e duplicare file sensibili. Google collega il suo impiego al gruppo russo APT28, che lo ha utilizzato contro obiettivi ucraini, mascherandolo da generatore di immagini AI. Un altro esempio è PROMPTLOCK, un ransomware cross-platform sviluppato in Go, in grado di generare script Lua per la scansione del filesystem e avviare cifrature simultanee su ambienti Windows e Linux. Seguono poi FRUITSHELL, una reverse shell PowerShell programmata con prompt codificati per aggirare i filtri di sicurezza AI, e QUIETVAULT, un infostealer progettato per cercare segreti nei repository GitHub e NPM utilizzando query AI dinamiche, con successiva esfiltrazione su server controllati dagli aggressori. Tutti questi strumenti mostrano un’evoluzione precisa: il malware non è più un blocco statico, ma un organismo che interagisce costantemente con i modelli linguistici per adattarsi alle difese. La simbiosi tra AI e codice malevolo segna l’ingresso in una nuova era della minaccia informatica.

Uso dell’intelligenza artificiale da parte di attori statali

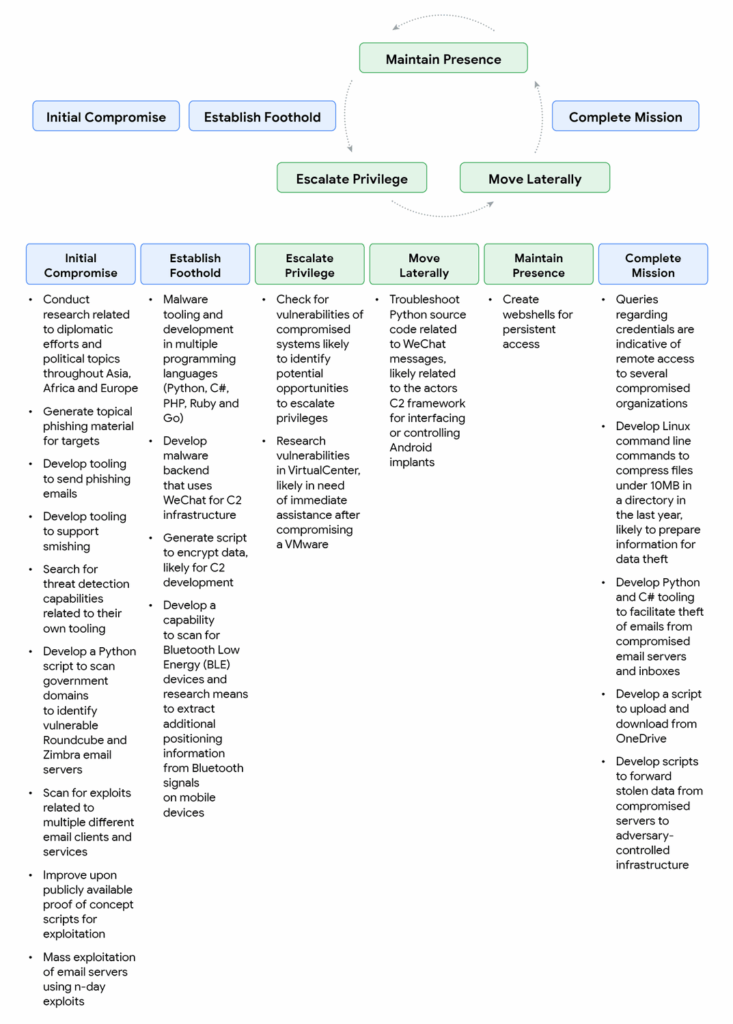

Google evidenzia che i gruppi APT sponsorizzati da stati autoritari stanno sperimentando l’uso dell’AI con un livello di integrazione strategica mai visto prima. Gli attori iraniani, tra cui TEMP.Zagros e APT42, hanno utilizzato Gemini per generare web shell, costruire server di comando e controllo in Python e creare agenti SQL automatizzati per analizzare database contenenti numeri di telefono e tracciamenti di viaggio. Fingendosi ricercatori universitari, hanno aggirato le restrizioni etiche dei modelli per ottenere codice malevolo “a fini accademici”.

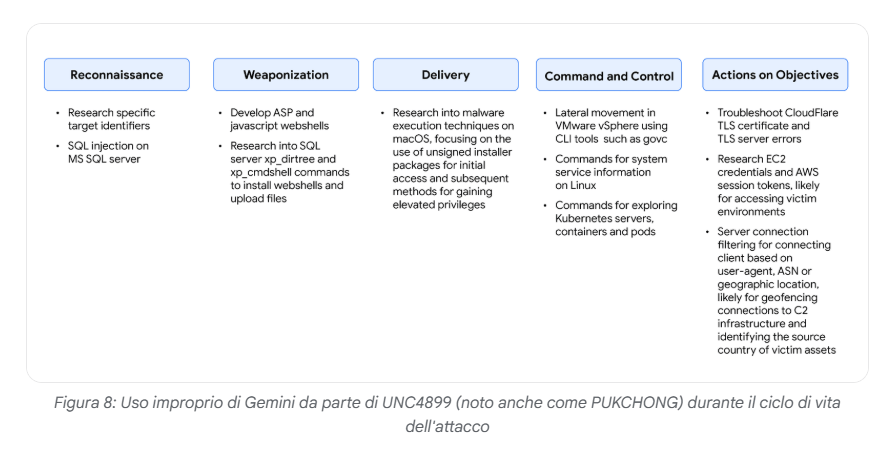

In Cina, il gruppo APT41 ha sviluppato il framework OSSTUN in C++ e Go, integrando componenti AI per migliorare la capacità di offuscamento e di comunicazione tra sistemi infetti. Gli operatori cinesi hanno simulato partecipazioni a competizioni Capture The Flag per ottenere informazioni su vulnerabilità in ambienti AWS, Kubernetes e vSphere, sfruttando poi tali conoscenze per il movimento laterale e l’esfiltrazione dei dati.

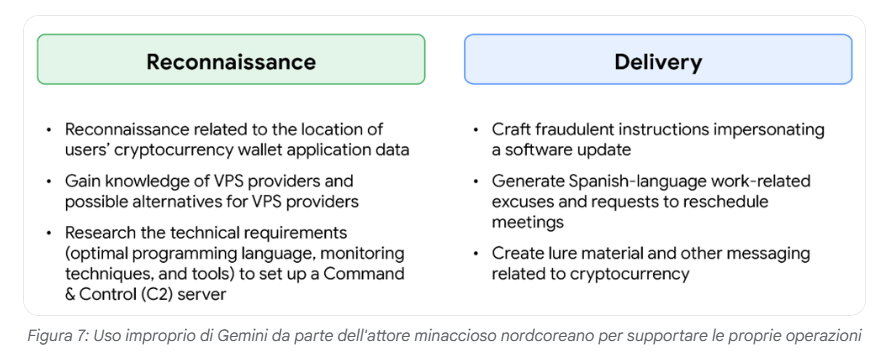

La Corea del Nord, invece, si è concentrata su operazioni a carattere finanziario. I gruppi UNC1069 e UNC4899 hanno usato modelli AI per creare campagne di phishing multilingue e sviluppare deepfake di legittimi sviluppatori di software, con cui distribuire aggiornamenti fraudolenti o pacchetti SDK alterati. In diversi casi, le campagne sono state collegate al furto di criptovalute destinate al finanziamento del programma missilistico di Pyongyang.

Google ha disattivato oltre trecento asset collegati a queste operazioni e introdotto aggiornamenti nei propri modelli per impedire il riutilizzo delle stesse tecniche di inganno.

Mercato underground e democratizzazione del cybercrime

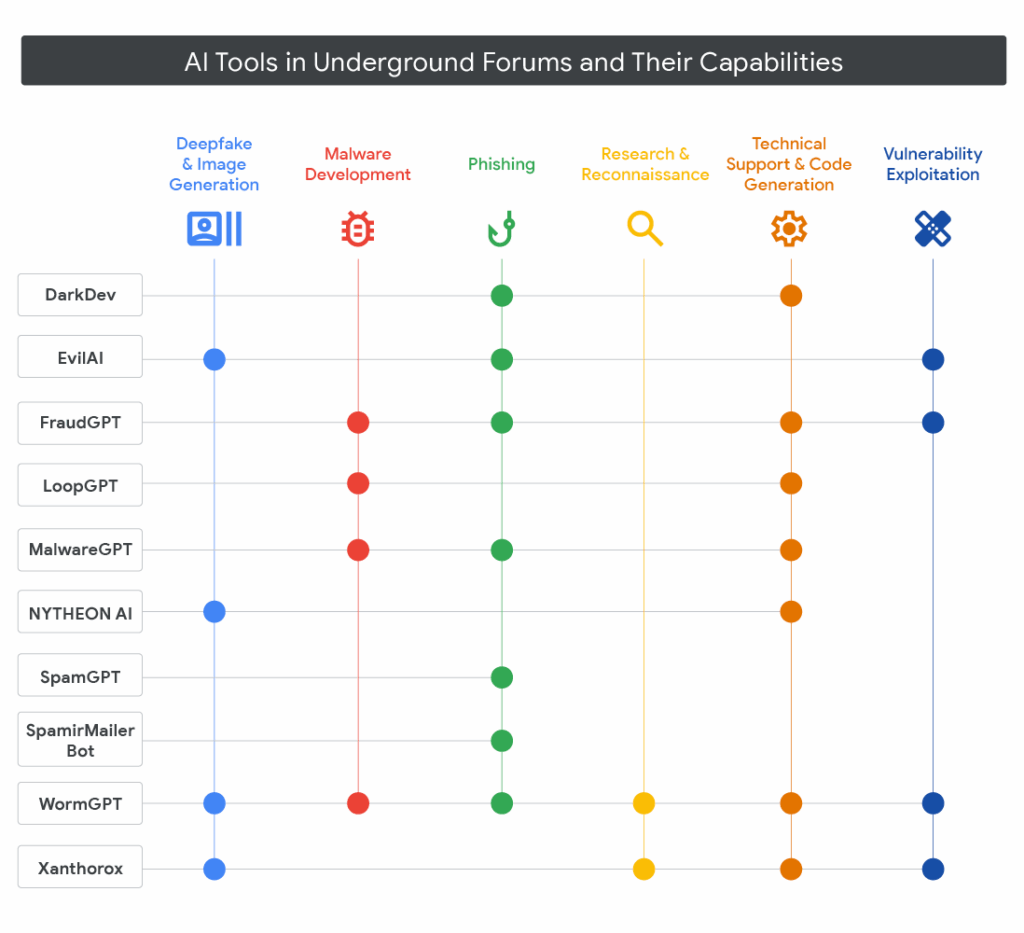

Accanto ai gruppi statali, si è sviluppato un mercato sotterraneo dedicato ai tool AI per uso criminale. Google ha documentato forum in lingua russa e inglese dove vengono venduti servizi di intelligenza artificiale in abbonamento, capaci di generare codice dannoso, scrivere email di phishing personalizzate, creare documenti falsi e persino individuare vulnerabilità in sistemi non patchati.

Alcuni di questi strumenti si presentano come software legittimi per test di sicurezza, ma vengono rapidamente riadattati per scopi malevoli. Le versioni più avanzate offrono accesso ad API premium e includono moduli per deepfake destinati a bypassare procedure KYC o frodare istituti finanziari. L’effetto di questa diffusione è un abbassamento drastico delle barriere d’ingresso: hacker poco esperti possono ora lanciare operazioni complesse senza possedere conoscenze tecniche profonde. Google stima che nel 2025 la disponibilità di tool AI multifunzionali nel dark web sia aumentata di oltre il 180% rispetto all’anno precedente. Più della metà di questi sfrutta modelli open-source addestrati su dataset tecnici pubblici, una tendenza che rende estremamente difficile distinguere l’uso etico da quello criminale.

Difese, framework e implicazioni globali

In risposta a questa evoluzione, Google ha potenziato il Secure AI Framework (SAIF), una piattaforma di sicurezza che definisce un approccio unitario alla gestione del rischio legato all’intelligenza artificiale. L’azienda promuove una strategia basata sul monitoraggio continuo dei prompt e dei log API, indispensabile per riconoscere schemi sospetti e anomalie operative. Il red teaming costante sui modelli Gemini e Bard consente di testare la resistenza alle manipolazioni, mentre l’uso del watermarking nei dataset e nei modelli permette di tracciare eventuali abusi o derivazioni non autorizzate. A queste misure si aggiungono linee guida dettagliate per gli sviluppatori, che forniscono strumenti di valutazione del rischio e integrazioni automatiche di sicurezza nelle pipeline di sviluppo. Google definisce questo approccio come una forma di AI difensiva, in cui la stessa tecnologia viene impiegata per rilevare e contrastare comportamenti ostili generati da altri modelli. L’azienda ha inoltre aggiornato il framework Big Sleep, dedicato all’analisi di prompt injection e query malevole, e ha ampliato il progetto CodeMender, che corregge automaticamente porzioni di codice a rischio. Queste iniziative si accompagnano a un impegno etico più ampio: la creazione di standard internazionali per l’uso responsabile dell’intelligenza artificiale e la collaborazione con governi e organizzazioni per definire protocolli di sicurezza condivisi. Google sottolinea che solo una cooperazione globale tra settore pubblico e privato potrà impedire che l’AI diventi un’arma a disposizione di regimi o gruppi criminali.

L’anno cruciale della sicurezza AI

Il 2025 segna una svolta nella relazione tra intelligenza artificiale e cybersecurity. I malware come PROMPTFLUX, PROMPTLOCK e QUIETVAULT dimostrano che l’AI non è più un semplice strumento di supporto, ma un motore operativo del crimine informatico. Le campagne sponsorizzate da stati come Iran, Cina e Corea del Nord rivelano come la tecnologia possa essere impiegata per scopi strategici, mentre i mercati clandestini moltiplicano l’accesso ai tool malevoli. La sfida che attende governi e imprese nel 2026 sarà quella di garantire un equilibrio tra innovazione e sicurezza, sviluppando una cultura della responsabilità tecnologica che preservi l’intelligenza artificiale come risorsa per la società, e non come vettore di minaccia.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.