Google Cloud inaugura una nuova fase nell’evoluzione dell’intelligenza artificiale con il debutto della TPU Ironwood e delle VM Axion, progettate per potenza di calcolo e sostenibilità. La settima generazione di Tensor Processing Unit segna un salto di dieci volte nelle prestazioni rispetto alla TPU v5p e di quattro volte rispetto alla v6e, mentre le VM N4A basate su Axion offrono fino al doppio del rapporto prestazioni-prezzo rispetto alle istanze x86 tradizionali. L’annuncio include anche l’espansione delle istanze C4A metal bare metal Arm, nuovi strumenti per sviluppatori con Gemini, e la migrazione enterprise a Memorystore for Valkey, a conferma della strategia Google di integrare hardware, software e sostenibilità in un’unica piattaforma cloud.

Innovazioni in Ironwood TPU

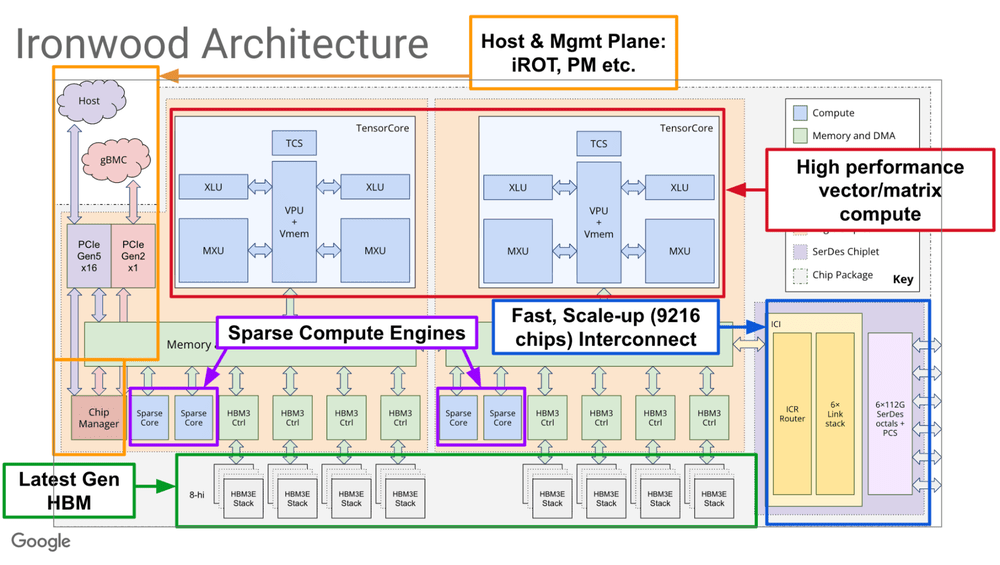

La TPU Ironwood è stata sviluppata per addestrare e distribuire modelli AI da trilioni di parametri, combinando efficienza energetica e scalabilità estrema. Ogni chip incorpora una Matrix Multiply Unit per operazioni matriciali e una Vector Processing Unit per i calcoli element-wise, mentre i nuovi SparseCores ottimizzano le ricerche embedding. Il risultato è una capacità di 42,5 exaflops in FP8, supportata da otto stack HBM3E per chip con 192 GiB di memoria e 7,4 TB/s di banda.

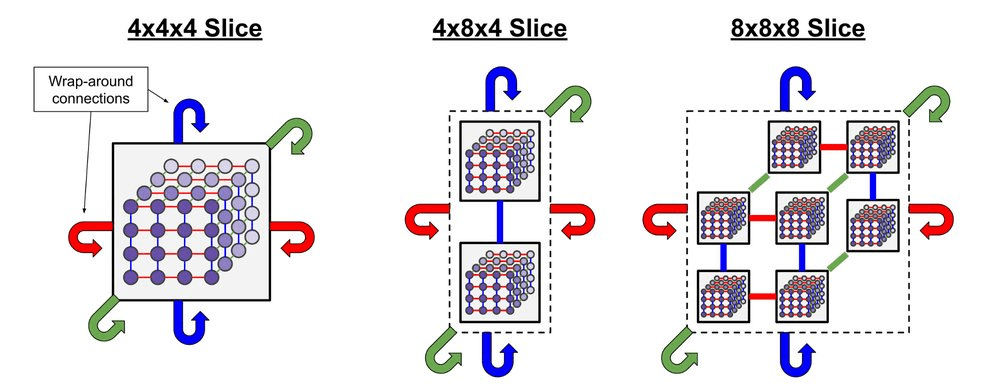

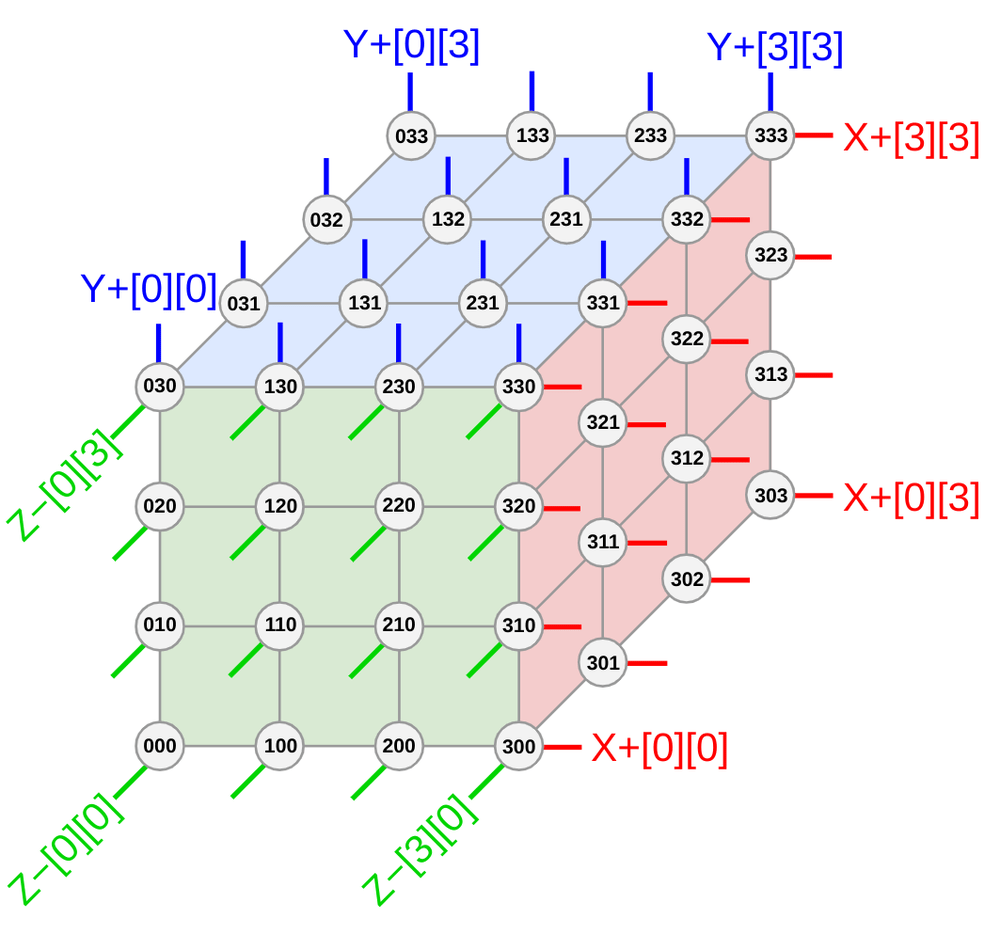

L’architettura Ironwood permette di scalare fino a 9.216 chip collegati in un superpod ottico con 1,77 petabyte di memoria condivisa, gestito da un sistema di Optical Circuit Switch che garantisce tolleranza ai guasti e riconfigurazione dinamica. Grazie al raffreddamento a liquido a scala gigawatt, la TPU raggiunge un’efficienza energetica doppia rispetto alla Trillium e fino a 30 volte superiore rispetto al 2018, con un uptime del 99,999%.

Google Cloud integra nel suo stack AI JAX, PyTorch nativo e vLLM, supportando addestramento e inferenza unificati. Strumenti come MaxText e XLA compiler migliorano la parallelizzazione e la compilazione “whole-program”, mentre Cluster Director su GKE automatizza la manutenzione. Ironwood è già testata su Gemini e su modelli sperimentali come Nano Banana, dimostrando capacità di eseguire reinforcement learning complesso con costi ridotti per watt e maggiore resilienza operativa.

VM Axion: N4A e C4A metal

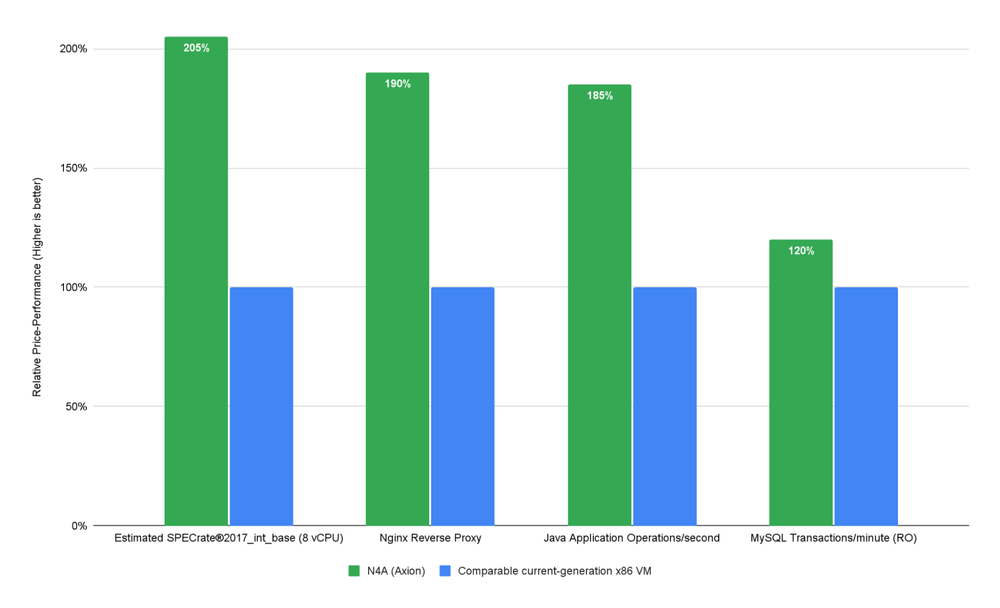

Parallelamente, Google Cloud introduce la linea Axion VM, basata su architettura Arm Neoverse N3, con due varianti principali. Le N4A VM, ora in preview, offrono fino a 64 vCPU e 512 GB di RAM DDR5, con throughput di 50 Gbps e storage Hyperdisk fino a 160.000 IOPS. Queste istanze si distinguono per configurazioni flessibili e prestazioni-prezzo superiori del 105% rispetto a sistemi x86, rendendole ideali per microservizi, workload general purpose e database mid-sized.

Le C4A metal forniscono potenza bare metal con 96 vCPU e 768 GB di memoria, eliminando gli overhead della virtualizzazione. Progettate per ambienti high-performance, supportano sviluppo Android, rendering, e simulazioni ad alta intensità computazionale, con connettività Tier 1 a 100 Gbps e Titanium SSD locali da 6 TB. La combinazione di Axion e Hyperdisk ML abilita accesso condiviso ad alta velocità per carichi AI distribuiti, con un 80% di miglioramento prestazioni per watt e 30% di incremento nel transcoding video.

Sviluppo AI semplificato con Gemini e Vertex AI

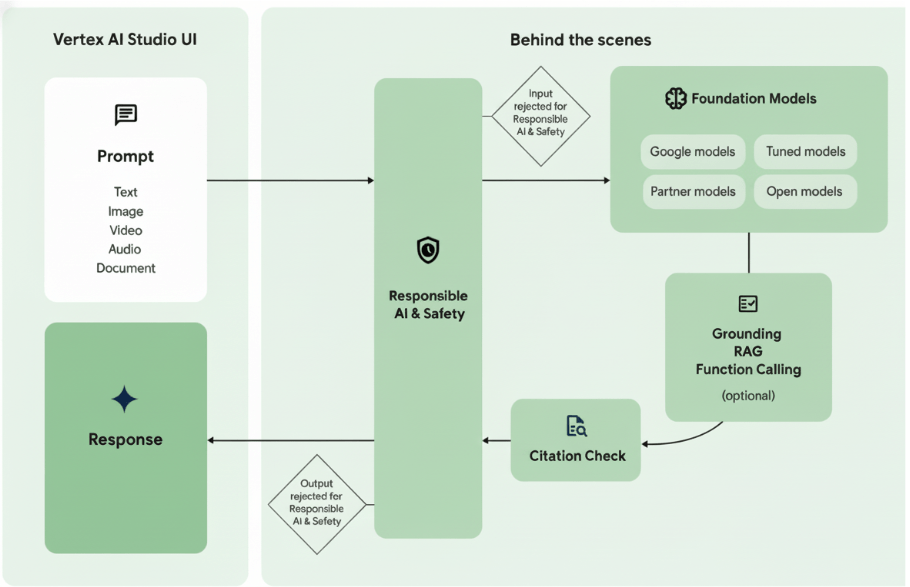

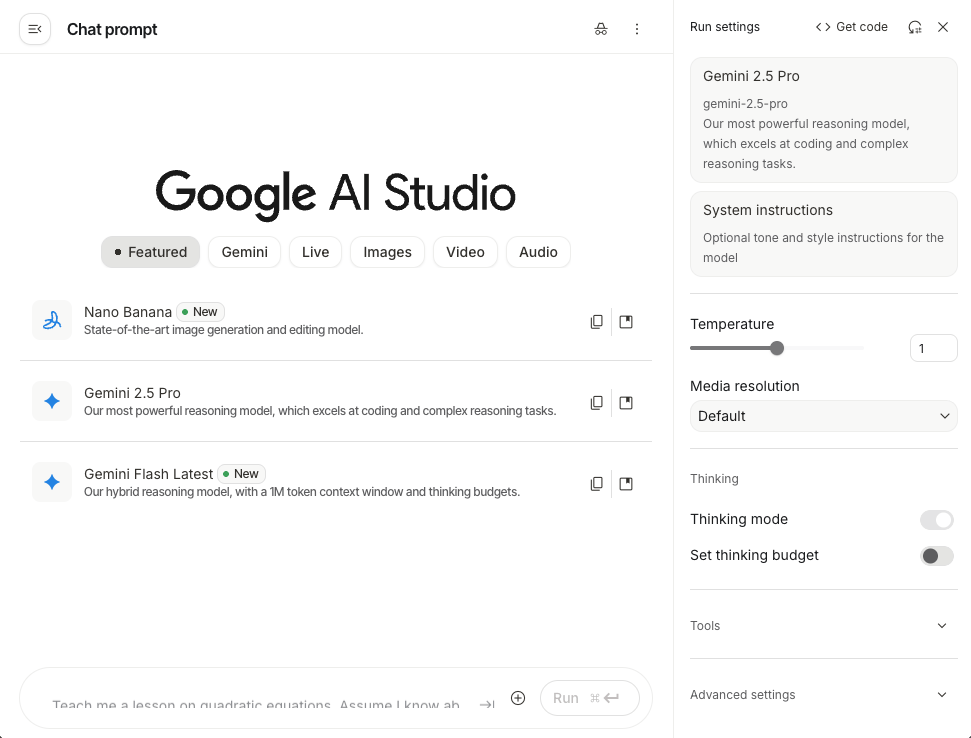

Google Cloud amplia anche la gamma di strumenti per sviluppatori con un codelab integrato in Vertex AI SDK. Questo ambiente permette di costruire applicazioni AI multimodali senza conoscenze avanzate, collegando in modo nativo le API di Gemini e includendo function calling, autenticazione sicura e prompt contestuali. Gli sviluppatori possono creare chatbot e servizi interattivi, come assistenti di viaggio o strumenti di supporto, sfruttando Geocoding API e risposte personalizzate.

Il sistema promuove rapid prototyping e iterazione continua, favorendo una AI accessibile e production-ready. Con integrazione diretta su AI Studio e Vertex AI, Google facilita la diffusione di applicazioni intelligenti su scala enterprise, accelerando l’adozione di soluzioni agentiche e multimodali.

Migrazione a Memorystore for Valkey

La società Buildertrend è tra i primi esempi di migrazione a Memorystore for Valkey, evoluzione open source compatibile con Redis. La migrazione di 300 istanze globali ha ridotto downtime e complessità infrastrutturale grazie alla replica cross-regionale nativa e all’integrazione con Private Service Connect. Con throughput di 30.000 richieste al secondo, Valkey gestisce caching e session state su larga scala, migliorando resilienza e scalabilità per applicazioni cloud-native. La soluzione semplifica i flussi di rete, elimina proxy intermedi e assicura failover trasparente, consolidando la piattaforma di caching di Google Cloud come pilastro per architetture real-time e sistemi con milioni di utenti simultanei. Buildertrend evidenzia un time-to-market più rapido e una riduzione dei costi operativi grazie all’automazione del layer di replica e al supporto tecnico Google.

Principi di sostenibilità software

L’innovazione di Google Cloud si fonda sui principi 4Ms per la sostenibilità software: Machine, Model, Mechanisation e Map. Questi pilastri guidano la progettazione di sistemi efficienti per watt, la riutilizzazione di modelli ottimizzati, l’automazione serverless e l’esecuzione su energia carbon-free. Con un PUE di 1.09 e data center alimentati da fonti rinnovabili al 100%, Google integra sostenibilità nel ciclo di vita AI, riducendo emissioni e costi infrastrutturali. Progetti come Green Light, che ottimizza i semafori urbani, e Contrails, che riduce l’impatto ambientale del traffico aereo, riflettono questa filosofia. Il whitepaper Build Software Sustainably e gli AI Days Nordics diffondono le best practice per lo sviluppo ecologico. Ironwood, grazie alla liquid cooling e all’efficienza 30x dal 2018, rappresenta un esempio di AI green, dove performance e impatto ambientale trovano finalmente equilibrio.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.