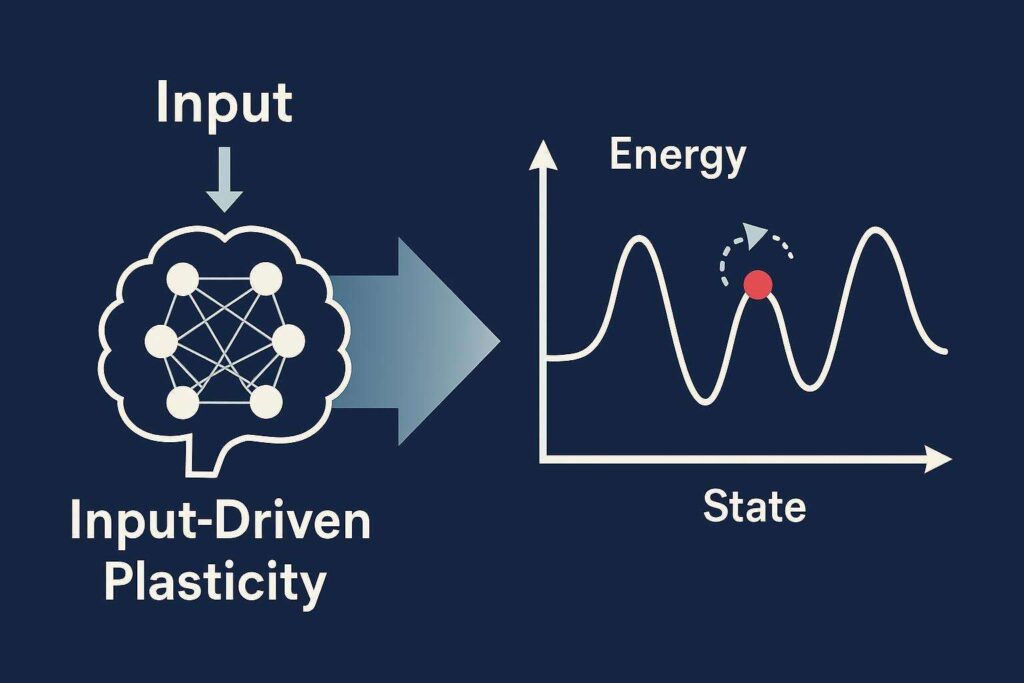

Un gruppo di ricercatori dell’Università della California, Santa Barbara (UCSB) ha presentato un nuovo modello computazionale che potrebbe rivoluzionare l’architettura delle reti neurali artificiali, ridefinendo il concetto stesso di memoria associativa. Il paradigma si chiama Input-Driven Plasticity (IDP) e si propone come alternativa dinamica al modello statico delle classiche Hopfield networks, attraverso un’interazione continua tra stimoli esterni e paesaggio energetico interno.

Il principio è semplice nella forma, ma sofisticato nell’implementazione: ogni stimolo ricevuto, come ad esempio l’immagine di una coda di gatto, modifica attivamente e istantaneamente lo spazio delle possibilità neurali, facendo sì che il sistema “discenda” in modo naturale verso il ricordo corretto. Questo meccanismo non solo permette un recupero più preciso della memoria, ma è anche robusto al rumore, utilizzando l’ambiguità dell’input per filtrare memorie instabili a favore di quelle più stabili.

Secondo il professor Francesco Bullo, il sistema consente al network di “semplificare il proprio paesaggio energetico man mano che riceve stimoli”, a differenza delle reti Hopfield, che operano su un terreno statico. Inoltre, il modello IDP non richiede un punto di partenza preciso: qualsiasi stimolo pertinente è in grado di guidare il sistema verso l’obiettivo mnemonico corretto, anche in caso di input parziali o disturbati.

Il concetto di attenzione selettiva – già alla base dei modelli transformer come GPT – viene qui reinterpretato in una chiave neurodinamica, dove ogni elemento dello stimolo viene processato progressivamente, con il network che si ricalibra in tempo reale sulla base del focus momentaneo. Anche se il modello parte da un punto di vista teorico completamente differente rispetto ai transformer, i ricercatori intravedono possibili connessioni applicative future, suggerendo una convergenza fra sistemi di memoria associativa e linguaggi neurali su larga scala.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.