L’Intelligenza Artificiale (AI) sta emergendo come una tecnologia cruciale per i servizi pubblici, con la sua applicazione in continua crescita. Nel settore delle forze dell’ordine, l’AI offre opportunità straordinarie per migliorare l’efficienza e l’accuratezza nelle indagini, nella sicurezza delle frontiere, nelle procedure di giustizia penale e nei processi di asilo. L’AI può assistere nell’analisi di vasti set di dati, nell’identificazione di schemi nel comportamento criminale, nella previsione di minacce e nella gestione ottimizzata dei casi. Tuttavia, parallelamente a questi benefici, si pone la sfida etica del bias nell’AI, che può condurre a discriminazioni e all’erosione della fiducia pubblica, risultando in pratiche di polizia inaccurate, come l’errata identificazione di individui.

Un rapporto dell’Europol Innovation Lab, intitolato “AI bias in law enforcement – A practical guide“, affronta questa problematica cruciale, fornendo chiarezza sul concetto di bias nell’AI, esplorandone i potenziali danni e spiegando le strategie per rilevarlo e mitigarle. Europol, come agenzia centrale per la cooperazione delle forze dell’ordine nell’Unione Europea, ha il compito di supportare gli Stati membri nell’integrazione dell’AI, assicurando che sia conforme alla legislazione UE (come l’AI Act), trasparente, efficiente e allineata con gli standard etici.

Cosa leggere

Cos’è il Bias nell’AI e dove si annida?

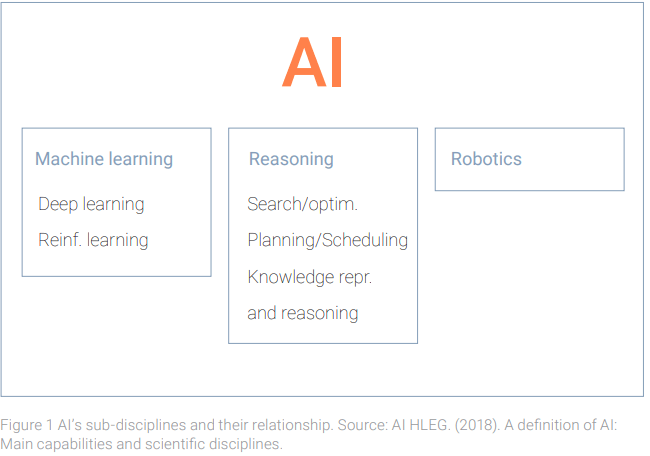

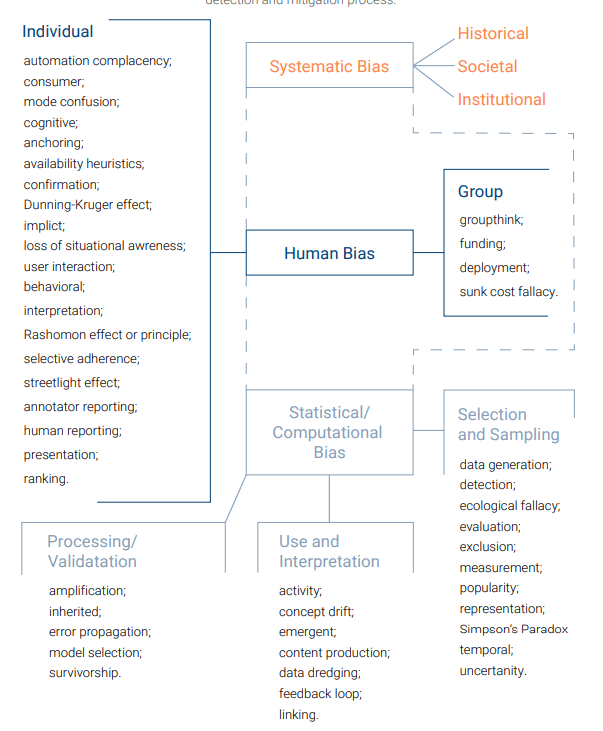

Il bias nell’AI è definito come “errori sistematici o pregiudizi nei dati, negli algoritmi o nei risultati di un sistema di AI che favoriscono o svantaggiano ingiustamente determinati gruppi o individui”. Mentre ogni modello di Machine Learning (ML) è intrinsecamente “biased” per il suo design (essendo concepito per rilevare schemi nei dati di addestramento), l’attenzione è posta sui bias indesiderati e dannosi.

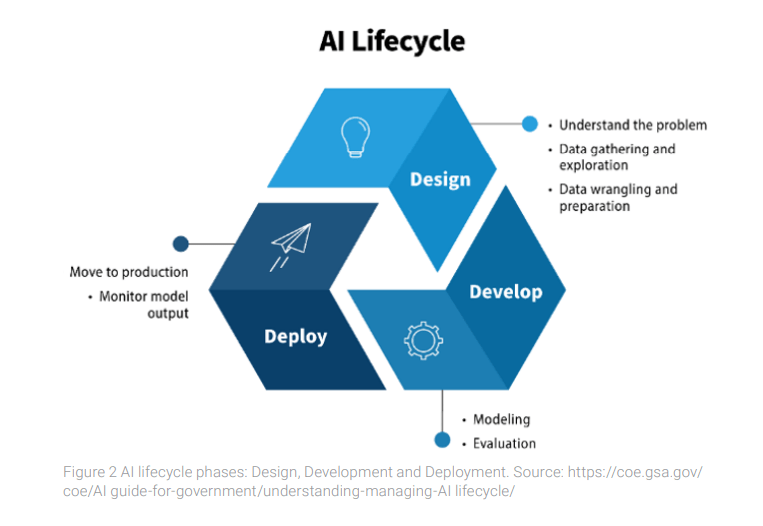

Il bias nell’AI può emergere in ogni fase del ciclo di vita del sistema:

- Fase di Progettazione (Design):

- Bias nella formulazione del problema: Si verifica quando l’obiettivo del sistema AI è definito in modo troppo semplicistico o impreciso, non cogliendo la complessità dei reali obiettivi predittivi. Ad esempio, un sistema progettato per ridurre le violazioni del traffico potrebbe concentrarsi su aree con molte telecamere, ignorando aree con alti tassi di incidenti ma meno dati preesistenti.

- Bias storico: I dati stessi possono contenere complessi schemi sociali e storici influenzati da bias umani, perpetuando stereotipi (razza, etnia, genere) anche se il sistema riflette accuratamente il mondo.

- Bias di campionamento o rappresentazione: I dati raccolti sono sbilanciati e non rappresentano accuratamente la popolazione per cui il sistema è destinato. Se un algoritmo di riconoscimento facciale è addestrato prevalentemente su soggetti maschi bianchi, potrebbe non funzionare bene su donne di altre etnie.

- Bias di etichettatura (labelling): Gli individui responsabili dell’etichettatura dei dati permettono alle loro visioni soggettive di influenzare il processo. Annotatori con pregiudizi inconsci potrebbero etichettare come “sospettoso” il comportamento di individui di determinate origini etniche più frequentemente rispetto a comportamenti identici di altri individui.

- Fase di Sviluppo (Development):

- Bias di misurazione o proxy: Deriva da misurazioni inaccurate, da una precisione variabile tra gruppi, o dall’uso di attributi non sensibili che sono altamente correlati ad attributi sensibili (come la razza o il genere), portando a risultati distorti. Ad esempio, l’uso di un codice postale può inavvertitamente servire da proxy per la demografia socio-economica ed etnica.

- Bias di aggregazione: Un singolo modello uniforme viene applicato a dati contenenti sottogruppi distinti che richiederebbero considerazione individualizzata, ottimizzando il modello per il gruppo predominante. Gli strumenti di polizia predittiva possono mostrare questo bias se sviluppati con dati di crimine di diverse città senza considerare i contesti unici di ciascuna.

- Bias di apprendimento (algoritmico): La scelta degli algoritmi o la progettazione del processo di apprendimento introduce o amplifica bias indesiderabili.

- Bias di valutazione: I parametri di valutazione scelti, i dati di test o l’interpretazione dei risultati non riflettono accuratamente come il sistema AI si comporterà nel mondo reale.

- Fase di Implementazione (Deployment):

- Bias di implementazione: Il modello fatica ad applicare i suoi schemi appresi a nuovi dati non visti, spesso a causa di un eccessivo adattamento (overfitting) ai dati di addestramento.

- Bias di utilizzo improprio (misuse bias): Un sistema AI progettato per uno scopo viene utilizzato per un altro (deployment “off-label”). Un sistema creato per monitorare il traffico riutilizzato per prevedere attività criminali basate sul movimento dei veicoli può portare a sospetti e sorveglianza ingiustificati.

- Bias di automazione: Eccessiva dipendenza dall’AI, che porta gli operatori umani a ignorare la propria esperienza e alterare decisioni accurate per allinearsi alle raccomandazioni dell’AI.

Il pericolo della Polizia Predittiva: ruolo del Quadro Normativo UE

Le conseguenze del bias nell’AI possono essere particolarmente pericolose nei sistemi di polizia predittiva. Questa strategia utilizza tecniche analitiche per fare previsioni statistiche sull’attività criminale potenziale, cercando di intervenire prima che i crimini si verifichino. Si distingue tra mappatura predittiva (o “place-based”), che predice dove e quando un crimine potrebbe verificarsi a livello aggregato (punti caldi di criminalità), e identificazione predittiva, che analizza a livello individuale o di gruppo, prevedendo potenziali criminali o vittime.

Se la mappatura predittiva porta a un aumento della presenza della polizia in aree abitate prevalentemente da determinate minoranze etniche, l’area stessa diventa un proxy per l’origine etnica, configurando una discriminazione indiretta. Esempi concreti di bias sono stati osservati: il progetto olandese “Sensing” a Roermond, che ha mirato a contrastare i furti, ha identificato veicoli con targhe dell’Europa orientale, cercando di individuare i Rom come sospetti, con un modello specificamente orientato contro i cittadini non olandesi. Anche il software di mappatura predittiva “Precobs”, usato in Germania e Svizzera, ha mostrato limiti dovuti a dati insufficienti per previsioni affidabili.

Una delle principali sfide nella polizia predittiva è l’utilizzo di dati storici viziati. I dati di addestramento degli algoritmi provengono spesso da database di polizia e possono non essere rappresentativi del presente, risentendo della riluttanza di alcuni gruppi socio-economici a denunciare crimini o della maggiore presenza della polizia in determinate aree. Questo può creare un ciclo di feedback negativo: se i sistemi AI viziati indirizzano le pattuglie in aree già sovrasorvegliate, si creano set di dati che sembrano riflettere tassi di criminalità più elevati, ma che in realtà riflettono solo una maggiore attenzione della polizia. Il caso dello scandalo olandese dei sussidi per l’infanzia, dove un algoritmo ha severamente colpito categorie vulnerabili come le madri single con condizioni mediche attraverso un bias “by proxy”, ne è un esempio lampante.

L’Unione Europea ha affrontato attivamente il tema dell’AI e del bias, in particolare in settori sensibili come le forze dell’ordine, attraverso iniziative come l’High-Level Expert Group on Artificial Intelligence (AI HLEG) e la sua “Ethics Guidelines on Trustworthy AI” (2019). La legislazione chiave include il Regolamento sull’Intelligenza Artificiale (AI Act – Regolamento (UE) 2024/1689), in vigore da agosto 2024, che classifica i sistemi AI usati dalle forze dell’ordine come “ad alto rischio”. L’AI Act vieta l’uso di sistemi AI per la polizia predittiva basati unicamente sulla profilazione di una persona fisica o sulla valutazione dei suoi tratti di personalità. Impone inoltre requisiti rigorosi per questi sistemi:

- Sistema di gestione dei rischi.

- Qualità dei dati e governance per set di dati di addestramento, validazione e test.

- Documentazione dettagliata.

- Trasparenza e fornitura di informazioni agli utilizzatori.

- Sorveglianza umana (Human oversight), per comprendere i limiti del sistema e prevenire il bias di automazione.

- Accuratezza, robustezza e cybersecurity, con misure per eliminare o ridurre il rischio di output viziati che influenzano gli input all’interno dei cicli di feedback.

- Valutazioni d’impatto sui diritti fondamentali (Fundamental rights impact assessments).

Misurare l’equità: le metriche del Bias nell’AI

Europol sottolinea che la comprensione e l’applicazione di metriche di equità (fairness metrics) sono fondamentali per la rilevazione e la mitigazione del bias. Le definizioni di equità dipendono dal contesto e dal caso d’uso. Le metriche possono essere classificate in diverse categorie:

- Metriche Statistiche (Group Fairness): Si basano sulle previsioni del modello o sulle probabilità previste e sugli esiti reali, focalizzandosi sull’equità tra gruppi demografici.

- Parità Demografica (Demographic Parity): La probabilità di un esito positivo è la stessa tra i gruppi, indipendentemente dalla “verità effettiva” (ground truth).

- Disparità d’Impatto (Disparate Impact): Rapporto tra la probabilità di esito positivo tra il gruppo di minoranza e quello di non minoranza.

- Pari Opportunità (Equal Opportunity): Il tasso di veri positivi (True Positive Rate – TPR) è uguale tra i gruppi.

- Uguaglianza Predittiva (Predictive Equality): Il tasso di falsi positivi (False Positive Rate – FPR) è uguale tra i gruppi.

- Probabilità Equilibrate (Equalised Odds): Sia il TPR che il FPR sono uguali tra i gruppi.

- Calibrazione (Calibration): Le probabilità predette dal sistema AI riflettono accuratamente la vera probabilità di un evento.

- Metriche Basate sulla Somiglianza (Individual Fairness): Mirano a garantire risultati simili per individui simili, indipendentemente dagli attributi protetti. Esempio: “Fairness through awareness” che definisce l’equità se produce risultati simili per individui simili secondo metriche specifiche del compito.

- Metriche Basate sul Ragionamento Causale: Distinguono tra correlazione e causalità per evitare di interpretare correlazioni come discriminazioni. Esempio: “Counterfactual fairness”, dove una decisione è giusta se rimarrebbe invariata in un mondo ipotetico in cui un attributo sensibile è diverso, mentre tutti gli altri attributi rimangono gli stessi.

Strategie di mitigazione del Bias e le Scelte Complesse

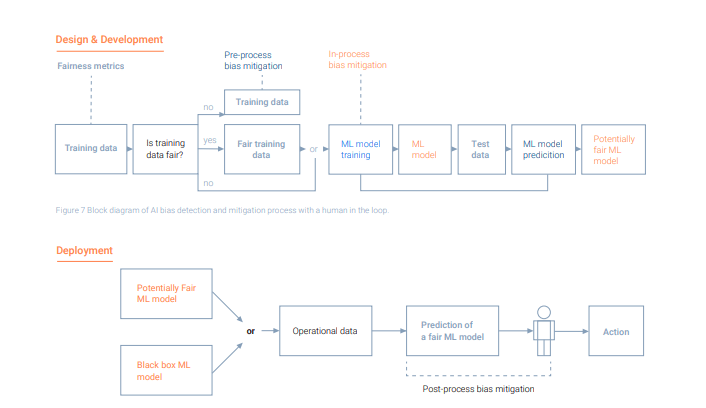

Le tecniche per mitigare il bias si dividono in tre categorie:

- Pre-processing: Modifiche ai dati di addestramento prima che il modello ML venga addestrato, per eliminare correlazioni con attributi protetti. Metodi includono la riponderazione dei dati, il campionamento, la modifica delle rappresentazioni delle feature e la generazione di dati sintetici.

- In-training: Incorporazione di vincoli di equità direttamente nel processo di ottimizzazione durante l’addestramento del modello ML. Esempi sono la regolarizzazione della funzione obiettivo e l’apprendimento avversariale.

- Post-processing: Manipolazione degli output del modello ML addestrato per garantirne l’equità, spesso impostando soglie di classificazione diverse per gruppi diversi.

È fondamentale riconoscere che la mitigazione del bias spesso comporta compromessi (trade-offs). In particolare, c’è una tensione tra equità e accuratezza del modello. Escludere attributi sensibili o proxy (come i codici postali) per prevenire la discriminazione può ridurre l’accuratezza predittiva del modello. Un altro compromesso esiste tra privacy ed equità: per raccogliere più dati rilevanti e migliorare l’accuratezza e l’equità, potrebbe essere necessario raccogliere informazioni su caratteristiche protette, il che è consentito dall’AI Act solo in condizioni specifiche e con rigorose salvaguardie. Il “Teorema dell’Impossibilità” di Kleinberg et al. (2016) suggerisce inoltre che non è possibile soddisfare simultaneamente più di una tra le metriche di Parità Demografica, Parità Predittiva e Probabilità Equilibrate per un classificatore ben calibrato e un attributo sensibile.

AI Responsabile: raccomandazioni di Europol

Europol sottolinea che le soluzioni matematiche non sono sufficienti per affrontare tutte le fonti di bias; è essenziale una comprensione dell’AI come sistema socio-tecnico. Le decisioni umane sono cruciali in ogni fase del ciclo di vita dell’AI, dalla progettazione all’interpretazione degli output.

Le raccomandazioni chiave di Europol per le forze dell’ordine per prevenire e mitigare il bias includono:

- Documentazione e Trasparenza: Mantenere una documentazione dettagliata di tutte le fasi del ciclo di vita dell’AI, comprese le decisioni basate sugli output, per garantire tracciabilità e responsabilità.

- Quadro di Valutazione Olistico: Sviluppare un quadro socio-tecnico che valuti non solo l’accuratezza tecnica ma anche i contesti storici, sociali e demografici, coinvolgendo un gruppo eterogeneo di stakeholder (ingegneri, scienziati dei dati, avvocati, sociologi).

- Formazione e Consapevolezza Regolare: Formazione continua per tutto il personale coinvolto con gli strumenti AI, con enfasi sulla valutazione umana degli output e sulla potenziale influenza del bias di conferma.

- Test Rigorosi Prima dell’Implementazione: Valutazioni di performance, impatto e bias sui set di dati disponibili prima del deployment. È essenziale testare per i bias i set di dati di fine-tuning se si utilizzano modelli pre-addestrati.

- Analisi Caso per Caso e Formazione Tecnica Specificata: Comprendere che la definizione di equità dipende dal contesto, e le metriche di equità sono difficili da generalizzare. È fondamentale una formazione specifica sulle diverse tipologie di bias e le loro relazioni con le metriche di equità e i metodi di mitigazione.

- Valutazione e Mitigazione Continua del Bias: Implementare test e rivalutazioni regolari dei modelli AI lungo tutto il loro ciclo di vita, analizzando i processi decisionali e il background di coloro che influenzano lo sviluppo dell’AI.

- Umano nel Ciclo (Human-in-the-loop) e Valutazione Umana: La valutazione umana dovrebbe essere parte integrante della valutazione del sistema AI, utilizzando il giudizio umano per aspetti qualitativi difficili da catturare con metriche predefinite.

- Standardizzazione delle Procedure: Adottare framework comuni per i test di bias e le strategie di mitigazione per garantire coerenza e affidabilità.

In conclusione, l’integrazione responsabile dell’AI nelle forze dell’ordine richiede un approccio multifattoriale che integri fattori tecnici, umani e contestuali. Promuovendo la diversità nei team di sviluppo, documentando i bias, eseguendo valutazioni d’impatto approfondite e selezionando metriche di equità appropriate, si possono sviluppare sistemi AI che siano più equi, trasparenti e meglio attrezzati per supportare pratiche di polizia giuste e imparziali, salvaguardando i diritti individuali e promuovendo la fiducia pubblica.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.