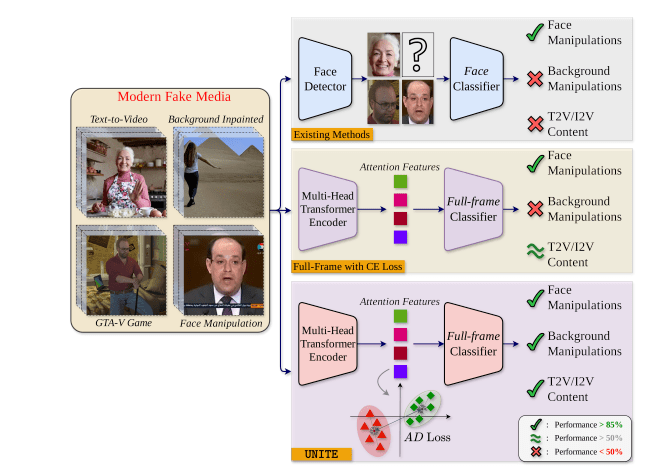

Nel 2025 la lotta contro la disinformazione visiva raggiunge un nuovo punto di svolta con UNITE, un modello avanzato di deepfake detection sviluppato da ricercatori di Google e dell’Università della California a Riverside. A differenza dei detector convenzionali focalizzati esclusivamente sui volti, UNITE introduce un approccio universale capace di identificare manipolazioni a livello di frame completo, inclusi sfondi alterati e contenuti interamente generati dall’intelligenza artificiale.

Il modello nasce per rispondere all’emergente generazione video da testo (T2V) e da immagini (I2V), dove le tecnologie come CogVideoX e Lumiere producono contenuti indistinguibili dal reale. Il team, guidato da Rohit Kundu e Amit K. Roy-Chowdhury, disegna un sistema che integra un transformer su base SigLIP-So400M, ottimizzato per estrarre feature domain-agnostic, aggirando così i limiti dei detector specializzati su volti umani. I risultati ottenuti definiscono nuovi standard per la rilevazione di video sintetici, con implicazioni dirette per elezioni, media, giustizia e cybersecurity globale.

Architettura universale e attenzione distribuita

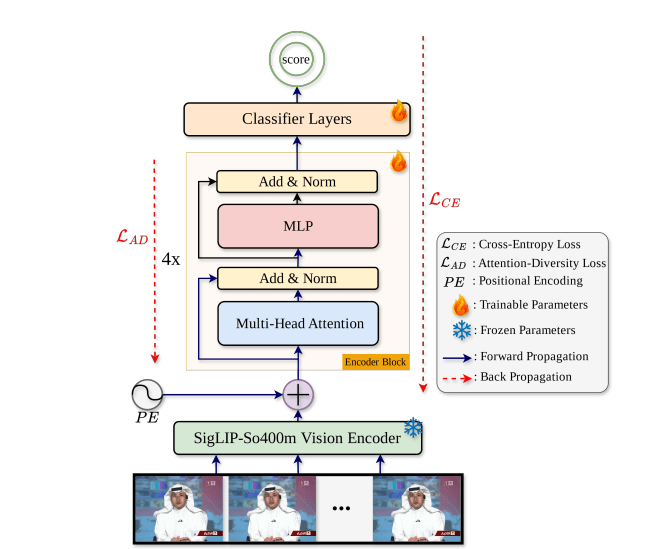

Il cuore di UNITE è una rete transformer multi-head self-attention, progettata per analizzare sequenze video fino a 64 frame consecutivi, mantenendo inalterata l’informazione spaziale e temporale. Ogni frame viene ridimensionato a 384x384x3 e processato dal foundation model SigLIP, che lo converte in un embedding di dimensione 729×1152. Questi vengono concatenati per formare una rappresentazione completa del video, poi elaborata da quattro encoder block del transformer, ognuno dotato di 12 attention head.

Una caratteristica distintiva del sistema è l’attention-diversity loss, un meccanismo che promuove la distribuzione dell’attenzione su tutto il frame, penalizzando la concentrazione eccessiva su singole aree come i volti. In questo modo, UNITE è in grado di individuare alterazioni minime e distribuite, come modifiche impercettibili agli sfondi o la generazione sintetica di interi ambienti. L’output finale viene ridotto tramite average pooling e classificato attraverso un layer lineare. L’architettura, completamente face-agnostic, supporta l’analisi di video privi di soggetti umani, come animazioni AI o scene alterate nei dettagli visivi più periferici. Questo la rende scalabile, versatile e adattabile a diversi domini di contenuto.

Addestramento multi-dominio e feature extraction robusta

UNITE si distingue anche per l’approccio al training. I ricercatori impiegano dataset eterogenei per massimizzare la generalizzabilità: dalle collezioni classiche come FaceForensics++ e Celeb-DF per deepfake di volti, a DF-BGM per manipolazioni di sfondo, fino a video completamente generati da modelli T2V e I2V.

Per bilanciare il learning e prevenire overfitting, il team include anche dati task-irrelevant provenienti da Kinetics-400, una scelta strategica per insegnare al modello a distinguere tra manipolazione e variazione semantica. In fase di training, la attention-diversity loss si integra alla cross-entropy, agendo sulla varianza spaziale dell’attenzione per garantire copertura ampia e diversificata. L’uso del foundation model SigLIP consente di partire da feature pre-addestrate su domini visivi ampi, riducendo il bisogno di etichettare enormi volumi di dati sintetici. L’intero training avviene su GPU ad alte prestazioni, con ottimizzazione tramite AdamW, scheduler dinamico del learning rate, e random frame sampling per evitare correlazioni sequenziali.

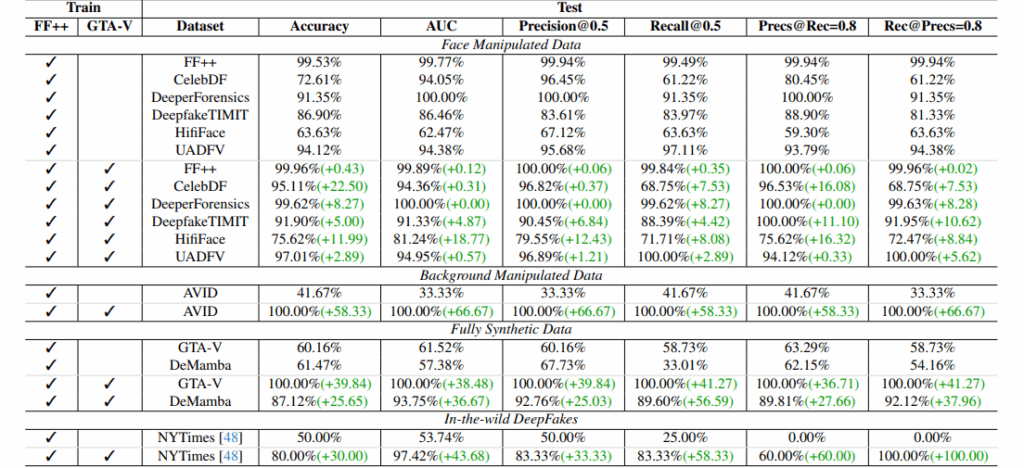

Performance superiori e robustezza cross-dataset

I risultati sperimentali di UNITE segnano un salto prestazionale rispetto ai modelli esistenti. Sul benchmark FF++ c40, il modello raggiunge un AUC del 98,7%, superando il precedente 97,2% dei migliori sistemi. Su Celeb-DF, l’AUC tocca il 99,1%, mentre su DF-BGM registra un’accuracy del 96,5%, evidenziando la capacità di rilevare anche alterazioni di sfondo. Ancora più rilevante è la performance sui video completamente sintetici da CogVideoX e Lumiere, dove UNITE mantiene un detection rate del 95,8%, laddove i modelli centrati sui volti scendono sotto il 70%. Gli ablation studies confermano che rimuovere la attention-diversity loss porta a un calo di 5 punti percentuali nelle metriche principali. L’aggiunta di dati non pertinenti al task incrementa la generalizzabilità di oltre l’8%. La robustezza si estende anche a compressione video, rumore e post-produzione: UNITE mantiene elevate performance anche su contenuti degradati, dimostrando una resilienza essenziale per il mondo reale. Le mappe di attenzione generate evidenziano una distribuzione coerente, con focus dinamico anche su contorni, movimento e texture.

Implicazioni etiche, sociali e limiti tecnici

L’avvento di UNITE arriva in un momento critico, in cui la generazione di video sintetici è accessibile al grande pubblico e può essere impiegata per influenzare elezioni, distorcere prove legali o manipolare media digitali. Il modello, pubblicato su arXiv, rappresenta una risposta accademico-industriale al bisogno urgente di strumenti scalabili per la verifica dei contenuti visivi. Tuttavia, permangono alcune limitazioni tecniche. Il modello è fortemente dipendente dal foundation model SigLIP, e richiede risorse computazionali importanti per l’inference, ostacolando in parte l’adozione in contesti real-time o mobile. Inoltre, la crescente sofisticazione dei modelli generativi rende necessario un aggiornamento continuo del training dataset, soprattutto per video T2V di nuova generazione. Le questioni etiche non mancano: la capacità di rilevare video sintetici senza volti o soggetti identificabili solleva interrogativi su privacy, sorveglianza e libertà d’espressione. I ricercatori suggeriscono la creazione di framework trasparenti e normativi per l’uso responsabile di tali tecnologie, con attenzione anche ai bias nei dataset, ancora troppo concentrati su scenari occidentali.

Applicazioni concrete e prospettive evolutive

UNITE è già in fase di integrazione in piattaforme digitali, con potenziali utilizzi in moderazione automatica su YouTube, strumenti per il giornalismo investigativo, sistemi di verifica nei tribunali, e monitoraggio di disinformazione in campagne elettorali. I suoi casi d’uso si estendono anche al settore educativo, come supporto nell’insegnamento della verifica digitale e della media literacy. Per il futuro, i ricercatori pianificano l’estensione al rilevamento multimodale, combinando video con audio analysis, controllo della sincronizzazione labiale e valutazione di coerenza narrativa. La roadmap include anche ottimizzazioni per deployment real-time, scalabilità cloud-native, e rilascio open-source per la comunità di ricerca e sviluppo. Sono in corso studi per rafforzare la resilienza ad attacchi adversariali, sviluppare versioni leggere del modello per ambienti embedded, e sperimentare integrazioni con blockchain per tracciabilità dei media. L’architettura di UNITE rappresenta un’evoluzione chiave nel panorama della cyber-detection visiva. Il suo design full-frame, il meccanismo di attention diversity e l’impiego di feature domain-agnostic tramite SigLIP lo rendono generalizzabile e adattabile a scenari futuri ancora più complessi. Con una base solida di validazione sperimentale, UNITE getta le fondamenta per un nuovo standard nella difesa contro contenuti manipolati generati da intelligenza artificiale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.