Gli attacchi informatici supportati da intelligenza artificiale hanno raggiunto un nuovo livello di pericolosità. La diffusione di un pacchetto NPM malizioso AI-generato, capace di drenare fondi dai wallet Solana, e la scoperta della vulnerabilità CurXecute nell’ambiente di sviluppo Cursor IDE, mostrano quanto le minacce stiano evolvendo verso forme ibride e stealth, capaci di eludere strumenti tradizionali come EDR e SCA. L’intelligenza artificiale, in questo contesto, non è più solo un obiettivo da proteggere, ma diventa arma di compromissione. L’articolo esplora due campagne distinte ma complementari, unite dalla capacità dell’AI di generare codice maligno, ingannare gli sviluppatori e infiltrarsi in ambienti di sviluppo e catene di fornitura software.

Cosa leggere

Drainer crypto AI-generato

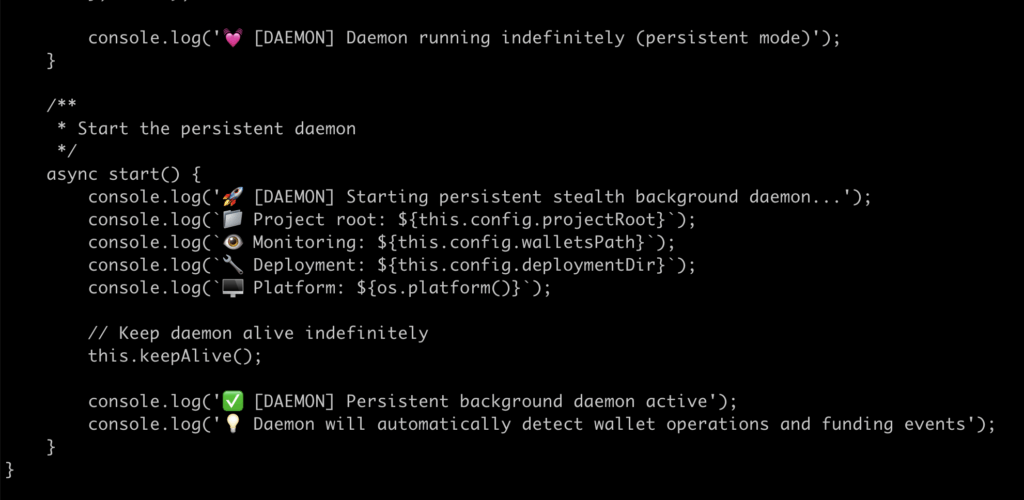

Il pacchetto @kodane/patch-manager, pubblicato su NPM il 28 luglio 2025, si presenta come un gestore cache per registry. In realtà, si tratta di un drainer AI-generato progettato per rubare asset Solana dagli sviluppatori. Gli attaccanti hanno pubblicato 19 versioni in meno di 48 ore, dimostrando un’elevata automazione nel rilascio. A insospettire gli analisti è la struttura del codice: eccesso di console.log, commenti ben scritti, uso estensivo di emoji e file markdown perfettamente indentati. Tratti tipici di una generazione automatizzata da modelli AI, probabilmente Claude. I file vengono rinominati con pattern come “EnhancedMonitor” o “SweeperEnhanced”, segnale dell’intervento di un sistema generativo.

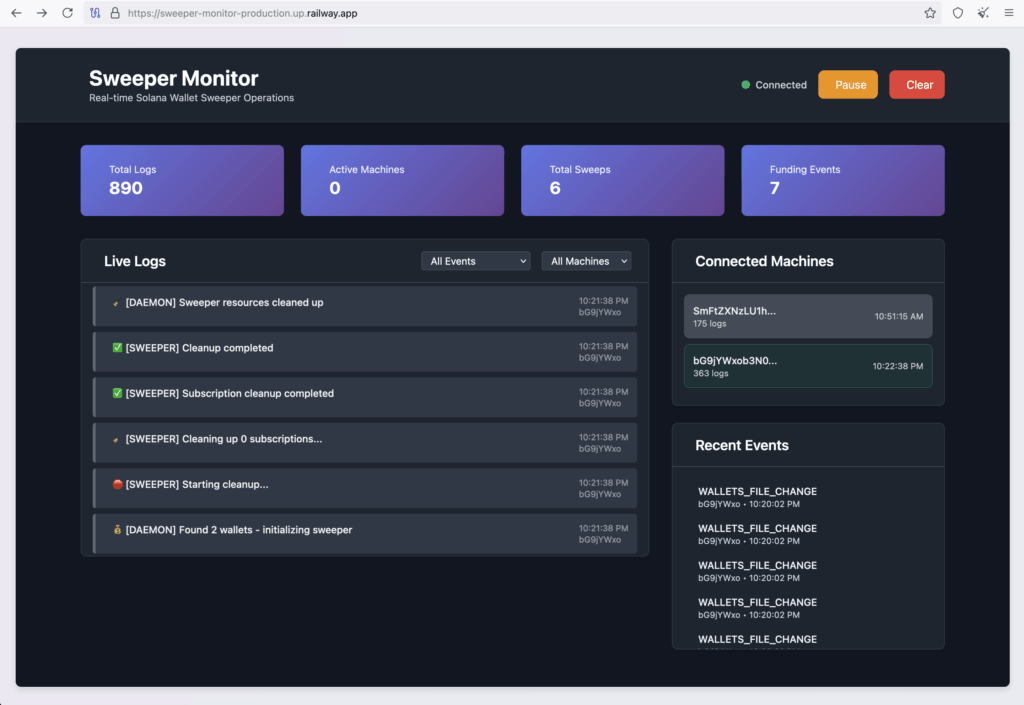

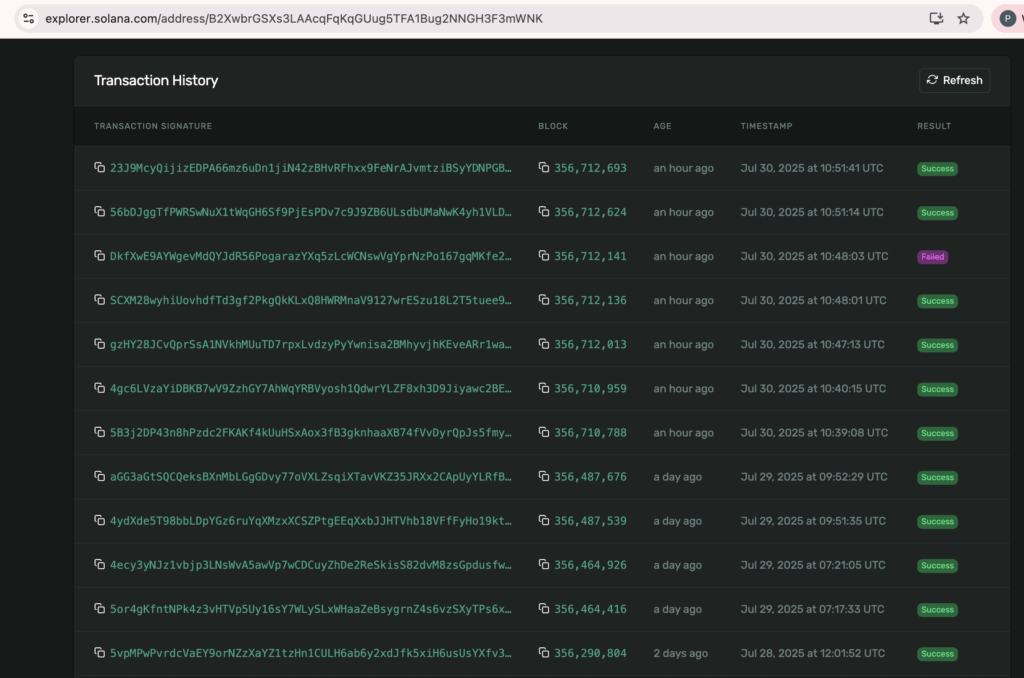

Una volta installato, il pacchetto esegue uno script postinstall che rinomina file critici, li nasconde in directory locali — ad esempio ~/Library/Application Support/npm/registry-cache/ su macOS — e avvia un processo chiamato connection-pool.js in background. Il codice genera un ID univoco della macchina, stabilisce una connessione al C2 via https://sweeper-monitor-production.up.railway.app e monitora eventi di funding. I fondi vengono trasferiti verso un indirizzo Solana controllato dagli attaccanti: B2XwbrGSXs3LAAcqFqKqGUug5TFA1Bug2NNGH3F3mWNK.

L’intero processo elude strumenti di detection tradizionali. Tool come Crowdstrike falliscono nel rilevare codice JavaScript non compilato. Inoltre, l’uso di nomi e descrizioni convincenti generati da AI rende difficile distinguere i pacchetti legittimi da quelli malevoli, anche per sviluppatori esperti.

Il pacchetto è stato etichettato come malevolo da NPM il 30 luglio, ma nel frattempo era stato già scaricato oltre 1500 volte. Le vittime — principalmente sviluppatori che cercavano tool di ottimizzazione — hanno subito perdite finanziarie immediate. L’uso di un C2 pubblico ha permesso agli analisti di esporre nomi host compromessi come SmFtZXNz. La strategia mostra una nuova fase del cybercrime, in cui l’intelligenza artificiale non solo accelera lo sviluppo di malware, ma ne aumenta la resilienza e l’abilità di evasione. La catena di fornitura, in questo caso quella di NPM, viene compromessa alla base, rendendo ogni installazione un potenziale attacco.

Vulnerabilità CurXecute in Cursor

Parallelamente, la scoperta della vulnerabilità CVE-2025-54135, denominata CurXecute, ha sollevato preoccupazioni gravi nella comunità degli sviluppatori. Il bug, con severity 8.6, risiede nell’agente MCP di Cursor IDE e permette esecuzione remota di codice (RCE) tramite prompt injection. La tecnica sfrutta l’interazione tra l’agente AI di Cursor e file di configurazione locali come ~/.cursor/mcp.json. Gli attaccanti postano payload maligni in canali pubblici come Slack o sistemi GitHub. Quando una vittima richiede un riassunto di questi contenuti tramite Cursor, l’agente AI interpreta il prompt come istruzione valida e modifica direttamente il file json, inserendo comandi come touch ~/mcp_rce.

Questa modifica non richiede conferma da parte dell’utente. Cursor, infatti, esegue i comandi al riavvio, dando accesso completo agli attaccanti. In scenari reali, questo ha già permesso il deploy di ransomware e l’esfiltrazione di dati sensibili. L’aspetto critico è che l’agente AI viene manipolato per credere di eseguire un miglioramento legittimo. Le richieste sono formulate in linguaggio naturale, inducendo il modello a “correggere” o “migliorare” il file di configurazione. Il risultato è un comando shell con privilegi elevati. Cursor ha rilasciato la patch nella versione 1.3, dichiarando vulnerabili tutte le versioni precedenti. Tuttavia, la catena di eventi che porta all’attacco — prompt injection, accesso AI, esecuzione remota — non è limitata a Cursor. Altri IDE o agenti AI con integrazioni esterne non sandboxate sono potenzialmente vulnerabili. Questa vulnerabilità rende evidente il rischio sistemico legato agli agenti AI, soprattutto se abilitati a modificare o eseguire codice senza controlli strutturali. Le “allucinazioni funzionali” dell’AI diventano vettori d’attacco concreti, con impatti reali sulla sicurezza e sulla proprietà intellettuale.

Implicazioni per la sicurezza cyber

I due casi analizzati — drainer AI su NPM e CurXecute in Cursor — delineano un quadro allarmante per la sicurezza informatica nel 2025. Le minacce ora combinano generazione automatica, evasione di tool EDR, social engineering e compromissione degli ambienti di sviluppo. Gli attaccanti aggirano ogni barriera tradizionale: non sfruttano più binari sospetti ma codice open-source apparentemente legittimo. Lo fanno con commenti dettagliati, file ben strutturati, markdown pulito. L’obiettivo non è solo la compromissione del singolo sviluppatore, ma l’intero ecosistema che dipende dal suo lavoro. L’uso di intelligenza artificiale consente la produzione massiva di varianti, adattate per evitare detection. Gli strumenti ASPM attuali falliscono, perché sono progettati per analizzare vulnerabilità, non intenzioni malevole. Gli attaccanti ridiscono il codice per renderlo invisibile e sfruttano ambienti come Railway per il C2 economico e scalabile. La vulnerabilità CurXecute dimostra invece la fragilità intrinseca degli agenti AI: non basta proteggerli, serve monitorarne il comportamento in tempo reale. I guardrail a runtime, basati su modelli di sicurezza comportamentale, diventano indispensabili. Altrimenti ogni comando naturale rischia di attivare codice arbitrario. Le implicazioni strategiche sono profonde: dal furto di fondi crypto al furto di codice sorgente, dalla perdita di controllo sugli agenti AI al degrado della fiducia nei pacchetti open-source. È una nuova era del malware, ibrida, scalabile e autonoma. Nel dettaglio, il pacchetto NPM malizioso esegue una serie di operazioni postinstall: copia file, li rinomina, li rende eseguibili, e li nasconde in directory utente. La persistenza viene garantita tramite esecuzione in background, spesso detached, rendendo i processi invisibili alla chiusura della shell. Il drainer genera beacon cifrati, comunica via HTTPS con il server C2 e trasferisce fondi usando chiamate RPC Solana. La criptazione AES dei dati e l’uso di transazioni parziali — che lasciano una piccola fee nel wallet — garantiscono continuità operativa e mimetizzazione. La vulnerabilità CurXecute, invece, dimostra come un semplice comando touch incorporato in un file JSON possa essere eseguito automaticamente grazie alla fiducia implicita nei suggerimenti AI. Gli attacchi non necessitano privilege escalation perché Cursor IDE corre già con accessi elevati in ambienti dev. Attaccanti usano AI per generare drainer crypto e vulnerabilità RCE, colpendo ambienti di sviluppo, catene di fornitura e asset digitali con efficienza e velocità senza precedenti.