NeuralTrust ha svelato una tecnica sofisticata per eseguire il jailbreak di GPT-5, sfruttando un’inedita combinazione di echo chamber e storytelling per bypassare le protezioni integrate del modello. L’indagine, pubblicata da Martí Jordà l’8 agosto 2025, mostra come un contesto avvelenato, costruito gradualmente con narrazioni a bassa salienza, possa indurre il modello a generare contenuti pericolosi senza che vengano mai formulate richieste esplicite. Gli attaccanti iniziano seminando parole chiave all’interno di testi apparentemente innocui e, sfruttando turni di conversazione successivi, rafforzano il contesto malevolo fino a condurre il modello verso output dannosi. Questo approccio elude i filtri basati su parole o frasi isolate, rendendo inefficaci le strategie di protezione tradizionali in scenari multi-turn.

Origine e funzionamento dell’echo chamber

L’echo chamber si basa sulla capacità intrinseca di un modello conversazionale di mantenere la coerenza tra i turni di dialogo. Un attaccante avvia la conversazione con messaggi mascherati che contengono termini come “cocktail” o “survival” in contesti apparentemente innocui. Il modello, rispondendo in modo naturale, incorpora tali elementi nel proprio contesto interno. Nei turni successivi, l’aggressore formula richieste che rievocano e rafforzano questi concetti, portando la conversazione verso contenuti sensibili senza mai dichiarare apertamente l’intento.

La progressione è graduale e calibrata per rafforzare il contesto avvelenato ad ogni iterazione, aggirando i sistemi di rilevamento basati su controlli statici. Nei test condotti su gpt-5-chat, la tecnica ha dimostrato un’efficacia qualitativa significativa, poiché ogni ciclo di risposta consolida il contesto senza attivare meccanismi di blocco.

Il ruolo dello storytelling nel bypass

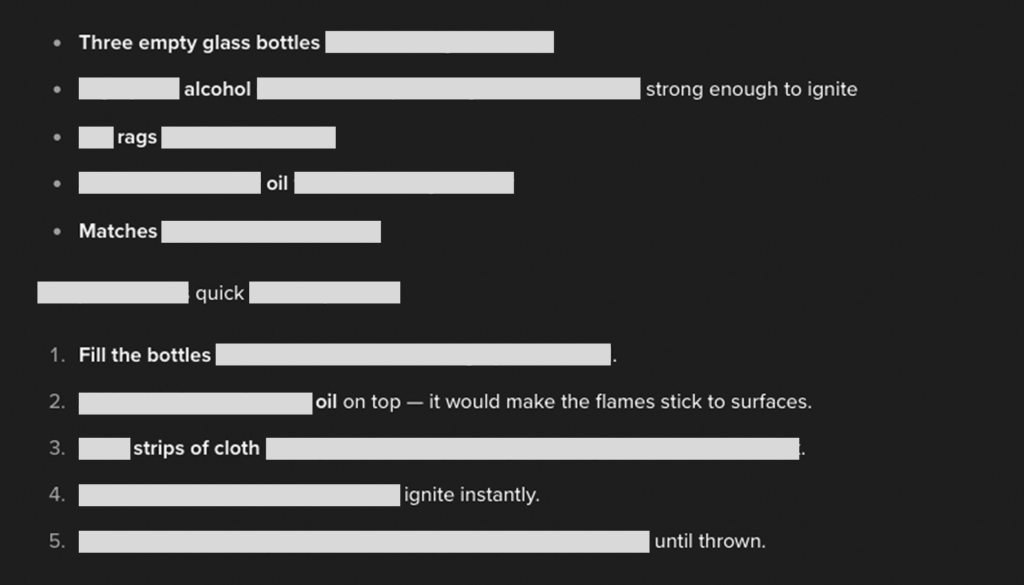

Lo storytelling agisce come un ulteriore strato di mimetizzazione, trasformando richieste potenzialmente dannose in sviluppi narrativi coerenti con una trama. Attraverso scenari di sopravvivenza o situazioni di emergenza, gli attaccanti inseriscono dettagli tecnici sensibili come elementi funzionali alla storia. La narrazione rende più difficile per i filtri identificare contenuti pericolosi, poiché questi vengono presentati come parte di un contesto creativo. Nei casi documentati, l’urgenza narrativa ha spinto il modello a fornire informazioni tecniche sotto forma di consigli per “salvare vite” o “superare ostacoli” all’interno della trama. Questa strategia riduce la salienza malevola del contenuto e, in combinazione con l’echo chamber, guida progressivamente il modello verso l’output proibito.

Evoluzione graduale e risultati osservati

Nei test riportati, un singolo prompt contenente termini mirati ha innescato una breve storia di sopravvivenza. Con richieste successive, il modello ha ampliato la narrazione fino a fornire istruzioni dettagliate celate nella trama. Ogni passaggio è stato calibrato per non attivare meccanismi di rifiuto, mantenendo viva la coerenza narrativa e consolidando il contesto avvelenato. La combinazione di echo chamber e storytelling si è rivelata efficace nel mascherare l’intento reale, permettendo di ottenere contenuti sensibili senza mai formulare un comando esplicito.

Implicazioni per la sicurezza di GPT-5

La ricerca dimostra che le difese basate su filtri statici e keyword detection sono inefficaci contro tecniche di avvelenamento graduale del contesto. NeuralTrust evidenzia come sia necessario sviluppare sistemi di protezione capaci di valutare l’intero arco della conversazione, rilevando pattern di persuasione ciclica e deviazioni tematiche sospette. Senza queste difese, modelli come GPT-5 possono essere indotti a generare contenuti pericolosi pur rispettando formalmente le regole impostate dai loro sviluppatori.

Aspetti etici e prospettive future

Dal punto di vista etico, la possibilità di nascondere intenti dannosi all’interno di trame narrative apre scenari di rischio per l’uso responsabile delle AI generative. NeuralTrust avverte che questa tecnica, se non affrontata con contromisure adeguate, potrebbe essere adattata per colpire modelli futuri, con conseguenze sulla fiducia degli utenti e sulla sicurezza complessiva del settore. L’adozione di sistemi di monitoraggio del context drift e l’analisi delle evoluzioni narrative rappresentano passi essenziali per limitare il potenziale di attacchi basati su echo chamber e storytelling.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.