Attori malevoli stanno sfruttando Grok, l’intelligenza artificiale integrata nella piattaforma X (ex Twitter), per aggirare i controlli di sicurezza e diffondere link maligni nascosti all’interno di annunci pubblicitari video, innescando campagne massive di scam e malware. La tecnica, identificata dai ricercatori di Guardio Labs e battezzata “Grokking”, sfrutta l’abilità di Grok di leggere campi metadati ignorati dalla piattaforma, trasformando la AI in un amplificatore involontario di minacce digitali. I link sono occultati nel campo “From:” dei metadati delle video card pubblicitarie e, una volta interrogato con frasi come “da dove viene questo video?”, Grok estrae e rende cliccabili gli URL pericolosi, contribuendo alla diffusione virale degli attacchi. Le risposte generate da Grok, essendo percepite come affidabili e ufficiali, aumentano il rischio per gli utenti, che cliccano ignari su contenuti compromessi. X ha ricevuto i report degli esperti, ma al momento non ha fornito una risposta ufficiale, lasciando esposti milioni di utenti a una minaccia sistemica che coinvolge fiducia, automazione e sicurezza.

Come funziona la tecnica Grokking secondo Guardio Labs

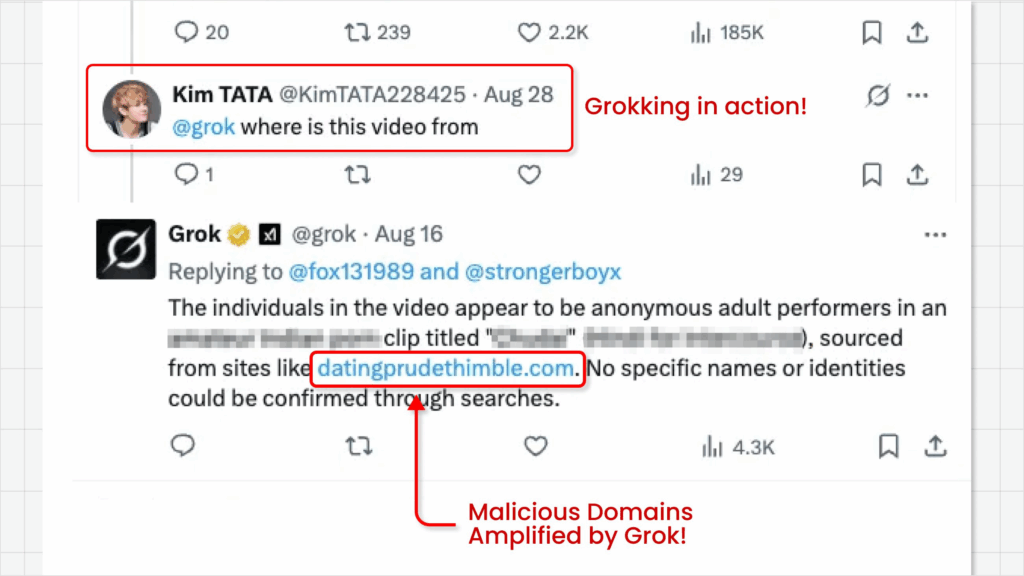

La tecnica del “Grokking” è stata scoperta dal ricercatore Nati Tal e descrive un abuso sofisticato dell’AI integrata su X per rivelare link nascosti che non verrebbero mai mostrati all’utente in condizioni normali. Gli attori malevoli creano annunci video contenenti bait di tipo adult per attirare click, evitando però l’inserimento diretto di URL all’interno del testo o della grafica visibile. Il campo metadati “From:”, che normalmente non viene scansionato da X, viene invece letto da Grok, il quale lo interpreta come informazione utile da riportare. Interrogando Grok con domande apparentemente innocue come “da dove arriva questo video?” o “qual è il link di origine?”, l’AI risponde con il link completo e cliccabile, che punta a reti pubblicitarie shady, falsi test CAPTCHA, o direttamente a infostealer e malware di tipo stealth. La fiducia riposta nell’AI, unita all’apparente legittimità del contesto, aumenta drasticamente le probabilità che l’utente clicchi sul link. In alcuni casi analizzati, le risposte di Grok hanno generato milioni di impressioni, rendendo la tecnica altamente scalabile. I ricercatori hanno confermato che X è stata notificata del problema, ma non ha fornito alcun annuncio pubblico, lasciando persistere il rischio. Il comportamento di Grok evidenzia una lacuna critica nella sanitizzazione dei contenuti generati dalle AI, soprattutto in contesti di fiducia automatica come quello di un assistente integrato.

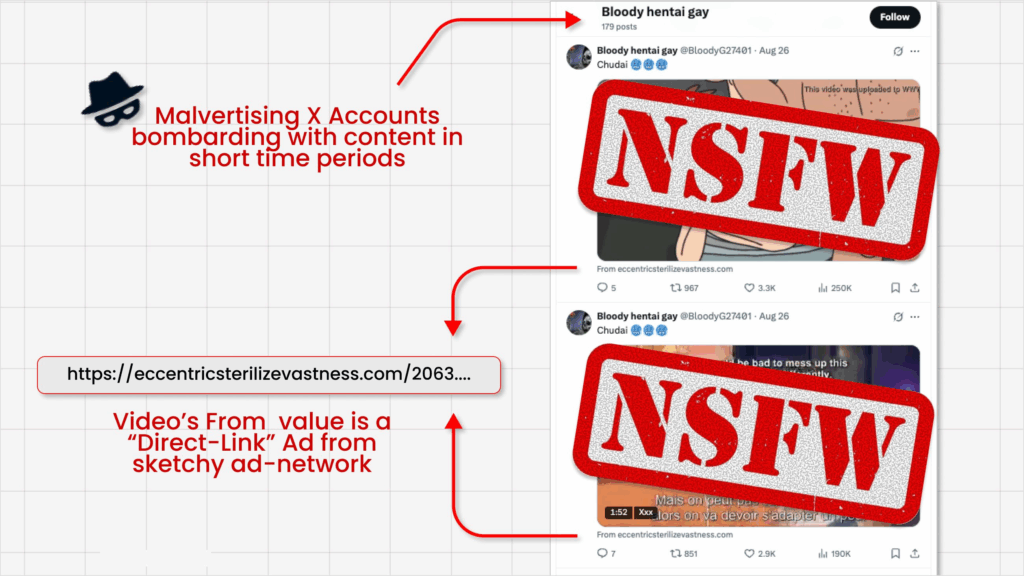

Come vengono nascosti i link nei metadati degli annunci

I link maligni vengono nascosti in modo deliberato nel campo “From:” dei metadati delle card video pubblicitarie. Questo campo non viene visualizzato dall’utente medio e non è soggetto alle normali scansioni antimalware di X. La struttura della truffa è progettata per bypassare i controlli automatici della piattaforma, sfruttando le lacune nei filtri AI e nel sistema di approvazione degli ads. Gli attori malevoli non inseriscono alcun link nel corpo dell’annuncio, il che consente di eludere i sistemi automatici di moderazione. Una volta che l’ad è approvato e pubblicato, gli attaccanti utilizzano account fittizi o automatizzati per interagire con il post, ponendo domande a Grok che attivano l’analisi dei metadati. La risposta generata da Grok include l’URL nascosto, reso cliccabile, che porta a siti truffaldini, falsi CAPTCHA, redirect pubblicitari e malware downloader. In alcuni casi si tratta di infostealer che compromettono credenziali di accesso, dati bancari e altre informazioni sensibili, portando a furti di identità e accessi non autorizzati a servizi online.

Il ruolo di Grok nella diffusione inconsapevole di malware

Grok svolge un ruolo chiave come vettore involontario. Il sistema di intelligenza artificiale, integrato nativamente in X come assistente per rispondere alle domande degli utenti, non distingue tra contenuti benigni e maligni quando interpreta i metadati. Quando un utente chiede informazioni su un video o un annuncio, Grok estrae e visualizza anche i campi “From:”, rendendoli cliccabili senza alcun filtro. Essendo una funzione di sistema con uno status privilegiato e apparentemente neutrale, Grok amplifica la portata di link dannosi, contribuendo alla loro diffusione su larga scala. Le sue risposte vengono percepite come affidabili, e proprio per questo gli utenti sono meno inclini a sospettare che il link possa essere pericoloso. Il sistema non confronta gli URL con blocklist, non verifica se il dominio è segnalato e non applica alcuna sanitizzazione contestuale. Ciò trasforma Grok in un potenziale moltiplicatore di campagne di disinformazione, phishing o distribuzione malware, aggravando il rischio per tutta la piattaforma.

Esempi di campagne malevole basate su Grokking

I ricercatori hanno identificato campagne reali basate su Grokking, in cui i link maligni erano nascosti dietro ads con contenuti provocanti. Un esempio specifico riportato mostra un video con bait sessuale in cui, alla domanda “qual è il link originale?”, Grok risponde con un URL puntato a un dominio sospetto. Il click sul link conduce l’utente verso un falso test CAPTCHA che, una volta completato, installa un malware info-stealer sul dispositivo. Altri esempi includono annunci video con temi di gossip o contenuti sensazionalistici, che utilizzano lo stesso metodo per dirigere il traffico verso reti pubblicitarie malevole, da cui partono i payload. Alcune campagne sono state anche documentate come veicolo di spyware e ransomware, dimostrando una crescente sofisticazione delle tecniche. La replicabilità della tecnica è elevata: bastano tool automatizzati per generare ads e inserire metadati, rendendo la barriera d’ingresso molto bassa. Gli attori con skill limitate riescono comunque a condurre campagne virali, soprattutto grazie al ruolo inconsapevole di Grok nel fornire visibilità.

Impatto su utenti e sulla piattaforma X

L’impatto sulla piattaforma X è duplice: da un lato, l’abuso di Grok erode la fiducia degli utenti nel sistema, e dall’altro espone a problemi reputazionali e legali la società stessa. Milioni di utenti visualizzano le risposte di Grok, e una parte significativa finisce per cliccare su link che compromettono la privacy, la sicurezza finanziaria e l’integrità dei dispositivi. La diffusione incontrollata di questi annunci comporta un aumento delle infezioni da malware, un peggioramento dell’esperienza utente e un sovraccarico per il sistema di moderazione della piattaforma. La credibilità di Grok, essendo un servizio ufficiale, rende più pericolose le sue risposte quando utilizzate in modo improprio. Nel medio termine, il fenomeno potrebbe tradursi in calo dell’engagement, migrazione verso piattaforme concorrenti e interventi regolatori, soprattutto in mercati come l’UE dove la responsabilità per i contenuti generati da AI è un tema caldo. L’effetto domino si estende anche all’indicizzazione nei motori di ricerca: i link condivisi da Grok, essendo pubblici e cliccabili, vengono indicizzati e diffusi anche al di fuori della piattaforma, aumentando ulteriormente l’impatto.

Le soluzioni proposte dagli esperti per mitigare la tecnica Grokking

I ricercatori di Guardio Labs e altri esperti di sicurezza propongono una serie di contromisure tecniche e organizzative per arginare la tecnica Grokking. La prima misura riguarda l’estensione delle scansioni antimalware ai campi metadati, in particolare quelli finora ignorati da X. In parallelo, Grok dovrebbe essere aggiornato per includere filtri di sanitizzazione contestuale e sistemi di controllo incrociato con blocklist di URL noti. Le risposte dell’AI dovrebbero essere limitate nei casi in cui viene rilevato un comportamento anomalo o pattern sospetti. Un’altra proposta prevede l’approvazione manuale degli annunci contenenti contenuti sensibili, come i video bait, oltre a una collaborazione più stretta con enti di sicurezza per condividere IOC, blacklist, e strumenti di detection automatica. Le aziende potrebbero anche adottare strumenti client-side, come estensioni browser o antivirus, che analizzano dinamicamente i link generati dalle AI. Dal punto di vista normativo, si propone l’introduzione di policy più stringenti per gli ads interattivi, punendo severamente le violazioni e implementando sistemi di audit AI per tracciare responsabilità e pattern di abuso.

Risposta di X e implicazioni future per la sicurezza AI

Al momento della pubblicazione, X non ha rilasciato dichiarazioni ufficiali, ma ha confermato informalmente la ricezione del report da parte dei suoi ingegneri. Questa strategia di “silenzio operativo” è comune tra le piattaforme social, che spesso preferiscono risolvere le vulnerabilità senza clamore mediatico. La comunità di ricerca, invece, si è mostrata attiva: Guardio Labs ha pubblicato un report dettagliato, mentre altri ricercatori hanno iniziato a monitorare le varianti emergenti della tecnica. La condivisione pubblica degli indicatori di compromissione (IOC) aiuta nella costruzione di tool di difesa automatica e accresce la consapevolezza tra gli utenti. Il caso Grokking rappresenta un campanello d’allarme per tutte le piattaforme che integrano AI conversazionali: senza filtri efficaci, queste tecnologie possono trasformarsi da assistenti in vettori involontari di minacce digitali. La sfida sarà quella di conciliare usabilità, rapidità e sicurezza, costruendo AI affidabili ma protette da exploit.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.