La sicurezza AI segna la rotta di settembre 2025 con tre mosse che ridisegnano il perimetro: Anthropic integra la security review automatica in Claude Code, Google porta la provenance C2PA direttamente nella fotocamera di Pixel 10 e Cursor espone gli sviluppatori a autorun malevolo disattivando Workspace Trust di default. Il quadro è chiarissimo: l’intelligenza artificiale diventa alleato e vettore allo stesso tempo. Anthropic spinge il DevSecOps verso un “shift-left” misurabile con /security-review e un’action GitHub che intercetta SQLi, XSS, SSRF e RCE prima del merge; Google consolida la fiducia nei contenuti con C2PA a Assurance Level 2, ancorando le credenziali a Titan M2; Cursor, al contrario, consente a .vscode/tasks.json di eseguire codice alla semplice apertura di un repository pubblico, aprendo a furto credenziali e supply chain compromise. In mezzo, team sicurezza e developer guadagnano produttività, ma devono ritarare policy, sandbox e telemetria per non trasformare l’automazione in un punto cieco.

Anthropic e la security review autonoma: dal prompt alla policy

Anthropic porta la revisione della sicurezza nel punto giusto della pipeline, riducendo errori umani e tempi morti. La /security-review fa emergere pattern vulnerabili e propone patch contestuali in modo ripetibile, misurabile e integrabile.

Come funziona /security-review in pratica

La /security-review su Claude Code analizza intere codebase, non solo i diff, e mette in evidenza query non parametrizzate a rischio SQL injection, input non sanitizzati che abilitano XSS, superfici di session hijacking e IDOR, gestione fragile di segreti e dipendenze affette da CVE. Il valore non è solo nell’individuazione: il modello genera spiegazioni con riferimenti OWASP, propone fix coerenti con lo stile del repository e consente iterazione immediata nel contesto del pull request. In scenari reali, la combinazione tra prompt specializzati e regole custom in YAML riduce falsi positivi, allinea la segnalazione alle policy interne e mantiene la velocità di sviluppo.

Impatto su CI/CD, governance e tracciabilità

L’action GitHub di Anthropic commenta inline, etichetta i rischi per severità e categoria e impedisce l’unione quando i guardrail lo richiedono. La tracciabilità in PR riduce l’attrito fra sviluppo e security engineering, mentre la copertura su RCE, SSRF, leak di credenziali, hardcoded secrets e misconfiguration IaC sposta l’ago verso una prevenzione sistemica. Sul piano operativo, i team adottano regole incrementali per repository e monorepo, definiscono baseline di accettazione del rischio e sfruttano l’automazione per uniformare gli standard su decine di progetti contemporaneamente. Il risultato è una riduzione misurabile di fix post-merge e rollback in produzione, con tempi di remediation compressi e coerenza fra audit e delivery.

C2PA su Pixel 10: provenance verificabile contro la manipolazione AI

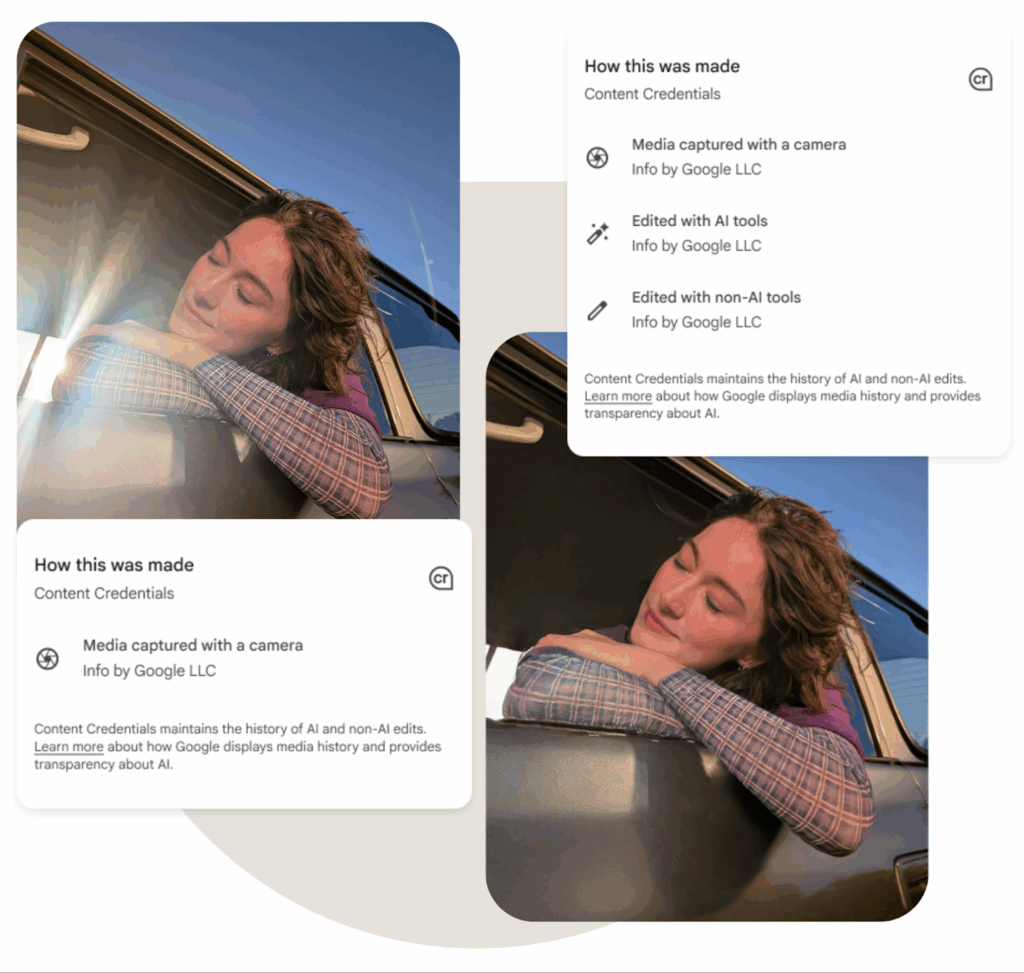

L’integrazione C2PA nella fotocamera Pixel 10 sposta a livello di dispositivo la catena di fiducia dei contenuti, codificando chi, cosa, quando e come di una foto o di un video e rendendo verificabile la sua storia, anche offline.

Che cos’è C2PA e perché conta su Pixel 10

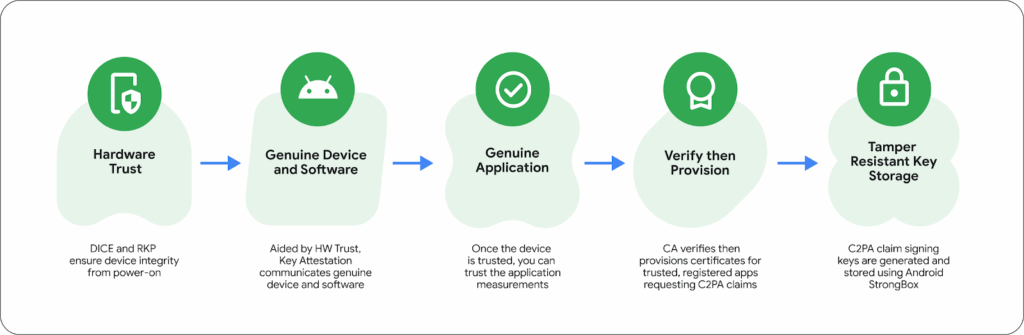

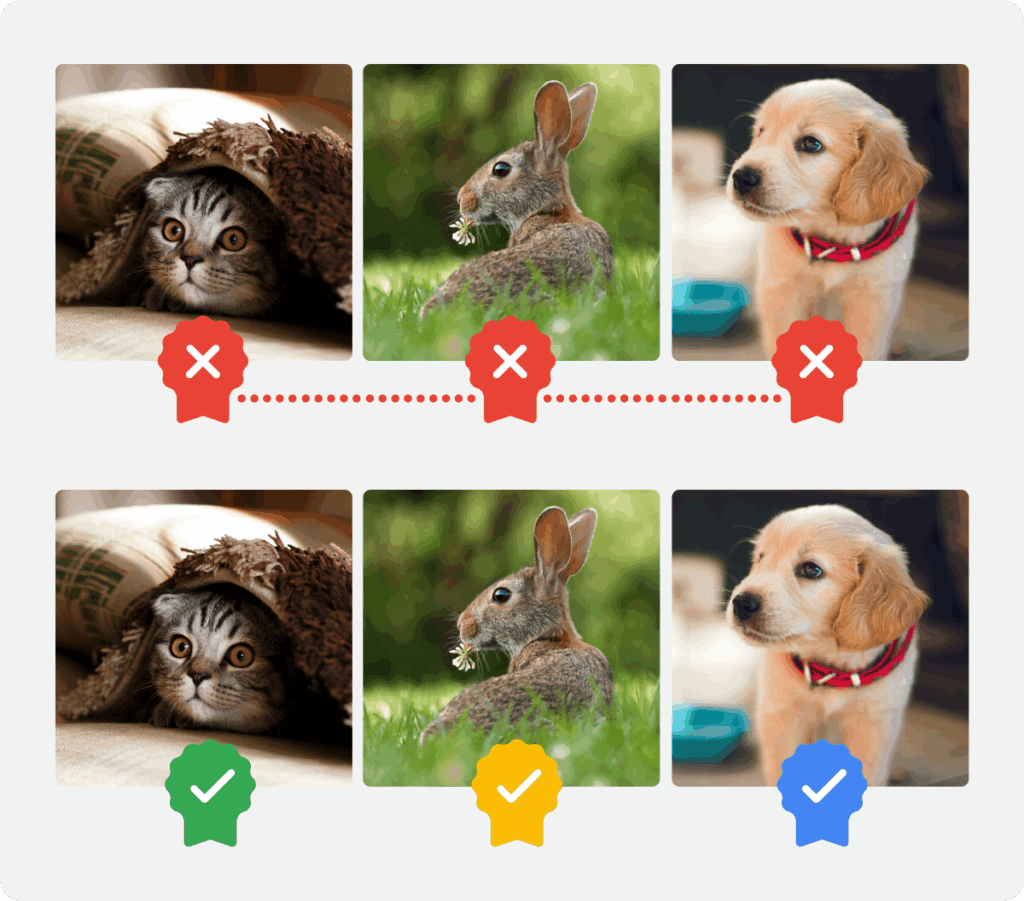

C2PA è uno standard aperto per la provenienza dei contenuti che registra metadati firmati su creazione e modifiche. Su Pixel 10, la fotocamera allega credenziali hardware-backed, con certificazione a Assurance Level 2, superando la retorica “AI vs non-AI” e adottando una classificazione “con evidenza / senza evidenza”. La verifica non dipende dal cloud: Titan M2 custodisce le chiavi, Android Key Attestation e DICE/RKP convalidano l’integrità del percorso, mentre Google Photos estende la catena di modifiche anche agli edit manuali o AI-assistiti. L’utente può consultare, esportare e validare la provenance, con SDK e tool terzi che consentono controlli in ambienti regolamentati.

Standard, ecosistema e affidabilità operativa

Portare C2PA nella camera nativa accelera l’adozione nell’ecosistema Android e crea un benchmark per OEM, editor e piattaforme. La scelta di ancorare le credenziali a hardware tamper-resistant riduce il rischio di spoofing e consolida la non ripudiabilità dell’origine.

L’approccio “evidence first” riduce l’implied truth effect, perché non decreta autenticità in assoluto, ma documenta tracce verificabili: un’immagine senza credenziali non è automaticamente falsa, ma richiede scrutini maggiori. Nelle redazioni, nei tribunali, nelle piattaforme social, questa granularità eleva lo standard probatorio e sottrae terreno alla disinformazione alimentata da deepfake.

Cursor e l’autorun malevolo: quando l’AI coding ignora i guardrail

Il caso Cursor mette in luce il lato rischioso dell’AI coding: disabilitando Workspace Trust per UX e funzionalità dell’assistente, l’editor esegue task.json alla sola apertura di una cartella, persino da repository pubblici non fidati.

Perché Workspace Trust è un confine di sicurezza

La protezione Workspace Trust blocca script e task non fidati in ambienti VS Code-like. Con Cursor, un semplice .vscode/tasks.json può invocare shell, esfiltrare username, token API, avviare download e stabilire C2 senza un clic esplicito. La superficie di attacco diventa apertura di progetto, trasformando l’esplorazione di un repo in esecuzione arbitraria. In un contesto dove gli LLM generano patch, aggiornano dipendenze e propongono script, il confine tra assist e autonomia non può cancellare i fondamentali: least privilege, consenso esplicito e isolamento.

Supply chain, credenziali e responsabilità del maintainer

Il rischio supply chain cresce perché gli editor AI aumentano la velocità con cui sviluppatori navigano sconosciuti e accettano suggerimenti. Senza sandbox e trust gating, la probabilità che un task alteri un rc file, modifichi PATH, depositi binari persistenti o ritocchi config cresce esponenzialmente. Il punto critico non è l’AI che propone codice, ma l’ambiente che lo esegue implicitamente. Il rifiuto di ripristinare Workspace Trust come default significa spostare il rischio su utenti e organizzazioni, che devono supplire con policy e contromisure locali.

Implicazioni per privacy, compliance e governance del codice

L’emersione contemporanea di Claude Code, C2PA su Pixel 10 e il caso Cursor impone una governance che unisca identità, contenuti e esecuzione.

Identità e revisione del codice

Automatizzare la security review crea traccia di decisione tecnica: chi ha approvato, con quali segnalazioni ignorate e che rischio residuo è stato accettato. Gli audit diventano riproducibili; i CISO ottengono metriche su time-to-detect, time-to-patch e copertura per categoria OWASP, con correlazioni a incidenti reali. L’AI non sostituisce la revisione umana, ma standardizza il minimo comune e libera tempo per i casi ambigui, dove serve giudizio.

Provenienza e fiducia nei media

Con C2PA, le aziende possono richiedere provenance per contenuti interni e fornitori; nel marketing, nella documentazione e nel giornalismo, il requisito di evidenza riduce dispute e abusi. Assurance Level 2 su Pixel 10 rende portatile la fiducia, perché la firma viaggia con l’asset e non dipende da un servizio terzo. Ciò si traduce in processi probatori più snelli e in compliance più prevedibile.

Esecuzione e superficie d’attacco

Il caso Cursor ribadisce che la superficie non è solo codice o dipendenze, ma l’ambiente di esecuzione. Ridurre la frizione senza mantenere i guardrail significa creare nuove dipendenze dal buon senso dell’utente. I SOC devono osservare telemetria IDE e ambienti di sviluppo, perché l’ingresso di malware dalla postazione developer salta gli strati di difesa a valle e inquina la filiera del software.

Metriche e interoperabilità: come misurare la fiducia

La maturità passa per metriche concrete. Nel codice, fall-through rate delle regole /security-review, tempo medio di mitigazione e densità di vulnerabilità per kLOC testimoniano l’efficacia dell’automazione. Nei contenuti, la percentuale di asset con C2PA, il tasso di verifica e gli esiti di convalida diventano KPI. Per l’esecuzione, tasso di aperture di repo non fidati in sandbox, incidenti evitati grazie a Workspace Trust e segnali EDR su autorun formano la base di una assurance condivisa tra security e engineering. La interoperabilità è decisiva: C2PA deve dialogare con DAM, CMS e strumenti forensi; /security-review e GitHub Action devono integrarsi con SIEM/XDR; gli IDE devono esporsi a policy centralizzate di trust.

Dal laboratorio alla produzione: adozione senza regressi

Le organizzazioni che adottano Claude Code evitano regressi definendo “golden repos” per regole e prompt; i modelli evolvono, ma la policy deve restare deterministica su ciò che blocca e ciò che avvisa. Nel media pipeline, l’inserimento di C2PA va affiancato da linee guida editoriali: quando un contenuto senza evidenza può essere pubblicato? con quali avvertenze? Nel mondo developer, l’uso di Cursor impone sandbox a privilegi minimi, container effimeri per repository non fidati e la riattivazione di Workspace Trust a livello policy aziendale, anche a costo di rinunciare a feature AI meno sicure.

Impatto su privacy e data protection

La provenance introduce metadati che vanno gestiti: minimizzazione, retention e informativa devono essere chiare, specialmente quando i contenuti entrano in workflow esterni. L’archiviazione di commenti di security e decisioni in PR costituisce documentazione utile per compliance, ma richiede governance dei permessi e cifratura a riposo. Sul fronte Cursor, i token e le secrets vanno segregati: nessun env globale in shell dell’IDE, broker di credenziali e scoped tokens per limitare l’impatto di eventuali autorun.

Economia del rischio: produttività vs superficie d’attacco

I dati di adozione mostrano produttività in aumento con AI review e fix suggeriti; ma il delta di rischio dipende da policy, tooling e formazione. Dove Workspace Trust resta attivo, i benefici superano i rischi; dove viene disattivato, l’asimmetria premia gli attaccanti. La scelta di assurance hardware per i media sposta i costi sui vendor, liberando l’utente dalla necessità di verifiche manuali per ogni asset critico. Il ROI della sicurezza AI si misura nel tempo evitato in incident response e post-mortem, non solo in righe di codice prodotte.

Scenari 2026: convergenza AI + hardware + policy

Guardando avanti, la convergenza tra LLM, root of trust hardware e policy centralizzate ridurrà la ambiguità in cui prosperano gli attacchi. I modelli impareranno a spiegare le segnalazioni in modo forense-ready; gli editor dovranno negoziare feature con guardrail non disattivabili; la provenance estenderà video e live capture, con verifica locale e audit trail standardizzato. Sul piano normativo, standard ibridi tra OWASP e C2PA emergeranno come linguaggio comune per assurance di codice e contenuti.

Architetture di fiducia per codice, contenuti ed esecuzione

La robustezza del nuovo perimetro nasce dall’allineamento di tre architetture. Sul codice, la /security-review trasformata in gate CI impone controlli deterministici prima del merge, con policy codificate, telemetria in PR e integrazione XDR per chiudere il ciclo dal segnale all’incidente. Sui contenuti, la C2PA ancorata a Titan M2 e Assurance Level 2 crea evidenza verificabile dal sensore al DAM, riducendo la dipendenza da heuristiche anti-deepfake. Sull’esecuzione, l’IDE deve reintrodurre Workspace Trust come default non negoziabile, spostando l’eccezione nel consenso esplicito, in sandbox isolate e con token a scopo limitato. Questa triade riduce gli spazi grigi che gli attaccanti sfruttano e permette a AI e automazione di esprimere il vantaggio senza amplificare la superficie d’attacco. In assenza di uno di questi tre pilastri, la velocità dell’AI diventa acceleratore del rischio; con tutti e tre allineati, diventa moltiplicatore di resilienza.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.