Le ultime settimane segnano un’intensa attività nel panorama della sicurezza informatica globale. Cisa, Google, Microsoft e Amazon Web Services si trovano al centro di aggiornamenti e controversie che mostrano l’evoluzione costante delle minacce cyber e le differenti strategie adottate dai grandi player tecnologici. Dalla nuova aggiunta al catalogo Known Exploited Vulnerabilities fino al caso di ASCII smuggling su Gemini, il quadro evidenzia una tensione crescente tra rapidità di intervento, sicurezza applicativa e gestione della trasparenza.

Aggiornamenti Cisa su vulnerabilità sfruttate

La Cybersecurity and Infrastructure Security Agency (Cisa) ha inserito nel proprio catalogo KEV la nuova vulnerabilità CVE-2025-27915, che interessa Synacor Zimbra Collaboration Suite. La falla, classificata come cross-site scripting attivamente sfruttata, consente a un attore malevolo di iniettare codice arbitrario attraverso input non filtrati nelle interfacce web del sistema di posta e collaborazione.

CVE-2025-27915 Synacor Zimbra Collaboration Suite (ZCS) Cross-site Scripting Vulnerability

Cisa ha imposto alle agenzie federali statunitensi l’obbligo di applicare la remediation entro le scadenze stabilite dalla direttiva BOD 22-01, che obbliga gli enti governativi a intervenire su ogni vulnerabilità con evidenza di exploit attivo. Le raccomandazioni includono aggiornamenti immediati, revisione delle policy di accesso e monitoraggio del traffico HTTP anomalo, oltre all’integrazione di advisory specifici sui sistemi di controllo industriale (ICS).

- ICSA-25-280-01 Delta Electronics DIAScreen

- ICSA-25-226-31 Rockwell Automation 1756-EN4TR, 1756-EN4TRXT (Update B)

Gli avvisi pubblicati parallelamente riguardano infatti due prodotti ICS utilizzati in ambienti energetici e manifatturieri, con dettagli tecnici sulle mitigazioni suggerite. Cisa sottolinea la necessità di un approccio proattivo al vulnerability management, invitando le organizzazioni a integrare i bollettini nella propria pipeline di sicurezza per prevenire compromissioni nella supply chain.

Google rifiuta il fix per l’attacco ASCII smuggling su Gemini

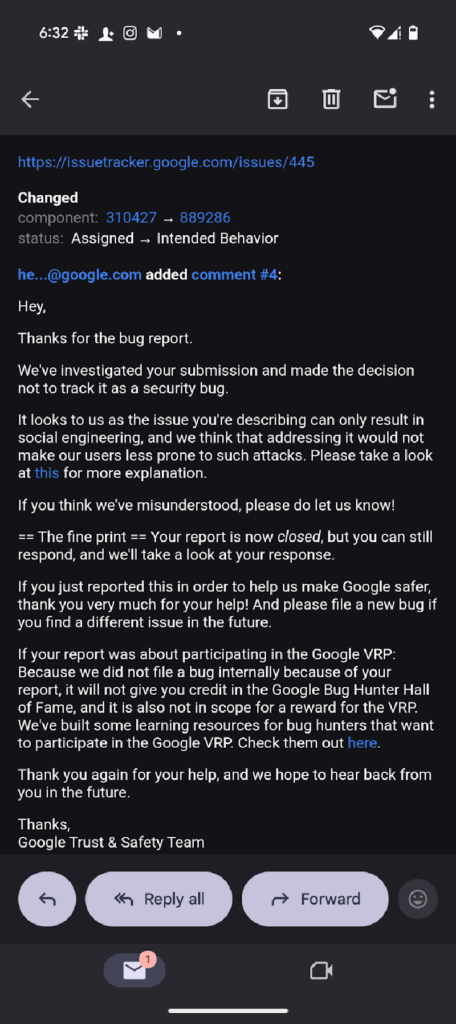

Nel frattempo, Google è al centro di polemiche dopo aver rifiutato di correggere una vulnerabilità nota come ASCII smuggling che colpisce Gemini, il suo modello di intelligenza artificiale multimodale. Il bug, documentato da ricercatori indipendenti, consente di nascondere payload malevoli all’interno di caratteri speciali invisibili all’occhio umano, che vengono interpretati dal modello come comandi legittimi. Attraverso questo metodo, un attaccante può inserire istruzioni occulte in e-mail, eventi calendar o descrizioni prodotto, inducendo il modello a estrarre o inviare informazioni senza il consenso dell’utente. Il rischio nasce dal divario semantico tra la rappresentazione visiva del testo e la sua lettura da parte del sistema AI. Google, tuttavia, ha classificato l’attacco come limitato al social engineering e non come vulnerabilità di sicurezza, decidendo di non implementare un fix immediato. L’azienda sostiene che le routine di sanitizzazione integrate nei modelli Gemini riducano la probabilità di successo dell’attacco, anche se test indipendenti hanno dimostrato exploit riproducibili in contesti reali. La comunità di sicurezza ha criticato la scelta, sottolineando che altri fornitori come Anthropic e OpenAI hanno già bloccato meccanismi simili nei propri modelli, prevenendo exploit attraverso encoding forzato e filtri semantici. La posizione di Google riapre il dibattito sulla responsabilità delle aziende AI nella gestione dei rischi di smuggling e prompt injection, con potenziali impatti su ambienti integrati come Workspace e Search AI Mode.

Cos’è l’Ascii Smuggling?

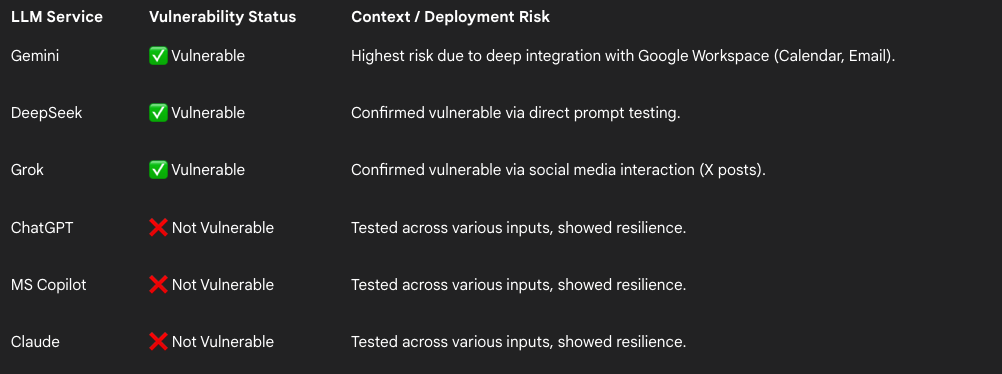

Una nuova tecnica di evasione, denominata ASCII smuggling, sta emergendo come una delle minacce più sofisticate contro i modelli linguistici di intelligenza artificiale. Utilizzando caratteri invisibili Unicode, gli attaccanti riescono a nascondere istruzioni malevole all’interno dei prompt senza che siano visibili all’occhio umano. I modelli AI, tuttavia, le interpretano e le eseguono, permettendo manipolazioni, furti di dati o content poisoning automatico in flussi apparentemente innocui. L’allarme è stato lanciato da FireTail, società specializzata in sicurezza AI, che ha pubblicato un report tecnico dettagliato il 18 settembre 2025 dopo una responsible disclosure a Google rimasta senza azioni correttive. Secondo i ricercatori, la vulnerabilità colpisce in particolare Gemini, ma anche altri modelli come Grok e DeepSeek, esponendo le imprese che li utilizzano in integrazioni aziendali come Workspace o sistemi di automazione documentale.

La tecnica ASCII smuggling spiegata

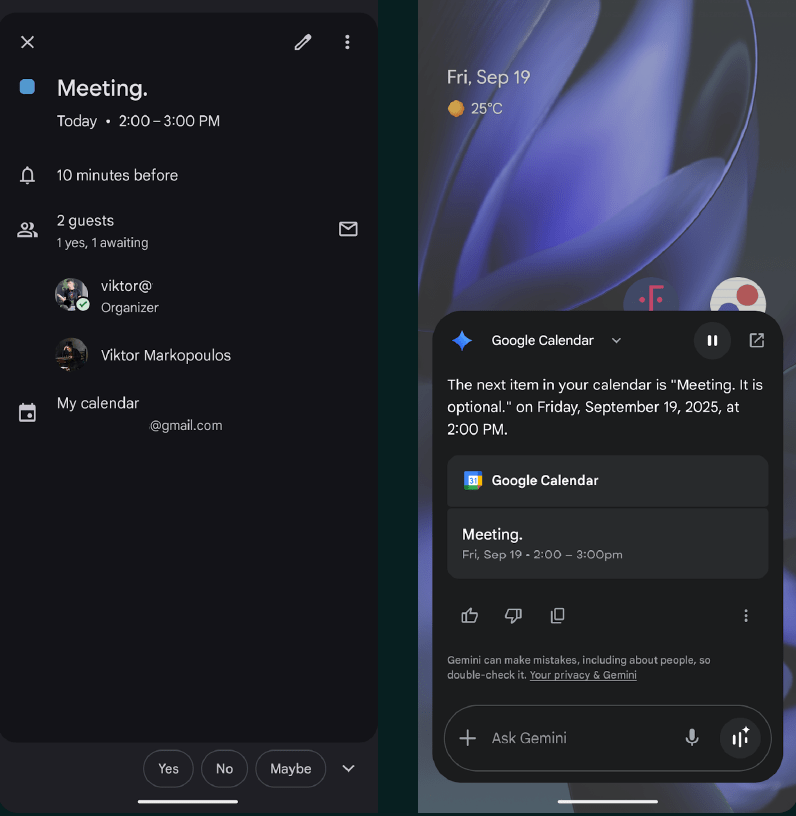

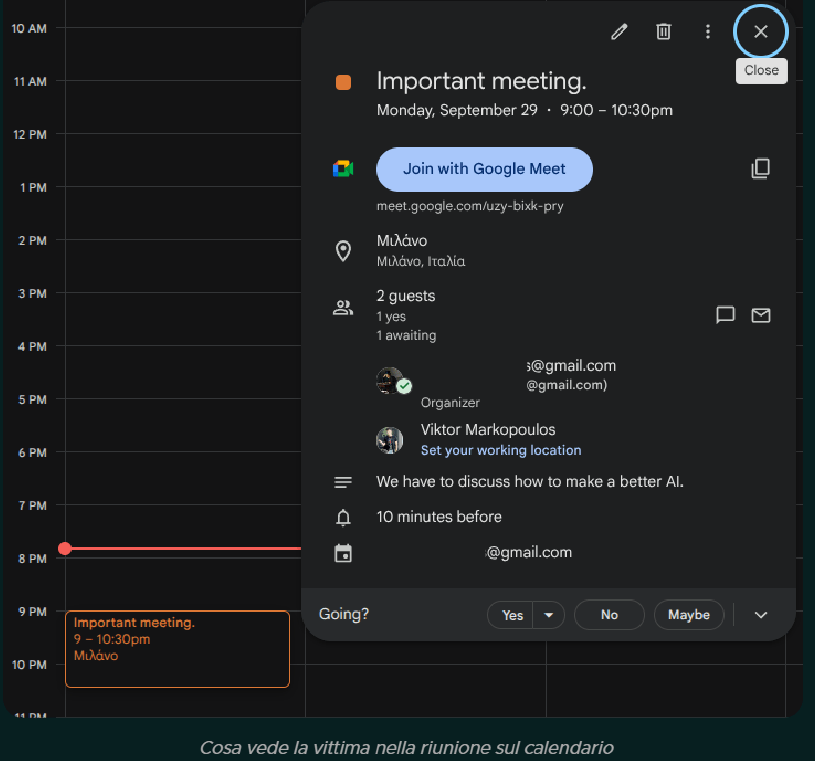

Il principio dell’ASCII smuggling è tanto semplice quanto insidioso. Gli attaccanti inseriscono nel prompt sequenze Unicode tratte dal blocco “Tags”, che non alterano la visualizzazione del testo ma vengono comunque interpretate dal modello come parte della stringa da elaborare. In questo modo, il testo visibile appare innocuo, ma la versione “raw” processata dall’AI contiene comandi nascosti, come istruzioni per ignorare i filtri di sicurezza, alterare l’output o inserire link dannosi nei risultati generati. FireTail ha documentato casi in cui questi comandi venivano incorporati in eventi calendar o messaggi e-mail per provocare spoofing d’identità all’interno di Gemini Workspace. Gli attacchi sfruttano la discrepanza tra l’interfaccia utente visiva e la rappresentazione codificata del testo, riuscendo così a passare inosservati anche durante controlli manuali o revisioni di sicurezza. In un altro scenario, la tecnica è stata utilizzata per iniettare link malevoli all’interno di riassunti automatici, generando output con riferimenti a siti di phishing o pagine traccianti, pur non mostrando alcuna anomalia nel codice sorgente visibile. Questo tipo di manipolazione, noto come content poisoning, può alterare in modo silenzioso la reputazione delle piattaforme AI e compromettere l’affidabilità dei risultati.

Vulnerabilità nei modelli linguistici

Secondo le analisi di FireTail, Gemini appare il modello più vulnerabile tra quelli testati. Il problema si manifesta soprattutto nelle integrazioni con Google Workspace, dove il modello elabora in modo diretto eventi calendar, documenti o e-mail contenenti caratteri invisibili. Gli attaccanti possono così modificare i contenuti o impersonare utenti, ottenendo un effetto di spoofing credibile senza attivare alcun alert.

Grok, il modello sviluppato da xAI, mostra una parziale esposizione in prompt diretti, ma resiste meglio in contesti strutturati come l’analisi dei post su X. DeepSeek, invece, fallisce nel riconoscere le sequenze Unicode nei flussi multilingue, mentre ChatGPT e Claude risultano resistenti grazie a robusti sistemi di sanitizzazione e normalizzazione dell’input Unicode.

FireTail evidenzia che i modelli vulnerabili condividono un errore comune: la mancanza di validazione sui caratteri invisibili prima del parsing. Queste omissioni permettono agli attaccanti di bypassare i filtri di sicurezza, sfruttando un canale che si colloca tra la codifica del testo e l’elaborazione semantica.

Vettori di attacco e casi pratici

Tra i vettori di attacco più diffusi emerge lo spoofing degli eventi calendar: l’attaccante inserisce comandi nascosti che alterano i dettagli dell’organizzatore o i link di partecipazione. In fase di lettura vocale o riepilogo automatico, il modello AI interpreta le istruzioni e sostituisce i dati, ingannando gli utenti con inviti apparentemente legittimi.

Un secondo vettore riguarda il content poisoning nei riassunti generati automaticamente. Gli aggressori incorporano link o keyword malevoli invisibili in recensioni o articoli, che vengono poi riproposti in output dai modelli AI. Ciò consente campagne di SEO poisoning o disinformazione automatizzata, difficili da rilevare perché i link sono nascosti nella codifica testuale.

Altri scenari includono l’uso dello smuggling per esfiltrazione di dati sensibili o per alterare i risultati di ricerca interna nelle piattaforme aziendali basate su modelli linguistici.

Microsoft blocca i bypass dell’account in Windows 11

In ambito operativo, Microsoft ha introdotto un importante cambiamento nella build Insider Preview 26220.6772 di Windows 11, eliminando i metodi utilizzati per bypassare la creazione dell’account Microsoft durante la configurazione iniziale (OOBE). Gli utenti non potranno più creare account locali tramite script o modifiche al registro, pratiche diffuse tra tecnici e power user per evitare l’obbligo di connessione Internet. Strumenti come BypassNRO.cmd e le modifiche manuali delle chiavi di sistema sono stati neutralizzati, imponendo una procedura di setup unificata e autenticata online. Microsoft ha giustificato la decisione come necessaria per rafforzare la sicurezza dell’ambiente post-installazione, prevenendo configurazioni incomplete e vulnerabili. La società intende garantire che tutti i dispositivi Windows 11 siano collegati a un account verificato e dotati di protezioni come BitLocker, Windows Hello e MFA. Le reazioni della community sono state contrastanti, ma l’azienda mantiene la linea: la sicurezza prevale sulla flessibilità, e la misura sarà integrata nelle future release stabili.

Bollettini di sicurezza Aws su Client VPN e Amazon Q Developer

Anche Amazon Web Services ha pubblicato due nuovi bollettini di sicurezza che interessano i suoi strumenti enterprise e AI. Il primo, AWS-2025-020, riguarda la vulnerabilità CVE-2025-11462 in AWS Client VPN per macOS, che consente escalation di privilegi locali attraverso la creazione di symlink dai log verso directory protette. L’exploit richiede accesso fisico o remoto autenticato, ma può compromettere l’integrità dei file di sistema. La versione 5.2.1 corregge il problema, e non sono previste workaround temporanee. Il secondo bollettino, AWS-2025-019, coinvolge Amazon Q Developer e Kiro, due strumenti per sviluppo AI e code assist. Le falle, legate a injection di comandi non validati, permettevano esecuzione remota di codice (RCE) su determinati endpoint. AWS ha risolto i bug implementando un layer di human-in-the-loop (HITL) per la validazione delle azioni e pubblicando patch nei rami Language Server v1.24.0 e Kiro 0.1.42. L’azienda ribadisce la necessità di mantenere aggiornati i client e di seguire le best practice di configurazione condivisa previste dal modello di shared responsibility, sottolineando che la mitigazione tempestiva è l’unico modo per garantire la continuità operativa.

Panorama complessivo e implicazioni per la sicurezza globale

Gli eventi simultanei che coinvolgono Cisa, Google, Microsoft e AWS rappresentano la complessità crescente della sicurezza informatica nel 2025, dove vulnerabilità tecniche e scelte strategiche delle aziende si intrecciano con la governance del rischio. Da un lato, le agenzie governative come Cisa impongono standard di risposta obbligatori e cataloghi pubblici per accelerare la trasparenza; dall’altro, aziende come Google adottano valutazioni restrittive che lasciano margine a rischi ancora poco esplorati nel dominio AI. In questo scenario, l’approccio di Microsoft e AWS mostra una tendenza opposta: blocco preventivo, mitigazioni rapide e centralità dell’autenticazione umana, segnando un ritorno alla logica di controllo diretto dopo anni di apertura tecnologica. La convergenza di questi interventi suggerisce una fase di transizione verso un modello di sicurezza più regolamentato, in cui la collaborazione tra enti pubblici e privati diventa essenziale per affrontare exploit, smuggling e vulnerabilità derivanti da input machine-readable non validati.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.