Meta accelera la trasformazione della propria infrastruttura globale combinando scalabilità per l’intelligenza artificiale e sostenibilità ambientale. L’azienda espande la rete backbone per supportare carichi AI sempre più intensi e introduce principi di Design for Sustainability per ridurre le emissioni Scope 3 legate all’hardware IT. Questa strategia integra innovazione tecnica, efficienza energetica e responsabilità ambientale, proiettando Meta verso l’obiettivo di zero emissioni nette entro il 2030.

Scalabilità del backbone per AI

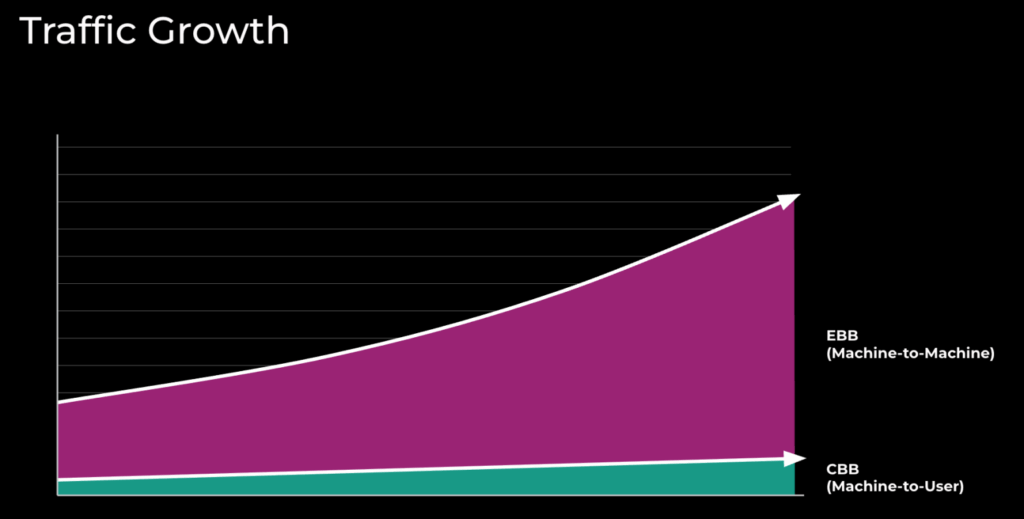

La rete backbone di Meta, composta da Classic Backbone e Express Backbone, rappresenta il cuore della connettività tra data center e punti di presenza globali. Dal 2015, il traffico tra data center (DC-to-DC) è cresciuto di dieci volte, superando quello verso i punti di accesso (DC-to-POP). Per gestire questa crescita, Meta ha introdotto una nuova architettura chiamata 10X Backbone, capace di scalare simultaneamente topologia e tecnologia.

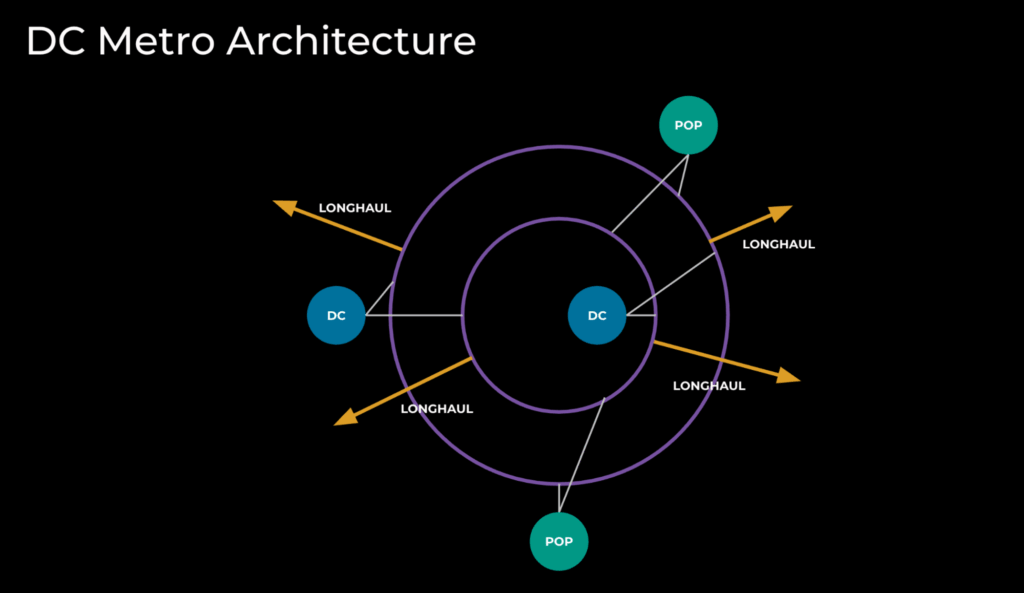

L’azienda adotta una struttura metro modulare che collega anelli in fibra long-haul a punti di presenza regionali. Questa scelta riduce tempi di deployment e consente di espandere la capacità in modo agile. La rete Express Backbone, evoluta con il protocollo Open/R e algoritmi di traffic engineering personalizzati, consente di bilanciare carichi AI tra cluster GPU e infrastrutture distribuite, garantendo una connettività resiliente e a bassa latenza.

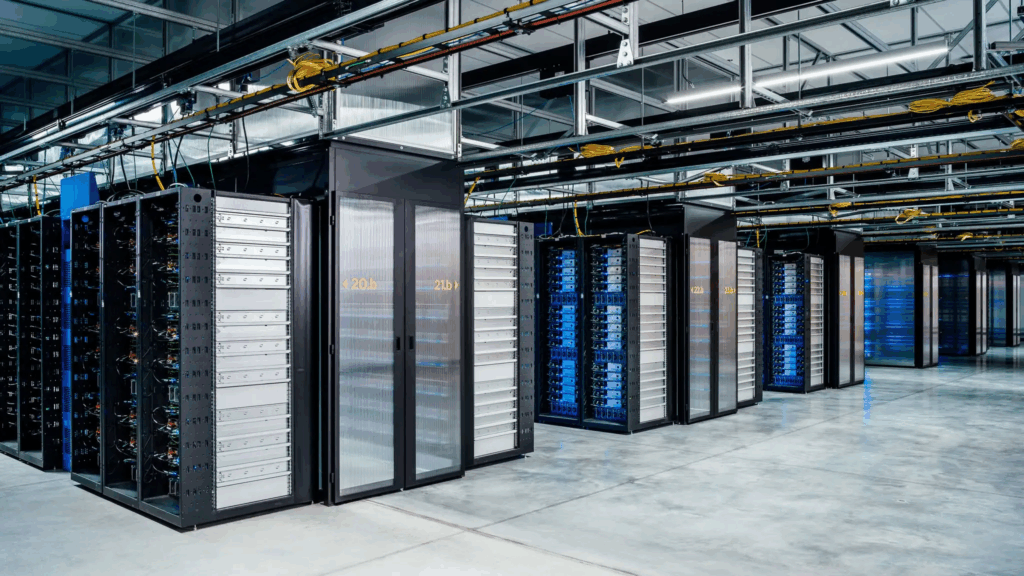

Per soddisfare la domanda generata da modelli di AI sempre più grandi, Meta ha costruito data center city-size, collegati da dorsali ottiche in grado di trasferire centinaia di terabit al secondo. Il progetto AI Backbone nasce da questa evoluzione e integra architetture leaf-and-spine, progettate per offrire capacità di calcolo massiccia con un impatto energetico contenuto.

Scalabilità delle piattaforme IP

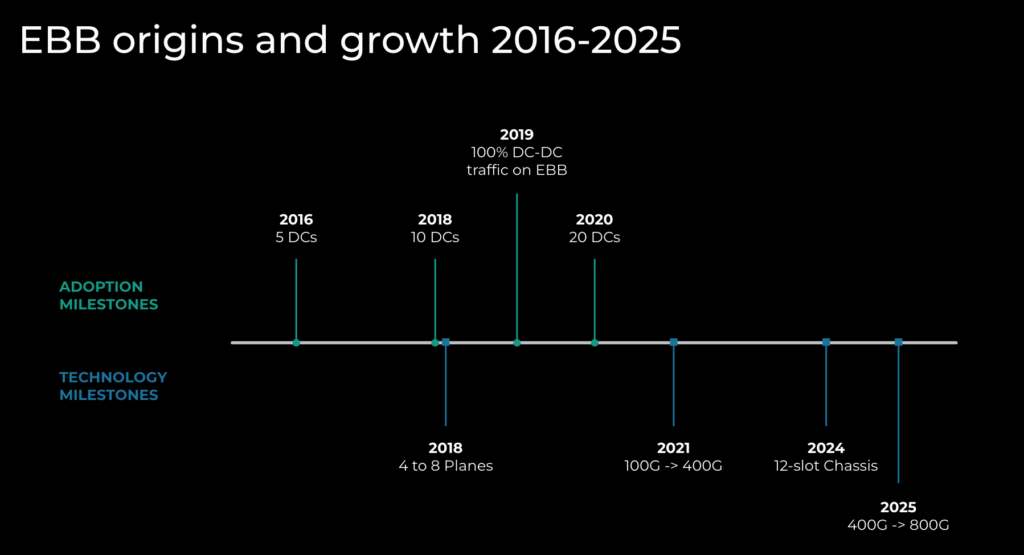

Per aumentare la capacità di rete, Meta combina due strategie complementari: scaling up e scaling out. Con lo scaling up, l’azienda adotta chassis a 12 slot che offrono fino al 50% di capacità aggiuntiva rispetto ai modelli precedenti, con interfacce da 800G e ASIC multipli per il controllo del traffico. Questo approccio aumenta la densità di potenza per rack, imponendo nuove sfide termiche che Meta affronta con soluzioni di raffreddamento ottimizzate.

Lo scaling out, invece, consiste nell’aggiunta di nuovi piani backbone, raddoppiando il numero di percorsi da quattro a otto e consentendo una gestione più flessibile della capacità geografica. La combinazione di entrambi i metodi consente a Meta di raddoppiare la capacità globale mantenendo un equilibrio tra performance e resilienza operativa.

Integrazione tra IP e ottica

Una delle innovazioni più significative riguarda l’integrazione tra IP e ottica, che consente di eliminare i transponder standalone e sostituirli con moduli pluggable ZR e ZR+ direttamente nei router. Questa soluzione riduce l’ingombro fisico, il consumo energetico e la complessità gestionale.

Ogni plug ottico consuma solo 10-15 watt, riducendo del 90% il consumo energetico per terabit trasportato rispetto ai sistemi tradizionali. L’integrazione consente inoltre un risparmio fino all’80% sul numero di dispositivi attivi per rack. La telemetria ottica integrata nei dispositivi IP migliora la visibilità operativa, permettendo a Meta di ottimizzare dinamicamente le connessioni in base al traffico AI.

Il backbone è oggi in grado di gestire 64 flussi da 800G per ogni coppia di fibre, una densità senza precedenti che rende possibile il supporto simultaneo di carichi AI, machine learning e servizi cloud.

Espansione per cluster AI e data center

Meta espande il footprint energetico dei propri cluster GPU, superando i limiti strutturali dei data center tradizionali. Per connettere questi cluster, l’azienda impiega plug FR per 3 km, plug LR per 10 km e ZR con DWDM per distanze lunghe, riducendo del 64% il numero di fibre necessarie. La tecnologia C+L Band 800G ZR consente di trasmettere grandi volumi di dati senza amplificatori intermedi, riducendo costi e consumi. Attraverso un sistema di optical protection switching, la rete garantisce continuità anche in caso di guasti, supportando carichi AI che richiedono affidabilità assoluta. Meta dichiara che un singolo site-pair AI può oggi trasportare un volume di traffico equivalente all’intero backbone globale del 2015, dimostrando l’efficienza dell’evoluzione infrastrutturale.

Lezioni apprese e roadmap futura

L’azienda ha anticipato dal 2028 al 2024 i propri piani di scalabilità, accelerando la transizione verso l’AI Backbone. La principale lezione emersa è che la scalabilità sostenibile deriva da innovazioni simultanee in progettazione, integrazione e gestione. Meta ora applica questi principi su tutti i nuovi siti, iterando i design per ottimizzare il rapporto tra potenza di calcolo, spazio fisico e impatto ambientale.

Principi di design per la sostenibilità

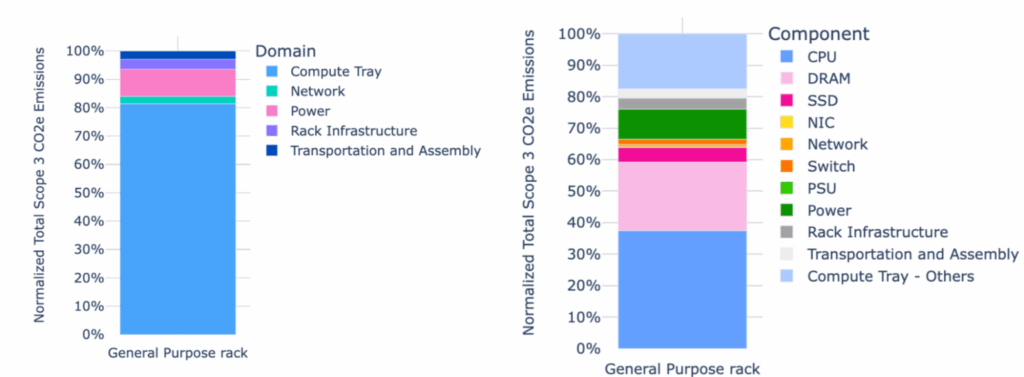

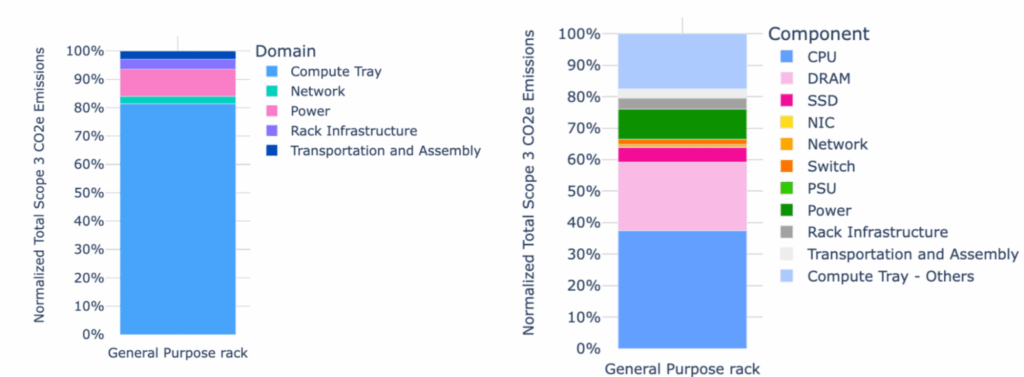

Parallelamente allo sviluppo infrastrutturale, Meta introduce la filosofia Design for Sustainability, una serie di linee guida che mirano a ridurre l’impatto ambientale dell’hardware IT e a tagliare le emissioni Scope 3 — quelle generate lungo la catena di fornitura.

I principi chiave includono efficienza energetica, modularità, riutilizzo e dematerializzazione. Meta adotta il framework Open Rack ORv3, che separa le unità di alimentazione e backup in scaffali modulari, permettendo configurazioni flessibili e una migliore manutenzione. Questa architettura riduce sprechi di materiali e semplifica gli aggiornamenti dei rack. Per le infrastrutture di rete, Meta introduce la variante ORv3N, retrocompatibile con i rack esistenti. Il design standardizzato riduce i rischi qualitativi e accelera il deployment. Inoltre, la compagnia sostituisce acciaio tradizionale con “green steel”, ottenuto da forni elettrici ad arco, e impone ai fornitori un requisito minimo del 20% di materiale riciclato. I dissipatori di calore vengono realizzati in alluminio o rame riciclato, in collaborazione con partner come Tata Steel. Meta riduce anche il numero di componenti elettronici non essenziali, eliminando connettori e circuiti inutilizzati, e sostituendo HDD con SSD per migliorare efficienza e durata. L’azienda sperimenta memorie PCM e MRAM, oltre a moduli LPDDR per ridurre i consumi nei server AI.

Uso dell’AI per stimare e ridurre le emissioni

Meta applica intelligenza artificiale generativa per stimare con precisione le emissioni Scope 3 dei propri componenti. La compagnia ha sviluppato una tassonomia comune open source, presentata all’Open Compute Project, che consente di aggregare i dati di milioni di parti hardware e identificare gli “hotspot emissivi”. L’AI utilizza tecniche di Natural Language Processing, come TF-IDF e cosine similarity, per classificare automaticamente i componenti e mappare i Product Carbon Footprint (PCF) alle relative varianti. I modelli identificano i materiali e i processi produttivi con il maggiore impatto ambientale, suggerendo alternative più sostenibili.

Questa metodologia, già applicata a moduli di memoria e cablaggi, consente a Meta di migliorare la qualità del reporting ambientale e di estendere il programma Net Zero Supplier, che coinvolge i principali fornitori nella transizione verso materiali e processi a basse emissioni.

Verso un’infrastruttura AI sostenibile

Con la combinazione di un backbone a capacità 10x e di hardware progettato secondo principi ecologici, Meta si posiziona come pioniere dell’efficienza ambientale nel settore AI. L’azienda trasforma la propria rete globale in un modello di riferimento per l’industria, dimostrando che la scalabilità e la sostenibilità possono coesistere. Meta descrive questa evoluzione non solo come un traguardo tecnologico, ma come una necessità etica per un futuro digitale più responsabile.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.