NVIDIA e Google Cloud guidano la nuova fase dell’intelligenza artificiale e delle infrastrutture cloud, unendo potenza computazionale, trasparenza open source e soluzioni per la pubblica amministrazione. Dalla produzione del primo wafer Blackwell negli Stati Uniti in collaborazione con TSMC Arizona, ai nuovi strumenti Gemini CLI, Vertex AI SDK e BigQuery Studio, le due aziende stanno ridefinendo gli standard globali di innovazione digitale.

Produzione NVIDIA Blackwell con TSMC

NVIDIA ha annunciato l’avvio della produzione in volumi dei chip Blackwell sul suolo statunitense. Il primo wafer è stato realizzato presso la fabbrica TSMC di Phoenix, Arizona, con un evento simbolico che ha visto Jensen Huang, CEO di NVIDIA, firmare la prima unità insieme a Y.L. Wang di TSMC. Questo momento rappresenta un punto di svolta per la reindustrializzazione americana e per il rafforzamento della sovranità tecnologica USA.

Blackwell, costruito con processi a 2 e 4 nanometri, inaugura una nuova generazione di GPU acceleratrici ad alte prestazioni, progettate per AI generativa, HPC e data analytics. La collaborazione con TSMC consente di integrare robotica e automazione AI nelle linee produttive, garantendo qualità e scalabilità senza precedenti. NVIDIA prevede che i chip Blackwell, grazie alla loro efficienza energetica e all’ottimizzazione per carichi di inferenza, diventeranno il cuore delle future AI factories statunitensi. La partnership con TSMC, attiva da oltre trent’anni, conferma l’obiettivo condiviso di potenziare le capacità produttive locali e di garantire supply chain resilienti. Durante l’evento Open Source AI Week a San Francisco, NVIDIA ha sottolineato come l’hardware Blackwell sia solo una parte di un ecosistema più ampio che integra software open source, framework di deep learning e librerie HPC in un’unica piattaforma distribuita.

Contributi NVIDIA a open source AI

Nel contesto dell’Open Source AI Week, NVIDIA ha annunciato la pubblicazione di oltre 1000 risorse su GitHub e 450 modelli su Hugging Face, consolidandosi come primo contributor mondiale alle piattaforme AI collaborative. L’iniziativa comprende framework, dataset e strumenti system-level pensati per sviluppatori e ricercatori.

Tra i progetti principali figurano i modelli Nemotron, che accelerano l’addestramento su PyTorch, e DeepConsensus, un tool open source che migliora del 250% il throughput nel sequenziamento genetico. NVIDIA ha anche collaborato con istituzioni accademiche per il progetto pangenoma umano, contribuendo alla scoperta di nuove varianti genetiche associate a patologie oncologiche. Durante la PyTorch Conference, l’azienda ha promosso hackathon e workshop per favorire la collaborazione tra sviluppatori e community scientifiche, ribadendo il proprio impegno verso un’AI più aperta, equa e trasparente.

Partnership Google Cloud e NVIDIA per AI sicura

Google Cloud e NVIDIA hanno rafforzato la loro alleanza strategica per abilitare applicazioni AI sicure e scalabili nel settore pubblico. Dal 27 al 29 ottobre 2025, durante il GTC DC e il Public Sector Summit a Washington, le due aziende presenteranno soluzioni per la gestione di dati governativi sensibili, AI agentica e calcolo ad alte prestazioni (HPC). Il CEO di Google Cloud Thomas Kurian e Jensen Huang di NVIDIA terranno una fireside chat dedicata all’AI per la pubblica amministrazione, mentre il programma “Gemini for Government” introdurrà una piattaforma basata su GPU Blackwell per l’elaborazione sicura di informazioni critiche. La partnership punta a fornire alle agenzie federali un’infrastruttura air-gapped, cioè isolata da Internet, capace di eseguire modelli multimodali con privacy garantita e latenza ridotta. Google Cloud fornirà i servizi di scalabilità e orchestration tramite GKE, mentre NVIDIA offrirà acceleratori ottimizzati per AI e quantum computing.

Aggiornamenti di BigQuery Studio e strumenti per sviluppatori

Google ha aggiornato BigQuery Studio con una nuova interfaccia più pulita e produttiva. La Explorer view consente la ricerca di risorse filtrate per progetto, mentre il Reference panel offre informazioni contestuali e frammenti SQL generabili direttamente dall’editor. La sezione Job history è stata semplificata per ridurre la proliferazione di tab e migliorare la visibilità delle query eseguite. L’obiettivo è favorire un ambiente di analisi dati più efficiente, con meno interruzioni di contesto e maggiore spazio per il codice. Il rinnovamento di BigQuery Studio fa parte di un piano più ampio che include strumenti per data engineer, analisti e sviluppatori di machine learning, integrando la console Google Cloud con feedback diretto e supporto multi-progetto.

Gemini CLI per modelli LLM su GKE

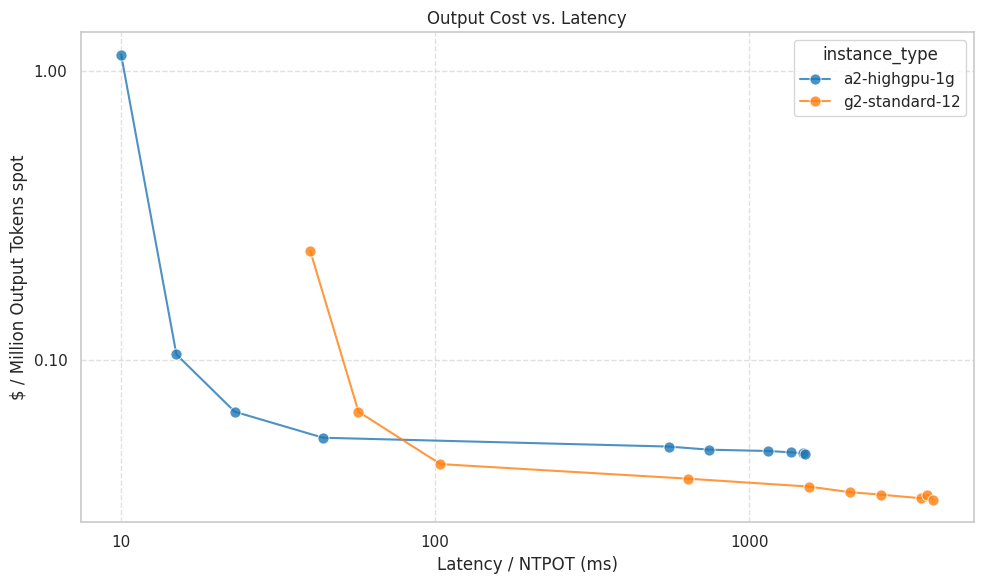

Google ha introdotto Gemini CLI, un’interfaccia da riga di comando progettata per gestire workload di LLM su Google Kubernetes Engine (GKE). Lo strumento consente di confrontare modelli, calcolare costi operativi, e distribuire configurazioni Kubernetes tramite manifest generati automaticamente.

Con Gemini CLI, il deployment di modelli AI passa da mesi a minuti, grazie a estensioni GKE-MCP e supporto per autoscaling e observability. Il tool offre benchmark automatici per prestazioni e costi, suggerendo configurazioni hardware ottimali in base alla dimensione del modello e al livello di latenza desiderato.

Disponibilità generale delle VMs Axion per Cloud SQL

Google ha portato in general availability le nuove VMs C4A e N4 basate su CPU Axion, progettate per il servizio Cloud SQL Enterprise. I test mostrano un miglioramento fino al 48% nel rapporto prezzo-prestazioni rispetto alle istanze N2 e un throughput fino a 2 volte superiore. Le nuove VMs offrono Hyperdisk Balanced Storage, che garantisce 1,6x IOPS e 2x throughput rispetto alle configurazioni precedenti, riducendo i costi per workload I/O intensivi come PostgreSQL, MySQL e SQL Server. Client come Avi Medical e Synspective riportano riduzioni dei costi fino al 35% e miglioramenti nelle query del 50%, confermando l’efficacia delle ottimizzazioni Axion per scenari enterprise.

Moloco e Vertex AI per retail media intelligente

La piattaforma pubblicitaria Moloco sfrutta Vertex AI per introdurre la vector search semantica, che sostituisce il classico approccio basato su keyword. Grazie all’integrazione con Google ScaNN e alle TPU di Google Cloud, Moloco elabora milioni di combinazioni in pochi millisecondi, riducendo la latenza del 25% e migliorando il CTR del 4%.

import vertexai

# Instantiate a client

client = vertexai.Client(project=PROJECT_ID, location=LOCATION)

# Define a prompt object

prompt = {

"prompt_data": {

"contents": [

{

"parts": [

{

"text": "Hello, {name}! How are you?"

}

]

}

],

# variables replace templates in a prompt, i.e. {name} in this prompt

"variables": [

{

"name": {

"text": "Alice"

}

}

],

"model": "gemini-2.5-flash"

}

}

# Create a prompt in Vertex

prompt_resource = client.prompts.create(

prompt=prompt,

)

La collaborazione con Google consente a Moloco di gestire enormi volumi di dati di prima parte senza costruire infrastrutture personalizzate, garantendo isolamento dei tenant e compliance enterprise.

Gestione prompt e caching in Vertex AI

Google ha rilasciato in GA la funzione Prompt Management in Vertex AI SDK, che permette di creare, versionare e gestire prompt programmaticamente. Gli sviluppatori possono trattare i prompt come veri e propri asset con controllo di versione, garantendo coerenza tra team e pipeline di produzione. La novità si affianca alla funzione di context caching, che consente di riutilizzare token precomputati per ridurre i costi fino al 90% e migliorare le performance su modelli Gemini 2.5 e superiori. Il caching può essere implicito o esplicito, con billing orario e TTL configurabile, ottimizzando l’elaborazione di documenti multimodali o dataset estesi.

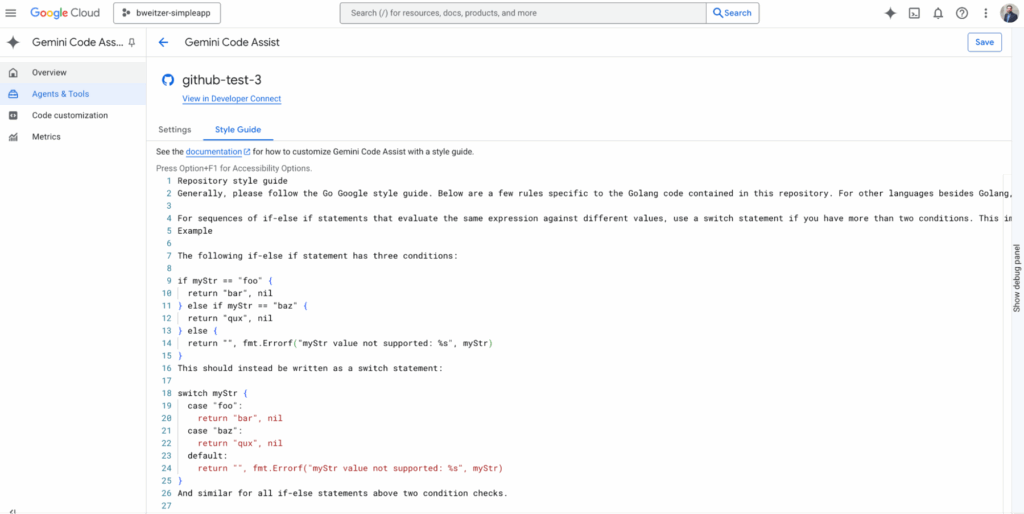

Gemini Code Assist su GitHub Enterprise

Google ha infine introdotto in preview Gemini Code Assist per GitHub Enterprise e GHEC Server. Lo strumento analizza automaticamente il codice, identifica anti-patterns, applica style guide personalizzate e migliora le metriche DORA riducendo i tempi di revisione. Operando in modalità stateless, Code Assist non utilizza i dati aziendali per training e garantisce piena privacy. Le organizzazioni possono configurare policy centralizzate, integrazioni CLI e reportistica automatica per i team di sviluppo distribuiti.

Con queste iniziative, NVIDIA e Google Cloud consolidano la propria leadership nel settore AI-cloud, bilanciando innovazione tecnologica, sostenibilità e sicurezza. La produzione locale dei chip Blackwell, i contributi open source e l’evoluzione degli strumenti di AI distribuita segnano l’ingresso in una nuova era di intelligenza artificiale accessibile, scalabile e trasparente.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.