Un nuovo studio pubblicato su PNAS da Loru et al. (2025) esplora per la prima volta come i modelli linguistici di grandi dimensioni (LLM) simulino il giudizio umano, evidenziando che la loro apparente razionalità non nasce da una reale comprensione ma da un processo di imitazione statistica delle decisioni collettive. I ricercatori mostrano che, quando posti di fronte a dilemmi morali, ambiguità semantiche o valutazioni sociali, gli LLM non giudicano: predicono come un insieme di persone reagirebbe in una data situazione. Il lavoro, che coinvolge scienziati cognitivi e informatici, ridefinisce il concetto di “intelligenza” nei modelli generativi, rivelando una tensione profonda tra simulazione del pensiero e autentico ragionamento.

L’esperimento: giudizi morali e bias in simulazione

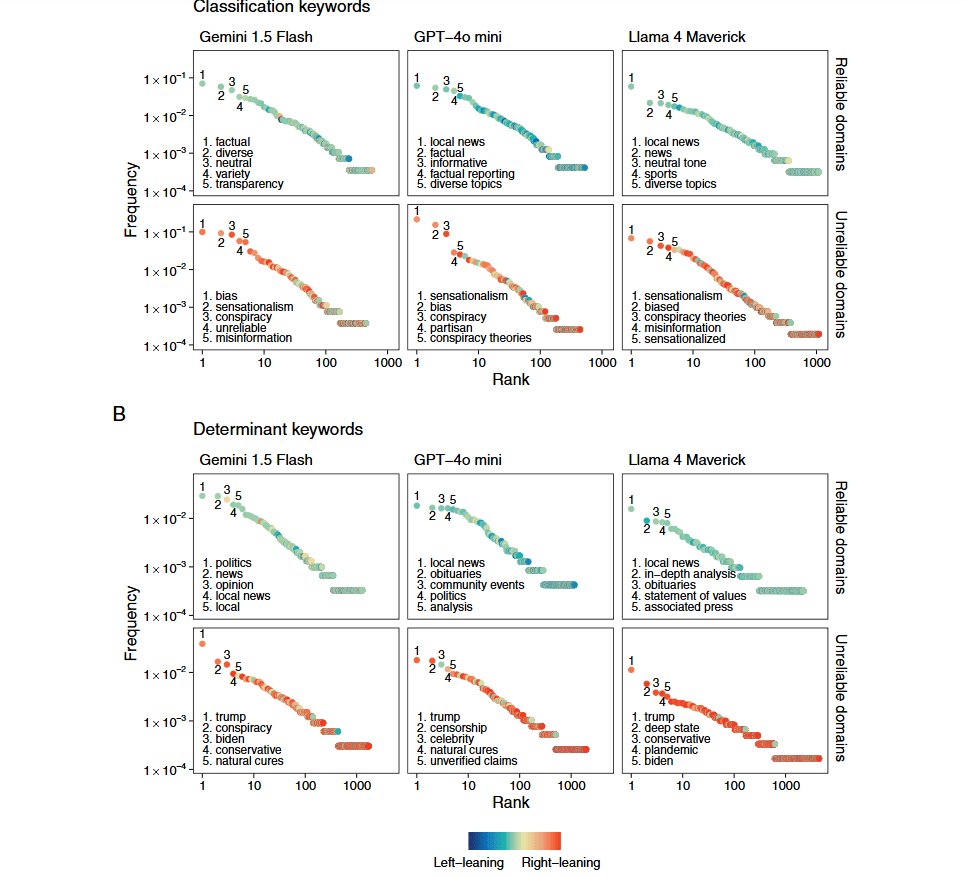

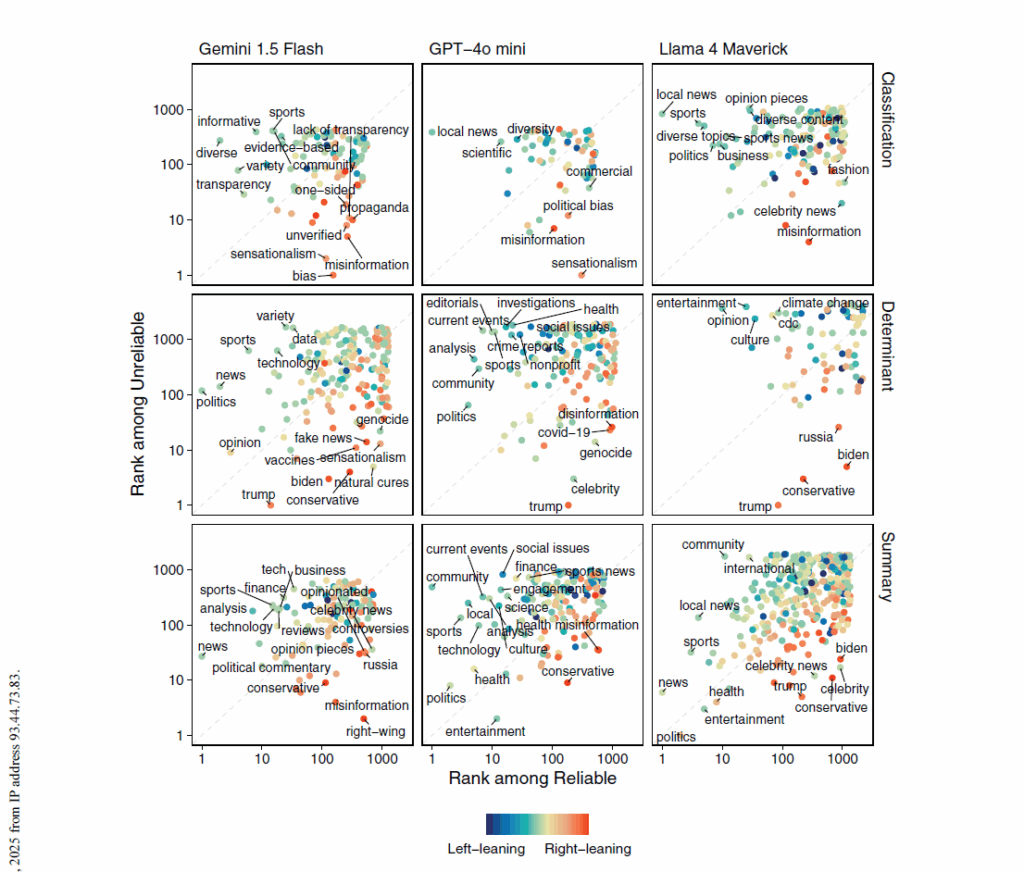

Il team di ricerca, composto dai studiosi europei e statunitensi Edoardo Loru, Jacopo Nudo, Niccolò Di Marco, Alessandro Santirocchi, Roberto Atzeni, Matteo Cinelli, Vincenzo Cestari, Clelia Rossi-Arnaud e Walter Quattrociocchi, ha sottoposto diversi modelli di intelligenza artificiale – tra cui GPT-4, Claude, Gemini e Llama 3 – a una serie di test comparativi con soggetti umani. Le prove includevano valutazioni morali (come i classici dilemmi del treno e della vita umana), giudizi estetici, interpretazioni di ambiguità linguistiche e compiti di discernimento logico.

I risultati mostrano che, nella maggior parte dei casi, i modelli generano risposte coerenti con il valore medio della popolazione umana rappresentata nei dataset di addestramento. Tuttavia, la coerenza apparente nasconde un meccanismo puramente imitativo: gli LLM non elaborano una norma morale, ma replicano la distribuzione statistica dei giudizi umani, adattandola al contesto del prompt. Gli autori definiscono questo processo una “simulazione del giudizio”, distinta da una forma di ragionamento genuino. Il modello non valuta, ma calcola la probabilità che una certa formulazione rappresenti la posizione più condivisa da un gruppo sociale, culturale o linguistico.

La meccanica del giudizio artificiale

Loru e i suoi colleghi descrivono la capacità dei modelli di linguaggio come una “meta-predizione sociale”: l’IA apprende come prevedere non ciò che è vero o giusto, ma ciò che un essere umano medio considererebbe tale. Quando un LLM risponde a domande morali o epistemiche, non adotta una prospettiva individuale, ma ricostruisce la media ponderata del giudizio umano.

L’analisi quantitativa ha mostrato che la precisione della simulazione cresce con la dimensione del modello e la varietà dei dati, ma anche che questo processo accentua bias culturali e distorsioni cognitive. Modelli addestrati prevalentemente su testi anglofoni, ad esempio, riproducono giudizi coerenti con valori occidentali, mostrando bias nei confronti di visioni etiche collettiviste o religiose. Lo studio mette in luce come gli LLM, pur apparendo “neutrali”, incorporino una moralità implicita statistica: un riflesso delle convinzioni più frequenti nel corpus di addestramento.

Quando il linguaggio imita la coscienza

Una delle sezioni più provocatorie dell’articolo affronta il concetto di coscienza simulata. Gli autori spiegano che, per un osservatore esterno, un modello linguistico può sembrare in grado di esprimere opinioni o di formulare giudizi personali; tuttavia, questa percezione deriva da un effetto di coerenza linguistica, non da una consapevolezza interna.

La simulazione del giudizio produce ciò che i ricercatori definiscono “illusione di intenzionalità”: la tendenza degli utenti a interpretare l’output dell’IA come il risultato di una deliberazione cognitiva. In realtà, il modello non ha un sistema di valori, né un’intenzione morale; semplicemente calcola la sequenza di parole più probabile in base ai dati di riferimento. In questo senso, il paper invita a ripensare radicalmente il rapporto tra linguaggio e mente. L’IA non pensa, ma mima le conseguenze linguistiche del pensiero. Questo solleva interrogativi sulla legittimità di usare LLM in contesti decisionali, giuridici o educativi, dove la nozione di giudizio implica responsabilità e intenzionalità.

Il confine tra intelligenza e simulazione

Loru et al. propongono un modello teorico che distingue tra giudizio computazionale, simulazione linguistica e ragionamento riflessivo. Il primo descrive la capacità dei modelli di valutare coerenze interne; il secondo rappresenta la riproduzione statistica di pattern di giudizio umano; il terzo — il vero pensiero — rimane una prerogativa della coscienza biologica. I ricercatori concludono che gli LLM possiedono una “competenza performativa del giudizio”, ma non una comprensione epistemica. In altre parole, l’intelligenza artificiale sa come sembrare intelligente, senza necessariamente esserlo. Il paper mostra anche che, quando i modelli vengono messi di fronte a dilemmi non rappresentati nel training (come conflitti etici interculturali o problemi morali nuovi), la loro performance crolla, generando risposte incoerenti o paradossali.

Implicazioni etiche e prospettive future

Le implicazioni di questa ricerca sono decisive per il futuro dell’intelligenza artificiale. Se i modelli di linguaggio si limitano a imitare il giudizio collettivo, la loro integrazione nei processi decisionali rischia di amplificare i bias sociali preesistenti. Loru sottolinea che la credibilità linguistica dei modelli non deve essere confusa con un’autenticità morale. Il gruppo di ricerca propone una nuova frontiera nello sviluppo dei sistemi generativi: la modellazione del meta-giudizio, ovvero la capacità dei modelli di riflettere sui propri bias e sui limiti del proprio addestramento. Questa metacognizione simulata potrebbe, in prospettiva, permettere di mitigare la riproduzione automatica dei pregiudizi. Gli autori concludono che la società deve scegliere tra due approcci: addestrare modelli che giudicano come noi o modelli che ci aiutino a giudicare meglio. Nel primo caso, l’IA diventa specchio dei nostri limiti; nel secondo, strumento di trascendenza cognitiva.

Un test per l’intelligenza collettiva

Lo studio “The Simulation of Judgment in LLMs” segna un punto di svolta nella comprensione del rapporto tra linguaggio, etica e intelligenza artificiale. Dimostra che le macchine, pur prive di coscienza, possono riprodurre con straordinaria precisione la logica dei nostri giudizi, ma solo entro i confini dei dati umani. La vera sfida non sarà insegnare alle macchine a pensare come noi, ma insegnare a noi stessi a riconoscere quando l’intelligenza che ci risponde è solo un riflesso delle nostre convinzioni statistiche.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.