Google Cloud introduce un’ondata di innovazioni nel campo dell’intelligenza artificiale e del cloud computing, segnando ottobre 2025 come un mese chiave per la maturazione del suo ecosistema. Gli aggiornamenti abbracciano modelli Gemini 2.5, framework di sicurezza potenziati come Model Armor, espansioni di rete con Cross-Site Interconnect e nuove VM HPC per calcolo ad alte prestazioni, consolidando la posizione dell’azienda come leader nel settore secondo IDC MarketScape 2025.

Evoluzione di Gemini e intelligenza artificiale generativa

La piattaforma Gemini continua a rappresentare il cuore della strategia AI di Google. Il nuovo Gemini 2.5 Pro introduce un livello di intelligenza multimodale superiore, capace di combinare testo, immagini, voce e video in flussi di lavoro coerenti attraverso Vertex AI. La versione Gemini 2.5 Flash, pensata per applicazioni educative e di produttività, fornisce guide passo-passo su argomenti complessi e una gestione più efficiente dei contesti, mentre migliora la comprensione visiva di note e diagrammi. Una delle novità più apprezzate è Canvas, lo strumento che consente di generare presentazioni complete a partire da un tema o documento caricato, integrando automaticamente immagini, grafici e testo con la possibilità di esportare in Google Slides o PDF. La compatibilità con LaTeX Rendering permette ora di copiare, modificare e rendere formule matematiche direttamente all’interno di Canvas, rendendo il tool ideale anche per ricerca e istruzione scientifica. L’intelligenza di Gemini arriva inoltre su Google TV, dove diventa assistente vocale conversazionale, capace di fornire raccomandazioni personalizzate basate sullo storico visivo e sull’analisi semantica dei contenuti di YouTube. Il rollout è già in corso per gli abbonati Pro e raggiungerà gli utenti gratuiti nelle prossime settimane.

Gemini nelle campagne creative e applicazioni scientifiche

Cinque grandi agenzie pubblicitarie hanno adottato Gemini 2.5 Pro per la creazione di campagne iper-personalizzate. L’integrazione con modelli generativi come Lyria per la musica, Chirp per la voce, Imagen per le immagini e Veo per i video consente la produzione automatizzata di contenuti immersivi e la generazione di esperienze personalizzate in tempo reale. Esempi emblematici includono Slice Healthy Soda, che ha creato una “radio AI” capace di comporre brani tematici e narrazioni integrate con i valori del marchio, e Smirnoff, che con il progetto “Party Engine” ha fuso dati culturali e preferenze degli ospiti per creare eventi dinamici e playlist su misura. In ambito scientifico, l’Istituto Max Planck ha collaborato con Google Cloud allo sviluppo di Proteomics Lab Agent, un sistema AI capace di analizzare video di laboratorio per identificare errori procedurali e generare protocolli standardizzati. Grazie all’analisi multimodale di Gemini, l’agente ottiene un recall del 74% nella rilevazione di anomalie e crea documentazione in meno di tre minuti. Il framework open-source è già in fase di adattamento per settori come biotecnologia e ingegneria.

Nuovi strumenti per sviluppatori e integrazione AI

Google estende l’accesso ai modelli generativi introducendo l’SDK .NET per AI generativa, che unifica l’interazione con Google AI e Vertex AI, supportando la generazione di testo, immagini e risposte strutturate. Lo strumento consente la configurazione di parametri avanzati come temperatura, vincoli semantici e schemi di output, mentre l’Agent Development Kit semplifica la creazione di agenti autonomi con memoria persistente e callback per la validazione delle azioni. Parallelamente, l’Agent Engine adotta il nuovo protocollo A2A (Agent-to-Agent), che abilita la comunicazione diretta tra agenti Gemini e introduce il Model Context Protocol (MCP) per standardizzare la gestione del contesto condiviso. Questa architettura modulare permette la creazione di ecosistemi di agenti cooperanti, con orchestratori root e sub-agent dedicati a specifici task industriali.

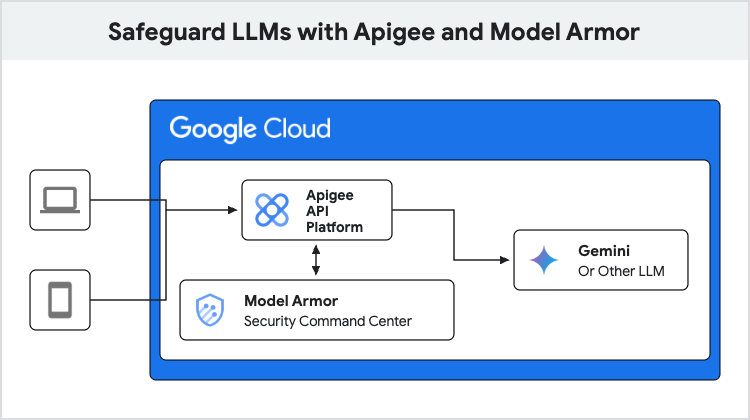

Sicurezza AI con Model Armor e Cloud Armor

Il nuovo framework Model Armor innalza lo standard di sicurezza per applicazioni AI. Il sistema filtra input e output per bloccare iniezioni prompt, jailbreak e contenuti dannosi, eseguendo la scansione automatica di URL maligni e dati sensibili (PII). I modelli vengono isolati in sandbox su Cloud Run, mentre Cloud Logging registra ogni interazione per audit e tracciabilità. Apigee si integra con Model Armor per definire policy di sicurezza dinamiche, mentre una dashboard unificata consente di monitorare rischi, tentativi di bypass e flussi di dati.

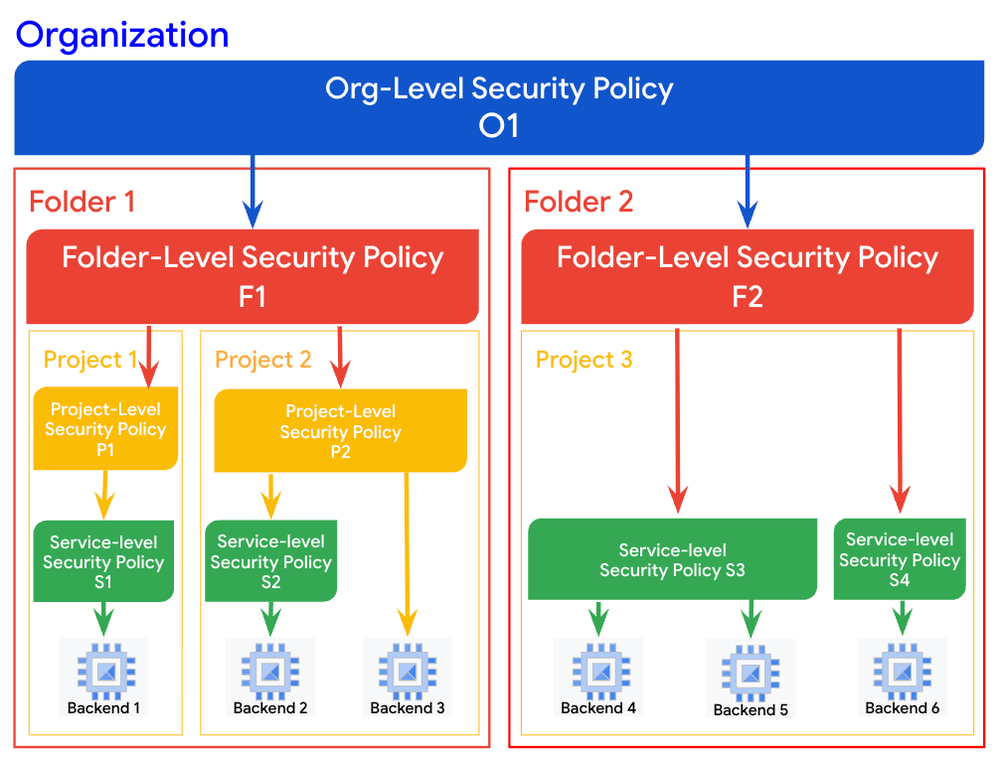

Il framework Secure AI completa la suite introducendo controlli granulari su VPC, redazione automatica dei dati sensibili e funzioni di isolamento a livello di rete. Sul fronte infrastrutturale, Cloud Armor ottiene il riconoscimento di Strong Performer nella Forrester Wave 2025, grazie alle nuove policy gerarchiche, al supporto JA4 fingerprinting per l’identificazione SSL/TLS e all’estensione WAF a 64 KB per la protezione di applicazioni web di grandi dimensioni.

Innovazioni in rete e connettività globale

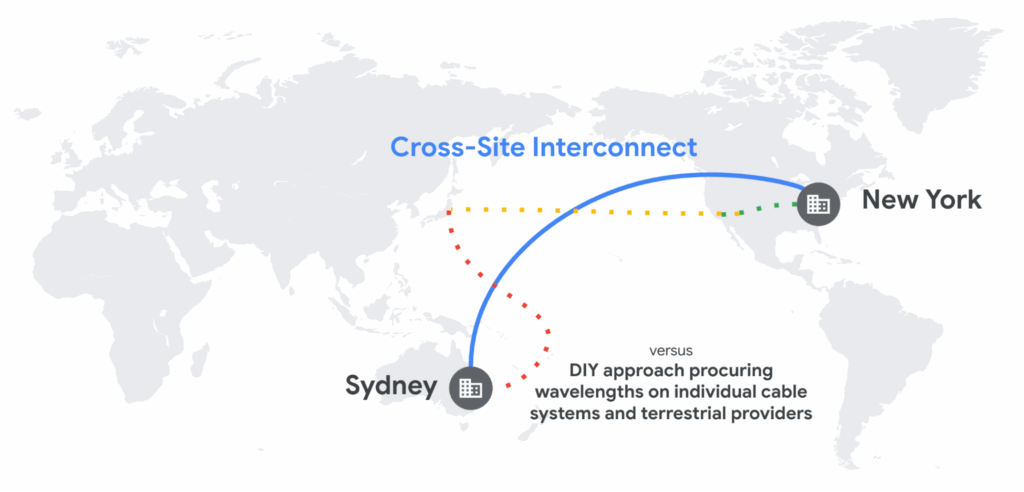

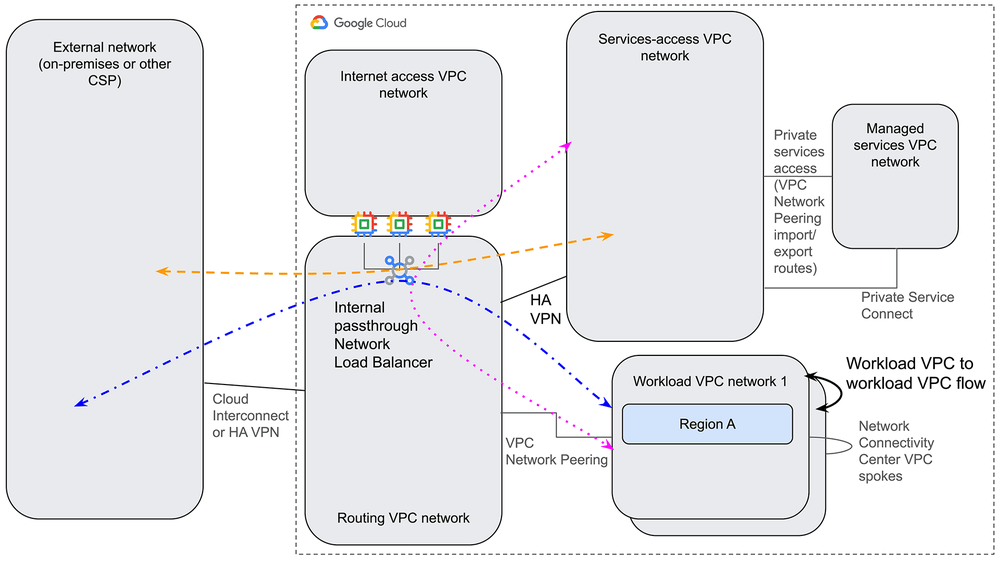

Google Cloud amplia le capacità della sua infrastruttura con l’introduzione di Cross-Site Interconnect (CSI), una soluzione GA che semplifica la connettività L2 e L3 su scala globale. Basata sull’architettura Cross-Cloud Network, CSI permette collegamenti diretti tra VPC regionali e workload ibridi, offrendo bassa latenza, MACsec per crittografia, e SLA del 99,95%.

Il modello hub-and-spoke consente una gestione flessibile dei flussi di traffico e una conformità geografica dei dati senza compromettere le performance. Le nuove routing policy-based rules e i bilanciatori interni NLB garantiscono resilienza e sicurezza, mentre PRR (Proactive Route Reroute) assicura la continuità in caso di failure.

Avanzamenti in analytics, dati e HPC

Lato dati, Dataplex introduce la lineage a livello di colonna per BigQuery, permettendo di tracciare l’origine e la trasformazione di ogni singolo attributo. Questa innovazione aumenta la fiducia nei dataset AI e migliora la trasparenza dei processi decisionali automatizzati. Google potenzia anche il proprio stack HPC con le nuove H4D VM basate su AMD EPYC di quinta generazione, ottimizzate per trading ad alta frequenza, simulazioni di rischio e calcolo scientifico avanzato. Queste VM garantiscono un 34% di aumento prestazionale nei benchmark KX Nano e integrano file system Lustre per accessi I/O estremamente rapidi. Le nuove G4 VM con GPU NVIDIA RTX 6000 Blackwell, ora in disponibilità generale, supportano MIG per inferenza multi-GPU, fino a 768 GB di memoria e throughput incrementato del 168%. La comunicazione P2P fabric riduce la latenza del 41% rispetto alla generazione precedente, con integrazione diretta in Vertex AI, Dataproc e GKE. L’AI Hypercomputer, inoltre, introduce vLLM TPU per accelerare l’inferenza dei LLM e unifica JAX e PyTorch in un unico runtime ottimizzato. Le nuove “ricette” NeMo RL forniscono schemi di addestramento per reinforcement learning, compatibili con GRPO e PPO, mentre GKE Inference Gateway bilancia dinamicamente i carichi per garantire stabilità operativa nei cluster AI di grandi dimensioni.

Ecosistemi cloud e automazione operativa

Google annuncia anche Parameter Manager, un servizio che gestisce configurazioni applicative in JSON o YAML, con versionamento automatico e integrazione con Secret Manager per la gestione dei segreti. Il sistema usa la sintassi REF per i riferimenti e un alias latest per versioni aggiornate, migliorando l’automazione CI/CD. A livello operativo, Google continua la migrazione di 30.000 applicazioni interne da x86 ad architettura Arm, utilizzando i processori Axion, con un risparmio energetico del 60%. Strumenti come Rosie e CHAMP monitorano rollout e remediation automatizzate, mentre CogniPort, un agente AI interno, analizza commit e suggerisce correzioni nel monorepo aziendale. Con questi aggiornamenti, Google Cloud rafforza la propria posizione come piattaforma di riferimento per AI generativa, sicurezza avanzata e cloud sovrano. Le innovazioni di ottobre 2025 mostrano una convergenza tra infrastruttura, intelligenza artificiale e automazione, delineando un ecosistema in cui ogni livello — dal chip alla governance — è interconnesso.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU...