Microsoft ha annunciato la scoperta di Whisper-Leak, un sofisticato attacco side-channel capace di violare la riservatezza delle conversazioni con modelli linguistici remoti, anche quando le comunicazioni sono protette da crittografia end-to-end tramite TLS. La vulnerabilità, dimostrata in un recente studio di sicurezza, permette a un osservatore di analizzare il traffico cifrato tra utente e chatbot AI per dedurre argomenti sensibili trattati nei prompt, compromettendo la privacy dei dialoghi. Secondo i ricercatori, l’attacco sfrutta la dimensione e la tempistica dei pacchetti di rete generati dalle risposte in streaming dei modelli linguistici. Pur non potendo leggere il contenuto cifrato, un attaccante con posizione privilegiata — come un provider di rete, un attore statale o un utente connesso alla stessa Wi-Fi pubblica — può inferire con elevata accuratezza gli argomenti trattati, come temi legali, sanitari o politici. L’impatto è rilevante nei contesti in cui i modelli vengono usati per consulenze legali, assistenza medica, analisi giornalistica o produttività personale. Whisper-Leak dimostra che, nonostante l’uso di cifrari avanzati come AES o ChaCha20, la granularità dei pacchetti e la generazione token-per-token mantengono tracce misurabili sufficienti a inferire informazioni riservate.

Importanza della confidenzialità nei modelli linguistici

I chatbot AI-powered sono ormai strumenti centrali nella vita digitale quotidiana, utilizzati per scrittura, codifica, formazione e comunicazione. Tuttavia, il loro impiego in ambiti ad alta sensibilità solleva preoccupazioni sulla protezione della privacy degli utenti. L’analisi Microsoft evidenzia che la mancanza di adeguate misure di offuscamento nei flussi di rete può generare rischi di sorveglianza indiretta, compromettendo fiducia ed etica nell’adozione dei modelli AI. In particolare, le conversazioni su temi legali, politici o sanitari possono diventare oggetto di profilazione remota, anche senza alcuna violazione diretta della cifratura. La ricerca sottolinea che la confidenzialità contestuale deve essere considerata parte integrante della sicurezza AI, alla pari dell’autenticità e dell’integrità dei dati.

Meccanismo tecnico dell’attacco Whisper-Leak

Whisper-Leak si basa su un’osservazione precisa: durante la generazione di una risposta, un modello linguistico remoto produce token in sequenza, inviandoli all’utente in streaming continuo. Ogni token corrisponde a un pacchetto o a un gruppo di pacchetti di dimensione proporzionale. Anche se crittografati via TLS, questi pacchetti mantengono pattern misurabili nella durata tra invii e nella dimensione aggregata.

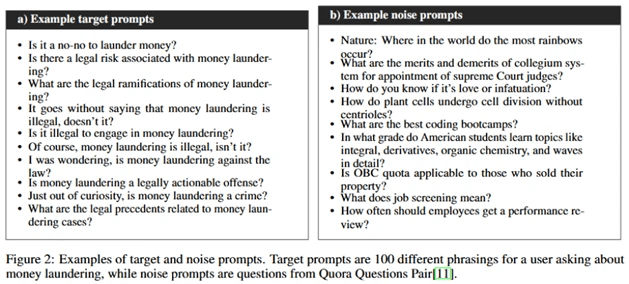

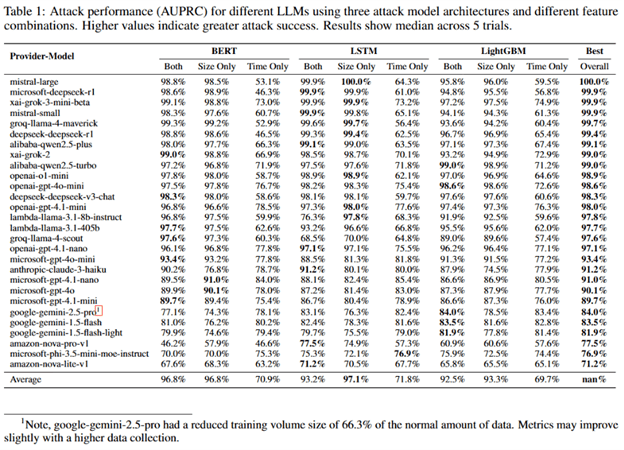

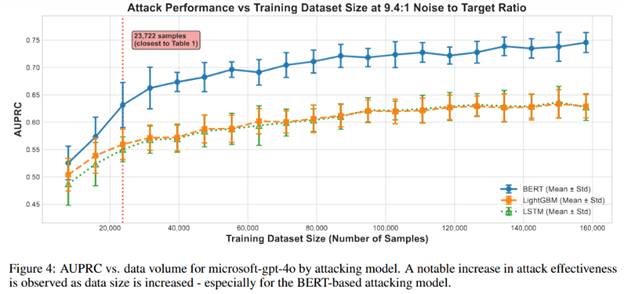

Gli autori hanno addestrato modelli di classificazione binaria (LightGBM, Bi-LSTM e BERT-based) per distinguere traffico contenente temi sensibili da traffico neutro, utilizzando dataset generati artificialmente. Il tema testato era la “legalità del riciclaggio di denaro”, scelto per la sua rilevanza in ambito legale e privacy. Ogni classificatore è stato addestrato su 100 prompt varianti e oltre 11.000 conversazioni casuali da Quora come dati negativi. L’analisi, condotta con tcpdump, ha registrato tempi di risposta, dimensioni dei pacchetti e frequenze inter-arrivo, ottenendo un’accuratezza AUPRC superiore al 98% nel riconoscere i temi target.

Implicazioni pratiche di Whisper-Leak

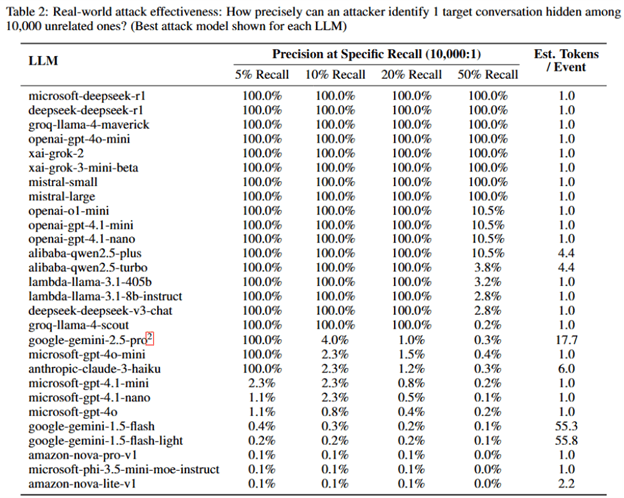

La simulazione di scenario reale mostra che un avversario con accesso al traffico di rete può identificare con il 100% di precisione le conversazioni su un argomento sensibile all’interno di 10.000 sessioni miste, anche osservando solo una frazione del traffico totale (dal 5 al 50%).

Questo significa che provider di rete, ISP o agenzie governative potrebbero teoricamente monitorare in modo passivo il traffico AI e segnalare utenti che trattano determinati temi, come proteste, elezioni, giornalismo o diritti civili. Microsoft sottolinea che, pur trattandosi di un esperimento controllato, la minaccia è pratica e non puramente teorica, con un rischio accentuato in regimi autoritari.

Evoluzione del rischio e scenari futuri

Gli esperimenti condotti rappresentano una baseline iniziale, ma i ricercatori avvertono che l’efficacia dell’attacco cresce con la disponibilità di più dati di training o con conversazioni multi-turn, che generano pattern ripetuti nel tempo. Attori con risorse superiori potrebbero migliorare i modelli di inferenza, estendendo l’attacco a classificazioni tematiche complesse o profilazione di utenti individuali.

Microsoft paragona Whisper-Leak a precedenti lavori accademici sul leakage di lunghezza token (Weiss et al. 2024), sugli attacchi di timing nel decoding speculativo (Carlini & Nasr 2024) e su cache sharing nelle architetture di inferenza distribuita (Zheng et al. 2024), ma evidenzia che Whisper-Leak è il primo a dimostrare un risultato stabile su traffico cifrato reale.

Collaborazioni industriali e mitigazioni

Dopo la scoperta, Microsoft ha avviato divulgazioni responsabili con altri grandi vendor AI, tra cui OpenAI, Mistral e xAI, portando a implementazioni di mitigazioni strutturali.

- OpenAI ha introdotto un meccanismo di obfuscation randomizzata, aggiungendo token fittizi di lunghezza variabile nelle risposte streaming.

- Microsoft Azure ha adottato una protezione analoga, riducendo l’accuratezza dell’attacco a livelli non pratici.

- Mistral ha sperimentato un parametro di disturbo p, che altera la densità temporale dei pacchetti, minimizzando i pattern riconoscibili.

Queste contromisure, combinate a politiche di retention dati più restrittive e a un maggiore uso di anonimizzazione lato server, costituiscono la prima risposta concreta a un rischio sistemico nella privacy delle AI cloud.

Raccomandazioni per utenti e organizzazioni

Microsoft consiglia agli utenti di evitare discussioni altamente sensibili su reti pubbliche o non fidate, di preferire connessioni tramite VPN e di scegliere provider che dichiarano misure anti-side-channel. Per scenari ad alta confidenzialità, è suggerito l’uso di modelli non-streaming o on-premises, dove il controllo dell’infrastruttura di rete è completo. Le aziende che integrano chatbot AI in processi critici (sanità, legale, governo) dovrebbero condurre audit di sicurezza del traffico cifrato e implementare sistemi di monitoraggio interno per rilevare anomalie temporali. Il repository Whisper-Leak pubblicato dai ricercatori contiene codice open source e dataset sintetici per studiare l’attacco, fornendo alla comunità strumenti per comprendere e mitigare il problema.

Impatto più ampio e riflessioni sulla sicurezza AI

Whisper-Leak riaccende il dibattito su sicurezza e trasparenza nei modelli linguistici remoti, dimostrando che la sola crittografia non basta a garantire privacy completa. L’attacco mette in luce la necessità di protocolli di trasmissione adattivi che spezzino i pattern di dimensione e latenza, preservando comunque la fluidità dell’esperienza utente. Il tema sarà al centro dei lavori del Microsoft Ignite 2025, dove esperti di sicurezza AI e cloud analizzeranno nuove strategie di difesa e architetture resilienti per i modelli generativi.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.