La ricerca sull’intelligenza artificiale applicata ai video raggiunge un nuovo traguardo con due innovazioni complementari: il sistema di watermarking invisibile di Meta e il benchmark PEVA sviluppato dall’Università di Berkeley. Entrambe le soluzioni affrontano le sfide cruciali dell’autenticità e della valutazione percettiva nell’era dei contenuti generativi. Meta introduce un sistema scalabile capace di incorporare dati di provenienza invisibili direttamente nei pixel dei video, distinguendo materiali reali da contenuti generati da AI. Parallelamente, PEVA ridefinisce il modo in cui vengono valutati gli aspetti percettivi dei video AI, misurando l’allineamento audio-visivo e la qualità percepita dall’occhio umano. Questi progressi segnano una convergenza tra tracciabilità, sicurezza e qualità, elementi centrali per l’adozione responsabile delle tecnologie generative nei settori mediatico, legale e sanitario.

Panoramica sul watermarking invisibile

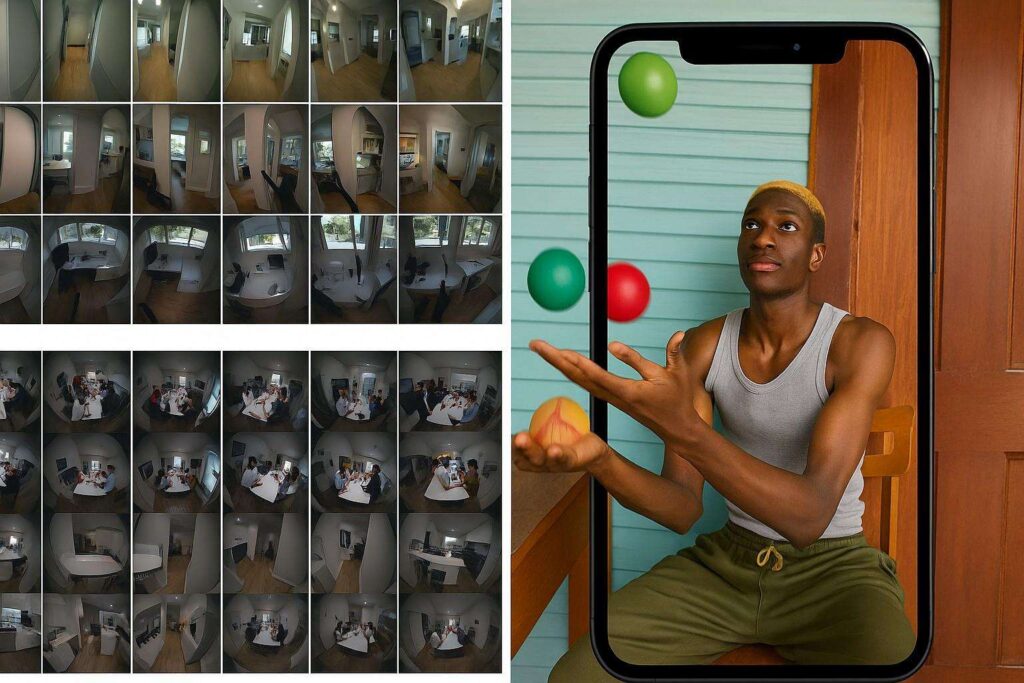

Il watermarking invisibile rappresenta la nuova frontiera per garantire la tracciabilità dei contenuti multimediali. Gli algoritmi sviluppati da Meta permettono di modificare in modo impercettibile i pixel video, le forme d’onda audio o i token testuali, inserendo metadati di autenticità. Questa metodologia consente di identificare i contenuti AI-generated, preservando la qualità visiva. Il sistema, costruito su architettura CPU-based, offre prestazioni equivalenti a soluzioni GPU ma con un’efficienza energetica superiore e costi ridotti.

Meta ha ottimizzato la pipeline di elaborazione per operare su volumi massivi di video, integrando algoritmi che gestiscono milioni di frame giornalieri. L’obiettivo è fornire una soluzione scalabile per piattaforme social, capace di resistere a compressioni, ritagli e altre manipolazioni. I watermark restano riconoscibili anche dopo processi di editing intensivi, assicurando robustezza e persistenza nel tempo.

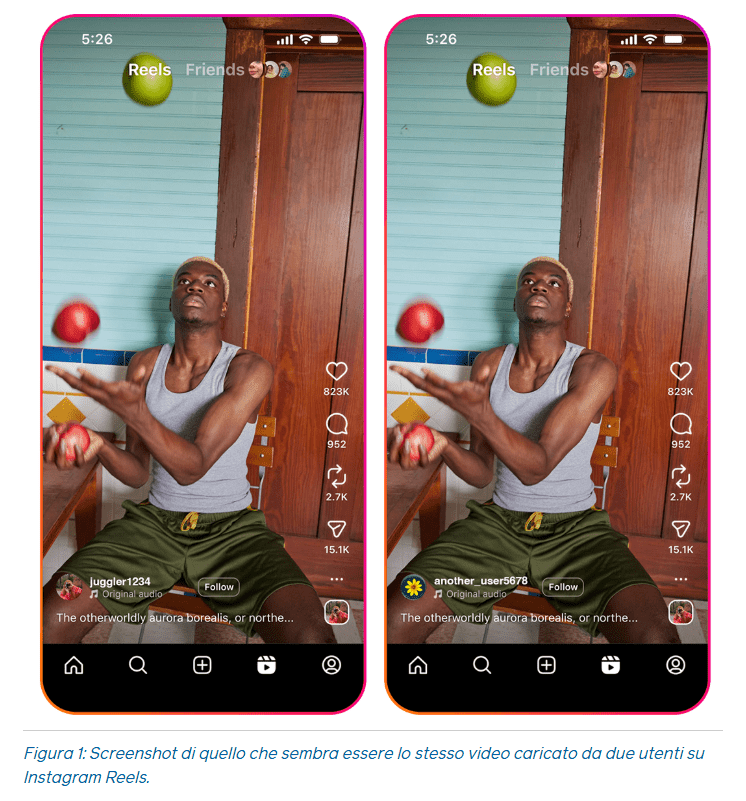

L’applicazione pratica di questo sistema è cruciale nel contrasto a deepfake, manipolazioni video e disinformazione, offrendo ai media e alle istituzioni un metodo affidabile per verificare la provenienza dei contenuti digitali.

Dettagli tecnici della soluzione di Meta

Il sistema ideato da Meta adotta un’architettura completamente CPU-based, in controtendenza rispetto alle soluzioni tradizionali basate su GPU. Questa scelta riduce i costi infrastrutturali e consente una scalabilità lineare senza dipendere da hardware dedicato. L’algoritmo lavora su frame individuali, incorporando dati di autenticità tramite leggere variazioni di intensità dei pixel, impercettibili all’occhio umano ma riconoscibili da un decodificatore dedicato. Meta ha testato la tecnologia su dataset video di grandi dimensioni, valutandone precisione, latenza e consumo energetico. I risultati mostrano che le CPU moderne, grazie all’ottimizzazione per la parallelizzazione, possono eguagliare le prestazioni delle GPU su carichi di lavoro di watermarking, con un risparmio energetico fino al 40%.

Il sistema supporta formati video standard e si integra con pipeline di elaborazione esistenti, permettendo un’adozione immediata in ambienti di produzione e distribuzione. I ricercatori hanno pubblicato benchmark di trasparenza, favorendo la riproducibilità e lo sviluppo open della tecnologia.

Sfide superate nella scalabilità

La principale sfida per Meta era adattare il watermarking invisibile a scala industriale, mantenendo robustezza e qualità visiva. L’azienda ha risolto colli di bottiglia legati a memoria, latenza e throughput, implementando batch processing, caching dinamico e compressione intelligente. Un altro ostacolo era la resistenza agli attacchi avversari, come la rimozione intenzionale del watermark o la ricodifica con filtri distruttivi. Meta ha sviluppato una strategia di ridondanza distribuita, replicando porzioni del watermark su più aree del frame, per assicurare il recupero anche dopo modifiche pesanti. Le ottimizzazioni software permettono di ridurre del 25% il tempo medio di elaborazione per video HD, garantendo la compatibilità con pipeline giornalistiche e di content moderation. La soluzione è già pronta per essere adottata da piattaforme social e agenzie di verifica, rafforzando la fiducia nel contenuto digitale.

Applicazioni e impatti del watermarking video

Il sistema di Meta ha un impatto diretto sulla lotta alla disinformazione visiva. Le piattaforme potranno taggare automaticamente i contenuti generati da intelligenza artificiale, fornendo un’etichetta di provenienza verificabile. In ambito giornalistico, il watermarking invisibile consente di preservare l’integrità dei video d’inchiesta e di garantire la catena di custodia digitale. In campo educativo, può essere usato per certificare l’autenticità di materiali didattici, mentre nel settore legale funge da prova di origine nei procedimenti giudiziari. Inoltre, la tecnologia può essere estesa anche ad audio e testo, offrendo un sistema universale di tracciamento per tutti i formati generativi. Meta mira a promuovere standard industriali condivisi, collaborando con altre aziende per la definizione di protocolli interoperabili che assicurino una verifica universale della provenienza.

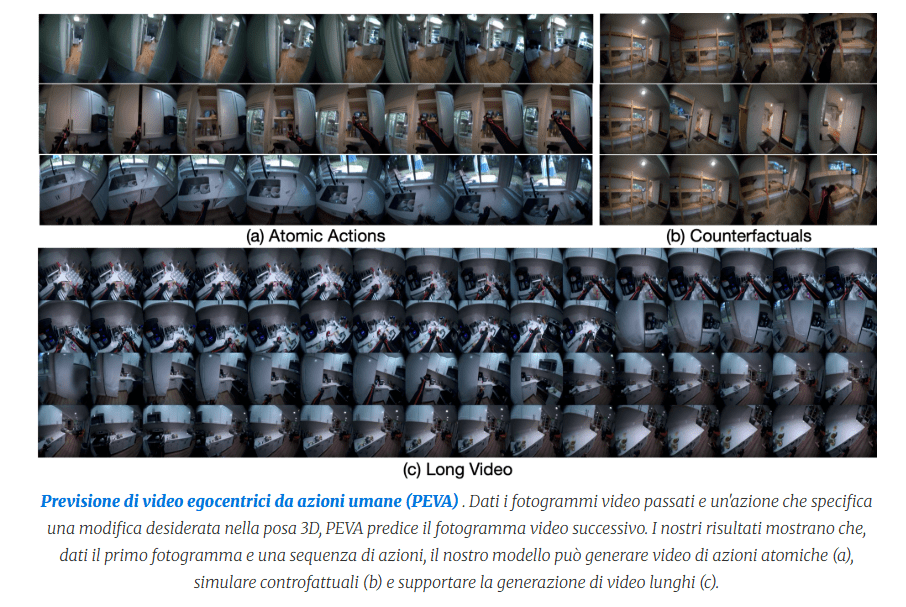

Introduzione a PEVA di Berkeley

L’Università di Berkeley introduce PEVA (Perceptual Evaluation of Video Alignment), un benchmark progettato per misurare la qualità percettiva dei video generati da AI. PEVA analizza l’allineamento tra audio e immagine, un elemento critico nella generazione multimodale. Il progetto nasce per superare i limiti delle metriche tradizionali, spesso incapaci di cogliere errori temporali o incoerenze percettive.

Il team di Berkeley ha sviluppato un dataset diversificato, contenente esempi reali di disallineamento controllato, con l’obiettivo di addestrare e valutare modelli video più coerenti. Il benchmark fornisce punteggi basati su metriche psicovisive, simulate da osservazioni umane, e integra strumenti di analisi automatica compatibili con framework di machine learning.

Funzionalità e struttura del benchmark PEVA

PEVA è progettato per essere scalabile e standardizzato. Comprende dataset annotati manualmente, metriche percettive come il Sync Error Index (SEI) e moduli di scoring qualitativo basati su studi di percezione. I ricercatori di Berkeley hanno integrato PEVA con framework diffusi, consentendo il confronto diretto tra modelli di generazione video. Le metriche valutano coerenza temporale, sincronizzazione labiale e congruenza semantica tra audio e immagine.

La validazione è stata condotta tramite studi soggettivi, confermando una correlazione del 92% tra il punteggio PEVA e la valutazione umana. Questa accuratezza lo rende un benchmark di riferimento per la ricerca multimodale, accelerando l’innovazione nei modelli video AI.

Impatto di PEVA sulla ricerca AI

PEVA sta già influenzando la ricerca internazionale, fungendo da standard comparativo per modelli video multimodali. I laboratori di ricerca lo utilizzano per testare nuovi modelli generativi e migliorare la coerenza percettiva dei risultati.

La capacità di quantificare differenze sottili in sincronia e realismo audiovisivo consente di identificare le debolezze algoritmiche in modo più rapido e mirato. Berkeley promuove anche collaborazioni industriali per adattare PEVA a casi d’uso concreti, come la produzione cinematografica automatizzata, la telemedicina e la formazione immersiva.Il benchmark incoraggia inoltre la creazione di modelli etici e trasparenti, riducendo il rischio di distorsioni percettive e falsificazioni realistiche.

Connessioni tra watermarking e valutazione percettuale

L’unione delle tecnologie sviluppate da Meta e Berkeley rappresenta un’evoluzione fondamentale nella gestione dei contenuti video generativi. Il watermarking invisibile può essere utilizzato per identificare e tracciare i contenuti valutati con PEVA, creando un ecosistema integrato di autenticazione e misurazione della qualità. Meta, ad esempio, esplora l’integrazione di metriche percettive nel proprio sistema di watermarking, mentre Berkeley prevede di testare PEVA su video contrassegnati da watermark per studiare correlazioni tra autenticità e qualità percepita. Questa sinergia apre la strada a standard comuni per la certificazione dei contenuti AI, migliorando trasparenza, fiducia e responsabilità nel panorama digitale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.