Google Cloud annuncia una nuova ondata di innovazioni che spaziano dall’intelligenza artificiale alla resilienza di rete e alla sicurezza cloud. Al centro dei recenti sviluppi si trovano Protective ReRoute, il meccanismo che aumenta la tolleranza ai guasti nelle reti distribuite, e una serie di avanzamenti in AI e analytics che rafforzano la posizione di Google nel panorama tecnologico globale. Durante la conferenza SC25 a St. Louis, l’azienda presenta nuove VM ad alte prestazioni basate su processori AMD e GPU NVIDIA, mentre nel campo della sicurezza introduce il programma Google Unified Security Recommended con partner strategici come CrowdStrike e Fortinet. Le innovazioni si estendono anche a BigQuery ML, Gemini, Memorystore, e alle piattaforme per AI agentica e analytics conversazionale.

Innovazioni nella resilienza di rete

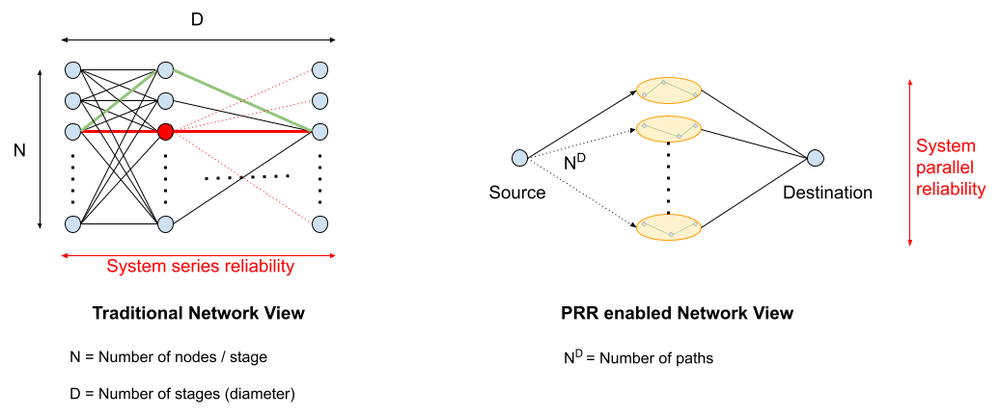

La tecnologia Protective ReRoute segna un punto di svolta nella gestione della connettività cloud. Google Cloud ha sviluppato questo sistema per spostare il recupero dai guasti dal nucleo centralizzato agli endpoint distribuiti, garantendo una risposta in tempi inferiori a un multiplo singolo del round-trip della rete. Gli host monitorano costantemente la salute dei percorsi tramite timeout TCP e, in caso di fallimento, modificano dinamicamente gli header IPv6 o i metadati in overlay per deviare il traffico su rotte sane.

Questo approccio decentralizzato riduce fino all’84% i downtime causati da lente convergenze, prevenendo la maggior parte delle interruzioni legate a router o switch difettosi. Protective ReRoute, integrato nel kernel Linux dalla versione 4.20, è operativo da oltre cinque anni in produzione nei data center globali di Google. In modalità hypervisor, protegge il traffico tra data center senza interventi sul sistema guest, mentre in modalità guest offre tempi di recupero minimi per applicazioni sensibili. Il sistema si dimostra essenziale per applicazioni AI, ML e real-time, garantendo trasferimenti di dati continui, riduzione delle perdite di pacchetti e stabilità nei servizi a bassa latenza come gaming e videoconferenze. L’adozione su larga scala evidenzia come l’infrastruttura Google Cloud stia evolvendo verso un modello di autonomia resiliente, capace di rispondere a guasti hardware o software senza dipendere da meccanismi di routing centralizzati.

Accelerare innovazione e HPC a SC25

Dal 16 al 21 novembre 2025, durante la conferenza Supercomputing 25 (SC25), Google Cloud ha presentato le proprie soluzioni di High Performance Computing e AI avanzata. Le nuove VM H4D, basate su processori AMD EPYC di quinta generazione, e le VM A4X e A4X Max, con GPU NVIDIA di ultima generazione, ridefiniscono la potenza computazionale per il calcolo scientifico e industriale. Le infrastrutture HPC cloud-native permettono la creazione di cluster elastici in pochi minuti, applicabili a discipline come fluidodinamica computazionale, chimica molecolare, modellazione dei rischi finanziari e ingegneria assistita. Grazie al supporto RDMA e a strumenti come Cluster Toolkit e Dynamic Workload Scheduler, la gestione dei carichi diventa più efficiente e flessibile. Google ha inoltre potenziato lo storage ad alte prestazioni con Managed Lustre, mentre partnership strategiche con NVIDIA e AMD assicurano ottimizzazione hardware e sinergia tra CPU, GPU e TPU di settima generazione “Ironwood”. Tecnologie come Gemini Code Assist, AlphaFold 3 e Weather Next dimostrano come AI e HPC convergano per accelerare ricerca scientifica, simulazioni climatiche e scoperta di nuovi materiali.

Soluzioni analytics e machine learning con BigQuery ML

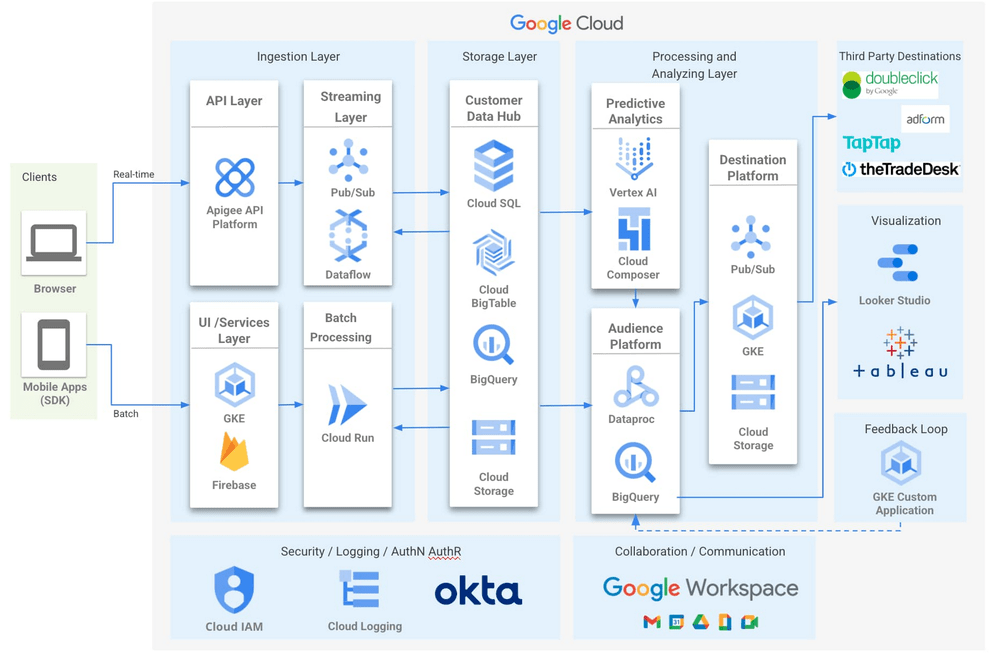

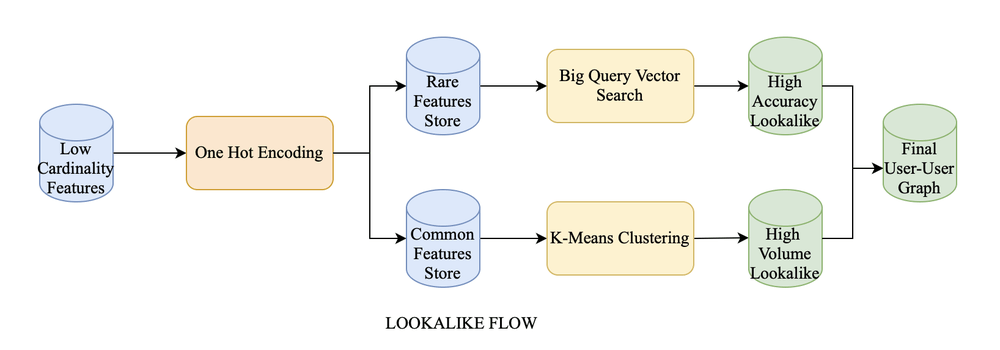

Nel campo dell’analisi dei dati, BigQuery ML mostra la propria capacità di risolvere casi d’uso complessi come la costruzione di audience lookalike per la piattaforma Zeotap. Utilizzando metriche come la somiglianza Jaccard e gli embedding vettoriali, il sistema identifica utenti con caratteristiche simili ai clienti di alto valore, migliorando targeting e conversioni.

BigQuery ML automatizza l’intero processo di addestramento e predizione tramite SQL unificato, riducendo la necessità di pipeline esterne. L’uso di BigQuery Vector Search e di indici TREE_AH basati su ScaNN consente ricerche nearest-neighbor ad alte prestazioni. Il risultato è un modello scalabile, conforme alle norme sulla privacy, che riduce i costi di acquisizione clienti e migliora la personalizzazione delle campagne.

Questa combinazione di machine learning nativo e ricerca vettoriale posiziona BigQuery come una piattaforma chiave per l’analisi predittiva e l’AI generativa in contesti enterprise, integrando elaborazione massiva e intelligenza contestuale.

Gemini e comprensione avanzata dei database

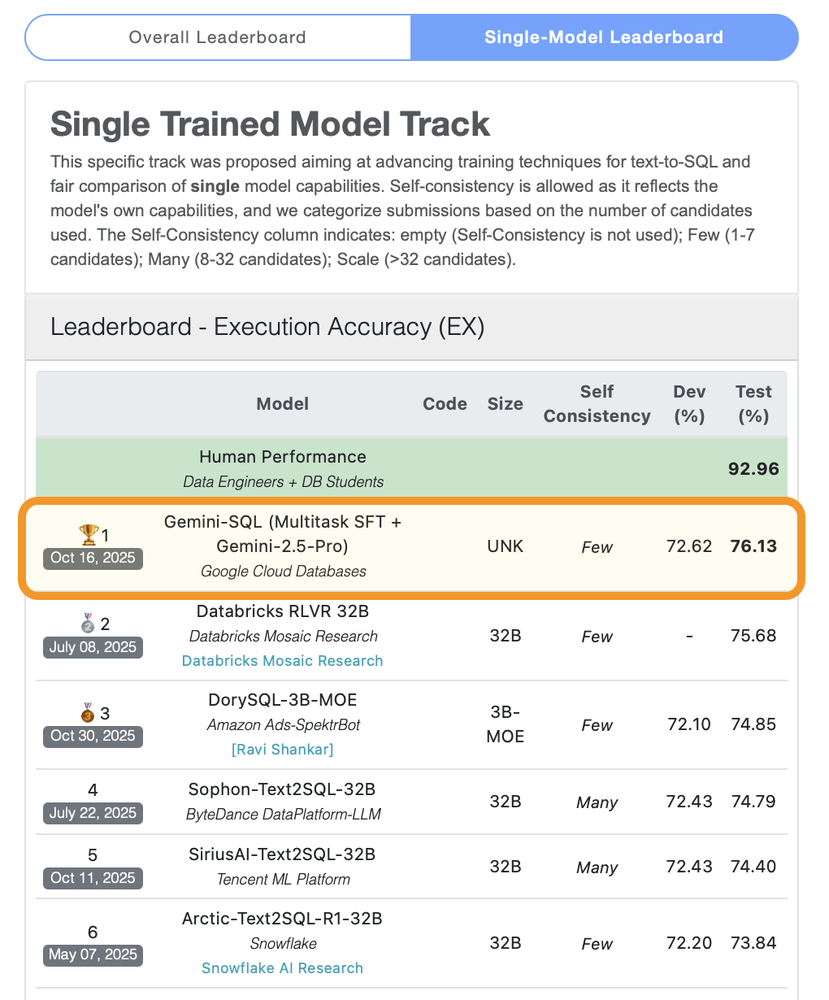

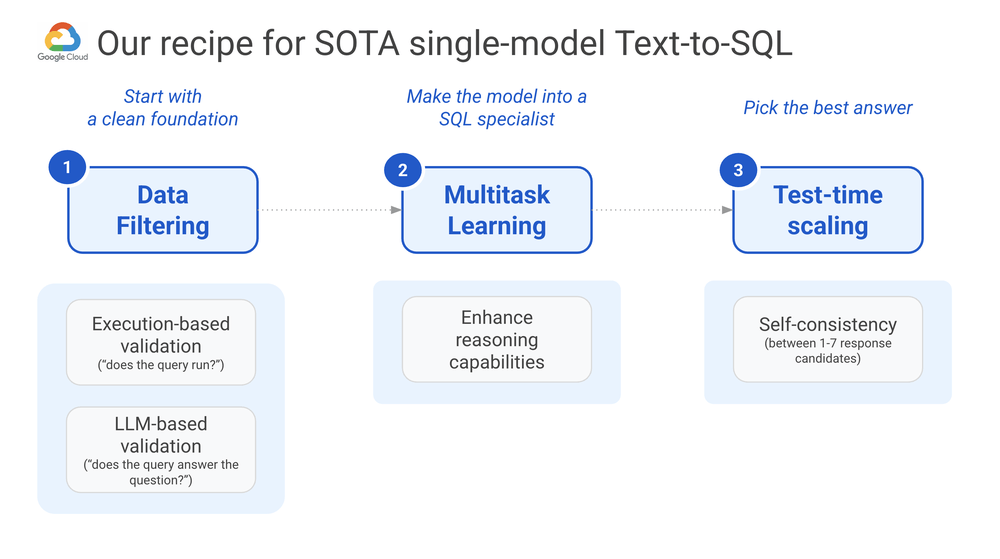

Il modello Gemini 2.5-pro estende le sue capacità di ragionamento e comprensione semantica attraverso pipeline di apprendimento multitask. I dataset vengono filtrati in due fasi: una validazione sintattica delle query SQL e una validazione semantica supervisionata da LLM. Questa metodologia assicura che i modelli apprendano query corrette e coerenti con le domande naturali.

Grazie al Supervised Tuning su Vertex AI, Gemini acquisisce la capacità di generare query accurate per sistemi come Spanner, AlloyDB e Cloud SQL Studio, raggiungendo un’accuratezza text-to-SQL del 76% sul benchmark BIRD. Con l’integrazione di AlloyDB AI, gli utenti possono eseguire query in linguaggio naturale su dati operativi, mentre BigQuery estende l’analisi conversazionale per team non tecnici. L’obiettivo è rendere l’interazione con i database più intuitiva e autonoma, riducendo il divario tra esperti di dati e stakeholder aziendali.

Memorystore ottimizza il traffico di Waze

Nel settore infrastrutturale, Waze adotta Memorystore per Redis Cluster per gestire fino a 1 milione di operazioni al secondo con latenza sub-millisecondo. Il nuovo Session Server centralizzato sostituisce l’architettura monolitica precedente, fungendo da fonte unica di verità per le sessioni utente. La migrazione da Memcached a Memorystore, effettuata con una strategia di dual-write e cutover senza downtime, ha migliorato la disponibilità dal 99,9% al 99,99%. L’uso di replica integrata e failover automatico elimina i colli di bottiglia e garantisce continuità durante la manutenzione. Le ottimizzazioni nei tipi di dati Redis e negli aggiornamenti parziali riducono la larghezza di banda e accelerano le scritture, migliorando la gestione di oggetti complessi. Questa architettura flessibile consente a Waze di mantenere un’esperienza di traffico in tempo reale anche in presenza di picchi globali di utilizzo.

Agent Factory e modelli open-source per AI agentica

Con Agent Factory, Google Cloud esplora la costruzione di sistemi multi-agente open-source. Questi agenti, addestrati tramite pipeline supervisionate e reinforcement learning, interagiscono con le interfacce dei computer in modo autonomo, eseguendo operazioni complesse come click, input o compilazione di form. Il framework Agent Development Kit consente alle startup di creare agenti personalizzati, orchestrati da un LLM root agent e moduli deterministici come LoopAgent. La pipeline di deployment, basata su Vertex AI Agent Engine, consente di passare da prototipi locali a sistemi scalabili in produzione, mantenendo isolamento del contesto e controllo dei permessi. Questa architettura modulare apre la strada a agenti AI multi-funzione, capaci di cooperare e di apprendere in ambienti dinamici, con potenziali applicazioni in CRM, analisi vendite e automazione decisionale.

Looker Conversational Analytics e AI per la business intelligence

La disponibilità generale di Looker Conversational Analytics segna un passo avanti nella business intelligence generativa. Gli utenti possono porre domande in linguaggio naturale, esplorare fino a cinque set di dati Looker Explores e ricevere risposte spiegate in modo trasparente grazie all’integrazione di Gemini per il ragionamento contestuale. Le conversazioni multi-turn permettono analisi iterative e self-service, riducendo la dipendenza dai data analyst. Le imprese beneficiano di decisioni più rapide, centralizzazione delle metriche e maggiore trasparenza nei processi analitici.

Programma Google Unified Security Recommended

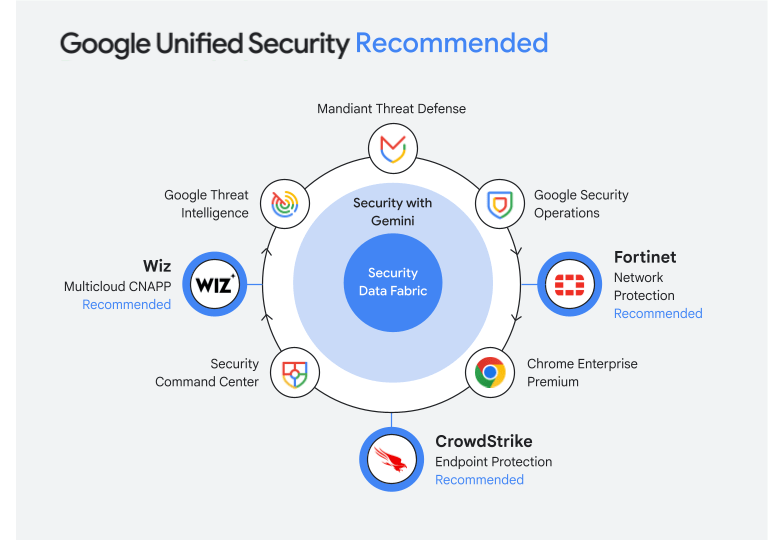

Sul fronte della sicurezza, Google lancia il programma Google Unified Security Recommended per unificare la protezione cloud e AI-powered. I partner iniziali includono CrowdStrike, che integra la piattaforma Falcon con Google Security Operations, e Fortinet, che combina la sua Security Fabric con i sistemi di Google per una visibilità unificata.

Altri partner come Wiz portano la propria piattaforma CNAPP multicloud nel Security Command Center, offrendo copertura su identità, endpoint e cloud. Il programma semplifica il procurement su Google Cloud Marketplace, riducendo la complessità di integrazione e garantendo interoperabilità tra strumenti convalidati. L’iniziativa rappresenta un passo verso un ecosistema di sicurezza collaborativo, dove AI, threat intelligence e partnership industriali si combinano per rispondere alle minacce emergenti in tempo reale.

Espansione AI e threat intelligence avanzata

Google Cloud amplia anche il supporto per gli sviluppatori AI attraverso Hugging Face, accelerando download di modelli grazie a un gateway cache ottimizzato. I modelli open-source ora supportano TPU nativamente su Vertex AI, con scansione di sicurezza enterprise tramite Mandiant e Threat Intelligence. Quest’ultima introduce time travel debugging per analizzare attacchi .NET con hollowing di processi legittimi. La tecnologia registra trace di esecuzione, permettendo di riprodurre eventi avanti e indietro e individuare comportamenti malevoli in modo deterministico. Questo approccio consente analisi forense più rapide e accurate, rafforzando le capacità difensive dell’intera piattaforma cloud.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.