Chip AI e inferenza avanzata sono diventati il vero terreno di scontro tra Intel, Microsoft e l’ecosistema cinese rappresentato da Iluvatar CoreX, in una fase in cui il dominio di Nvidia non è più dato per scontato. Le nuove architetture non puntano solo a più potenza bruta, ma a efficienza energetica, latenza ridotta, integrazione verticale e sovranità tecnologica. In parallelo, la sospensione dei negoziati tra SoftBank e Switch e l’emergere di transistor ottici sviluppati da Neurophos mostrano come la competizione sull’hardware AI stia toccando infrastrutture, regolazione e persino i limiti fisici del silicio.

Cosa leggere

Il processore ibrido AI di Intel e la scommessa sull’inferenza on-prem

Intel ha inserito nella propria roadmap AI un processore ibrido ancora non nominato ufficialmente, posizionato accanto a Crescent Island e Jaguar Shores. La scelta architetturale è netta: combinare CPU x86, acceleratore AI dedicato e logica programmabile, probabilmente derivata da IP Xe GPU o Altera. Questo approccio rompe con la tendenza dominante verso acceleratori puri e mira a un segmento che Nvidia e AMD stanno progressivamente trascurando.

Il target sono workload di inferenza AI on-prem, sensibili alla latenza e caratterizzati da carichi bursty, batch ridotti e forte dipendenza dal controllo di flusso. Sistemi di raccomandazione in tempo reale, rilevamento frodi, AI agentica e applicazioni di AI fisica soffrono spesso l’overhead di sincronizzazione delle GPU tradizionali, che risultano sottoutilizzate. In questo contesto, il processore ibrido Intel promette efficienza superiore per watt e maggiore adattabilità.

Crescent Island, basato su architettura Xe3P con 160 GB di LPDDR5X, copre l’inferenza server-side, mentre Jaguar Shores, previsto per il 2027 con HBM4, estenderà il perimetro anche al training. Il nuovo chip ibrido si colloca tra questi due estremi, sfruttando oneAPI come elemento chiave di differenziazione software. Il rischio, per Intel, non è tanto hardware quanto maturità dello stack: il successo dipenderà dalla capacità di rendere realmente semplice l’orchestrazione eterogenea CPU-AI-FPGA.

La roadmap GPU di Iluvatar CoreX e la sfida cinese a Nvidia Rubin

Sul fronte cinese, Iluvatar CoreX ha presentato una roadmap GPU aggressiva articolata in quattro generazioni: Tianshu, Tianxuan, Tianji e Tianquan. L’obiettivo dichiarato è superare Nvidia Rubin entro il 2027, una presa di posizione che va letta nel contesto delle restrizioni occidentali sull’export e della strategia di autonomia tecnologica di Pechino.

Secondo l’azienda, Tianshu raggiunge prestazioni comparabili a Hopper, mentre Tianxuan si colloca sul livello di Blackwell. Tianji, previsto nel 2025, promette di superare Blackwell, mentre Tianquan dovrebbe eccedere Rubin con un redesign architetturale completo. Le informazioni su nodi produttivi e specifiche dettagliate restano limitate, ma il messaggio è politico oltre che tecnologico: la Cina non intende più inseguire, ma competere frontalmente.

Questa roadmap rafforza la filiera domestica cinese, riducendo la dipendenza da GPU statunitensi e incidendo potenzialmente sui prezzi globali e sulla supply chain. Anche se le dichiarazioni di superiorità vanno verificate sul campo, la sola esistenza di alternative credibili erode il quasi-monopolio di Nvidia e costringe il mercato a confrontarsi con una competizione multipolare.

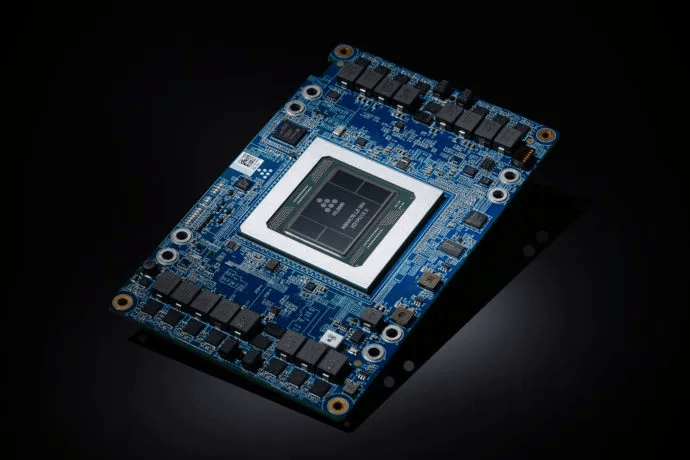

Microsoft Maia 200 e l’hardware AI proprietario per Azure

Microsoft ha compiuto un altro passo decisivo con Maia 200, acceleratore AI interno che succede a Maia 100 e consolida la strategia di chip bespoke per il cloud. Realizzato sul nodo N3P di TSMC, Maia 200 integra 216 GB di HBM3e con una banda di 7 TB/s e 272 MB di SRAM, organizzata in cluster e tile per ottimizzare la distribuzione dei workload.

Le prestazioni dichiarate parlano di 10,14 petaFLOPS in FP4 e 5,072 petaFLOPS in FP8, superando Trainium3 di Amazon e avvicinandosi a Blackwell B300 Ultra di Nvidia, con un TDP di 750 W, sensibilmente inferiore a quello dei rivali. Microsoft rivendica un miglioramento del 30% nel performance per dollaro rispetto a Maia 100, focalizzandosi sull’inferenza più che sul training.

| Specifiche Tecniche | Azure Maia 200 | AWS Trainium3 | Nvidia Blackwell B300 Ultra |

|---|---|---|---|

| Processo Produttivo | N3P (3nm) | N3P (3nm) | 4NP (4nm) |

| Prestazioni FP4 (PetaFLOPS) | 10.14 | 2.517 | 15.0 |

| Prestazioni FP8 (PetaFLOPS) | 5.072 | 2.517 | 5.0 |

| Prestazioni BF16 (PetaFLOPS) | 1.268 | 0.671 | 2.5 |

| Memoria HBM3e | 216 GB | 144 GB | 288 GB |

| Larghezza di Banda Memoria | 7 TB/s | 4.9 TB/s | 8 TB/s |

| Interconnessione (Bi-directional) | 2.8 TB/s | 2.56 TB/s | 1.8 TB/s |

| TDP (Consumo) | 750 W | N/D | 1400 W |

Confronto tra i giganti dell’hardware AI: Nvidia B300 Ultra domina per memoria (288GB) e potenza di calcolo grezza (FP4), mentre Microsoft Azure Maia 200 sorprende per l’altissima velocità di interconnessione e l’efficienza in FP8.

Maia 200 è già integrato in Azure, inizialmente nella regione US Central e in espansione verso US West 3 a Phoenix. La scelta di puntare su FP4 e FP8 riflette un’attenzione crescente all’efficienza energetica e alla sostenibilità, temi centrali per ottenere consenso sociale e regolatorio sull’espansione dei data center AI. Con Maia 200, Microsoft riduce la dipendenza da fornitori esterni e rafforza il controllo sull’intera catena hardware-software.

SoftBank, Switch e il nodo delle infrastrutture AI

In questo scenario si inserisce la decisione di SoftBank di sospendere i negoziati per l’acquisizione di Switch, operatore di data center hyperscale, per un valore stimato di 45,85 miliardi di euro. L’operazione era strategica per il progetto Stargate di OpenAI, che mira a realizzare 10 gigawatt di infrastruttura AI negli Stati Uniti entro il 2029.

La pausa è motivata da complessità operative, dubbi sul prezzo e soprattutto dallo scrutinio regolatorio sugli investimenti esteri in infrastrutture critiche USA. Switch punta ora a una IPO con valutazioni fino a 55 miliardi di euro, mentre SoftBank opta per partnership e acquisizioni indirette, come quella di DigitalBridge. Il risultato è una minore integrazione verticale e una maggiore dipendenza da operatori terzi in un momento in cui la capacità energetica è il vero collo di bottiglia dell’AI.

Neurophos e i transistor ottici: oltre il silicio

Sul fronte più radicale dell’innovazione, la startup Neurophos, supportata dal Gates Frontier Fund di Bill Gates, sta sviluppando transistor ottici e unità di processamento fotonico che promettono di rivitalizzare la legge di Moore. La sua OPU utilizza un sensore fotonico 1000×1000, dieci volte più grande delle matrici tipiche delle GPU AI, e transistor ottici 10.000 volte più piccoli rispetto alle controparti fotoniche tradizionali.

L’acceleratore Tulkas T100, grande 25 mm², opera a 56 GHz ed è progettato per moltiplicazioni matriciali massive, fondamentali per l’inferenza AI. Neurophos sostiene di raggiungere prestazioni fino a dieci volte superiori a NVL72 Vera Rubin di Nvidia in FP4/INT4 a parità di consumo energetico, anche se con precisione limitata, più adatta a immagini, video e segnali.

Se confermate, queste tecnologie potrebbero superare i limiti fisici dell’elettronica tradizionale, aprendo una nuova fase per il computing AI ad alta efficienza. La fotonica al silicio diventa così non solo una curiosità di laboratorio, ma una possibile alternativa strategica nel medio termine.

Implicazioni per data center e AI agentica

L’insieme di queste innovazioni indica un cambio di paradigma. Il futuro dei chip AI non sarà dominato da un’unica architettura, ma da un ecosistema eterogeneo in cui processori ibridi, GPU sovrane, acceleratori cloud-specifici e soluzioni fotoniche convivono. Le imprese ottengono maggiore flessibilità, riducono la dipendenza da un singolo fornitore e possono adattare l’hardware a modelli AI in continua evoluzione.

Per Nvidia, la sfida non è solo tecnica, ma strategica: difendere il proprio vantaggio in un mondo in cui inferenza distribuita, efficienza energetica e sovranità tecnologica contano quanto i petaFLOPS. La competizione sui chip AI è ormai una competizione su infrastrutture, geopolitica e sostenibilità, e i prossimi due anni saranno decisivi.

Domande frequenti sui nuovi chip AI

Perché Intel punta su un processore ibrido invece che su una GPU pura?

Perché molti workload di inferenza on-prem sono sensibili alla latenza e non sfruttano appieno le GPU tradizionali. Un design ibrido consente maggiore efficienza e flessibilità su carichi piccoli e dinamici.

La roadmap di Iluvatar CoreX è credibile rispetto a Nvidia?

Le dichiarazioni vanno verificate, ma la roadmap indica una forte volontà di colmare il gap tecnologico. Anche senza superare Rubin, la sola presenza di alternative domestiche riduce la dipendenza cinese da Nvidia.

Maia 200 sostituirà le GPU Nvidia in Azure?

Non completamente. Microsoft userà Maia 200 in configurazioni eterogenee, affiancandolo alle GPU Nvidia per ottimizzare costi, consumi e prestazioni su specifici workload.

I transistor ottici di Neurophos sono pronti per il mercato?

Sono ancora in fase di sviluppo, ma mostrano potenziale per superare i limiti del silicio tradizionale. Se scalabili industrialmente, potrebbero cambiare radicalmente il computing AI nei prossimi anni.

Iscriviti a Matrice Digitale

Ricevi le notizie principali direttamente nella tua casella di posta.

Niente spam, disiscriviti quando vuoi.