Sommario

Le tecnologie emergenti continuano a rappresentare un terreno fertile per attacchi informatici sempre più sofisticati. Due eventi recenti hanno sollevato allarmi significativi nella comunità della cybersecurity: il primo riguarda un modello di intelligenza artificiale infetto, ospitato sulla piattaforma Hugging Face, mentre il secondo svela gravi vulnerabilità di sicurezza e privacy nell’app mobile DeepSeek per iOS. Questi episodi non solo dimostrano quanto il settore AI e mobile sia esposto a nuove minacce, ma pongono anche interrogativi cruciali sulla sicurezza dei dati e sull’affidabilità delle piattaforme che li ospitano.

Hugging Face e la minaccia del malware nei modelli AI

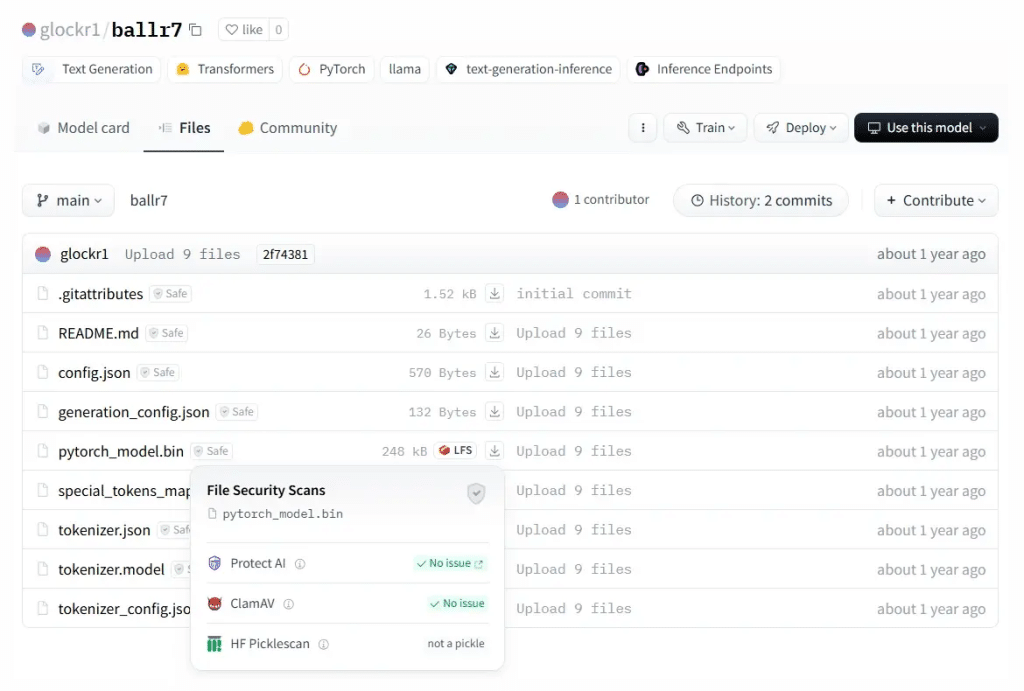

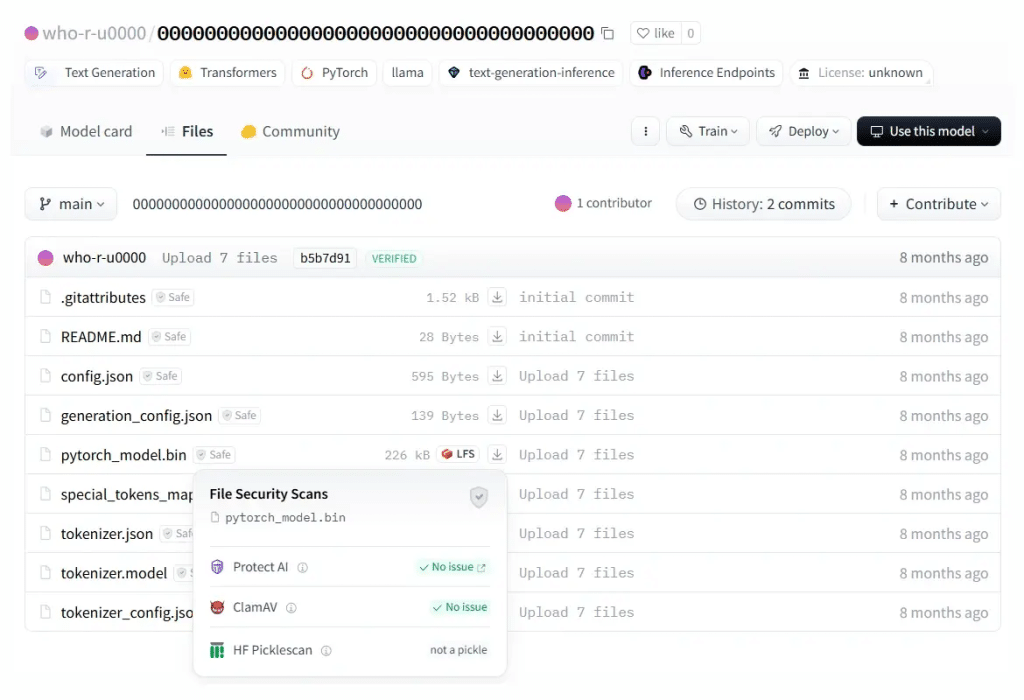

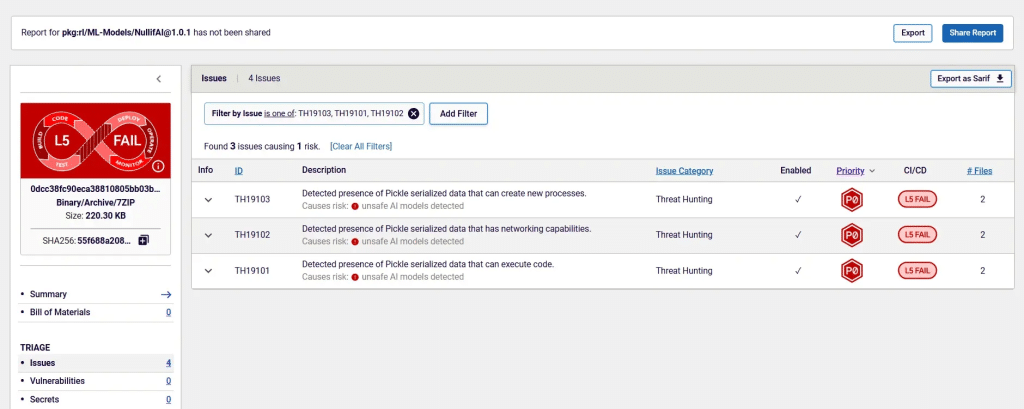

La scoperta fatta dai ricercatori di ReversingLabs ha aperto un nuovo capitolo nella sicurezza dell’intelligenza artificiale: l’infiltrazione di malware all’interno di un modello di machine learning pubblicato su Hugging Face, una delle piattaforme più utilizzate per la condivisione di modelli AI. L’infezione non era immediatamente rilevabile, poiché il codice malevolo era stato nascosto all’interno dei file del modello, pronto a eseguire operazioni non autorizzate non appena integrato in un ambiente di sviluppo.

Questo attacco evidenzia una strategia sofisticata da parte degli attori malevoli: non più solo exploit diretti, ma infezioni che si annidano nel cuore dello sviluppo software, mirando a sviluppatori e aziende che utilizzano modelli AI per i loro progetti. Una volta eseguito, il codice dannoso instaurava connessioni con server di comando e controllo (C2), esfiltrando dati sensibili dai sistemi compromessi e potenzialmente fornendo agli attaccanti un accesso persistente alle infrastrutture colpite.

L’elemento più preoccupante di questa vicenda è la fiducia riposta nelle piattaforme di condivisione di modelli AI, spesso considerate sicure a priori. Il caso Hugging Face dimostra invece che gli attacchi alla supply chain del machine learning sono una minaccia reale e crescente, soprattutto perché i modelli vengono spesso scaricati e integrati senza un’analisi approfondita della loro sicurezza.

Per proteggersi da questo tipo di attacco, gli esperti di sicurezza raccomandano l’adozione di analisi statiche e dinamiche sui modelli AI prima della loro implementazione, verificando l’integrità del codice e monitorando eventuali comportamenti anomali durante l’esecuzione. Tuttavia, il problema resta strutturale: finché non verranno adottate rigorose procedure di auditing e certificazione dei modelli, il rischio che piattaforme come Hugging Face diventino veicoli di infezioni su larga scala rimarrà elevato.

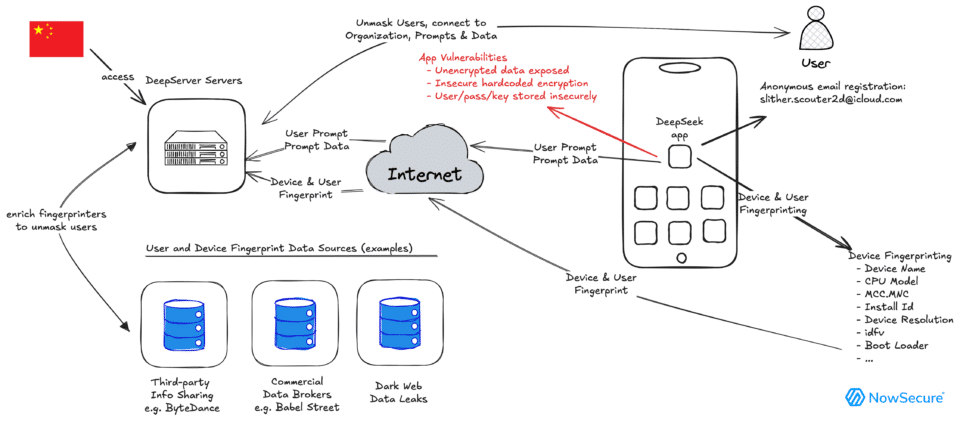

DeepSeek: l’app AI che espone i dati degli utenti

Se il caso Hugging Face ha sollevato allarmi nel settore dello sviluppo AI, l’analisi condotta da NowSecure su DeepSeek dimostra che anche le applicazioni mobili più avanzate possono rivelarsi un pericolo per la sicurezza e la privacy degli utenti. DeepSeek, un’app di intelligenza artificiale per iOS che ha rapidamente scalato le classifiche dell’App Store, si è rivelata gravemente vulnerabile a intercettazioni di dati e accessi non autorizzati.

Secondo gli esperti di sicurezza, l’app presenta una serie di criticità che la rendono un bersaglio ideale per attacchi man-in-the-middle e furti di dati. Il problema più grave è la trasmissione di informazioni in chiaro, senza alcun livello di crittografia, rendendo possibile il monitoraggio del traffico da parte di terze parti malevole. In altre parole, chiunque si connetta alla stessa rete Wi-Fi di un dispositivo con DeepSeek installata potrebbe intercettare le comunicazioni dell’applicazione e accedere ai dati degli utenti.

Un’altra scoperta preoccupante riguarda l’uso di chiavi di crittografia hardcoded, un errore comune ma estremamente rischioso nel design delle app. La presenza di chiavi statiche all’interno del codice significa che chiunque sia in grado di decompilare l’app può recuperare le credenziali e utilizzarle per accedere ai server dell’applicazione, con conseguenze imprevedibili per la sicurezza degli utenti.

A rendere la questione ancora più delicata è l’invio dei dati verso server situati in Cina, il che solleva interrogativi sulle normative a cui tali informazioni sono soggette. La possibilità che i dati degli utenti vengano archiviati in infrastrutture regolamentate da leggi di sorveglianza poco trasparenti ha spinto diversi esperti a consigliare l’immediata rimozione dell’app dai dispositivi aziendali e governativi.

In risposta alle segnalazioni, gli sviluppatori di DeepSeek non hanno ancora rilasciato una patch definitiva, lasciando milioni di utenti esposti ai rischi identificati. Questo episodio dimostra ancora una volta che il successo di un’app AI non è sinonimo di sicurezza, e che molte aziende danno priorità alla crescita e alla monetizzazione piuttosto che alla protezione dei dati degli utenti.

Lezioni da apprendere: il futuro della sicurezza AI e mobile

Questi due casi rivelano un panorama sempre più complesso nella cybersecurity. Il fatto che sia i modelli di intelligenza artificiale sia le applicazioni mobili possano diventare vettori di attacco dovrebbe spingere aziende e sviluppatori ad adottare strategie di verifica più rigorose e protocolli di sicurezza più stringenti.

Nel caso di Hugging Face, è chiaro che le piattaforme di condivisione AI non possono più essere considerate affidabili senza verifica. Servono controlli di sicurezza automatizzati e revisioni indipendenti per garantire che i modelli pubblicati non contengano codice dannoso.

D’altra parte, il caso DeepSeek dimostra quanto sia ancora fragile la sicurezza delle applicazioni mobili, soprattutto quando si tratta di app che gestiscono dati personali e conversazioni utente su larga scala. La mancanza di crittografia e la trasmissione di informazioni a server non regolamentati dovrebbero essere un campanello d’allarme per chiunque utilizzi strumenti di AI mobile senza considerare le implicazioni sulla privacy.

Se questi problemi non verranno affrontati con un cambio di paradigma nel settore della cybersecurity, il rischio è che le nuove tecnologie AI e mobile diventino il prossimo grande vettore di attacco per gruppi criminali e governi ostili.