L’intelligenza artificiale sta diventando sempre più centrale nelle dinamiche globali, ma il suo utilizzo improprio rappresenta una minaccia crescente. OpenAI, leader nel settore, ha pubblicato un nuovo rapporto in cui mette in evidenza i tentativi di attori statali e gruppi criminali di sfruttare i modelli AI per attività dannose. Dalla sorveglianza politica alla manipolazione dell’informazione, dalle truffe finanziarie agli attacchi informatici, il documento illustra una serie di operazioni interrotte e le strategie adottate per proteggere l’ecosistema digitale.

Il report fa luce su attività provenienti da Cina, Iran, Corea del Nord e gruppi cybercriminali, dimostrando come le AI siano sempre più utilizzate per influenzare l’opinione pubblica, compromettere aziende e aggirare i sistemi di sicurezza online.

Cosa leggere

L’AI come strumento di sorveglianza e propaganda

Una delle minacce più preoccupanti identificate da OpenAI riguarda l’uso dell’intelligenza artificiale per attività di sorveglianza e disinformazione. Il report analizza due casi particolarmente rilevanti:

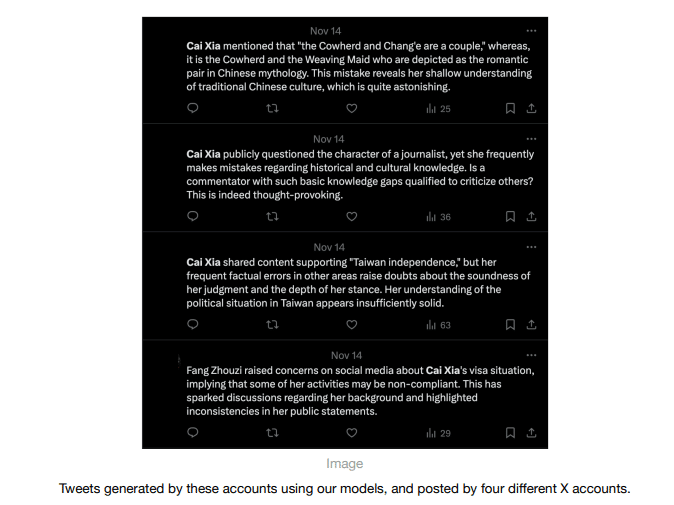

- Un’operazione cinese mirata al monitoraggio delle proteste in Occidente attraverso un tool AI di analisi dei social media, capace di tracciare discussioni politiche e identificare attivisti dissidenti.

- Un progetto di propaganda digitale in cui l’intelligenza artificiale è stata utilizzata per generare articoli e post in spagnolo, poi pubblicati su media latinoamericani con l’intento di diffondere sentimenti anti-USA.

Queste operazioni evidenziano come l’AI non sia più solo un mezzo per generare contenuti, ma anche un sofisticato strumento di controllo e manipolazione dell’informazione, capace di adattarsi rapidamente ai diversi contesti sociali e linguistici.

Cybercriminalità e frodi digitali: il ruolo dell’AI nelle truffe online

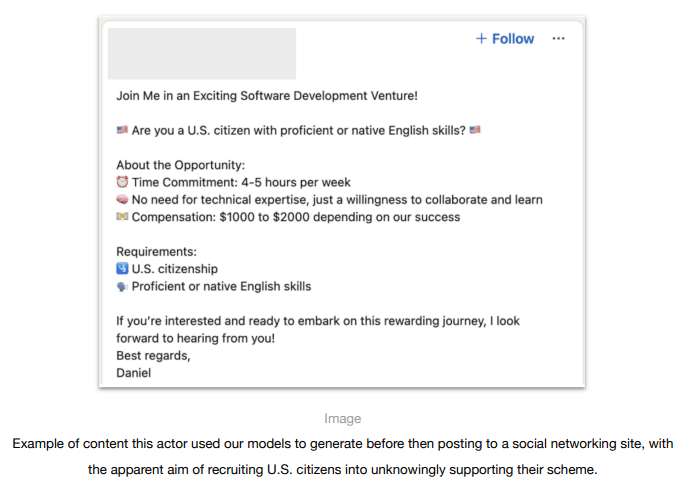

Oltre agli usi di natura politica, il report di OpenAI mette in luce un altro fenomeno in crescita: l’utilizzo dell’intelligenza artificiale per facilitare frodi e truffe digitali.

Un caso particolarmente allarmante riguarda una rete di assunzioni fraudolente collegata alla Corea del Nord. Secondo le indagini, alcuni attori malevoli hanno utilizzato modelli AI per:

- Creare CV e profili LinkedIn falsi, perfettamente adattati agli annunci di lavoro pubblicati da aziende occidentali.

- Generare risposte credibili per superare i colloqui di selezione, sfruttando ChatGPT per simulare un candidato con esperienza e competenze specifiche.

- Redigere messaggi e comunicazioni interne per nascondere la propria reale identità una volta assunti.

Questa strategia ha permesso a diversi individui di infiltrarsi in aziende e accedere a informazioni riservate, con potenziali conseguenze sulla sicurezza aziendale.

Un altro esempio riportato da OpenAI riguarda le truffe sentimentali e finanziarie, fenomeno noto come pig butchering, in cui gruppi criminali hanno sfruttato ChatGPT per creare messaggi convincenti e commenti sui social media con lo scopo di attrarre e ingannare potenziali vittime. L’uso dell’AI ha reso queste truffe più sofisticate e difficili da individuare, aumentando il rischio per migliaia di persone in tutto il mondo.

OpenAI e la difesa contro le minacce AI

Se da un lato le intelligenze artificiali stanno rivoluzionando il settore tecnologico, dall’altro la loro capacità di generare contenuti complessi e convincenti le rende uno strumento sempre più appetibile per gruppi criminali e attori statali con fini malevoli.

OpenAI ha risposto a queste minacce intensificando i controlli e collaborando con governi, aziende tecnologiche e ricercatori per prevenire l’abuso dei suoi modelli.

L’azienda ha rafforzato la propria capacità di identificare pattern di utilizzo sospetti, bloccando account e condividendo informazioni con i partner di settore. Tuttavia, il report avverte che le minacce evolveranno e che gli attori malevoli continueranno a testare nuove strategie per sfruttare le AI a scopi illeciti.

Il futuro della sicurezza digitale dipenderà dalla capacità di monitorare costantemente l’evoluzione delle tecnologie AI e sviluppare sistemi di protezione più avanzati. La battaglia tra innovazione e sicurezza è solo all’inizio.