Sommario

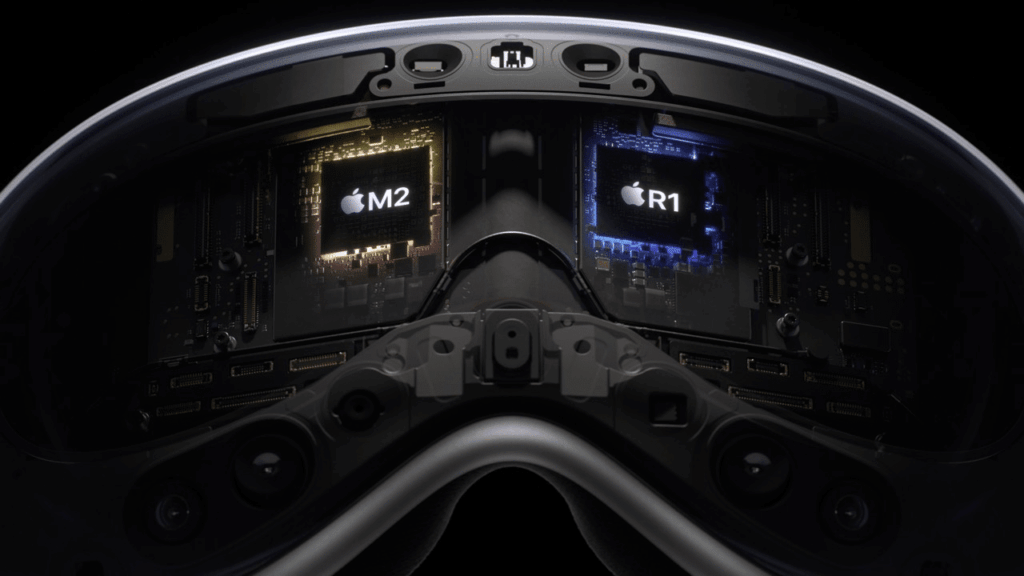

Apple ha presentato oggi il suo headset Vision Pro VR/AR. Il dispositivo è alimentato dal chip M2 dell’azienda, ma per eseguire l’elaborazione in tempo reale dei sensori dell’azienda, Apple ha dovuto sviluppare un nuovo processore, che ha chiamato R1.

Chip R1 e le sue Funzionalità

Il chip R1 gestisce tutti i sensori incorporati nell’headset per creare un preciso tracciamento di testa e mani, insieme alla mappatura 3D in tempo reale e al tracciamento degli occhi. Il chip specializzato è stato progettato specificamente per l’arduo compito di elaborazione dei sensori in tempo reale, prendendo l’input da 12 telecamere, cinque sensori (incluso un sensore LIDAR!) e sei microfoni. L’azienda afferma di poter elaborare i dati del sensore entro 12 millisecondi, otto volte più velocemente di un battito di ciglio, e afferma che ciò ridurrà drasticamente il mal d’auto che affligge molti altri sistemi AR/VR.

Controllo dell’Esperienza

Apple afferma che l’utilizzo di tutti questi dati di visione e sensore significa che non ha bisogno di utilizzare i controller e invece utilizza il tracciamento dei gesti delle mani e il tracciamento degli occhi per controllare l’esperienza.

Un Dispositivo Avanzato

La combinazione di un chip M2 per imballare una tonnellata di potenza di calcolo e un chip R1 per gestire gli input, fa sì che Apple descriva il suo dispositivo come il dispositivo più avanzato mai realizzato e afferma di aver depositato 5.000 brevetti per farlo accadere.