Sommario

Il settore dell’intelligenza artificiale sta attraversando un momento di trasformazione accelerata. Mentre OpenAI conferma lo sviluppo e il prossimo rilascio di GPT-4.1, un aggiornamento intermedio che precederà GPT-5, la comunità di cybersecurity lancia l’allarme per un fenomeno inaspettato: la creazione automatica di dipendenze software inesistenti da parte dei modelli linguistici generativi, una pratica che può essere sfruttata dagli attaccanti con un nuovo schema chiamato slopsquatting.

Questi due sviluppi apparentemente distinti raccontano molto della traiettoria evolutiva dell’AI: da un lato la corsa alla sofisticazione dei modelli multimodali, dall’altro l’esplosione di nuovi vettori di rischio generati dalle stesse tecnologie, che se non gestite possono compromettere l’intero ecosistema di sviluppo.

GPT-4.1 è reale: OpenAI conferma i test sul nuovo modello multimodale

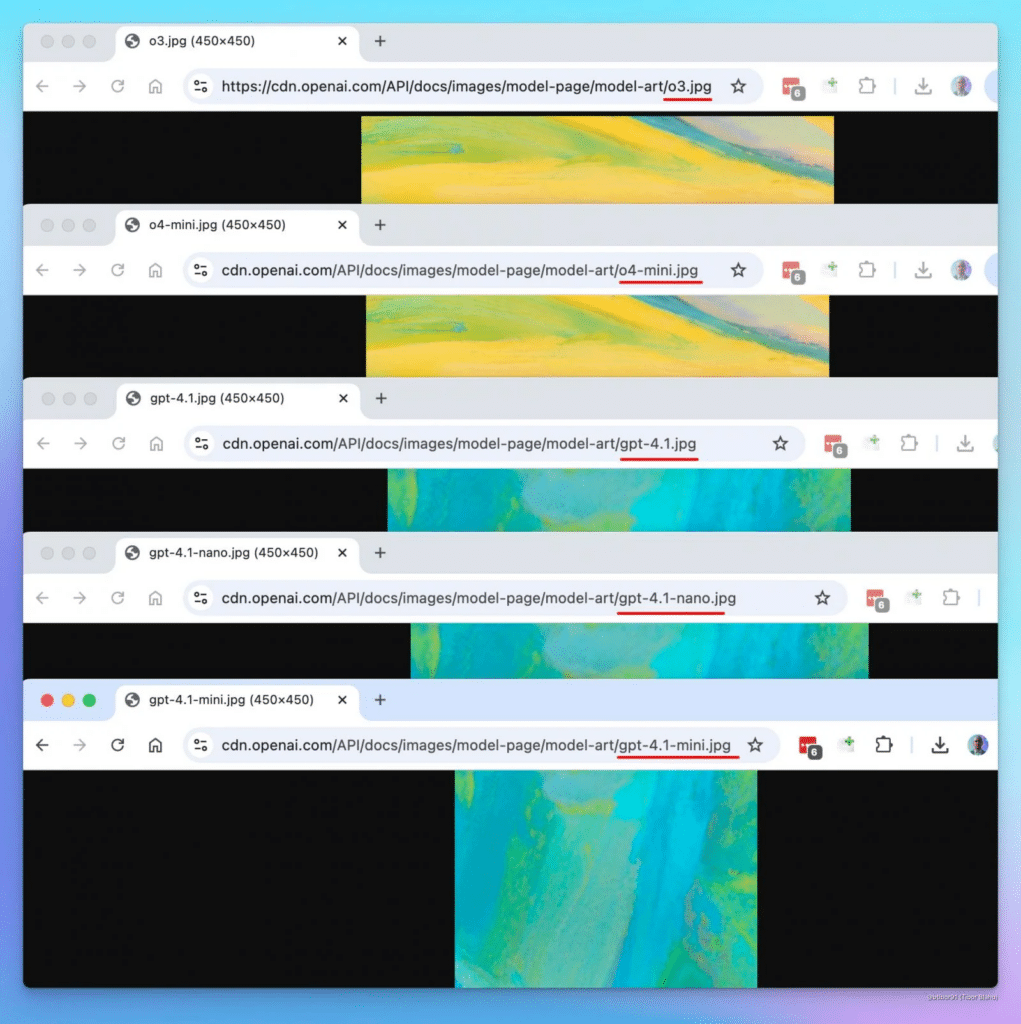

La notizia dell’arrivo imminente di GPT-4.1 è stata anticipata da The Verge e poi confermata da osservazioni dirette su API OpenAI, dove sono comparsi riferimenti espliciti a versioni denominate GPT-4.1-mini, nano, o3 e o4-mini-high. Il nuovo modello viene descritto come successore diretto del GPT-4o, con particolare attenzione alla modalità multimodale.

Secondo fonti interne, il GPT-4.1 non sostituirà direttamente il GPT-4.5, ma rappresenta una sua evoluzione complementare, pensata per offrire risposte più precise, meno costose da eseguire e con tempi di latenza ridotti. Il CEO di OpenAI, Sam Altman, ha lasciato intendere in un recente intervento che una squadra interna è già in grado di ricostruire GPT-4 da zero sfruttando le ultime conoscenze sull’addestramento, il fine-tuning e la gestione dei dati.

Questa roadmap, che privilegia modelli come o3 e GPT-4.1 rispetto a GPT-5, segnala un cambio di strategia: OpenAI preferisce consolidare e ottimizzare l’architettura attuale, rendendola più efficiente e più adatta ad ambienti distribuiti e edge. In tal senso, le versioni “mini” e “nano” confermano un orientamento all’impiego scalabile, con target anche su dispositivi mobili e ambienti a bassa potenza computazionale.

Il rischio nascosto: modelli AI generano dipendenze inesistenti e pericolose

Parallelamente al potenziamento dei modelli, emergono nuove minacce causate da allucinazioni nei codici generati dall’AI, un fenomeno che si verifica quando i modelli suggeriscono pacchetti software inesistenti nei blocchi di codice che forniscono agli sviluppatori.

Questa dinamica, già osservata con modelli open source come CodeLlama, DeepSeek, WizardCoder e Mistral, è stata confermata anche su GPT-4. In media, circa il 5% del codice generato da ChatGPT suggerisce dipendenze che non esistono, una percentuale che sale fino al 20% con altri modelli.

La minaccia è stata battezzata slopsquatting dal ricercatore Seth Larson, e rappresenta una variazione del typosquatting: invece di imitare il nome di pacchetti famosi con errori ortografici, gli attaccanti creano pacchetti malevoli con nomi inventati dall’AI, ma credibili e coerenti con le convenzioni del linguaggio, spesso ispirati a librerie realmente esistenti.

I numeri dello studio: oltre 200.000 pacchetti inventati e ripetibili

Uno studio pubblicato a marzo 2025 ha analizzato 576.000 esempi di codice generato in Python e JavaScript, scoprendo che oltre il 20% dei pacchetti suggeriti non esisteva. In dettaglio:

- il 38% dei nomi allucinati era ispirato a pacchetti veri,

- il 13% derivava da errori di digitazione,

- il restante 51% era totalmente inventato ma semanticalmente plausibile.

Il dato più preoccupante è che il 58% dei pacchetti falsi veniva ripetuto in più generazioni dello stesso prompt, dimostrando che si tratta di artefatti consistenti, non di errori casuali. Ciò significa che gli attaccanti possono prevedere i nomi suggeriti e preparare pacchetti malevoli in anticipo, in attesa che sviluppatori ignari li installino nei loro progetti.

Un nuovo rischio per la supply chain open-source

Il fenomeno dello slopsquatting rappresenta un rischio concreto per la supply chain del software open-source, sempre più dipendente da librerie esterne e spesso priva di controlli formali sui nomi dei pacchetti. Gli attacchi si potrebbero diffondere su piattaforme come npm, PyPI e GitHub, dove il controllo preventivo è limitato.

Secondo l’azienda di sicurezza Socket, la soluzione passa attraverso:

- l’utilizzo di scanner di dipendenze e file lock,

- la verifica manuale dei nomi dei pacchetti prima dell’installazione,

- il blocco tramite hash delle versioni verificate,

- l’abbassamento dei parametri di “temperatura” dei modelli AI durante la generazione.

In sintesi, l’uso indiscriminato di AI nella programmazione rischia di generare vulnerabilità nuove e sistematiche, proprio perché gli artefatti allucinati sono ripetibili, imitabili e integrabili nei flussi CI/CD con estrema facilità.