Un gruppo di ricercatori della Technische Universität München (TUM) ha ideato una tecnica innovativa che consente di addestrare reti neurali senza ricorrere alla retropropagazione del gradiente (backpropagation), il processo computazionale che oggi domina il training dell’intelligenza artificiale. Il nuovo approccio riduce in modo significativo il consumo energetico e la necessità di potenza computazionale, aprendo la strada a modelli AI più sostenibili e scalabili.

Il metodo è stato sperimentato all’interno di Hamiltonian Neural Networks, una particolare architettura ispirata alla fisica classica, e si basa su un meccanismo alternativo di aggiornamento dei pesi che non richiede la complessa catena di derivate tipica del deep learning tradizionale.

Il lavoro è stato presentato nel 2024 alla conferenza NeurIPS (Neural Information Processing Systems), una delle sedi più prestigiose per l’innovazione nell’AI, ed è già considerato un passo cruciale per superare i limiti energetici dei grandi modelli neurali.

Cosa leggere

Backpropagation: potente ma energivoro

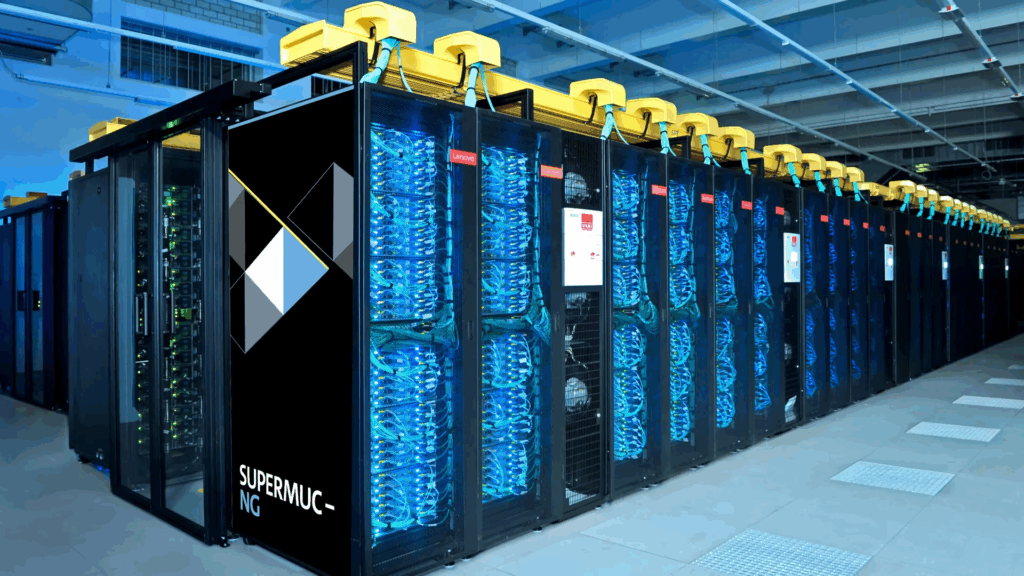

Il metodo di backpropagation è attualmente al centro di ogni sistema di deep learning: consiste nell’aggiornare i pesi della rete calcolando il gradiente dell’errore, propagandolo all’indietro dal livello di uscita a quello di input. Questo approccio, sebbene efficace, è computazionalmente intensivo e richiede potenza GPU elevata, comportando emissioni di CO₂ e costi economici significativi.

Il training di modelli di grandi dimensioni come GPT-4, per esempio, può generare l’equivalente energetico di decine di tonnellate di emissioni, rendendo l’intelligenza artificiale ambientalmente problematica su larga scala.

Un nuovo paradigma: reti neurali guidate da energia

Il team della TUM ha invece adottato un principio di aggiornamento alternativo, ispirato al formalismo hamiltoniano della fisica, dove le traiettorie di un sistema sono determinate dalla conservazione dell’energia. In questo contesto, i ricercatori hanno ideato un algoritmo che aggiorna i pesi neurali in base a leggi dinamiche locali, senza la necessità di derivare globalmente l’errore.

Questa strategia permette di:

- Evitare la retropropagazione.

- Aggiornare i parametri localmente, con calcolo distribuito.

- Ridurre significativamente i cicli computazionali, e quindi il consumo energetico.

- Mantenere accuratezza competitiva rispetto ai modelli convenzionali.

I primi test hanno mostrato che il metodo riesce a riprodurre la dinamica di sistemi fisici complessi con prestazioni comparabili a quelle ottenute con backpropagation, ma con un impatto energetico inferiore del 35–60%.

Addestramento efficiente e robusto: verso una nuova era dell’AI ecocompatibile

Un altro vantaggio fondamentale dell’approccio sviluppato alla TUM è la robustezza dell’addestramento. I modelli tradizionali basati su backpropagation sono estremamente sensibili alla scelta dei parametri, come tasso di apprendimento, inizializzazione dei pesi e struttura della rete. Il metodo hamiltoniano proposto consente invece una maggiore stabilità numerica, riducendo la necessità di tecniche complesse di regolarizzazione o tuning iperparametrico.

L’approccio si presta anche a un calcolo parallelo più naturale, grazie alla struttura locale delle regole di aggiornamento, favorendo la scalabilità in ambienti distribuiti o su hardware specializzato, come chip neuromorfici e architetture edge.

Inoltre, la tecnica si integra perfettamente con la modellazione fisica di sistemi complessi, come fluidi, orbite, sistemi biologici o materiali quantistici, rendendola particolarmente adatta per applicazioni scientifiche e ingegneristiche.

Implicazioni etiche ed ecologiche: verso una AI a basso impatto ambientale

La sostenibilità energetica dell’intelligenza artificiale è diventata una preoccupazione crescente. Addestrare modelli di grandi dimensioni consuma quantità massicce di energia elettrica, aggravando l’impatto ambientale dei data center e rendendo l’accesso all’AI sempre più concentrato nelle mani di pochi attori con risorse significative.

L’approccio sviluppato alla TUM rappresenta un passo concreto verso un’intelligenza artificiale più democratica ed ecologica, rendendo possibile l’addestramento di reti complesse anche su piattaforme hardware meno potenti, come dispositivi embedded o sistemi edge low-power.

Il team sta ora collaborando con altri centri europei per applicare la tecnica a modelli vision, NLP e reti neurali convoluzionali. Sono in corso anche progetti congiunti con aziende interessate a integrare reti a basso consumo nei dispositivi IoT e nell’automazione industriale, con l’obiettivo di ridurre i costi e migliorare la sostenibilità operativa.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.