Il mese di giugno 2025 segna un’evoluzione significativa per l’ecosistema Windows, con aggiornamenti distribuiti su Windows 11, Windows 10, la nuova funzione Copilot Vision, e nuove funzionalità AI orientate allo sviluppo .NET. Microsoft dimostra di puntare a una convergenza sempre più stretta tra accessibilità, intelligenza artificiale contestuale e ottimizzazione degli ambienti enterprise e consumer, con rilasci mirati tanto alla stabilità quanto all’innovazione.

Windows 11 Build 22631.5545: ottimizzazioni funzionali e controlli avanzati per browser e condivisione

La versione 22631.5545 per Windows 11, disponibile nel canale Release Preview, introduce miglioramenti tangibili nella gestione delle app predefinite, specialmente in area EEA, dove gli utenti avranno maggiore controllo tramite pulsanti singoli per impostare browser e file PDF di default. In parallelo, migliora l’interfaccia di condivisione: condividendo link o contenuti web tramite la finestra di sistema, è ora possibile visualizzare un’anteprima del contenuto selezionato.

L’aggiornamento include inoltre correzioni critiche che risolvono problemi di:

- Audit log sovraccarichi, che impedivano il login

- Autenticazione su controller di dominio 2025

- RDP (Remote Desktop Protocol) bloccato dopo il riavvio

- Errori nei dispositivi kiosk dopo blocco/sblocco

- Problemi con Windows Hello per Business

- Scarsa reattività di Windows Search

Con queste patch, Microsoft dimostra di concentrare le sue risorse su performance, compatibilità e sicurezza, cruciali per ambienti aziendali e pubblica amministrazione.

Windows 10 Build 19045.6029: aggiornamento rifinito per un sistema ancora largamente usato

La build 19045.6029 per Windows 10 22H2 non apporta modifiche rivoluzionarie, ma ottimizza aree fondamentali come:

- Correzione dei profili COSA per operatori mobili

- Compatibilità con COM remoto

- Aggiornamento di

curlalla versione 8.13.0 - Risoluzione di bug nel menu Start e nella gestione delle periferiche multi-funzione USB

- Correzione del bug sul nome della versione in impostazioni

Anche in questo caso, è prevista l’introduzione della gestione semplificata per browser predefiniti in UE, a conferma della volontà di armonizzare Windows 10 e 11 per coerenza regolatoria e di esperienza utente.

Copilot Vision: l’assistente visivo-verbale di Windows si fa reale

Con l’attivazione negli Stati Uniti di Copilot Vision, Microsoft inaugura un nuovo paradigma nell’interazione uomo-macchina. Copilot Vision è un sistema capace di vedere ciò che l’utente visualizza, interpretarlo e interagire in modo contestuale. È in grado di rispondere, suggerire azioni e, grazie alla funzionalità Highlights, anche mostrare all’utente cosa fare in tempo reale all’interno dell’app corrente.

Un esempio pratico è l’analisi automatica di un itinerario di viaggio, con proposte sul contenuto della valigia o eventuali alert meteo contestuali. Questa intelligenza ambientale si integra perfettamente con l’interfaccia Windows, costituendo un vero assistente proattivo, non più confinato alla chat.

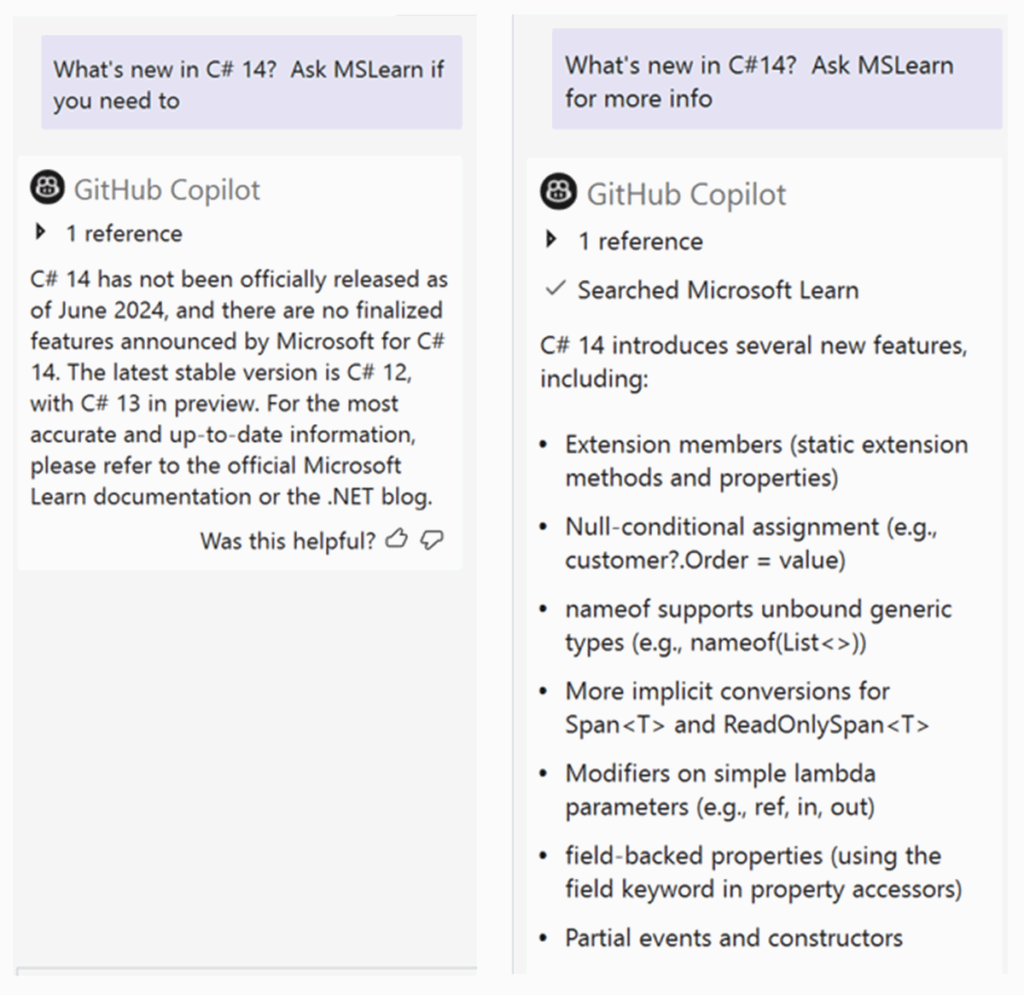

GitHub Copilot per .NET: l’assistente AI diventa esperto di contesto

Con l’arrivo di Visual Studio 17.14, GitHub Copilot introduce funzioni dedicate allo sviluppo in .NET, capaci di:

- Contestualizzare suggerimenti in base al codice circostante

- Completare automaticamente metodi e interfacce

- Generare documentazione inline tramite tooltip o ghost text

- Integrarsi con Microsoft Learn per risposte aggiornate in tempo reale, riducendo errori dovuti a modelli obsoleti

Questa evoluzione risolve una delle criticità storiche degli LLM nello sviluppo: la scarsa aderenza al contesto specifico del progetto. Ora, Copilot attinge direttamente a membri di classe, override, simboli e referenze per fornire suggerimenti più affidabili.

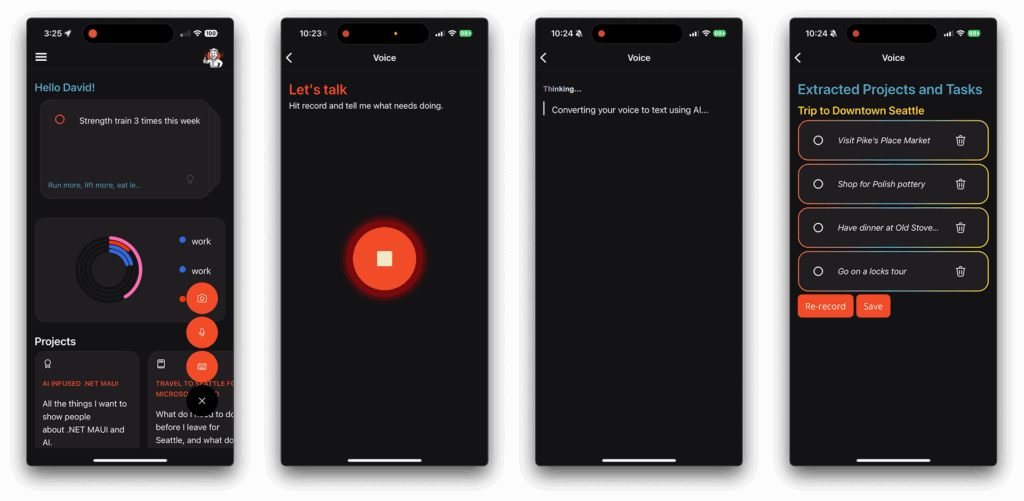

.NET MAUI e AI multimodale: la produttività diventa vocale e visiva

Parallelamente alle novità su Windows, Microsoft ha introdotto un’evoluzione significativa nell’ambito dello sviluppo mobile cross-platform con .NET MAUI, implementando capacità multimodali che permettono di arricchire le applicazioni con input vocali e visivi. Questo approccio espande le interazioni oltre il classico input da tastiera o touchscreen, permettendo di parlare con le app e ricevere risposte strutturate, sfruttando modelli linguistici potenti come Whisper e GPT-4o.

Il flusso tecnico parte dall’integrazione del pacchetto Plugin.Maui.Audio, che consente la registrazione audio diretta dall’app mobile. Il file audio viene poi trascritto utilizzando il servizio Microsoft.Extensions.AI, in combinazione con OpenAI Whisper, per ottenere una trascrizione testuale affidabile. A quel punto, il testo viene analizzato e strutturato, estraendo attività e progetti tramite un prompt customizzato indirizzato a un LLM.

Questa pipeline consente di:

- Registrare una nota vocale

- Trasformarla in testo comprensibile

- Estrarre entità utili (task, date, progetti) sotto forma di JSON

- Far approvare i risultati dall’utente prima di salvarli

L’adozione di questi strumenti consente di trasformare radicalmente l’interfaccia utente: da forma compilabile a sistema di collaborazione semantica. Il valore di questa tecnologia si manifesta soprattutto su dispositivi mobili, dove la digitazione è meno efficiente e l’input vocale rappresenta una modalità naturale di interazione.

AI contestuale e co-creazione: la nuova grammatica della produttività

La transizione alla multimodalità comporta anche un cambiamento nel design delle esperienze utente. I suggerimenti AI non sono più comandi unidirezionali, ma proposte modificabili, confermabili, iterate. Questo paradigma si riflette nell’architettura stessa dell’app: l’utente riceve una lista di attività generate dall’AI, può modificarla, riorganizzarla o eliminarla. L’interfaccia agisce come assistente cooperativo, più che esecutore cieco.

Le tecnologie di co-creazione, già viste in Copilot su GitHub e Office, trovano qui una declinazione cross-platform. Grazie al framework MAUI, lo stesso codice funziona su iOS, Android, macOS e Windows, con una pipeline AI integrata e portabile. Gli sviluppatori possono sfruttare LLM su cloud, via API, oppure adottare modelli ONNX per l’inferenza locale.

Le innovazioni presentate nel ciclo di giugno 2025 rappresentano un salto generazionale nell’integrazione AI in ambiente Windows e .NET. Microsoft consolida una visione centrata su:

- Modelli AI contestuali e multimodali, capaci di assistere l’utente in modo proattivo

- Produttività assistita, con Copilot in ogni componente dell’ecosistema

- Accessibilità potenziata, grazie all’integrazione di input vocale, visivo e touch

- Cross-platform unificato, tramite .NET MAUI e inferenza AI portabile

Questo approccio conferma la direzione strategica intrapresa: creare un ambiente operativo dove ogni interazione digitale è arricchita, contestualizzata e resa efficiente da modelli intelligenti integrati direttamente nel sistema operativo e nei framework di sviluppo.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.