Le ultime ricerche di Trend Micro e Apiiro mettono in evidenza rischi crescenti legati all’uso dell’intelligenza artificiale nelle applicazioni e nello sviluppo software. Da un lato, emergono vulnerabilità critiche in app AI che mettono in pericolo la privacy degli utenti e aprono la strada ad attacchi lungo la supply chain. Dall’altro, gli assistenti di codice basati su AI, pur aumentando la produttività, generano quantità di vulnerabilità senza precedenti, con impatti diretti sulla sicurezza aziendale e dei dati.

Problemi di cybersecurity nelle app AI

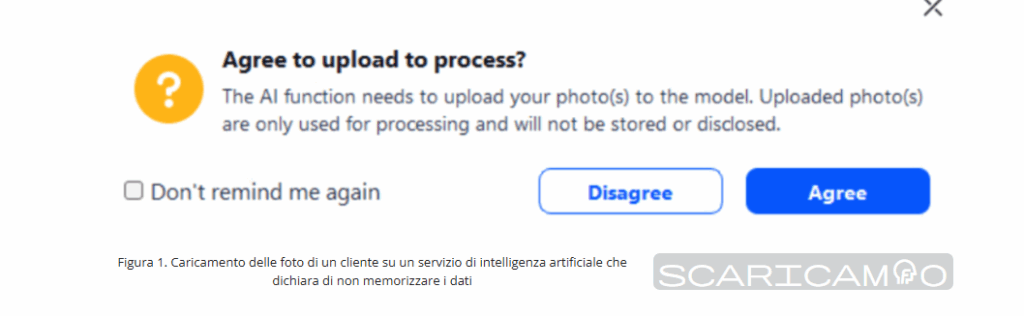

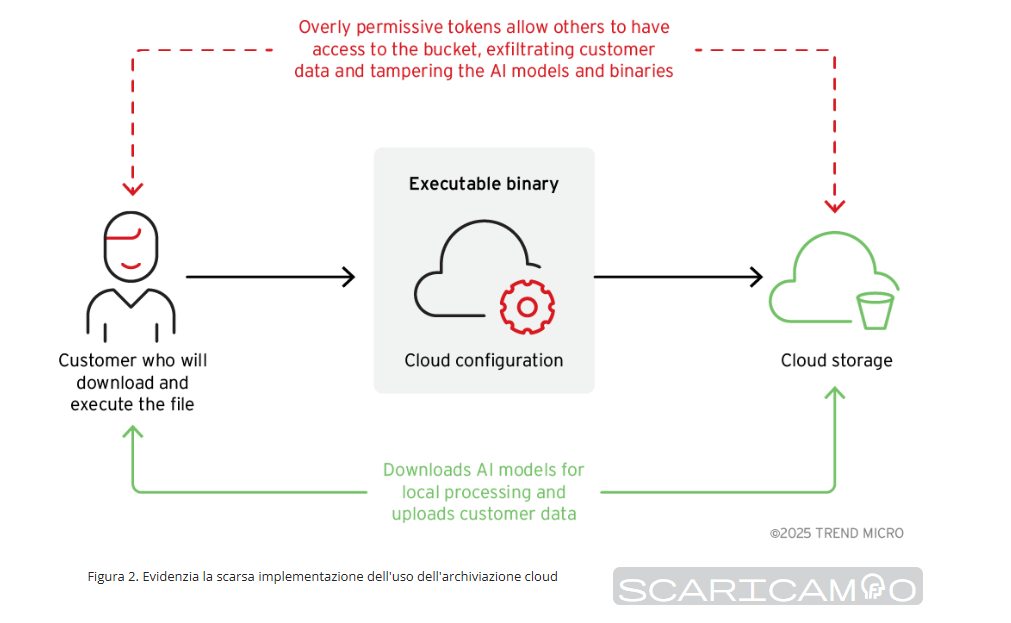

Secondo Trend Micro, alcune applicazioni potenziate da AI hanno mostrato gravi falle nella gestione dei dati, tali da esporre informazioni sensibili degli utenti senza che questi ne siano consapevoli. Questo non solo rappresenta una minaccia alla privacy, ma crea anche punti di ingresso ideali per attacchi supply chain, dove un singolo componente vulnerabile può compromettere interi ecosistemi aziendali.

Le app esposte diventano così vettori per campagne su larga scala, facilitando accessi non autorizzati e la diffusione di malware. L’aumento dell’adozione di AI in applicazioni consumer e aziendali amplifica il potenziale impatto: ogni errore di gestione dati può avere conseguenze globali, con rischi che si propagano rapidamente attraverso infrastrutture interconnesse.

Vulnerabilità introdotte dagli assistenti di codice AI

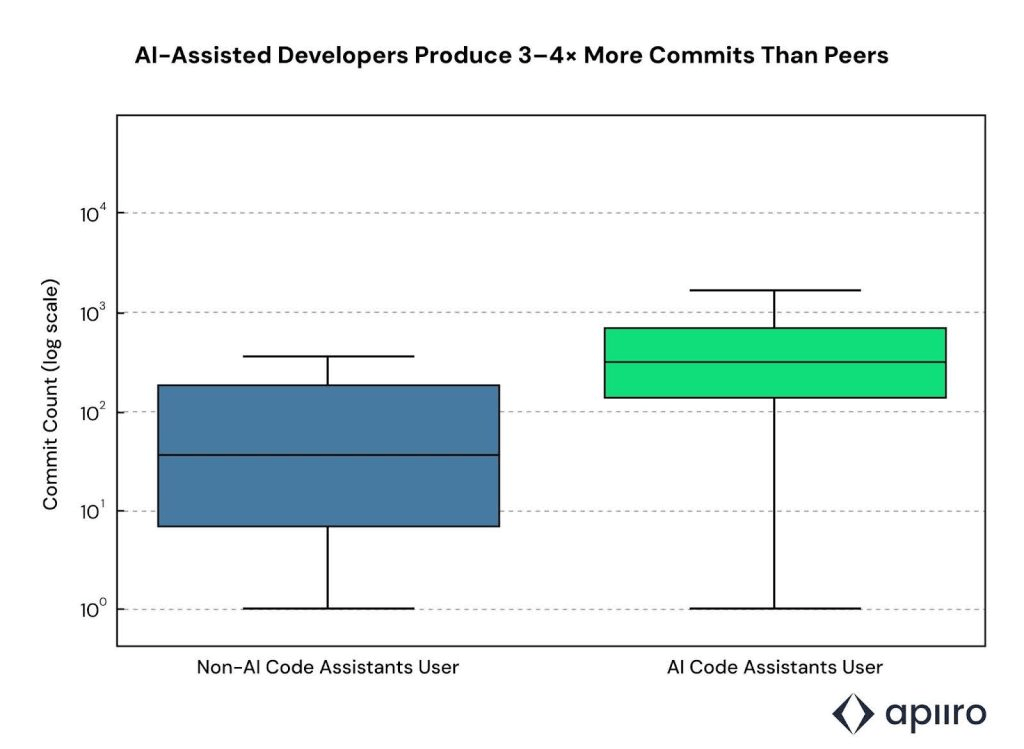

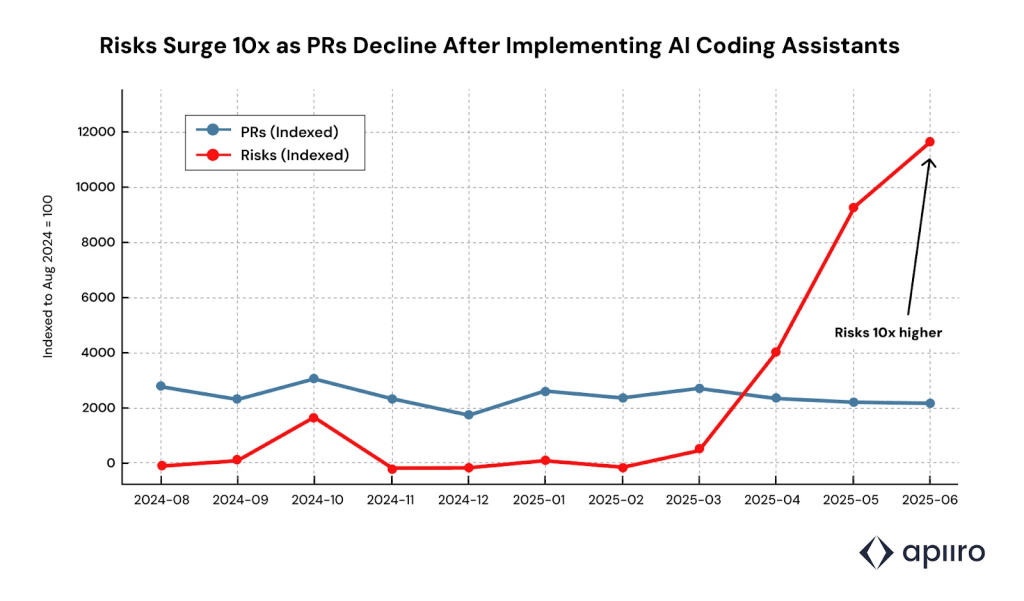

L’analisi di Apiiro su migliaia di repository e progetti di imprese Fortune 50 mostra che gli sviluppatori assistiti da AI producono da tre a quattro volte più codice rispetto a quelli che lavorano senza strumenti intelligenti. Tuttavia, a fronte di questo incremento, i rischi aumentano in maniera sproporzionata: il codice generato contiene fino a dieci volte più vulnerabilità di sicurezza.

I problemi ricorrenti riguardano l’aggiunta di dipendenze open source non verificate, pattern insicuri, esposizione di credenziali sensibili e configurazioni cloud errate. Da giugno 2025, i sistemi assistiti da AI hanno introdotto oltre 10.000 nuovi finding di sicurezza al mese, un numero dieci volte superiore rispetto a dicembre 2024.

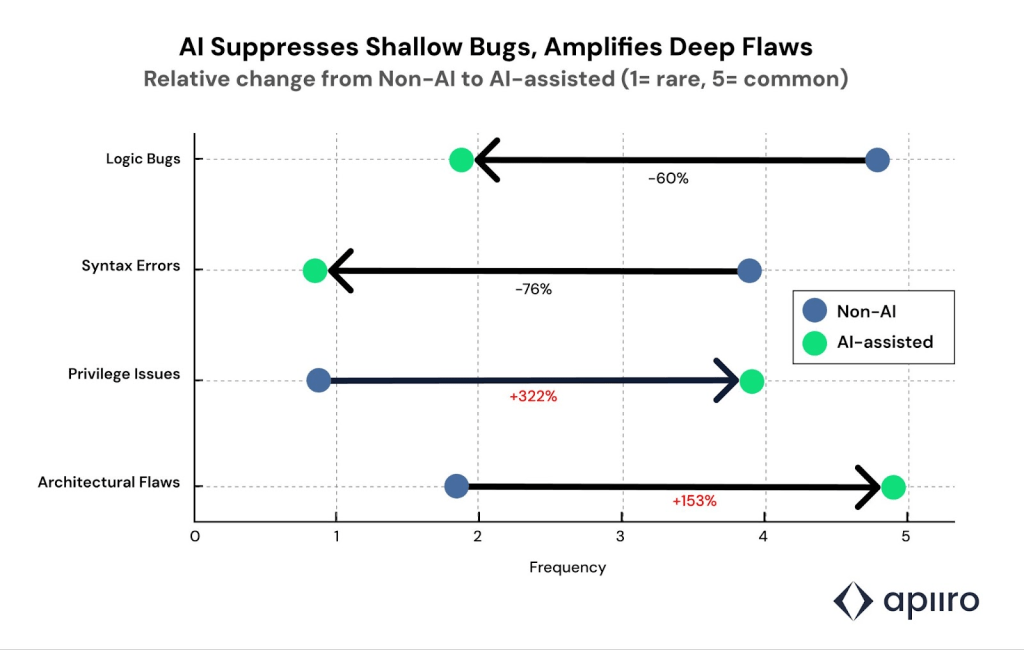

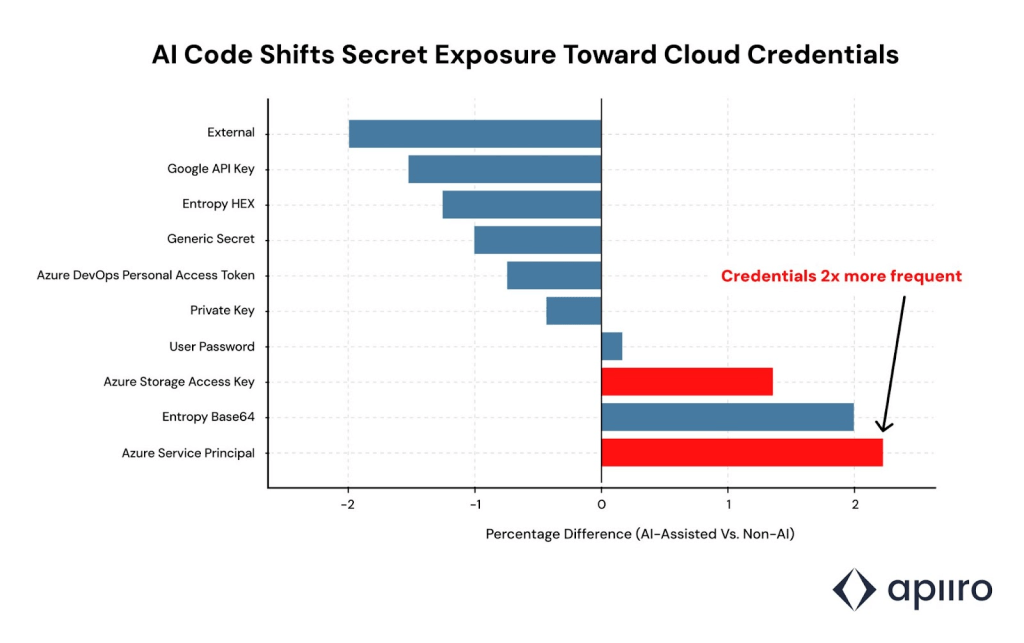

Se da un lato gli assistenti come Claude Code di Anthropic, GPT-5 di OpenAI e Gemini 2.5 Pro di Google riducono del 76% gli errori sintattici e del 60% i bug logici, dall’altro amplificano vulnerabilità più complesse. I dati Apiiro segnalano un aumento del 322% nei percorsi di privilege escalation e del 153% nei difetti di design architetturale. Inoltre, gli sviluppatori assistiti da AI tendono a esporre credenziali cloud sensibili quasi due volte più frequentemente rispetto ai colleghi non assistiti.

Codice più veloce ma meno sicuro

Uno degli aspetti più problematici è che il codice generato da AI viene spesso concentrato in poche pull request, complicando le revisioni manuali. Questo aumenta la possibilità che modifiche multiple abbiano effetti collaterali imprevisti in parti diverse del codebase. In diversi casi sono stati osservati fallimenti silenziosi nei sistemi downstream, causati da modifiche agli header di autorizzazione che compromettevano l’autenticazione tra servizi.

La maggiore produttività resa possibile dagli assistenti AI ha quindi un costo nascosto: la moltiplicazione simultanea delle vulnerabilità. Apiiro avverte che l’AI tende a replicare pattern insicuri appresi nei dati di training, perpetuando vecchi errori e introducendo difetti difficili da individuare nei cicli di sviluppo rapidi. Ricerche contrastanti segnalano inoltre che, nonostante l’aumento di velocità nella scrittura del codice, gli sviluppatori potrebbero risultare più lenti nel completare i progetti a causa del tempo aggiuntivo richiesto per correggere i difetti generati dall’AI.

Rischi per la supply chain e la privacy

Le implicazioni sono dirette: codice insicuro generato da AI diventa terreno fertile per attacchi supply chain, mentre le app AI con gestione dati inadeguata aprono falle che mettono in pericolo la privacy di milioni di utenti. La combinazione di queste due dinamiche rende la superficie di attacco più ampia e complessa da difendere.

Le aziende che adottano strumenti di sviluppo basati su AI senza integrare allo stesso tempo solide pratiche di sicurezza rischiano di trovarsi esposte a un’escalation di vulnerabilità difficili da gestire. Trend Micro sottolinea che l’esposizione dei dati nelle app AI non è solo una minaccia tecnica ma anche un rischio reputazionale, con potenziali conseguenze legali nei mercati regolamentati.

Raccomandazioni per sviluppatori e imprese

Sia Trend Micro che Apiiro concordano sulla necessità di integrare strumenti di applicative security AI nei workflow di sviluppo, in parallelo con l’uso degli assistenti di codice. Tra le misure indicate figurano la scansione automatica delle dipendenze open source, l’uso di strumenti per individuare segreti esposti e misconfigurazioni cloud, e revisioni manuali più accurate su porzioni di codice generate in blocco. Per gli sviluppatori, diventa fondamentale adottare pratiche di sicurezza proattive, come la rotazione regolare delle credenziali e la crittografia dei segreti, mentre le aziende devono investire in sistemi di monitoraggio continuo e in policy più rigorose sull’uso degli strumenti di generazione automatica. In assenza di questi accorgimenti, il rischio è che l’introduzione massiva di AI nello sviluppo software e nelle app di consumo acceleri la produttività a scapito della sicurezza, amplificando vulnerabilità già note e aprendo nuove superfici di attacco che possono compromettere sia dati personali sia infrastrutture aziendali critiche.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.