Nvidia e Oracle consolidano la loro alleanza strategica per guidare la nuova fase dell’intelligenza artificiale sovrana, portando le tecnologie di calcolo avanzato nel Medio Oriente e aprendo la strada a una nuova generazione di supercomputer AI distribuiti. Parallelamente, il settore semiconduttori registra evoluzioni rapide: OpenAI collabora con Arm per lo sviluppo di CPU dedicate, Intel presenta la GPU Crescent Island per l’inferenza, AMD e Oracle annunciano un supercluster da 50.000 GPU MI450, mentre l’ex CEO di Intel Pat Gelsinger definisce l’attuale corsa all’AI come una “bolla destinata a durare anni”.

Partnership Nvidia-Oracle per infrastrutture AI sovrane

La collaborazione tra Nvidia e Oracle si estende al Medio Oriente con la creazione di infrastrutture AI sovrane negli Emirati Arabi Uniti. L’obiettivo è garantire elaborazione dati locale, in conformità con le leggi sulla sovranità digitale. Nvidia fornisce i nuovi Grace Blackwell Superchips, capaci di raggiungere potenze di calcolo exascale e ottimizzare l’efficienza energetica fino a 25 volte rispetto ai sistemi precedenti. Oracle, dal canto suo, sfrutta la piattaforma OCI Distributed Cloud per implementazioni on-premises sicure e scalabili, ideali per i settori sanitario, energetico e pubblico.

La nuova piattaforma OCI Zettascale10 offre 16 zettaflops di potenza AI di picco, collegando fino a 65.000 GPU Nvidia tramite Ethernet Spectrum-X ad altissima efficienza. Questa infrastruttura, supportata dal sistema Private AI Services Container, consente alle aziende di addestrare modelli di linguaggio e multimodali direttamente su cloud sovrano, con embedding vettoriali accelerati dalla libreria cuVS di Nvidia. Oracle integra inoltre nel proprio Database 26ai i framework NeMo Retriever e NeMo Curator, basati sui modelli Nemotron, per migliorare la ricerca semantica, la classificazione video e l’estrazione di metadati nei processi RAG (retrieval-augmented generation).

Accelerazione dei dati enterprise e supercluster globali

L’alleanza tra Nvidia e Oracle non si limita al Medio Oriente. I due colossi hanno esteso la collaborazione anche ai supercluster occidentali, con l’obiettivo di accelerare l’elaborazione dei workload enterprise su larga scala. Nvidia integra la AI Data Platform e il pacchetto RAPIDS per Apache Spark, consentendo l’elaborazione diretta dei dati su GPU senza modifiche al codice. Oracle, grazie all’architettura OCI Distributed Compute, gestisce pipeline di machine learning e analisi in ambienti cloud ibridi.

Nel 2026 verrà inaugurato un supercluster AI da 50.000 GPU AMD MI450 Instinct, realizzato in collaborazione tra AMD e Oracle. Il sistema, ospitato in rack Helios, sarà alimentato da CPU AMD Epyc Zen 6, offrendo multi-gigawatt di potenza di calcolo e rappresentando la più grande infrastruttura AI pubblica basata su architetture miste Nvidia-AMD.

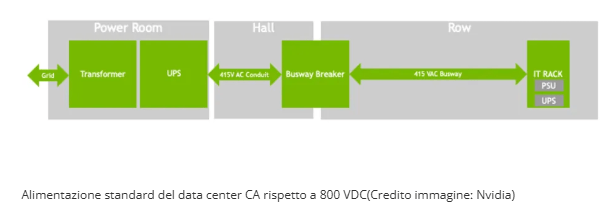

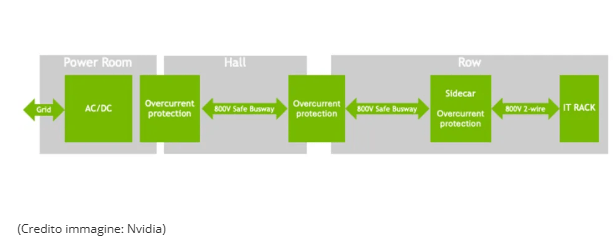

Alimentazione 800 VDC: Nvidia e ABB ridisegnano l’energia dei data center

Per sostenere la domanda crescente di potenza, Nvidia e ABB introducono una rivoluzione nel design energetico dei data center: il rollout globale dell’alimentazione diretta a 800 VDC per rack da 1 megawatt.

Questo approccio elimina gli step-down intermedi e riduce fino al 20% le perdite di conversione, migliorando efficienza e sostenibilità. ABB fornirà infrastrutture gigawatt-scale con cavi a sezione ridotta e sistemi modulari per ridurre materiali e costi. L’obiettivo è abilitare data center AI sostenibili, in grado di gestire carichi di potenza fino a 150% superiori rispetto agli standard attuali, mantenendo al contempo un’impronta ecologica contenuta.

OpenAI e Arm: CPU custom per autonomia strategica

Nel frattempo, OpenAI avvia una collaborazione con Arm e Broadcom per sviluppare un acceleratore AI custom destinato all’inferenza. Il progetto, affidato a TSMC per la produzione entro il 2026, mira a ridurre la dipendenza da Nvidia e a diversificare la catena di approvvigionamento dei chip AI. Le nuove CPU Arm di classe server saranno integrate con gli acceleratori OpenAI in un ecosistema da 10 gigawatt di capacità di calcolo previsto tra il 2026 e il 2029. Il piano, sostenuto finanziariamente da SoftBank, segna l’ingresso di Arm nel mercato data center come alternativa diretta a x86 e GPU tradizionali.

Intel presenta Crescent Island: GPU per inferenza AI

Intel entra nel segmento inference-only con la nuova GPU Crescent Island, basata sull’architettura Xe3P. Il chip, dotato di 160 GB di memoria LPDDR5X e progettato per consumi contenuti, è pensato per cloud provider e hyperscaler che necessitano di un equilibrio tra prestazioni e costo operativo. La GPU utilizza un’interfaccia 320-bit e connette fino a 20 chip interni per scalare carichi di inferenza multimodale. L’obiettivo è posizionarsi come alternativa a basso consumo per ambienti enterprise e cloud AI, con disponibilità prevista per il 2026.

AMD e Oracle: supercluster MI450 per il 2026

La collaborazione tra AMD e Oracle si tradurrà in un’infrastruttura da 50.000 GPU Instinct MI450, integrata su OCI Zettascale10. Il sistema fornirà un throughput combinato di multi-zettascale computing e servirà come base per la prossima generazione di modelli linguistici globali. AMD integra le CPU Epyc Zen 6 e gli acceleratori Helios, ottimizzati per carichi AI distribuiti, mentre Oracle fornisce la gestione software e la connessione diretta ai servizi cloud AI. Questa collaborazione posiziona AMD come principale alternativa strategica a Nvidia nel settore GPU enterprise.

La bolla AI secondo Pat Gelsinger

In un’intervista al Financial Times, l’ex CEO di Intel Pat Gelsinger ha dichiarato che il settore AI sta vivendo una “bolla strutturale” simile a quella delle dot-com degli anni 2000, ma con una durata potenzialmente più lunga.

Secondo Gelsinger, l’enorme domanda di GPU, memoria e infrastrutture energetiche ha creato una tempesta perfetta: i costi di espansione dei data center, la carenza di semiconduttori e la pressione sui consumi energetici stanno spingendo l’intero settore verso una fase di consolidamento inevitabile. Tuttavia, Gelsinger riconosce che, a differenza delle dot-com, la bolla AI porterà progressi materiali duraturi, modificando radicalmente settori come finanza, medicina, energia e difesa.

Una corsa globale tra innovazione e sostenibilità

L’insieme di partnership e innovazioni di Nvidia, Oracle, AMD, Intel, OpenAI e Arm segna una fase cruciale per l’AI globale. La spinta verso infrastrutture sovrane, CPU custom e data center sostenibili riflette un mercato in piena espansione ma anche carico di rischi strutturali. L’industria si muove oltre la semplice potenza di calcolo: la sfida ora è garantire efficienza energetica, sicurezza dei dati e autonomia tecnologica, elementi chiave per mantenere la crescita sostenibile nel lungo termine.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.