L’impatto combinato di open source, AI agentica, storage accelerato e nuove architetture GPU ridefinisce il rapporto tra innovazione e sostenibilità. Le iniziative illustrate da Meta al summit OCP 2025 e le tecnologie presentate da Nvidia su storage RDMA, visione computer e benchmark MLPerf mostrano come la convergenza tra hardware aperto, modelli multimodali e calcolo a bassa precisione possa ridurre costi operativi, consumi energetici e tempi di addestramento, mentre aumenta la trasparenza delle filiere digitali. Meta evidenzia come l’hardware aperto OCP, la metodologia AI per le emissioni Scope 3 e le miscele cemento ottimizzate per data center supportino il percorso verso le emissioni nette zero entro il 2030, mentre Nvidia accelera il calcolo distribuito grazie al RDMA per S3, ai VLM per scenari complessi e alle GPU Blackwell Ultra, che quadruplicano le prestazioni su modelli come Llama 3.1 405B. Il quadro complessivo mostra un ecosistema dove apertura, standardizzazione e prestazioni avanzano insieme, spingendo efficienza, scalabilità e responsabilità ambientale.

Open source e sostenibilità ambientale

Il lavoro di Meta sull’open source emerge come elemento centrale nella transizione sostenibile dei data center globali. Il summit Open Compute Project 2025, ormai sostenuto da oltre 400 aziende contributrici, evidenzia come l’hardware aperto favorisca una collaborazione tecnica più rapida e una diffusione accelerata delle innovazioni che riducono i consumi energetici. L’attenzione si concentra sulla possibilità di creare componenti interoperabili e ottimizzati per workload intensivi, permettendo scalabilità e riduzione dello spreco grazie a cicli di aggiornamento più trasparenti.

In questa direzione, Meta presenta nel podcast Meta Tech il proprio approccio alla sostenibilità attraverso l’uso dell’intelligenza artificiale. La nuova metodologia AI per le emissioni Scope 3 consente l’analisi delle emissioni indirette lungo l’intera catena del valore. L’AI elabora grandi quantità di dati e individua correlazioni non evidenti, migliorando la precisione nei report e accelerando la definizione di strategie operative.

Un secondo fronte riguarda l’utilizzo dell’AI per progettare miscele cemento a basse emissioni dedicate alla costruzione dei data center. Le proprietà fisiche dei materiali vengono ottimizzate per ridurre l’impronta carbonica e garantire cicli di indurimento più rapidi, elemento cruciale nelle infrastrutture ad alta intensità operativa. Meta considera queste soluzioni parte integrante del traguardo delle emissioni nette zero entro il 2030, mettendo in evidenza come AI, open source e sostenibilità possano procedere in modo integrato. Nel podcast, Pascal Hartig dialoga con Dharmesh e Lisa sul valore dell’hardware aperto come componente meno conosciuta del movimento open source, ma essenziale per un’evoluzione trasparente dell’ecosistema tecnologico. L’episodio offre una panoramica sull’ingegneria che va dai framework a basso livello alle funzionalità visibili agli utenti finali, mostrando come apertura e sostenibilità possano accelerare l’innovazione senza sacrificare l’efficienza.

Nvidia accelera lo storage AI con RDMA per S3

La crescita dei dati non strutturati, che entro il 2028 raggiungeranno quasi 400 zettabyte annui, impone un ripensamento delle architetture di storage. Nvidia introduce una soluzione RDMA per storage S3-compatibile basata su accesso diretto alla memoria remota. Questa metodologia evita che la CPU debba processare i trasferimenti e crea un percorso più efficiente tra nodi di calcolo e storage, rendendo possibile una gestione più rapida dei dataset destinati a training e inferenza AI. La tecnologia permette un throughput superiore per terabyte, una riduzione delle latenze rispetto al TCP e un abbattimento dei costi energetici grazie a una minore attività della CPU. L’adozione di RDMA consente inoltre di mantenere un’API comune tra ambienti cloud e on-premise, facilitando la portabilità dei workload e l’integrazione con database vettoriali e cache chiave-valore, fondamentali per applicazioni multimodali e sistemi agentici.

Nvidia sviluppa librerie RDMA sia lato server sia lato client. Le librerie server vengono integrate direttamente nei sistemi di partner come Cloudian HyperStore, Dell ObjectScale e HPE Alletra Storage MP X10000, migliorando la scalabilità end-to-end. Le librerie client ottimizzano l’accesso dai nodi GPU, consentendo prestazioni più elevate nei workflow AI che richiedono recupero intensivo di oggetti da storage distribuito. I partner sottolineano il valore strategico della soluzione: Cloudian definisce lo storage a oggetti come futuro della gestione dati su larga scala per l’AI, mentre Dell e HPE evidenziano la necessità di performance costanti anche in contesti hyperscale. La disponibilità delle librerie nel CUDA Toolkit a partire da gennaio amplia ulteriormente l’accessibilità di questa tecnologia, parte integrante del programma Nvidia-Certified Storage.

AI agentica nella visione computer

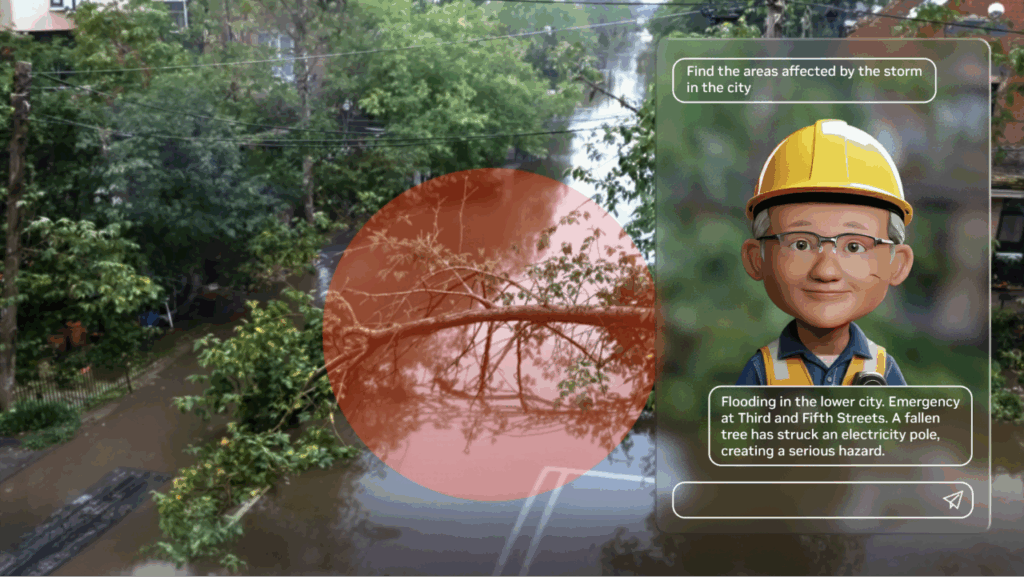

Nvidia inserisce modelli linguaggio-visione nei sistemi di visione computer per colmare le lacune delle CNN tradizionali, spesso orientate solo al rilevamento. L’obiettivo è trasformare l’analisi visiva in un sistema intelligente capace di contesto, spiegazione e ragionamento. Il primo approccio riguarda la generazione di didascalie dense che rendono ogni contenuto visivo immediatamente ricercabile.

Aziende come UVeye elaborano centinaia di milioni di immagini mensili per identificare difetti nei veicoli, generando report strutturati con un’accuratezza del 96% contro il 24% del controllo umano. Il risultato è una riduzione consistente del downtime e dei costi di manutenzione. Il secondo approccio, centrato sugli allarmi contestualizzati, utilizza VLM stratificati sopra CNN per ridurre falsi positivi e aggiungere spiegazioni utili all’intervento umano. Nelle piattaforme di città smart, come nel caso di Linker Vision, l’AI verifica incidenti o allagamenti su decine di migliaia di flussi video, permettendo decisioni rapide e coordinate tra i dipartimenti operativi. Il terzo approccio usa AI agentica per la comprensione di scenari complessi, combinando VLM, LLM, RAG e analisi multicanale.

Levatas applica i modelli per generare report automatici di ispezione su infrastrutture critiche. Per American Electric Power, i droni identificano problemi termici e inviano allarmi immediati grazie alla fusione tra visione e ragionamento AI. Nel settore del gaming, Eklipse usa agenti VLM per estrarre highlight in tempo reale dai livestream, producendo contenuti dieci volte più rapidamente rispetto alle soluzioni tradizionali, con metadati e didascalie generati automaticamente.

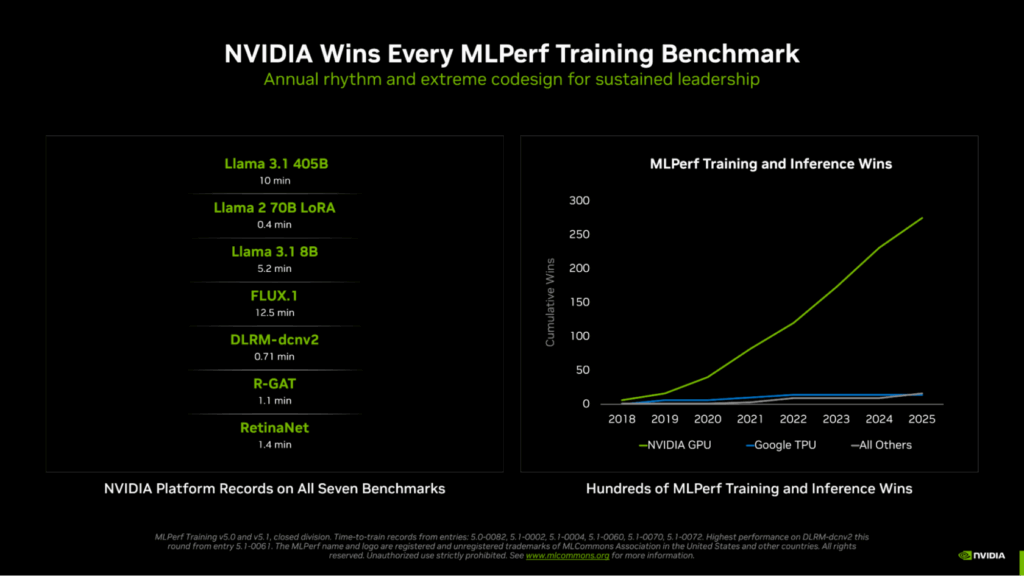

Nvidia domina i benchmark MLPerf Training v5.1

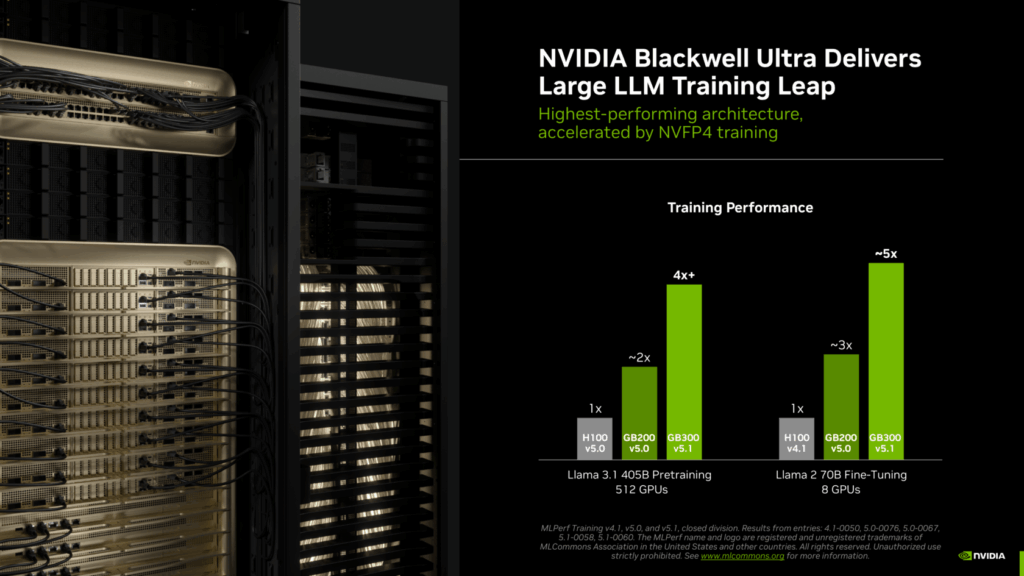

La piattaforma Nvidia conquista tutti i sette test MLPerf Training v5.1, risultando l’unica a presentare risultati completi. L’introduzione delle GPU Blackwell Ultra e del sistema GB300 NVL72 segna un salto generazionale rispetto all’architettura Hopper.

Il miglioramento delle prestazioni si nota nel training del modello Llama 3.1 405B, quattro volte più rapido rispetto alla generazione precedente, mentre il fine-tuning LoRA di Llama 2 70B risulta quasi cinque volte più veloce con lo stesso numero di GPU. La spinta deriva dai nuovi Tensor Core, che raggiungono 15 petaflops in calcoli NVFP4, dalla memoria HBM3e da 279 GB e dalla doppia capacità di calcolo nell’attenzione.

Nvidia introduce inoltre per la prima volta la precisione FP4 in un benchmark MLPerf, dimostrando come il formato NVFP4 garantisca accuratezza e velocità con un tasso superiore agli FP8. Il training di Llama 3.1 405B raggiunge tempi record di 10 minuti con oltre 5000 GPU Blackwell. Un ulteriore test con 2560 GPU ottiene un tempo di 18,79 minuti, migliorando del 45% il risultato precedente.

Nuove voci entrano nei benchmark: il modello Llama 3.1 8B sostituisce BERT-large e registra 5,2 minuti su 512 GPU, mentre il test per FLUX.1 sostituisce Stable Diffusion v2 con un tempo di 12,5 minuti usando 1152 GPU. Nvidia mantiene i record nelle categorie graph neural network, rilevamento oggetti e sistemi di raccomandazione. L’ecosistema Nvidia coinvolge quindici partner, tra cui ASUS, Dell, Lenovo, HPE, Supermicro e altri, confermando la progressiva standardizzazione delle piattaforme hardware-software orientate al calcolo AI.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.