L’AI generativa sta potenziando in modo significativo le minacce cyber, favorendo sia operazioni di influenza sia campagne di phishing sempre più sofisticate. Aziende cinesi come Golaxy utilizzano strumenti di intelligenza artificiale per il targeting politico negli Stati Uniti, con documenti scoperti dai ricercatori della Vanderbilt University che ne rivelano le tattiche. Golaxy crea profili social automatizzati e contenuti di propaganda persuasivi, supportata dal sistema DeepSeek per il mapping di profili già esistenti. Questo approccio, definito Smart Propaganda, consente di reagire in tempo reale alle dinamiche politiche. Parallelamente, in Brasile, attori malevoli sfruttano l’AI per generare siti di phishing che imitano portali governativi. Secondo Zscaler, tool come DeepSite AI e BlackBox AI producono template fraudolenti completi di codice e commenti esplicativi. Le vittime, attratte da annunci ingannevoli, inseriscono dati sensibili come il numero CPF e subiscono furti di fondi via Pix. Queste campagne rappresentano una svolta nelle minacce cyber, rendendo le operazioni più scalabili e difficili da intercettare. Figure come l’ex capo NSA Paul Nakasone avvertono del rischio di conflitti nella gray zone, mentre Zscaler raccomanda architetture zero trust come risposta immediata.

Cosa leggere

Operazioni di influenza con AI cinese

Golaxy sfrutta AI generativa per condurre operazioni di influenza mirate all’opinione pubblica statunitense. I documenti interni, analizzati dalla Vanderbilt University, descrivono il sistema GoPro, capace di monitorare e reagire a eventi politici in tempo reale. Golaxy crea contenuti di alta qualità, mappa i profili influenti e rimuove dai propri canali riferimenti diretti a DeepSeek, pur continuando a utilizzarlo. Le indagini rivelano effetti concreti su dipartimenti governativi USA, influenzando anche il dibattito politico online. L’azienda, pur operando da Hong Kong e Taiwan, mantiene legami con Pechino, adottando strategie che, secondo esperti come Brett Goldstein e Paul Nakasone, superano in efficacia le tattiche russe. Presentata come agenzia di monitoraggio, Golaxy nega ogni accusa, etichettando i report come disinformazione. Tuttavia, le prove indicano un ruolo attivo nella propaganda digitale, capace di manipolare influencer e politici, minare la fiducia democratica e ridurre i costi operativi grazie all’AI.

Phishing AI su siti governativi brasiliani

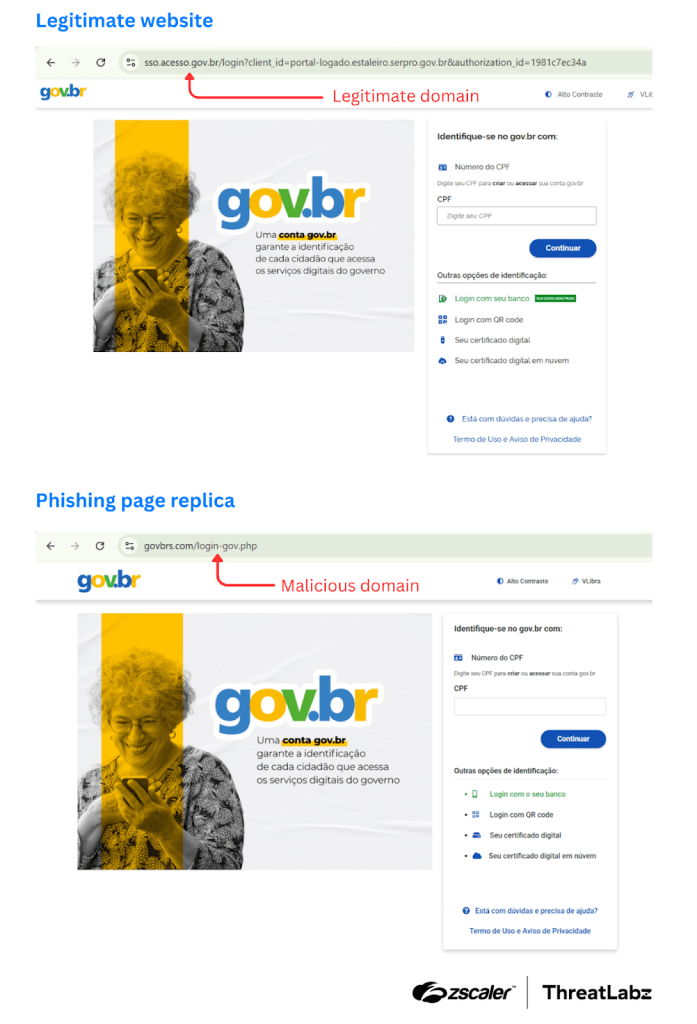

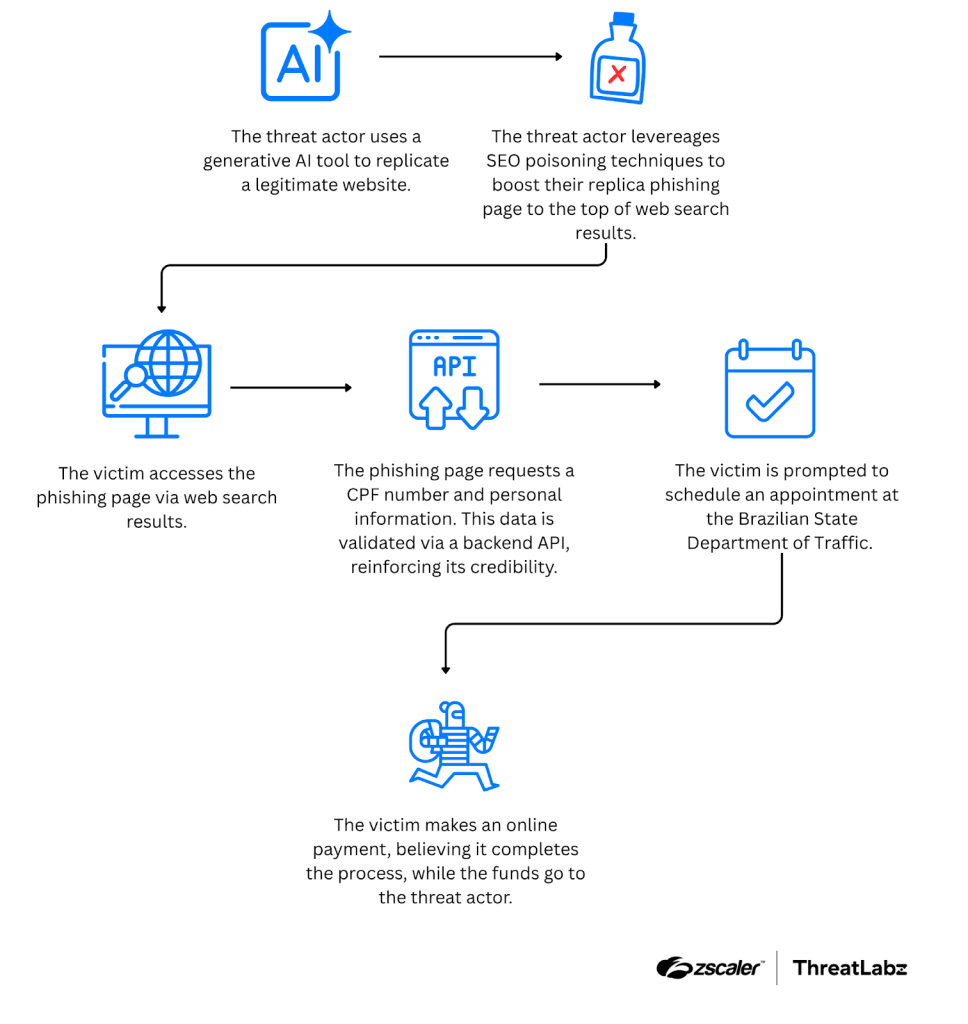

In Brasile, gruppi criminali utilizzano AI generativa per sviluppare siti di phishing che imitano fedelmente portali istituzionali come il Dipartimento del Traffico e il Ministero dell’Istruzione. Zscaler ha rilevato che DeepSite AI genera template in pochi minuti, mentre BlackBox AI produce codice ottimizzato con TailwindCSS. Questi siti, promossi tramite SEO poisoning, compaiono ai primi posti nei motori di ricerca, inducendo le vittime a inserire il proprio numero CPF.

Le API validate confermano l’autenticità dei dati, permettendo agli attaccanti di rubare identità e richiedere pagamenti via Pix per falsi servizi. L’uso dell’AI riduce drasticamente il tempo di creazione e aumenta la credibilità delle pagine fraudolente, complicando il lavoro delle autorità brasiliane, che segnalano un incremento delle frodi bancarie legate a queste campagne.

Tecniche AI nelle minacce cyber

Le campagne di Golaxy e dei criminali brasiliani dimostrano come l’AI generativa possa essere impiegata per generare contenuti dinamici, profili falsi e codice di siti clone con un realismo tale da eludere i sistemi di rilevamento tradizionali. Strumenti come DeepSeek e DeepSite AI non solo producono testi e layout, ma ottimizzano keyword per migliorare il posizionamento SEO, replicano API di validazione e implementano commenti esplicativi per rendere il codice più credibile.

Tecniche come il SEO poisoning amplificano la portata degli attacchi, mentre le capacità di adattamento dell’AI permettono varianti continue di siti e messaggi, aumentando la persistenza delle minacce.

Impatti delle operazioni AI

Gli impatti di queste operazioni si estendono dal furto di dati personali alla manipolazione politica su larga scala. Negli Stati Uniti, influencer e politici subiscono campagne di disinformazione coordinate, mentre in Brasile i cittadini affrontano perdite economiche e furti d’identità. Secondo Zscaler, le frodi legate al phishing AI generativo superano già milioni di euro di danni cumulativi. Le implicazioni sono anche sociali: erosione della fiducia nei media, divisione dell’opinione pubblica e indebolimento della coesione democratica. A livello geopolitico, la Cina ottiene vantaggi strategici nelle guerre ibride dell’informazione, esportando tattiche che potrebbero essere replicate in altre aree del mondo.

Contromisure contro AI malevola

La risposta passa da contromisure scalabili e integrate. Nakasone e Zscaler raccomandano un’architettura zero trust, con verifiche di identità rafforzate, MFA universale e monitoraggio continuo del codice sorgente per rilevare firme tipiche della generazione AI. Le piattaforme social devono investire in sistemi di rilevamento dei profili falsi, mentre le aziende devono formare personale e utenti a riconoscere contenuti e siti sospetti. Tool di threat intelligence e filtri AI difensivi sono già in sviluppo, insieme a collaborazioni internazionali per lo scambio di intelligence e la regolamentazione dell’uso malevolo dell’AI. Il phishing AI-based sfrutta tool come DeepSite AI per clonare in pochi minuti siti governativi, integrando API di validazione e codice con TailwindCSS e commenti autoesplicativi. Questa automazione riduce il tempo di sviluppo da ore a minuti, permettendo agli attaccanti di scalare le campagne in modo esponenziale e di aggirare i sistemi di rilevamento tradizionali.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.