L’annuncio di OpenAI di una serie di interventi urgenti su GPT-5 arriva dopo giorni di polemiche diffuse e un’ondata di critiche da parte della community. La società guidata da Sam Altman ha riconosciuto pubblicamente i problemi di performance, le risposte troppo brevi e una percepita mancanza di creatività che hanno alimentato un vero e proprio contraccolpo. Per contenere la crisi, l’azienda ha introdotto un raddoppio dei limiti di utilizzo per gli utenti paganti e ha reintrodotto l’accesso a GPT-4o tramite un toggle dedicato, offrendo così la possibilità di passare rapidamente tra modelli. La mossa non solo risponde alle esigenze immediate degli utenti, ma segnala anche un cambio di strategia verso maggiore trasparenza e controllo diretto sulla scelta dei modelli.

Aggiornamenti e fix per GPT-5

OpenAI ha confermato di aver identificato e corretto un bug legato all’autoswitcher, responsabile di un improvviso calo di qualità percepito da molti come un passo indietro nelle capacità di ragionamento. Secondo Altman, l’errore avrebbe reso GPT-5 “più stupido” per parte della giornata, generando frustrazione soprattutto tra i creatori di contenuti. Il rollout del fix è già iniziato e include un nuovo toggle per forzare il ragionamento, pensato per restituire maggiore profondità alle risposte. L’interfaccia è stata aggiornata per mostrare in modo chiaro quale modello stia rispondendo a ogni query, un passo verso quella trasparenza operativa più volte richiesta dalla community. La società ha inoltre annunciato test interni per valutare la stabilità del modello e prevenire futuri malfunzionamenti.

Le reazioni della community e le criticità emerse

Le segnalazioni degli utenti si sono concentrate su tre aree: la brevità delle risposte, le difficoltà nei compiti creativi e i malfunzionamenti in operazioni logiche o matematiche complesse. Test indipendenti hanno mostrato come GPT-5 sia effettivamente più veloce e performante in compiti di programmazione, ma meno convincente nella scrittura e nella generazione di testi lunghi. Alcuni utenti hanno ipotizzato un throttling intenzionale dei token per ridurre i costi operativi, mentre altri hanno evidenziato problemi di loop infiniti e sessioni bloccate. La mancanza iniziale di un’opzione per tornare ai modelli precedenti ha ulteriormente alimentato il malcontento, con numerosi creativi e professionisti che hanno dichiarato di preferire GPT-4o per i propri flussi di lavoro.

Raddoppio dei limiti di utilizzo per gli abbonati

In risposta alle lamentele, OpenAI ha deciso di raddoppiare i limiti rate per gli utenti Plus e Pro, un intervento mirato a ridurre l’impatto delle restrizioni quando si lavora con GPT-5, che richiede più token per funzioni di ragionamento avanzate. La modifica, già in fase di rollout globale, dovrebbe completarsi nei prossimi giorni e promette di migliorare sensibilmente la produttività di chi utilizza il modello per attività professionali. Secondo Altman, l’aumento dei limiti si inserisce in una strategia di fidelizzazione degli utenti paganti, riducendo le interruzioni e garantendo maggiore continuità nell’esperienza d’uso.

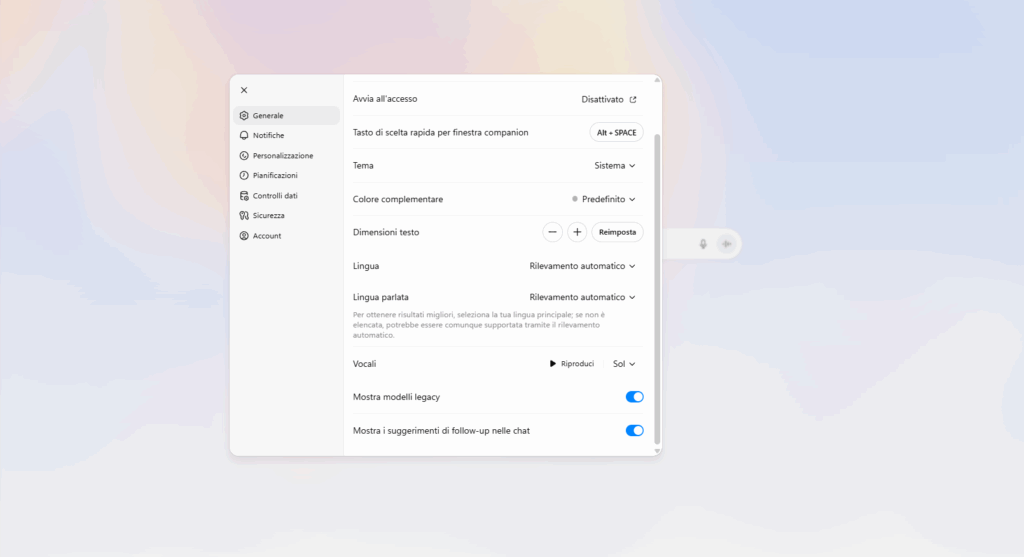

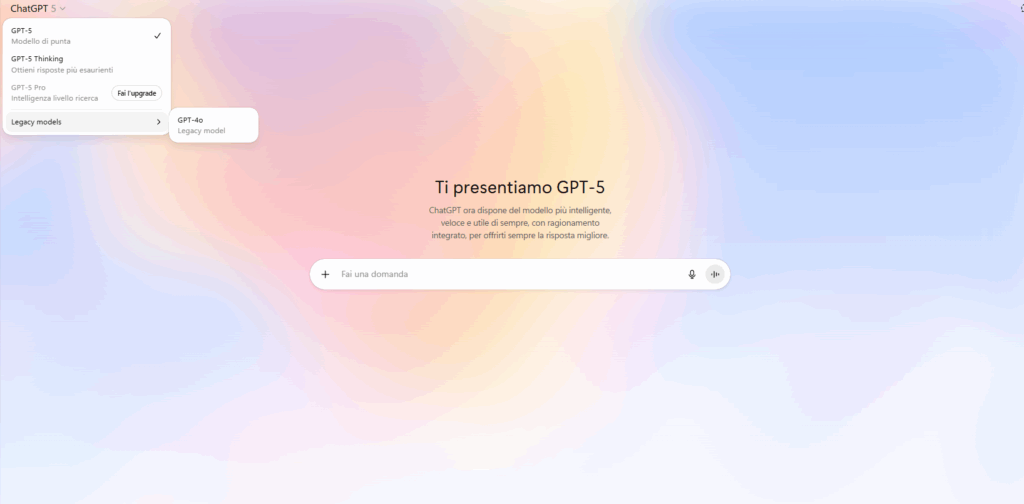

Ripristino di GPT-4o e gestione dei modelli legacy

Il ritorno di GPT-4o è stato reso possibile da un nuovo toggle nelle impostazioni dell’account, accessibile agli utenti Plus e Pro. Attivando l’opzione “Show legacy models”, è possibile selezionare GPT-4o direttamente dal menu dei modelli senza rinunciare a GPT-5. OpenAI ha chiarito che la disponibilità dei modelli legacy sarà monitorata in base all’uso e al feedback ricevuto, e che la funzione potrebbe rimanere solo temporanea.

Questa scelta mira a restituire flessibilità operativa agli utenti e a placare il malcontento legato all’obbligo di usare esclusivamente il modello più recente. L’azienda ha anche ottimizzato l’interfaccia di selezione per facilitare il passaggio tra le opzioni, riducendo i passaggi manuali e i tempi di attivazione.

Piani futuri e miglioramenti in arrivo

Guardando avanti, OpenAI ha dichiarato di voler proseguire con un piano di fix continui e miglioramenti iterativi per GPT-5. Tra le novità in fase di sviluppo figura un sistema di valutazione interna delle risposte, finalizzato a monitorare la qualità e identificare rapidamente eventuali cali di performance. L’azienda punta inoltre a potenziare le capacità creative del modello, mantenendo al contempo la superiorità nelle attività di coding e analisi dati. La trasparenza rimarrà un elemento chiave, con la promessa di rendere sempre visibile all’utente quale modello sta elaborando la richiesta e di fornire dettagli tecnici sui futuri aggiornamenti. La gestione dei modelli legacy sarà anch’essa oggetto di revisione, con la possibilità di rendere alcune versioni precedenti permanenti in base alla domanda. Il sistema di toggle introdotto da OpenAI funziona attraverso un flag di backend che autorizza l’accesso ai modelli precedenti per gli account Plus e Pro. Una query API verifica le versioni disponibili e aggiorna dinamicamente il selettore nell’interfaccia. L’attivazione persiste nelle sessioni del browser e sfrutta una cache locale per garantire cambi rapidi, riducendo così la latenza nelle richieste. Questo meccanismo, oltre a migliorare l’esperienza d’uso, permette di raccogliere dati sull’effettivo utilizzo dei modelli legacy, influenzando le decisioni future sulla loro disponibilità.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.