NVIDIA presenta Blackwell come piattaforma per l’inferenza AI su larga scala, ridisegnando i limiti dei data center e introducendo sistemi rack-scale come GB200 NVL72, che agiscono come un singolo GPU massiccio. Questa soluzione permette di gestire modelli da centinaia di miliardi a trilioni di parametri, addestrati su decine di trilioni di token provenienti da testi, immagini e video. Con partner come CoreWeave, NVIDIA applica Blackwell a implementazioni reali, trasformando le fabbriche AI in ambienti scalabili e resilienti. Ogni elemento della piattaforma, dall’integrazione hardware-software alla gestione energetica, è pensato per ottimizzare latenza, throughput e sostenibilità. L’adozione di NVLink, BlueField-3, TensorRT-LLM e l’OS Dynamo rende Blackwell il fulcro delle future infrastrutture AI globali.

Capacità di inferenza AI di Blackwell

Le capacità di Blackwell si concentrano sulla gestione di modelli AI con centinaia di miliardi di parametri, già oggi al servizio di quasi un miliardo di utenti settimanali. La piattaforma nasce per supportare modelli futuri oltre il trilione di parametri, addestrati con dataset multimodali di dimensioni senza precedenti. L’architettura riduce la dipendenza da risorse fisiche tradizionali e massimizza la condivisione di memoria grazie all’integrazione diretta tra GPU e CPU tramite NVLink. La bassa latenza e l’efficienza energetica sono priorità, perché ogni nanosecondo e ogni watt determinano i costi operativi delle fabbriche AI. Con il supporto a TensorRT-LLM v0.13, la piattaforma ottimizza workflow complessi, gestendo inferenze real-time su larga scala e integrandosi con ecosistemi cloud ed enterprise esistenti.

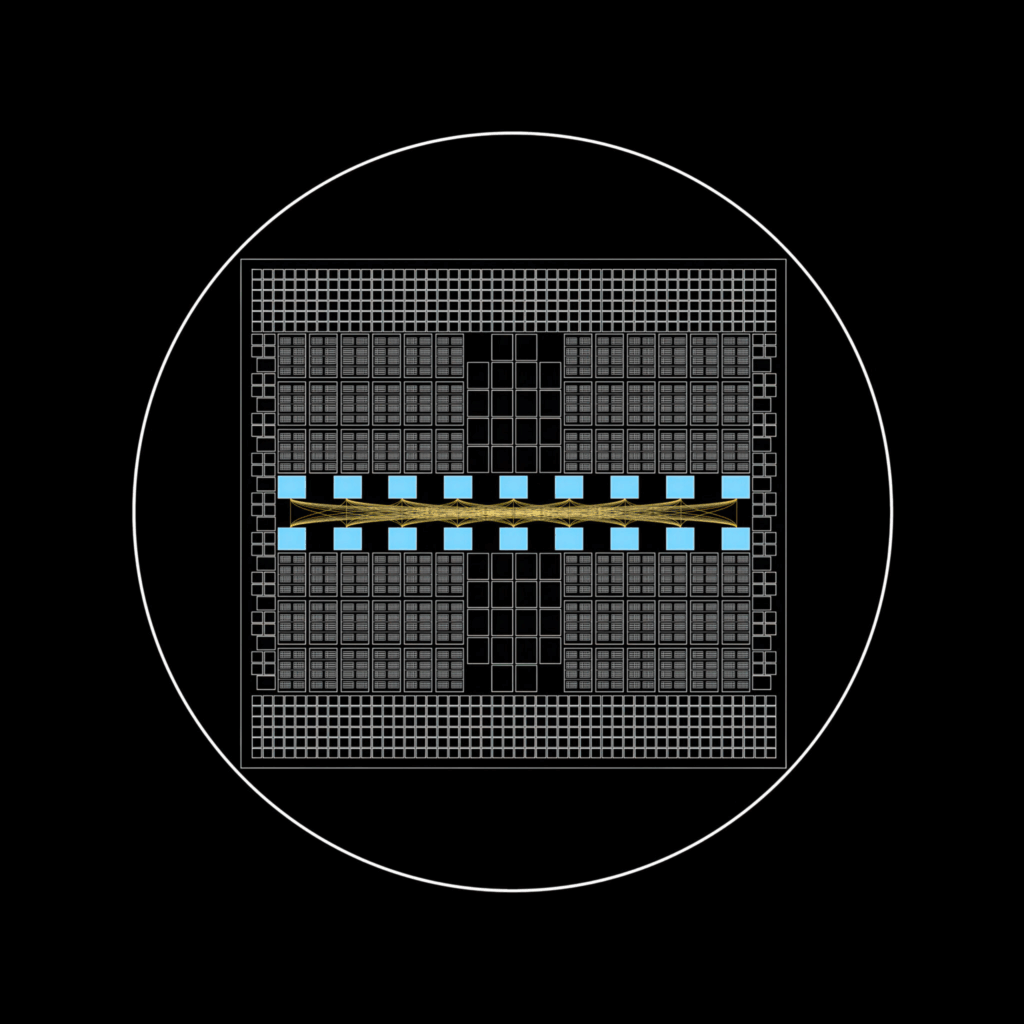

Il sistema GB200 NVL72 di NVIDIA

Il sistema GB200 NVL72 rappresenta il cuore fisico dell’architettura Blackwell, configurato come rack-scale unitario. Integra 72 GPU distribuite in 18 tray computazionali, collegate tramite oltre 5000 cavi copper ad alte prestazioni e capaci di muovere dati a 130 TB/s. Il superchip Grace Blackwell, formato da due GPU Blackwell e una CPU Grace, abilita la condivisione diretta della memoria, riducendo la latenza e aumentando le prestazioni di un ordine di grandezza rispetto alle generazioni precedenti. Il sistema, dal peso di oltre una tonnellata e mezzo e composto da oltre 600000 parti, unisce ConnectX-7 NIC, InfiniBand Quantum-X800, Spectrum-X Ethernet e BlueField-3 DPU, garantendo affidabilità e throughput elevati. Con Dynamo OS, le operazioni di orchestrazione diventano più semplici, rendendo possibile la gestione coordinata di flotte GPU per applicazioni mission-critical.

Integrazioni e tecnologie NVIDIA in Blackwell

L’ecosistema Blackwell integra una suite di tecnologie pensate per massimizzare prestazioni e resilienza. La connettività interna è affidata a NVLink, che unisce CPU e GPU in un’unica architettura coesa. La rete tra rack sfrutta Spectrum-X Ethernet e Quantum-X800 InfiniBand, capaci di supportare data center su scala globale. La gestione di task non AI viene affidata a BlueField-3 DPU, liberando le GPU da operazioni di networking e storage. L’orchestrazione dei carichi di lavoro è affidata a Dynamo OS, che coordina le richieste di inferenza distribuite. La piattaforma integra inoltre raffreddamento con vapor chamber, cifratura end-to-end e metriche di sostenibilità per ridurre l’impatto ambientale. Compatibilità retroattiva e SDK completi favoriscono gli sviluppatori, mentre l’integrazione con tool open-source rende la piattaforma accessibile a una comunità più ampia.

Partnership e applicazioni di Blackwell

Blackwell si diffonde grazie a una rete di oltre 200 partner tecnologici e più di 150 stabilimenti produttivi nel mondo. Tra le applicazioni concrete, spiccano le infrastrutture cloud di CoreWeave e il supercomputer Colossus di xAI, che impiega oltre 200000 GPU NVIDIA. La piattaforma è stata implementata in soli 122 giorni, dimostrando tempi di adozione rapidi per progetti su larga scala. Le industrie verticali, dalla sanità alla finanza, adottano Blackwell per analytics avanzati e compliance normativa, mentre i cloud provider globali come AWS e Azure ne integrano i sistemi nei loro servizi. L’architettura supporta applicazioni multimodali, veicoli autonomi, IoT e fabbriche intelligenti, democratizzando l’accesso a inferenze complesse e riducendo i costi di ingresso per le startup.

Dettagli tecnici e prestazioni di Blackwell

Dal punto di vista tecnico, Blackwell unisce due GPU Blackwell e una CPU Grace in un superchip collegato tramite NVLink, abilitando prestazioni superiori e riduzione della latenza. Il NVLink Switch spine connette 72 GPU a 130 TB/s, mentre le connessioni Ethernet a 400 Gbps e le ConnectX-7 NIC garantiscono interoperabilità con i data center. La piattaforma integra oltre due miglia di cablaggi, milioni di linee di codice e metriche di performance avanzate, permettendo il monitoraggio continuo dell’efficienza. La resilienza è garantita da ridondanza hardware, firmware aggiornabili e compatibilità con ambienti mission-critical. L’approccio green computing si traduce in consumi ottimizzati per watt, con metriche di carbon footprint e automazione dinamica delle risorse per sostenibilità a lungo termine.

Implicazioni per l’ecosistema AI con Blackwell

Con Blackwell, NVIDIA consolida la propria leadership nell’inferenza AI estrema, trasformando i data center in vere e proprie fabbriche scalabili. La piattaforma riduce le barriere di accesso per le imprese, democratizza l’uso di modelli multimodali e garantisce resilienza globale attraverso automazione, sicurezza integrata e compliance normativa. L’impatto riguarda settori come la ricerca, la sanità, la finanza e i trasporti, con applicazioni che spaziano dal cloud all’edge computing. Blackwell si inserisce come base per evoluzioni future, comprese le applicazioni legate a modelli quantistici e a infrastrutture ibride 5G. In questo scenario, ogni watt risparmiato e ogni nanosecondo guadagnato diventano fattori determinanti per la sostenibilità e l’efficienza delle fabbriche AI di nuova generazione.

NVIDIA rivoluziona le imprese con agenti AI

NVIDIA introduce agenti AI progettati per trasformare le imprese, aumentando produttività e ricavi grazie a un onboarding strategico e a infrastrutture ottimizzate per l’AI. Questi agenti operano come partner decisionali, gestendo processi complessi e preservando conoscenza istituzionale per ridurre perdite dovute al turnover. Servono quasi un miliardo di utenti a settimana e sono pensati per evolvere verso modelli con trilioni di parametri addestrati su testi, immagini e video. Con piattaforme integrate, NVIDIA ridisegna i data center per uno scale-up estremo, garantendo bassa latenza, massima efficienza energetica e throughput elevato grazie a tecnologie come TensorRT-LLM, BlueField-3 DPU, NVLink e GB200 NVL72. Gli agenti AI diventano repository dinamici di sapere, personalizzano l’esperienza cliente e supportano funzioni avanzate come generazione di codice, video analytics e assistenza contestuale.

Onboarding agenti AI nelle imprese

L’onboarding degli agenti AI avviene in fasi definite che permettono alle aziende di scegliere modelli per linguaggio, visione e ragionamento. NVIDIA utilizza NIM microservices per swap rapidi dei modelli e integra pipeline dati robuste capaci di fornire informazioni contestuali in tempo reale. Con NeMo microservices, l’azienda abilita un data flywheel che raccoglie e raffina continuamente i dati, migliorando l’accuratezza dei modelli. Le imprese partono da progetti pilota e scalano gradualmente fino a deployment estesi, con applicazioni che vanno dalla gestione IT alla pianificazione di risorse e supply chain. La governance è garantita da NeMo Guardrails, che implementa controlli su sicurezza, policy e contenuti, bloccando output manipolati o non etici. Questa combinazione riduce rischi, assicura compliance e migliora l’affidabilità operativa.

Tecnologie NVIDIA per agenti AI

Le tecnologie NVIDIA abilitano agenti AI flessibili e sicuri. Con i NIM microservices, le imprese collegano strumenti specifici e personalizzano i modelli secondo le esigenze. NeMo Guardrails applica linee guida dominio-specifiche, moderazione dei contenuti e protezioni contro jailbreak prompt, mentre le metriche integrate consentono monitoraggio e ottimizzazione continua. L’infrastruttura si basa su NVLink per la condivisione rapida della memoria, BlueField-3 DPU per l’offload dei task non AI e TensorRT-LLM per la gestione di modelli complessi. L’ecosistema supporta deployment ibridi su cloud e data center, riduce consumi energetici e garantisce resilienza grazie a ridondanza e automazione. Le aziende possono così ridurre costi operativi, massimizzare ROI e integrare pipeline di automazione che semplificano i workflow.

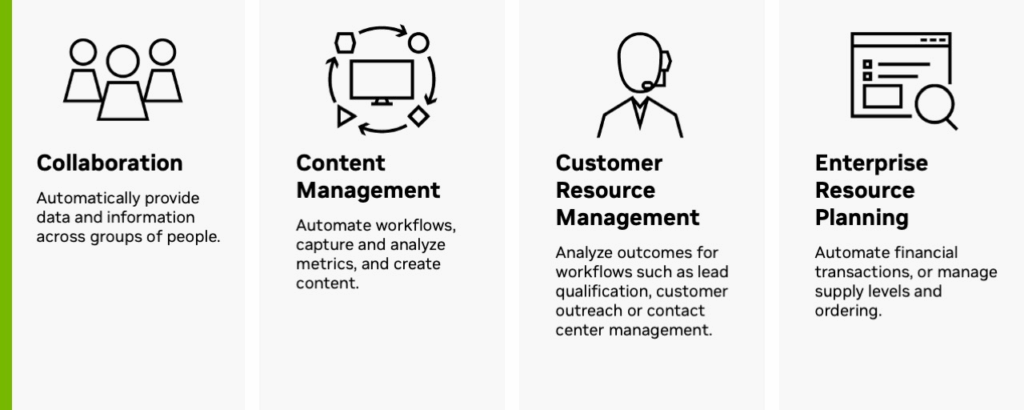

Applicazioni pratiche degli agenti AI

Gli agenti AI trovano applicazione in diversi settori. Nelle telecomunicazioni, con Amdocs amAIz, gestiscono percorsi clienti multistep che coprono vendite, billing e customer care, oltre a pianificare reti autonome. Nel campo IT ottimizzano ticketing e accesso ai dati per ingegneri, mentre nel finance automatizzano transazioni e gestione delle forniture. In ambito industriale analizzano video per ispezioni dei siti, rilevano difetti nei prodotti e migliorano la qualità della produzione. Integrati nei sistemi ERP e CRM, supportano personalizzazione delle esperienze cliente e riduzione dei tempi di risposta. Grazie a capacità multimodali, elaborano dati testuali e visivi in modo integrato, fornendo insights contestuali che migliorano decisioni strategiche. Questa versatilità rende gli agenti NVIDIA strumenti chiave per affrontare mercati dinamici, ridurre i rischi decisionali e garantire competitività continua.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.