Il 2025 segna una fase cruciale per l’evoluzione dell’intelligenza artificiale globale, con Google, OpenAI e Meta protagoniste di un’ondata di aggiornamenti che spazia dall’ottimizzazione delle infrastrutture per sviluppatori alla ricerca sull’efficienza dei modelli linguistici di grandi dimensioni (LLM). Le tre aziende delineano strategie convergenti verso un’AI più accessibile, scalabile e integrata nei contesti quotidiani, industriali e istituzionali.

Google unifica sviluppo AI con Gemini API e AI Studio

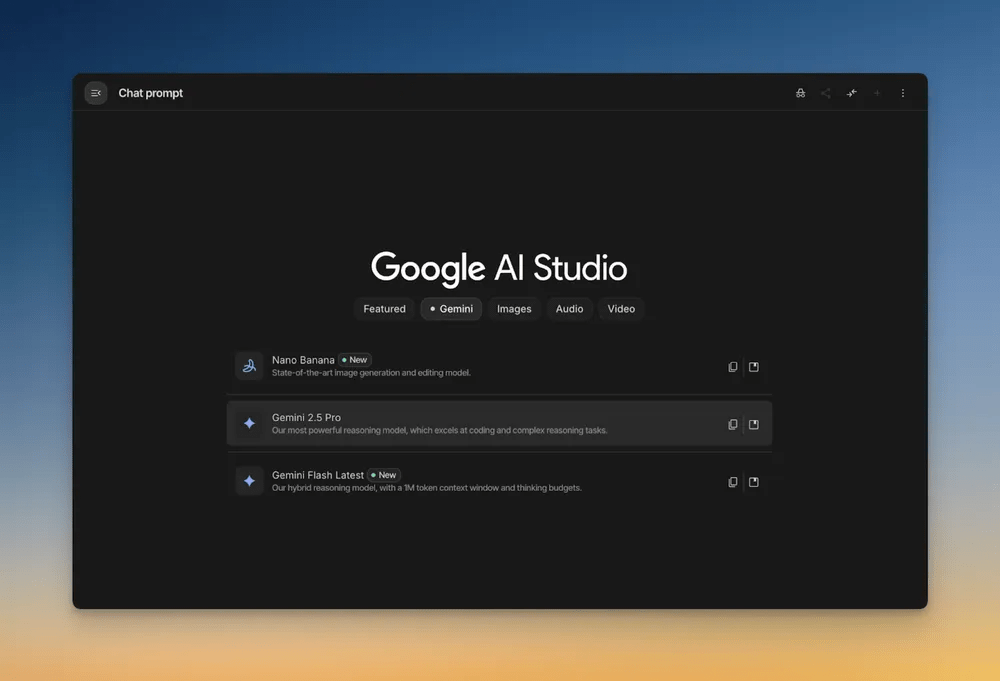

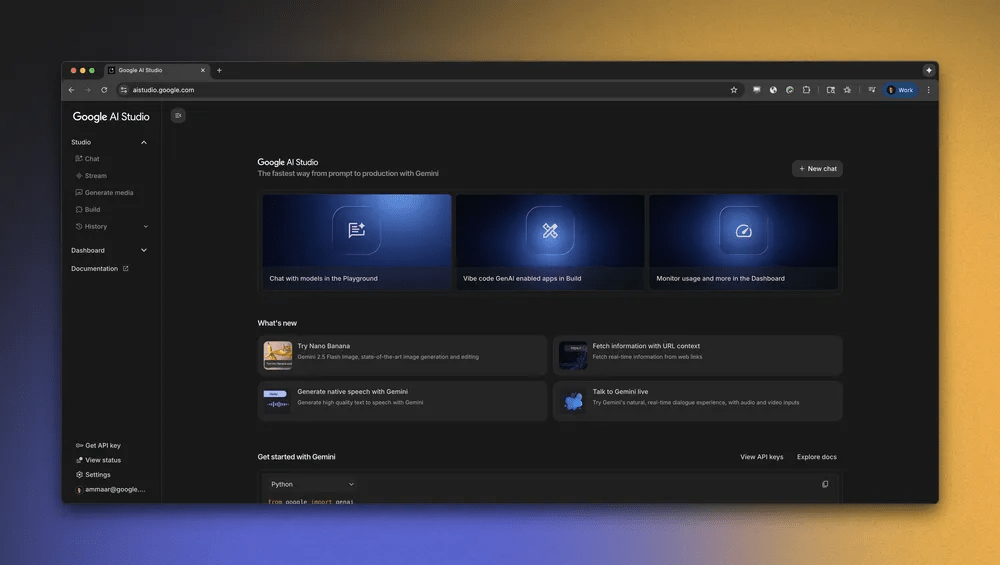

Google introduce una profonda revisione del proprio ecosistema per sviluppatori, lanciando la nuova versione di Google AI Studio e ampliando le funzionalità della Gemini API. L’obiettivo è semplificare l’intero flusso di lavoro dell’AI development, riducendo il numero di passaggi tra tool e favorendo la sperimentazione diretta di prompt, generazione multimediale e integrazione di dati reali.

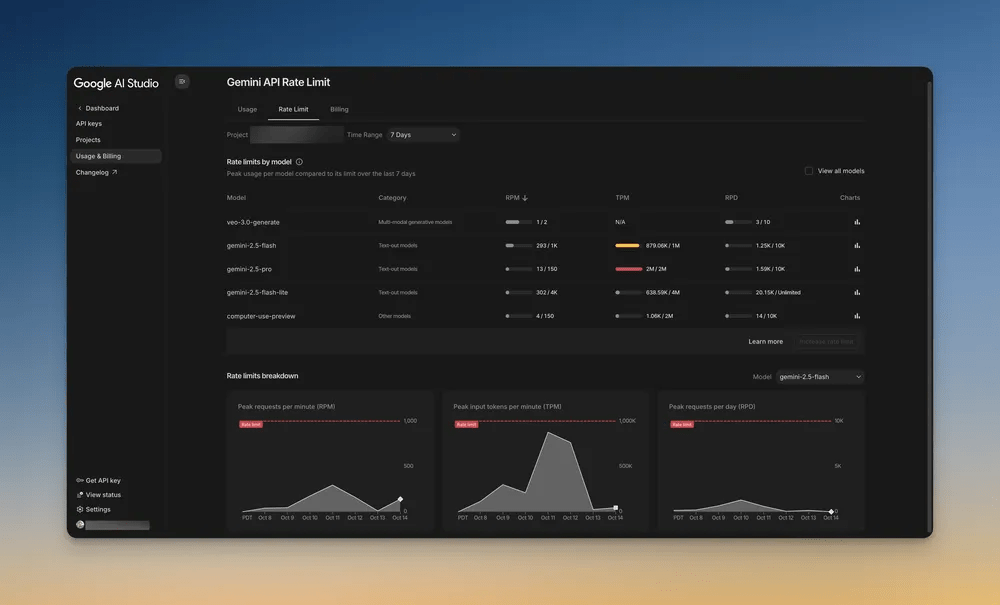

Il nuovo playground unificato consente di passare in modo fluido da input testuali a generazioni multimodali, includendo immagini e dati geografici. La homepage ridisegnata funge da vero e proprio command center, mostrando progetti recenti, rate limit in tempo reale e risorse API utilizzate. Questo approccio elimina la frammentazione tra esperienze di test e ambienti di produzione.

Una delle innovazioni più rilevanti è l’integrazione del grounding geografico tramite Google Maps, che collega i modelli Gemini a oltre 250 milioni di luoghi reali nel mondo. Gli sviluppatori possono ora ancorare le risposte AI a dati strutturati provenienti da Maps, Search e recensioni verificate, ottenendo risposte contestuali e pertinenti per applicazioni come viaggi, logistica e real estate.

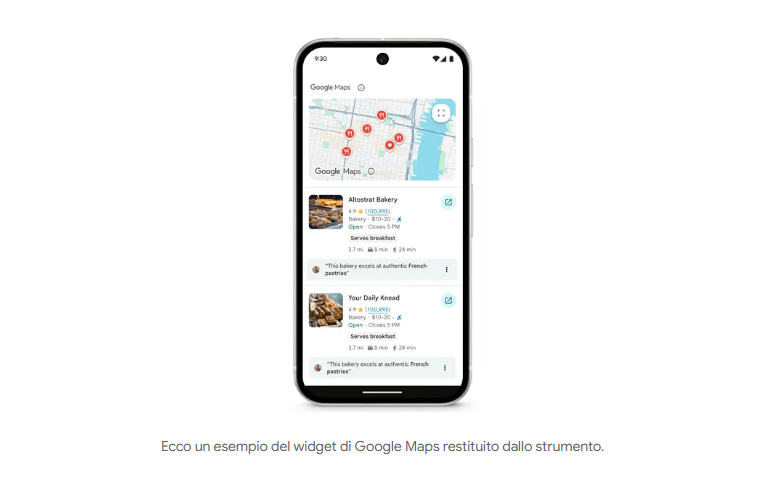

Google ha pubblicato esempi in Python SDK che mostrano come incorporare map widget, recensioni e immagini direttamente nelle risposte dei modelli, aprendo la strada a applicazioni iper-locali intelligenti. Gli esperti parlano di un passo decisivo verso una AI geoconsapevole, in grado di comprendere il contesto spaziale delle interazioni umane e digitali.

Gemini API e il nuovo paradigma del grounding

Con la nuova versione della Gemini API, Google porta il concetto di grounding a un livello superiore. Il sistema analizza automaticamente query con riferimenti geografici e restituisce risultati arricchiti da dati verificati, orari, indirizzi e recensioni. Questa capacità migliora la qualità e la coerenza delle risposte, riducendo il margine d’errore dei modelli generativi.

L’integrazione tra Maps e Search crea una sinergia unica: i primi forniscono la struttura geografica, i secondi il contesto narrativo e semantico. Il risultato è una AI contestuale, multimodale e affidabile, capace di generare itinerari, raccomandazioni di quartiere o suggerimenti personalizzati in base alla posizione dell’utente.

I primi test su Google AI Studio mostrano una riduzione della latenza di risposta e una maggiore precisione nel recupero di informazioni locali. Il nuovo framework offre trasparenza nei costi e nei limiti di utilizzo, semplificando la gestione di progetti complessi e migliorando la scalabilità delle applicazioni AI.

OpenAI smentisce GPT-6 e perfeziona GPT-5 con nuove modalità

Mentre le voci su un ipotetico GPT-6 continuano a circolare sui social, OpenAI ha smentito ufficialmente qualsiasi piano di rilascio nel 2025. L’azienda preferisce concentrare gli sforzi sul perfezionamento di GPT-5, introducendo aggiornamenti strutturali che migliorano il ragionamento automatico e l’efficienza delle query. Il modello ora include una modalità automatica di bilanciamento che alterna dinamicamente tra “reasoning mode” per compiti complessi e “instant mode” per risposte rapide. Questa architettura ibrida consente di ridurre i tempi di elaborazione per task semplici e di aumentare la profondità analitica per le richieste più articolate, mantenendo un equilibrio tra potenza e costi computazionali. OpenAI definisce questa strategia una “iterazione silenziosa”: niente nuove versioni numerate, ma un’evoluzione costante di GPT-5, ottimizzata su base mensile. Gli aggiornamenti includono anche un sistema di auto-switching integrato, capace di determinare in modo autonomo la modalità di risposta più adatta. Questa scelta riflette la volontà di OpenAI di spostare il focus dalla corsa alle release verso un paradigma di maturità e stabilità del modello, rendendo GPT-5 una piattaforma di lungo periodo per applicazioni pubbliche e aziendali.

Meta spinge i limiti del parallelismo per LLM

Sul versante infrastrutturale, Meta concentra la propria ricerca sull’efficienza dell’inferenza nei modelli linguistici di grandi dimensioni, come LLaMA 3. L’azienda sviluppa nuove tecniche di tensor parallelism e context parallelism per ridurre latenza e costi computazionali, mantenendo prestazioni elevate su reti di GPU eterogenee.

Tra le innovazioni più rilevanti spiccano le soluzioni DDA Flat e DDA Tree, che ottimizzano la comunicazione inter-GPU, portando a una riduzione del tempo di inferenza fino al 50% rispetto ai framework standard NCCL. Meta introduce inoltre un sistema di expert parallelism dinamico per architetture Mixture of Experts (MoE), in grado di distribuire in modo intelligente il carico di lavoro su GPU attive, abbattendo la latenza di comunicazione del 30%. Le nuove ottimizzazioni consentono di eseguire il prefill di 1 milione di token in meno di un minuto su GPU H100, e di gestire contesti lunghi fino a 10 milioni di token su 32 nodi. L’obiettivo è creare un’architettura di LLM scalabile e adattiva, capace di servire miliardi di utenti senza sacrificare velocità o accuratezza. Meta dichiara che queste innovazioni ridurranno significativamente il TTFT (Time To First Token) sotto i 350 millisecondi e il TTIT (Time To Interactive Token) a meno di 25 millisecondi, portando i suoi modelli AI di consumo – come quelli integrati in Facebook, Instagram e WhatsApp – a una reattività senza precedenti.

Google pubblica report sull’AI per governi e crescita economica

Oltre agli aggiornamenti per sviluppatori, Google ha pubblicato il report “AI Works for Governments”, uno studio che analizza l’impatto dell’intelligenza artificiale sui sistemi pubblici e sull’economia globale. Secondo il documento, l’adozione dell’AI può incrementare la produttività amministrativa del 3%, ridurre i deficit federali del 22% e aumentare il PIL nazionale del 4% in media, con un miglioramento del reddito familiare del 2%. Il report, realizzato in collaborazione con PwC, identifica quattro archetipi di maturità nell’adozione dell’AI: Explorers, Infrastructure Ready, Governance Ready e Leaders. Ogni categoria rappresenta un livello di prontezza tecnologica e regolatoria, offrendo ai governi una roadmap di implementazione sostenibile. Google raccomanda politiche cloud-first, formazione del personale pubblico e un approccio “all-government” per favorire l’integrazione dell’AI nei servizi sociali, fiscali e infrastrutturali. Il documento evidenzia come l’intelligenza artificiale stia diventando una leva strategica per trasformare la burocrazia in efficienza digitale, migliorando trasparenza e accessibilità dei servizi.

Una nuova fase per l’intelligenza artificiale globale

Le innovazioni annunciate da Google, OpenAI e Meta non rappresentano semplici aggiornamenti, ma l’inizio di una nuova fase nella maturazione dell’Intelligenza artificiale: una tecnologia che diventa più contestuale, efficiente e democratica. Mentre Google punta all’integrazione del mondo reale con il digitale, OpenAI raffina l’intelligenza generativa con equilibrio e stabilità, e Meta rivoluziona la velocità di esecuzione dei modelli su larga scala. Insieme, queste evoluzioni tracciano la rotta verso un’AI sempre più interconnessa, responsabile e accessibile, pronta a trasformare settori come sanità, finanza, pubblica amministrazione e mobilità.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.