Meta Llama 3, il potente modello di linguaggio di Meta, è ora disponibile su più piattaforme cloud, rendendolo accessibile agli sviluppatori di tutto il mondo per una vasta gamma di applicazioni AI: ecco le reazioni di Google, Amazon ed NVIDIA al nuovo arrivato in casa Zuckerberg.

Matrice Digitale l’ha già provato nonostante non sia ancora disponibile in italia

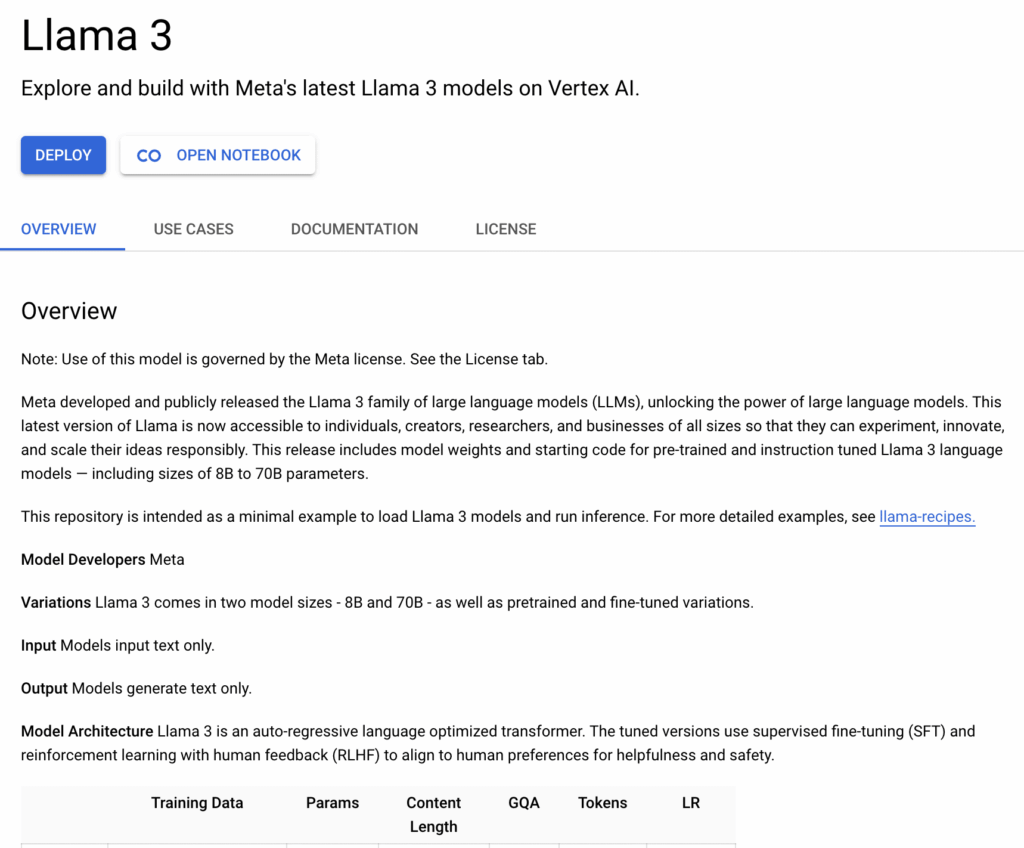

Google Cloud Vertex AI

Google Cloud ha annunciato l’integrazione di Meta Llama 3 nel suo Vertex AI, offrendo agli sviluppatori strumenti avanzati per personalizzare il modello con i propri dati. Questa integrazione permette di affinare il modello utilizzando tecniche di tuning supervisionate e rinforzo attraverso feedback umano. Gli sviluppatori possono anche valutare i modelli affinati direttamente in Model Garden di Vertex AI o utilizzare lo strumento di valutazione comparativa, Auto SxS. Con supporto per hardware all’avanguardia, come TPU e GPU, Google Cloud Vertex AI facilita l’ottimizzazione e il deployment di Llama 3 per casi d’uso specifici.

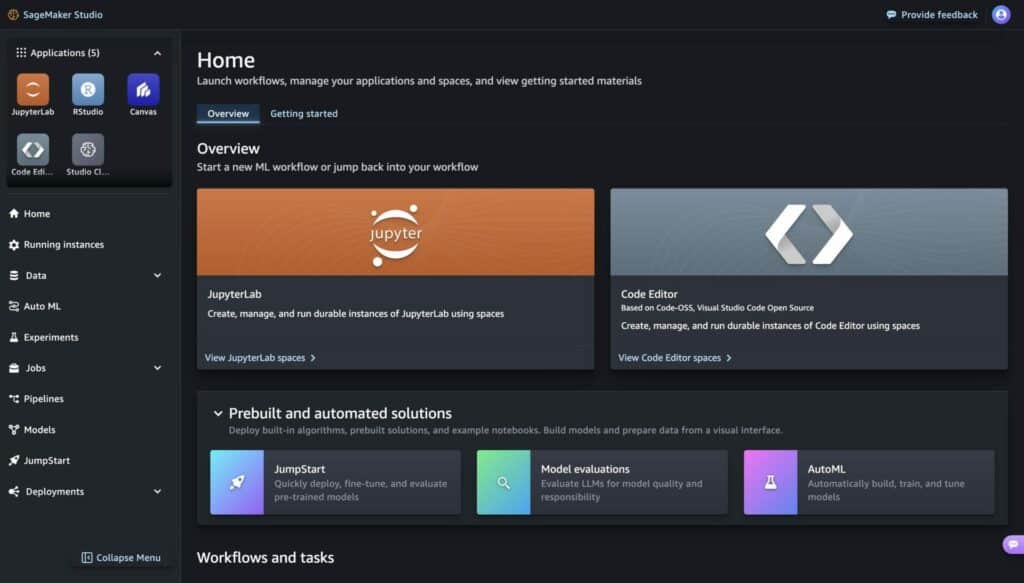

Amazon SageMaker JumpStart

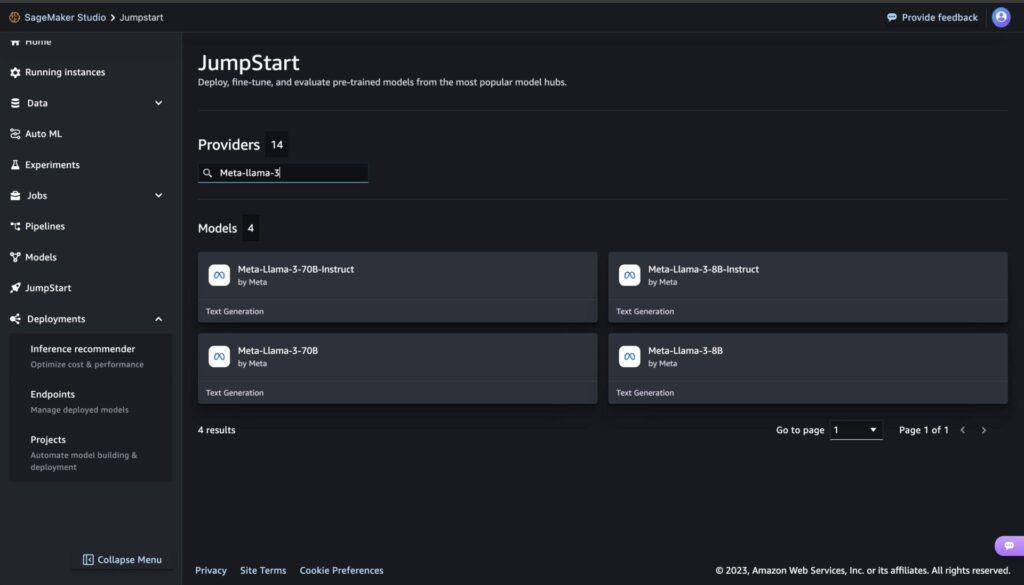

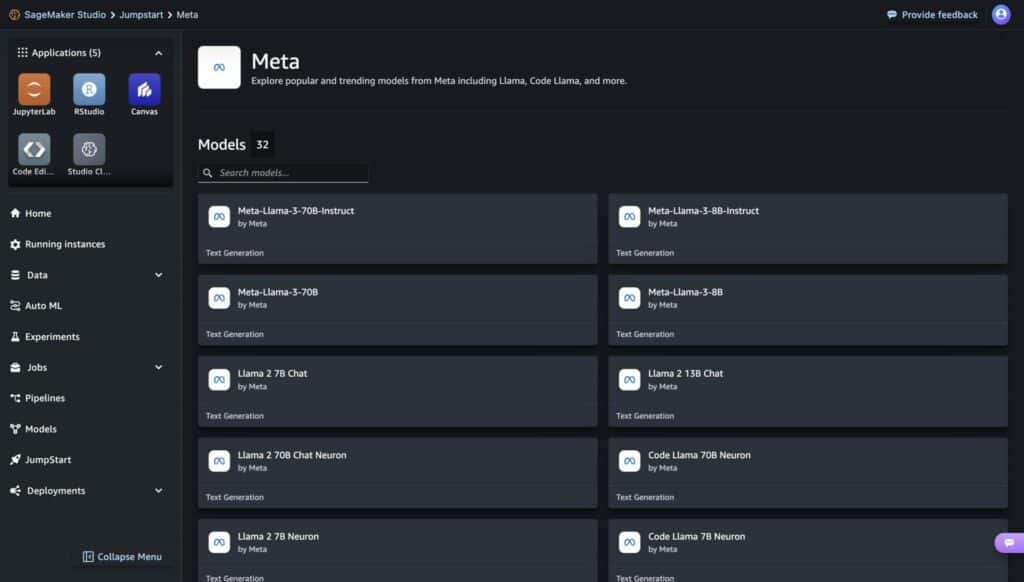

Parallelamente, Amazon ha reso disponibili i modelli Llama 3 attraverso SageMaker JumpStart, permettendo di deployare e eseguire inferenze facilmente. Con opzioni di due dimensioni di modello, 8B e 70B, Llama 3 supporta una vasta gamma di casi d’uso, migliorando capacità di ragionamento, generazione di codice e seguimento di istruzioni. Gli sviluppatori possono utilizzare SageMaker per deployare i modelli in ambienti isolati di rete e personalizzarli per addestramenti e deployment specifici, mantenendo la sicurezza dei dati sotto il controllo VPC.

Disponibilità su Amazon SageMaker JumpStart

Amazon SageMaker JumpStart facilita il deployment e l’utilizzo dei modelli di Meta Llama 3, rendendoli accessibili attraverso un ambiente di rete isolato e sicuro. Con due varianti del modello, da 8B e 70B, Llama 3 è ideale per una vasta gamma di applicazioni, dalle task di ragionamento e generazione di codice fino al seguire istruzioni complesse.

Caratteristiche e Funzionalità

L’architettura di Llama 3 si basa su un transformer decoder-only con un nuovo tokenizer che migliora la performance del modello. Le caratteristiche include:

- Flessibilità: I modelli possono essere addestrati con tecniche di fine-tuning per adattarsi a specifici dati e necessità.

- Valutazione e personalizzazione: Con SageMaker, gli sviluppatori possono personalizzare e valutare i modelli affinati direttamente all’interno dell’ambiente SageMaker, utilizzando strumenti come SageMaker Pipelines e Debugger.

- Sicurezza dei dati: Il deployment sotto i controlli VPC di AWS garantisce che i dati restino protetti durante l’uso dei modelli.

Implementazione e Utilizzo

Il deployment di Llama 3 attraverso SageMaker JumpStart è semplice e intuitivo, offrendo agli utenti la possibilità di sviluppare i modelli con pochi clic. Inoltre, gli sviluppatori possono sfruttare notebook di esempio per guidarli attraverso l’intero processo di deployment e inferenza.

Regioni AWS Disponibili

I modelli Llama 3 sono disponibili per il deployment in SageMaker Studio nelle regioni AWS di N. Virginia, Ohio, Oregon, Irlanda e Tokyo, assicurando così una vasta copertura geografica e prestazioni ottimali.

NVIDIA e l’Accelerazione dell’Inferenza

NVIDIA ha ottimizzato Llama 3 per accelerare l’inferenza su tutte le sue piattaforme hardware. Grazie al supporto per le GPU NVIDIA H100 Tensor Core, Llama 3 può essere eseguito in modo efficiente su cloud, data center, dispositivi edge e PC. Queste ottimizzazioni permettono a Llama 3 di supportare un maggior numero di utenti simultaneamente, rendendolo ideale per applicazioni che richiedono alta scalabilità e bassa latenza.

Dettagli sulle Ottimizzazioni

Meta Llama 3 è stato addestrato su un cluster di computer che incorpora 24,576 GPU NVIDIA H100 Tensor Core, connesse attraverso una rete NVIDIA Quantum-2 InfiniBand. Questo imponente hardware ha permesso a Meta di ottimizzare la rete, il software e le architetture dei modelli per il loro modello di linguaggio di punta, Llama 3.

Applicazioni Pratiche di Llama 3

Le versioni di Llama 3, accelerate su GPU NVIDIA, sono ora disponibili per l’uso nel cloud, nei data center, al bordo della rete e sui PC. Gli sviluppatori possono accedere a Llama 3 tramite un microservizio NVIDIA NIM con un’API standard, che può essere distribuito ovunque. Inoltre, le aziende possono personalizzare Llama 3 con i loro dati utilizzando il framework open source NVIDIA NeMo, parte della piattaforma NVIDIA AI Enterprise.

Performance e Utilizzo

Le pratiche ottimali per il deployment di un LLM per un chatbot prevedono un equilibrio tra bassa latenza, buona velocità di lettura e uso ottimale della GPU per ridurre i costi. Per esempio, un singolo GPU NVIDIA H200 Tensor Core può generare circa 3,000 token al secondo, sufficienti per servire circa 300 utenti simultanei. Un server NVIDIA HGX con otto GPU H200 può quindi fornire 24,000 token al secondo, supportando più di 2,400 utenti contemporaneamente.

Impatto sui Dispositivi Edge

Per i dispositivi edge, la versione di Llama 3 con otto miliardi di parametri ha generato fino a 40 token al secondo su Jetson AGX Orin e 15 token al secondo su Jetson Orin Nano. Questo mostra il potenziale di Llama 3 di operare efficacemente anche in ambienti con risorse limitate.

L’accessibilità di Meta Llama 3 su piattaforme come Google Cloud Vertex AI e Amazon SageMaker JumpStart, insieme alle ottimizzazioni di NVIDIA, apre nuove possibilità per l’implementazione di AI generativa. Gli sviluppatori hanno ora gli strumenti e le risorse necessarie per integrare capacità di AI avanzate nei loro prodotti e servizi, spingendo ulteriormente i confini dell’innovazione nel campo dell’intelligenza artificiale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.