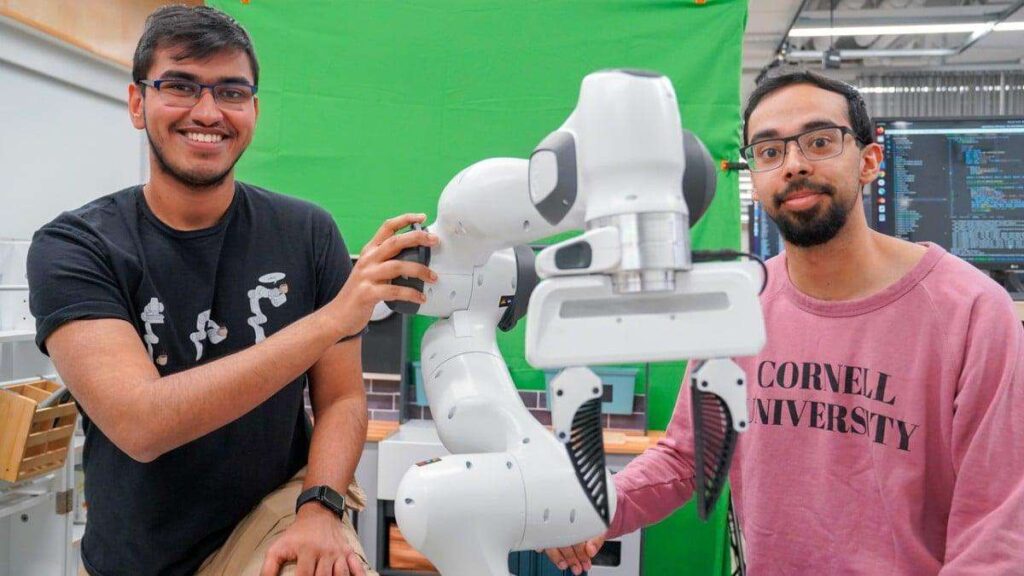

Il team di ricerca dell’Università Cornell, guidato da Sanjiban Choudhury e Kushal Kedia, ha sviluppato un nuovo framework di intelligenza artificiale chiamato RHyME (Retrieval for Hybrid Imitation under Mismatched Execution), capace di insegnare ai robot compiti complessi dopo aver osservato un solo video dimostrativo. Il sistema supera i limiti tradizionali dell’imitation learning, offrendo un approccio più scalabile e meno dipendente da grandi quantità di dati robotici.

Il progetto si fonda su un’idea chiave: i robot, come gli esseri umani, possono imparare osservando, senza necessità di programmazione manuale o addestramento estensivo. Con solo 30 minuti di dati robotici, RHyME consente di apprendere sequenze complesse di azioni, migliorando le prestazioni del 50% rispetto ai metodi precedenti, in ambienti di laboratorio.

Cosa leggere

I robot non imitano più passo per passo: RHyME introduce memoria adattiva e riconoscimento semantico

Tradizionalmente, i robot richiedevano istruzioni passo dopo passo per eseguire qualsiasi azione, fallendo al minimo scostamento dal comportamento atteso. RHyME, invece, è progettato per affrontare direttamente il problema dell’esecuzione non allineata: la differenza tra il modo in cui un essere umano esegue un compito e come un robot può riprodurlo fisicamente.

Il sistema permette al robot di osservare un video dimostrativo e, anziché replicarlo meccanicamente, confrontare ciò che vede con un archivio interno di altre azioni osservate in passato. In questo modo, può riempire le lacune, colmare discrepanze di movimento, e adattare l’azione al proprio corpo macchina.

Un esempio descritto dai ricercatori vede il robot osservare un video in cui un umano sposta una tazza da un ripiano al lavello. Anche se non ha mai visto esattamente quell’azione, il robot può associare i movimenti alla propria memoria di “afferrare una tazza” e “abbassare un oggetto”, costruendo una sequenza compatibile con la dimostrazione.

Imitazione una tantum e inferenza tra video: il paradigma scalabile della robotica cognitiva

Il sistema RHyME opera come un traduttore tra l’azione umana e la sua versione robotica. Secondo Choudhury, “il nostro lavoro è come tradurre dal francese all’inglese – stiamo traducendo un compito umano in uno robotico”. Questo tipo di traduzione richiede intelligenza contestuale e flessibilità semantica, che l’approccio RHyME integra attraverso inferenza su contenuti multimediali eterogenei.

Il framework sfrutta il concetto di retrieval-based learning: osservando una nuova azione, il robot non tenta di riprodurla in modo letterale, ma cerca nella propria memoria altre azioni simili, componendo un nuovo comportamento da frammenti noti. Ciò riduce drasticamente la necessità di tele-operazione, ovvero l’intervento umano per insegnare manualmente i compiti, una pratica considerata insostenibile per la scalabilità industriale.

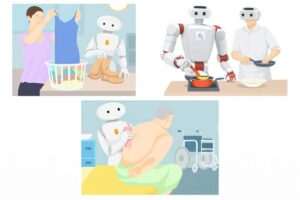

Verso l’assistenza domestica e ambienti dinamici: applicazioni future di RHyME

La ricerca, che verrà presentata alla prossima edizione della International Conference on Robotics and Automation (ICRA), apre scenari nuovi per l’applicazione della robotica in ambienti reali. A differenza dei metodi classici che falliscono in presenza di errori minimi o variazioni nella scena, RHyME permette ai robot di recuperare autonomamente in caso di imprevisti, come perdere una vite o un utensile.

Questo rende la tecnologia particolarmente adatta all’assistenza domestica, dove le condizioni cambiano frequentemente, ma anche all’industria manifatturiera e alla logistica. I robot potrebbero imparare compiti direttamente osservando lavoratori esperti, senza dover essere programmati da zero.

Il progetto è sostenuto da Google, OpenAI, dall’Ufficio della ricerca navale statunitense e dalla National Science Foundation, a dimostrazione del forte interesse istituzionale verso un futuro in cui l’intelligenza robotica non sarà solo reattiva, ma capace di apprendere per inferenza e imitazione contestuale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.