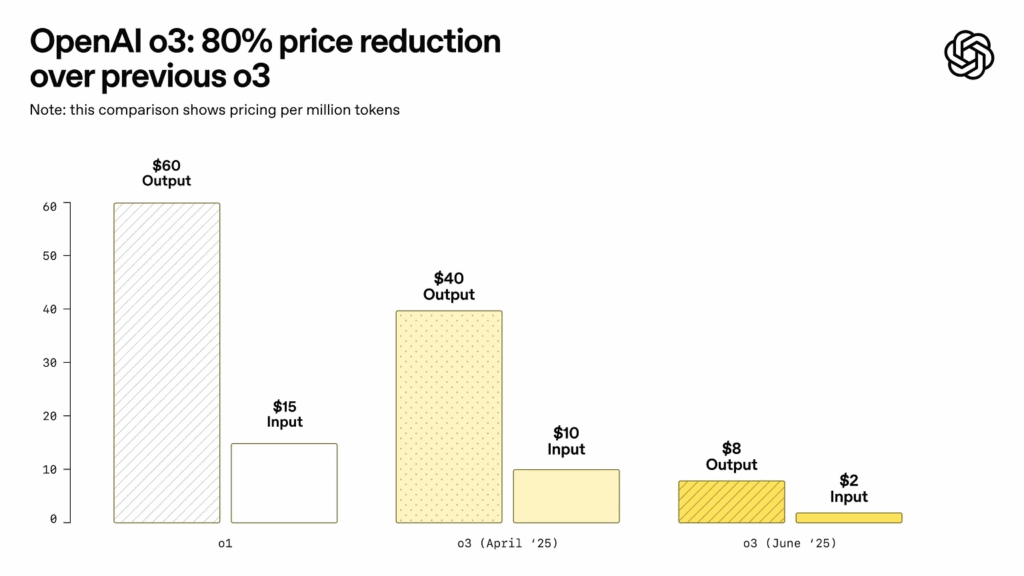

OpenAI ha annunciato una significativa riduzione del prezzo per l’accesso alla propria API ChatGPT o3, la più recente versione del modello linguistico utilizzato nella piattaforma. A partire da giugno 2025, il costo di utilizzo dell’API è diminuito dell’80% rispetto ai livelli precedenti, mantenendo invariato il livello di performance del modello. La decisione ha un impatto rilevante su sviluppatori, aziende SaaS e piattaforme che integrano modelli linguistici generativi nei propri prodotti.

Prezzo ridotto: $2 per milione di token in input, $8 in output

Il nuovo schema di prezzo fissato da OpenAI prevede un costo di 2 dollari per milione di token in input e 8 dollari per milione di token in output, contro gli storici 10/40 dollari per milione della versione precedente. Questo drastico abbattimento dei costi è stato reso possibile da ottimizzazioni interne allo stack di inferenza, secondo quanto comunicato direttamente dall’azienda tramite il canale ufficiale OpenAIDevs su X (ex Twitter).

OpenAI ha chiarito che non è stato sostituito il modello, ma è stato mantenuto lo stesso identico modello di aprile 2025, indicato come gpt-4o-2025-04-16. Le ottimizzazioni riguardano esclusivamente il backend infrastrutturale, responsabile della serving pipeline del modello stesso.

Validazione indipendente: nessun degrado nelle prestazioni

L’annuncio è stato immediatamente sottoposto a verifica da parte della comunità indipendente ARC Prize, un’iniziativa che gestisce benchmark standardizzati per modelli linguistici. I test di retest pubblicati confermano che non vi è alcuna variazione nelle risposte fornite dal modello o nel punteggio di accuratezza, rispetto ai benchmark originali registrati prima del cambio tariffario.

Questa trasparenza operativa rafforza la fiducia degli sviluppatori nella piattaforma e dimostra che il taglio dei costi non è stato compensato da un downgrade del modello o da un compromesso sulla qualità delle risposte.

Effetti sul mercato: API-based tools e AI SaaS più accessibili

L’impatto diretto si avverte su tutte le piattaforme che si basano sull’API OpenAI per erogare servizi. Applicazioni come Cursor (IDE potenziato da AI) e Windsurf (automazione per knowledge management) registrano già una drastica riduzione dei costi operativi, permettendo una maggiore accessibilità all’intelligenza artificiale generativa anche per piccole startup.

La riduzione dei costi favorisce l’integrazione di modelli linguistici in ambiti verticali, come CRM, ticketing, analisi documentale, assistenti sanitari e applicazioni in campo legale o finanziario, dove l’equilibrio tra performance e costo è determinante per la sostenibilità commerciale.

Aggiunta del modello o3-pro: prestazioni superiori con consumo maggiore

In parallelo all’annuncio della riduzione dei costi per il modello standard, OpenAI ha introdotto una nuova variante dell’API denominata “o3-pro”, che impiega una maggiore quantità di risorse computazionali per generare risultati qualitativamente superiori. Il modello è ottimizzato per attività complesse che richiedono inferenze profonde, precisione nel ragionamento e risposta contestuale estesa.

Le aziende potranno così scegliere tra il modello standard e la variante pro, in base alle necessità del contesto applicativo, bilanciando costi e capacità computazionale richiesta. Questa modularità rafforza l’architettura API-first di OpenAI, che consente flessibilità nei carichi di lavoro e gestione intelligente della spesa cloud.

Rivoluzione infrastrutturale: modelli più leggeri, inferenza più veloce

La riduzione di prezzo delle API ChatGPT o3 riflette l’effetto di un’importante ottimizzazione lato inferenza, realizzata da OpenAI senza alterare l’architettura del modello. L’azienda ha implementato un nuovo motore di inferenza dinamico, progettato per ridurre il costo per token attraverso:

- Pre-compilazione adattiva dei prompt

- Compressione interna dei token con auto-batching

- Caching semantico ottimizzato per prompt ricorrenti

Tali meccanismi, trasparenti per l’utente finale, riducono il carico sulle GPU e aumentano l’efficienza nel servire query simultanee, elemento cruciale per i fornitori di servizi in tempo reale.

Confronto con la concorrenza: pricing più competitivo di Claude e Gemini

Il nuovo pricing colloca ChatGPT o3 in posizione di vantaggio rispetto a Claude 3 Opus di Anthropic e Gemini 1.5 Pro di Google, entrambi con tariffe superiori sia per token input che output. La differenza di prezzo è ora dell’ordine di 3x–5x per i modelli più avanzati della concorrenza, rendendo ChatGPT o3 l’opzione più competitiva nel rapporto qualità-prezzo.

Questo posizionamento potrebbe spingere una nuova ondata di migrazione da altri LLM verso la piattaforma OpenAI, soprattutto in settori dove il costo del token è il principale vincolo alla scalabilità.

Implicazioni per gli sviluppatori e le policy di adozione

Gli sviluppatori che usano l’API ChatGPT o3 possono ora servire più utenti o implementare contesti più lunghi senza superare i limiti di budget. Ciò consente l’estensione dei prompt storici o dei documenti elaborati nei tool di knowledge augmentation, generazione codice, drafting legale e customer service.

Inoltre, il taglio dei costi favorisce modelli di pricing freemium per app consumer, permettendo a molte startup di offrire versioni gratuite dei propri strumenti senza incorrere in spese insostenibili. OpenAI non ha imposto modifiche alle quote di rate limit, mantenendo stabili le condizioni operative per gli utenti enterprise e hobbyist.

Il costo come leva strategica per l’adozione massiva

La decisione di OpenAI di ridurre drasticamente il prezzo delle API ChatGPT o3 senza impatto sulle prestazioni rappresenta un punto di svolta nel mercato dei modelli linguistici, e una risposta diretta alla crescente concorrenza tra fornitori LLM. L’ottimizzazione dell’infrastruttura di inferenza dimostra che l’efficienza computazionale è oggi il vero differenziale competitivo, più del semplice volume di parametri o della dimensione del contesto.

Il modello o3, nella sua versione attuale, è stato mantenuto identico anche nei test indipendenti. La possibilità di combinare economicità, affidabilità e flessibilità tramite l’introduzione della variante o3-pro rende OpenAI una delle poche realtà capaci di scalare l’adozione AI a livello globale, sia per startup che per grandi sistemi SaaS enterprise.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.