Un’indagine condotta da Truffle Security ha scoperto oltre 12.000 chiavi API e password attive all’interno del dataset Common Crawl, utilizzato per l’addestramento di modelli di intelligenza artificiale come DeepSeek. Questa scoperta evidenzia un problema crescente: i modelli AI potrebbero essere esposti a dati sensibili e, di conseguenza, generare output insicuri.

Come sono state trovate le chiavi API e le password?

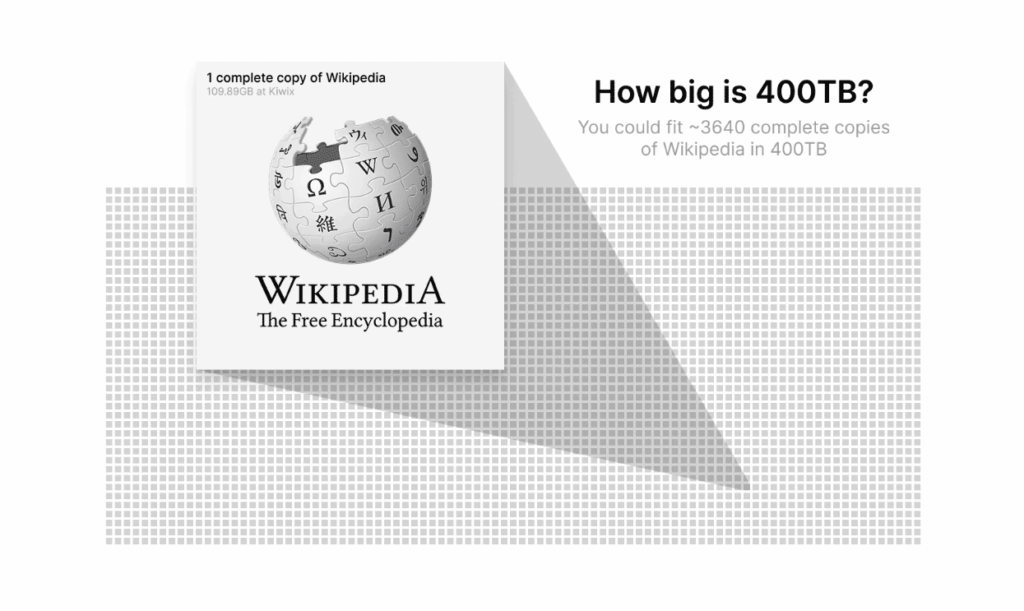

Il team di ricerca ha analizzato l’archivio Common Crawl di dicembre 2024, un dataset di 400 terabyte contenente snapshot di oltre 2,67 miliardi di pagine web. L’analisi è stata effettuata con TruffleHog, un tool open source per la scansione di segreti e credenziali nei dati pubblici.

I risultati principali includono:

- 11.908 credenziali attive rilevate.

- 2,76 milioni di pagine web contenenti segreti esposti.

- Un alto tasso di riutilizzo: il 63% delle chiavi era ripetuto su più siti.

Un caso estremo ha visto una stessa chiave API di WalkScore apparire 57.029 volte su 1.871 subdomini.

Quali dati erano esposti?

L’analisi ha identificato 219 tipi diversi di segreti nei dati di Common Crawl, tra cui:

Chiavi AWS root esposte direttamente in HTML, potenzialmente pericolose se utilizzate per autenticazione su S3. 1.500 chiavi API Mailchimp, usate per moduli e snippet JavaScript, che potrebbero essere sfruttate per campagne di phishing. Webhook Slack esposti, con un singolo sito che ne conteneva 17 unici, rischiando un accesso non autorizzato alle comunicazioni aziendali.

Perché è un problema per i modelli di AI?

Le AI non distinguono tra credenziali valide e non valide nei dati di addestramento, quindi:

- Possono suggerire chiavi API e password nei loro output, aumentando il rischio di esposizione accidentale.

- Rischiano di incoraggiare pratiche di programmazione insicure, riproducendo codice con credenziali hardcoded.

- I dati sensibili potrebbero essere utilizzati in maniera non intenzionale nei prompt generati dagli utenti.

Cosa fare per mitigare il rischio?

Truffle Security propone alcune soluzioni per gli sviluppatori e l’industria AI:

? Sviluppatori:

- Utilizzare tool come TruffleHog per scansionare codice e dataset alla ricerca di segreti esposti.

- Evitare di includere credenziali hardcoded nei repository pubblici.

- Personalizzare le impostazioni degli assistenti AI con regole che impediscano suggerimenti pericolosi.

? Settore AI:

- Applicare tecniche come Constitutional AI, per ridurre il rischio che i modelli riproducano informazioni sensibili.

- Integrare meccanismi di sanitizzazione dei dati nei processi di addestramento.

- Collaborare con fornitori di API per revocare credenziali esposte nei dataset pubblici.

Implicazioni future

Questa ricerca dimostra che i dataset utilizzati per addestrare i modelli AI non sono privi di rischi. Se le informazioni sensibili non vengono filtrate correttamente, gli assistenti AI potrebbero accidentalmente suggerire credenziali reali, compromettendo la sicurezza degli utenti.

Sarà fondamentale per il settore AI rafforzare i controlli sui dati di addestramento e garantire che gli LLM non contribuiscano involontariamente a pratiche di sviluppo insicure.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.