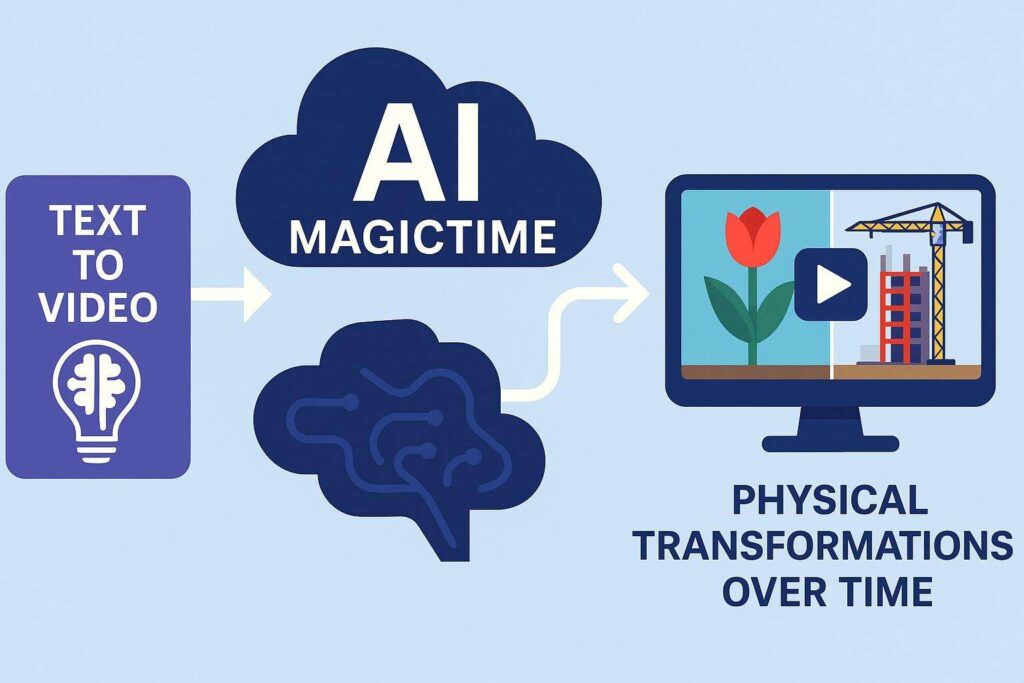

Un team internazionale di ricercatori guidato dall’Università di Rochester ha sviluppato un nuovo modello di intelligenza artificiale che potenzia la generazione video da testo, con la capacità di simulare trasformazioni fisiche complesse nel tempo, come la fioritura di un fiore o la costruzione di un edificio. La tecnologia, denominata MagicTime, segna un’evoluzione significativa rispetto ai precedenti modelli text-to-video.

Un salto evolutivo rispetto ai modelli generativi convenzionali

Sebbene modelli come Sora di OpenAI abbiano mostrato una notevole abilità nella generazione video, sono rimasti limitati nella rappresentazione di fenomeni metamorfici. Le trasformazioni biologiche o fisiche, come la crescita di una pianta o la cottura di un alimento, richiedono la comprensione di dinamiche temporali, variazioni morfologiche e proprietà della materia, difficilmente replicabili da sistemi privi di una base “fisica” di apprendimento.

MagicTime affronta questa limitazione grazie a un dataset proprietario composto da oltre 2.000 video time-lapse, ciascuno corredato di didascalie descrittive. Questo materiale consente all’AI di apprendere modelli di trasformazione reali, trasferendo queste conoscenze nella generazione autonoma di video coerenti e credibili.

Un approccio fisico e semantico alla simulazione video

Il modello MagicTime, presentato sulla rivista IEEE Transactions on Pattern Analysis and Machine Intelligence, integra architetture U-Net open source e una componente diffusion-transformer, capace di estendere le clip fino a dieci secondi a 512×512 pixel e otto frame al secondo. Le simulazioni prodotte includono fenomeni biologici come la metamorfosi, ma anche processi fisici come la costruzione edilizia o la lievitazione e cottura del pane.

Secondo Jinfa Huang, dottorando alla Rochester e co-autore della ricerca sotto la supervisione del professor Jiebo Luo, l’obiettivo non è solo quello di creare video esteticamente convincenti, ma di offrire uno strumento utile alla comunità scientifica. L’accuratezza delle simulazioni potrebbe infatti accelerare l’iterazione sperimentale preliminare, riducendo il numero di test reali necessari in settori come la biologia, la chimica e le scienze ambientali.

Verso una nuova generazione di strumenti per la ricerca

Nel lungo termine, i ricercatori puntano a integrare modelli come MagicTime in flussi di lavoro scientifici reali, dove la simulazione visiva potrà coadiuvare l’esplorazione di ipotesi o la previsione di scenari evolutivi. Sebbene gli esperimenti fisici restino indispensabili, l’uso di video generativi accurati potrà ottimizzare tempi e risorse nella fase esplorativa.

MagicTime si distingue anche per l’approccio open source, che consente ad altri laboratori e ricercatori di accedere al codice e contribuire alla sua evoluzione. La sua presenza su piattaforme come Hugging Face indica una chiara volontà di promuovere l’accessibilità e la riproducibilità nel campo dell’AI generativa.

Il progetto rappresenta una tappa fondamentale verso sistemi capaci di replicare non solo l’aspetto visivo delle trasformazioni, ma anche la logica fisica sottostante, aprendo la strada a nuove applicazioni nell’ambito della simulazione scientifica, dell’educazione e della creazione di contenuti.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.