La corsa all’intelligenza artificiale nel 2025 si tinge di un nuovo colore: quello della privacy. In pochi giorni, quattro importanti attori del settore – Proton, ROOST, WeTransfer e OpenAI – hanno annunciato cambiamenti e innovazioni che, da angolazioni diverse, convergono verso una tendenza comune: restituire controllo e trasparenza agli utenti. Dall’assistente AI crittografato di Proton, ai tool open-source per la sicurezza di ROOST, fino alla retromarcia di WeTransfer su una clausola controversa e all’evoluzione di ChatGPT come assistente personalizzabile, l’attenzione al rispetto dei dati e alla responsabilizzazione delle piattaforme sembra finalmente acquisire una forma concreta.

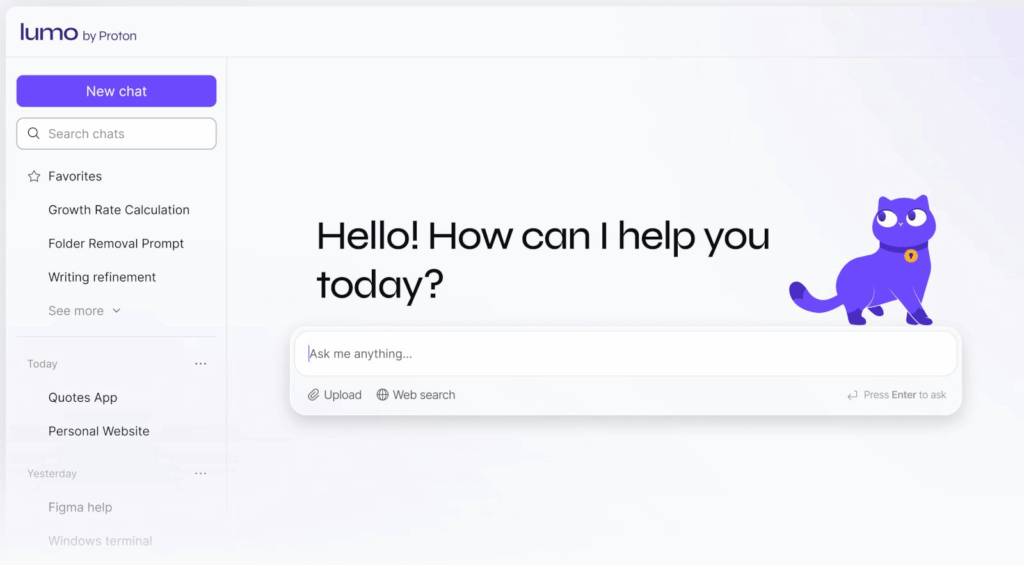

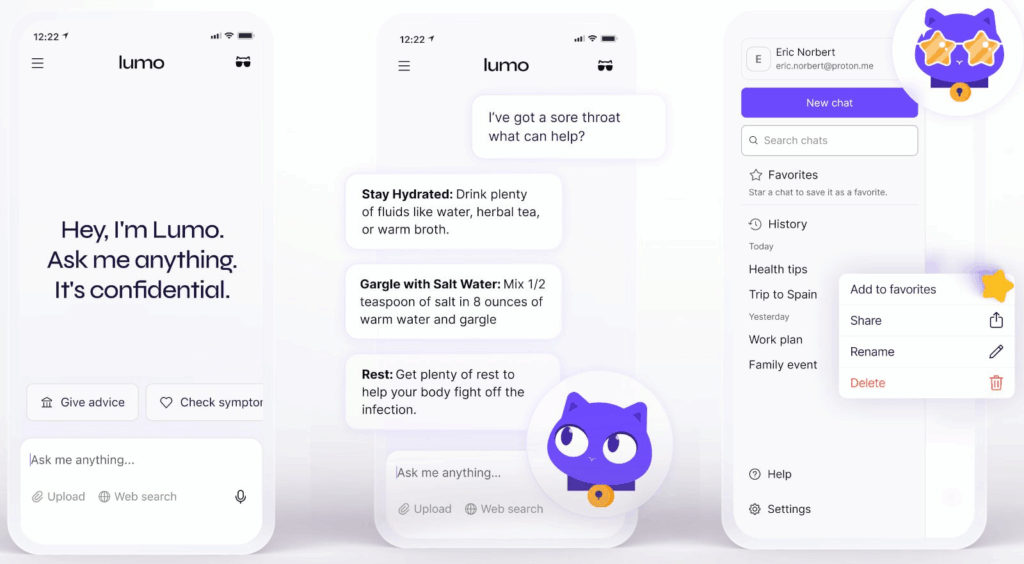

Lumo: l’AI privacy-first di Proton

Il 23 luglio 2025 Proton ha presentato Lumo, un assistente AI progettato fin dall’inizio con criteri di riservatezza avanzati. A differenza dei suoi concorrenti, Lumo non registra le conversazioni lato server, usa crittografia end-to-end con tecnologie zero-access, ed è interamente ospitato in data center europei conformi al GDPR. Gli utenti possono salvare localmente le chat, ma non viene inviato nulla a terze parti o utilizzato per addestrare modelli. Lumo impiega modelli open-source come Mistral Nemo e Nvidia OpenHands 32B, supporta upload sicuri tramite Proton Drive, e adotta una struttura d’accesso basata su tre livelli: Guest, con uso limitato e nessun salvataggio; Free, con storico crittografato; e Plus, a 11,90 euro al mese per uso illimitato. Il sistema può rispondere a domande, scrivere codice, analizzare documenti, e integra anche la ricerca web tramite motori privacy-friendly. Proton sottolinea il rifiuto della sorveglianza commerciale e contrappone il proprio modello ad Apple Intelligence e OpenAI. Il CEO Andy Yen ha ribadito l’impegno dell’azienda a non monetizzare i dati e ha aperto il codice di Lumo per garantire massima trasparenza e verifica pubblica.

Dettaglio tecnico: la crittografia di Lumo

Il cuore tecnologico di Lumo risiede nel suo sistema di zero-access encryption. Le chiavi crittografiche vengono generate localmente, direttamente sul dispositivo dell’utente, che è l’unico a poterle usare per decifrare le conversazioni. Proton, in quanto provider, non ha modo di accedere ai dati in transito o archiviati. Il sistema utilizza standard AES-256, integra file sharing sicuro con chiavi asimmetriche e presenta latenza inferiore a 200 ms, garantendo al tempo stesso performance e sicurezza. Il codice sorgente è disponibile su GitHub, offrendo verificabilità pubblica, mentre l’infrastruttura si basa su data center in Europa, evitando giurisdizioni extracomunitarie. L’intera architettura è costruita per scalabilità, resilienza e auditabilità da parte degli utenti.

Coop e Osprey: sicurezza open-source con ROOST

Il 21 luglio 2025 ROOST ha annunciato due strumenti open-source per la sicurezza AI-driven, chiamati Coop e Osprey, pensati per fornire protezione a basso costo anche alle piattaforme più piccole. Coop, basato sulla tecnologia Cove, rileva contenuti dannosi in forma testuale e visiva, mentre Osprey, ceduto da Discord, si concentra su minacce più complesse come il phishing e la protezione dei minori. ROOST ha acquistato la proprietà intellettuale di Cove per rilasciarla come codice aperto, e ha ricevuto fondi da enti filantropici per sostenere il progetto. Coop e Osprey possono essere personalizzati dagli sviluppatori, integrati con flussi esistenti, e non richiedono infrastrutture complesse. La piattaforma Bluesky ha già annunciato l’adozione di Osprey, e la community open-source sta contribuendo con patch e miglioramenti. L’obiettivo di ROOST è chiaro: ridurre le barriere all’adozione di strumenti di sicurezza, e democratizzare la protezione contro abusi e minacce online. I due strumenti saranno disponibili entro settembre 2025.

WeTransfer ritira la clausola AI dopo le critiche

Dopo un’ondata di proteste, il 20 luglio 2025 WeTransfer ha ritirato una clausola contrattuale introdotta il 2 luglio che consentiva l’addestramento di modelli AI sui file caricati dagli utenti. L’aggiornamento, inserito nel punto 6.3 dei termini di servizio, aveva suscitato forte indignazione per la presunta violazione della privacy e per la mancanza di chiarezza sul trattamento dei dati. Secondo la clausola, WeTransfer si riservava una licenza perpetua per utilizzare i file allo scopo di “migliorare i servizi”, con formulazioni generiche che hanno portato molti utenti a sospettare operazioni di training non dichiarate. In seguito alle critiche, l’azienda ha fatto marcia indietro e ha chiesto scusa, riaffermando il proprio impegno verso la tutela della privacy e la conformità al GDPR. In risposta, molti utenti hanno raccomandato l’uso di archivi ZIP con password e l’invio delle chiavi attraverso canali separati. La piattaforma, che compete con Dropbox e Google Drive, ha anche rafforzato i controlli interni per evitare incidenti simili.

ChatGPT introduce il toggle di personalità

Sempre il 23 luglio 2025, ChatGPT ha introdotto una nuova funzionalità che consente agli utenti di selezionare il tono delle risposte AI, chiamata “toggle di personalità”. Gli utenti possono scegliere se ricevere risposte in stile professionale, amichevole o creativo, direttamente nell’app web. Questo aggiornamento rappresenta un passo verso la personalizzazione dell’esperienza AI, e coincide con una serie di sviluppi che trasformano ChatGPT in assistente virtuale completo.

Tra le novità in fase di testing figurano l’integrazione con Gmail e Google Calendar, l’esecuzione di task locali (aprire file, generare documenti), e persino un browser AI che punta a sfidare Google Chrome. Attualmente, ChatGPT gestisce 2,5 miliardi di richieste al giorno e serve oltre 500 milioni di utenti a settimana. Con supporto a 50 lingue, crittografia dei dati e nuove funzioni agentive, OpenAI cerca di mantenere la leadership nel settore, ma si trova a competere sempre più apertamente con Gemini di Google e con Lumo di Proton, che offre un approccio più radicale in termini di privacy.

Impatto su privacy e sicurezza

Tutti e quattro i casi illustrano come la spinta verso l’AI generativa si stia affiancando a un’esigenza crescente di trasparenza, sicurezza e conformità normativa. Lumo evita qualunque trattamento server-side dei dati e consente solo all’utente il controllo sulla propria cronologia. Coop e Osprey, con la loro architettura modulare, consentono a startup e piattaforme emergenti di implementare difese efficaci contro phishing, hate speech e contenuti abusivi. WeTransfer, correggendo il tiro, mostra come la pressione pubblica possa costringere i provider a rispettare la volontà dell’utente. ChatGPT, infine, si evolve per rispondere meglio ai bisogni personalizzati degli utenti, mantenendo allo stesso tempo un’attenzione maggiore alla gestione del rischio reputazionale e regolamentare. Organizzazioni come la CISA evidenziano come i costi per data breach legati ad AI possano ammontare a miliardi di euro. Per questo, molte aziende stanno adottando autenticazione multifattoriale, DLP, backup resilienti, e strumenti di logging avanzato. L’obiettivo è duplice: da un lato, prevenire esfiltrazioni e uso improprio dei dati, e dall’altro, costruire un rapporto di fiducia duraturo con l’utente.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.