L’intelligenza artificiale avanza con agenti sempre più potenti e simultaneamente emerge la necessità di metriche accurate per proteggere la privacy. I test interni di GPT Alpha basato su GPT-5 mostrano come un agente possa integrare navigazione web, generazione immagini e esecuzione di codice, aumentandone l’utilità pratica ma anche la superficie di rischio. Contemporaneamente, ricerche accademiche propongono approcci come CAMIA per identificare memorizzazioni indesiderate nei modelli LLM. Questo articolo spiega le capacità e i vincoli di GPT Alpha, descrive i rischi tipici dei LLM, approfondisce il metodo CAMIA e traduce risultati e implicazioni in raccomandazioni operative per imprese e sviluppatori.

Cosa leggere

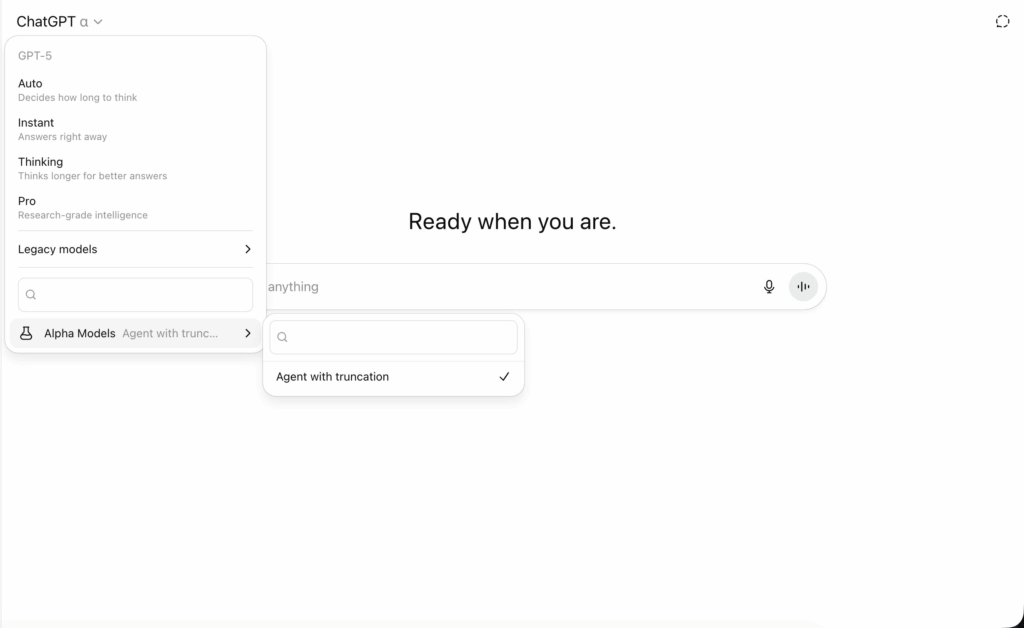

Test interni di GPT Alpha e modello operativo

I test interni su GPT Alpha rivelano un agente che unisce ragionamento avanzato a tool multipli. L’architettura sfrutta la capacità di GPT-5 per orchestrare fetch di dati aggiornati via web, generare e ritoccare immagini, scrivere ed eseguire script, e produrre documenti strutturati. L’ambiente di prova impone vincoli rigorosi sull’accesso a dati sensibili e prevede policy che impediscono l’estrazione di informazioni private a meno di input espliciti e autorizzati. L’adozione di vincoli runtime e di filtri di sicurezza rappresenta la prima linea di difesa, ma l’introduzione di strumenti eseguiti a catena aumenta la complessità del threat model. Gli operatori osservano che, nonostante l’efficacia nell’automazione dei task, l’agente richiede un controllo stretto delle integrazioni esterne per evitare fughe accidentali di dati.

Capacità avanzate e limiti funzionali

GPT Alpha dimostra abilità complesse: navigazione contestuale per dati niche, editing di immagini basato su prompt, generazione di codice eseguibile e debugging guidato. Queste capacità migliorano la produttività, ma amplificano il rischio di esposizione quando il modello manipola o sintetizza informazioni proprietarie. L’impostazione di accesso riservato a clienti paganti e l’uso di risorse computazionali dedicate limitano l’esposizione pubblica, ma non eliminano il problema delle memorizzazioni indesiderate nel peso stesso del modello. Inoltre, la disponibilità di tool esterni richiede un audit continuo delle API collegate, delle policy di logging e delle regole di esecuzione condivisa per ridurre il rischio che dati sensibili transitino in chiari comandi o output.

Rischi privacy nei modelli LLMs: meccanismi e contesti vulnerabili

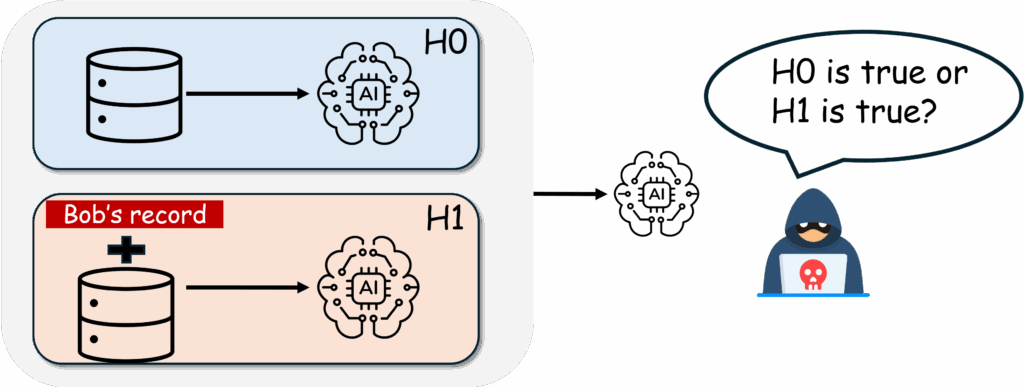

I modelli linguistici di grande scala memorizzano frammenti del materiale di addestramento in modi che possono emergere durante la generazione. Le fughe interessano documenti sanitari, email aziendali, contenuti paywalled e domande d’esame. La struttura token-by-token della generazione complica le valutazioni: un singolo prefisso può cambiare radicalmente la probabilità che il modello riproduca sequenze memorizzate. Gli attacchi di membership inference e di extraction sfruttano questa dinamica per verificare la presenza di dati nel training set o per estrarre porzioni sensibili. La diffusione dei LLM in prodotti consumer e enterprise rende queste vulnerabilità rilevanti in scenari reali, dove la perdita di dati personali o segreti industriali ha impatti legali e reputazionali.

Sfide nella misurazione della memorizzazione e limiti metodologici

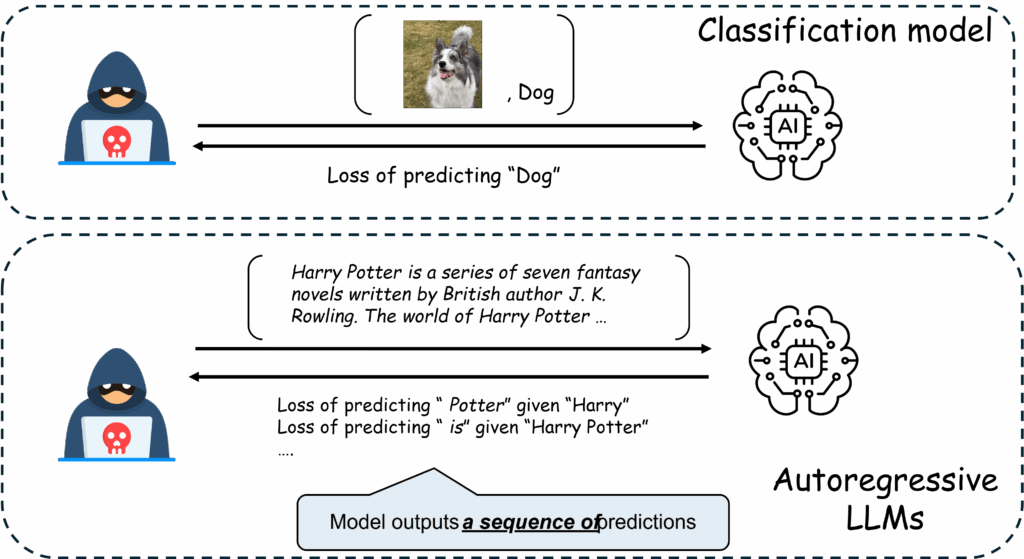

Valutare quanto un modello “ricordi” richiede metriche che considerino la dinamica di generazione. Metodi tradizionali basati su perdite aggregate o su attacchi statici risultano insufficienti perché non catturano transizioni contestuali tra incertezza e recall. La generazione dipende dai prefissi, dallo spazio delle probabilità e dalle tecniche di decoding usate in inference. Inoltre, le metriche devono essere computazionalmente efficienti per essere praticabili su modelli grandi. La mancanza di standard e di benchmark condivisi ostacola comparazioni tra approcci e la definizione di soglie operative che bilancino utilità e privacy.

Il metodo CAMIA: principio operativo e vantaggi

CAMIA introduce un paradigma token-level che traccia l’evoluzione dell’incertezza durante la generazione. L’algoritmo osserva la traiettoria delle probabilità sui token successivi per distinguere tra risposte generate per approssimazione statistica e repliche confidenti indicative di memorizzazione. Questo approccio cattura il momento in cui la predizione evolve da un’ipotesi a un recall deterministico, migliorando la capacità di identificare leak effettivi. I test pubblicati mostrano guadagni significativi di true positive rate su benchmark come MIMIR, con basso tasso di falsi positivi e tempi di calcolo compatibili con hardware standard per ricerca. CAMIA si rivela particolarmente efficace su domini tecnici come archivi accademici e codice sorgente, dove pattern ripetuti possono altrimenti passare inosservati.

Risultati sperimentali e impatto su domini sensibili

L’applicazione di CAMIA su modelli come Pythia e GPT-Neo evidenzia che la percentuale di memorizzazione rilevata cresce in dataset con alta ripetitività e con presenza di documenti altamente strutturati. Esperimenti su corpora di settore mostrano come CAMIA raddoppi la detection rispetto a metodi precedenti, mantenendo un controllo rigoroso sui falsi positivi. Le implicazioni pratiche sono pesanti per sanità, istruzione e media: l’adozione di misure preventive basate su detection token-level può ridurre la probabilità di leak e permettere policy di retraining mirate o di rimozione selettiva del training data che causa rischio.

Implicazioni etiche, regolamentari e operative

L’adozione diffusa di agenti come GPT Alpha impone una revisione delle pratiche di governance dell’IA. Le imprese devono documentare pipeline di addestramento, mantenere tracciabilità dei dataset e implementare testing privacy prima del deployment. Le autorità regolatorie richiederanno trasparenza sulle policy di retention e sulle tecniche di mitigazione adottate. Il rilascio di tool open-source come CAMIA favorisce responsabilità condivisa, ma aumenta l’urgenza di linee guida su come usare tali strumenti senza creare falsi allarmi o sovra-restrizioni che limitino ricerca e innovazione.

Raccomandazioni pratiche per sviluppatori e organizzazioni

I modelli devono essere sottoposti a test di memorizzazione token-level come parte del ciclo CI/CD. L’adozione di tecniche di privacy by design è cruciale: limitare l’esposizione degli strumenti di esecuzione, applicare rate limiting e policy di filtraggio dell’output, e utilizzare allowlist/denylist per oggetti sensibili riduce il rischio di extraction. Dove possibile, applicare differential privacy in fase di training e usare data minimization nella raccolta dei corpora. Le organizzazioni devono predisporre processi di incident response specifici per leak LLM e mantenere canali per la segnalazione e la verifica rapida di potenziali esposizioni. Dal punto di vista tecnico, l’evoluzione verso agenti autonomi come GPT Alpha evidenzia che la vera sfida non è solo incrementare capacità computazionali, ma governare la memoria implicita dei modelli. Metodi token-level come CAMIA rappresentano un passo avanti per misurare e mitigare memorizzazioni indesiderate, perché analizzano la traiettoria dell’incertezza durante la generazione e isolano segnali di recall definitivo. Tuttavia, la protezione effettiva richiede un pacchetto integrato: test continui, hardening delle interfacce tool, pratiche di data governance e trasparenza efficiente verso utenti e regolatori. Solo una strategia che combini misurazioni robuste, controlli operativi e policy chiare potrà permettere l’adozione sicura di agenti AI avanzati in contesti sensibili.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.