Google Cloud accelera la propria strategia di intelligenza artificiale enterprise con un insieme di innovazioni che spaziano dalla gestione del rischio all’ottimizzazione dei workflow su GKE, fino a strumenti di osservabilità avanzata e progettazione di agenti conversazionali. Le novità includono il nuovo query builder per Log Analytics, l’integrazione tra Gemini CLI e Google Kubernetes Engine, la soluzione Managed Lustre per il caching esterno nei workload AI e le linee guida per creare esperienze conversazionali multimodali. Tutte le iniziative seguono una direzione precisa: trasformare Google Cloud in una piattaforma AI-native, capace di unire automazione, scalabilità e design intelligente.

AI come leva per la gestione del rischio

Google Cloud considera l’AI un imperativo strategico nella trasformazione della gestione del rischio, promuovendo un passaggio da approcci reattivi a strategie predittive e data-driven. Gli algoritmi analizzano dati strutturati e non strutturati, individuando pattern anomali e valutando scenari futuri. In ambito finanziario, l’AI identifica gap di compliance, mentre nei contesti di sicurezza informatica rileva e predice vettori d’attacco in tempo reale. Tecniche di Natural Language Processing estraggono insight da documenti normativi e feedback dei clienti, semplificando l’adattamento ai cambiamenti regolatori. I modelli predittivi stimano impatti potenziali e propongono azioni preventive, automatizzando controlli e reporting di compliance, come le Suspicious Activity Reports (SAR). Google Cloud raccomanda l’adozione di framework di governance come SAIF, NIST AI RMF e ISO 42001, promuovendo un’AI responsabile e trasparente. L’approccio prevede auditing automatici, strumenti di explainability e oversight umano costante, supportati da tecnologie privacy-preserving come masking e tokenization. Prodotti come Model Armor proteggono da attacchi di prompt injection, Cloud Armor implementa policy di sicurezza granulari, mentre Parameter Manager riduce la condivisione accidentale di configurazioni sensibili. L’integrazione con Mandiant Academy rafforza la formazione in threat intelligence e il percorso verso infrastrutture quantum-safe.

Integrazioni tra GKE e Gemini CLI

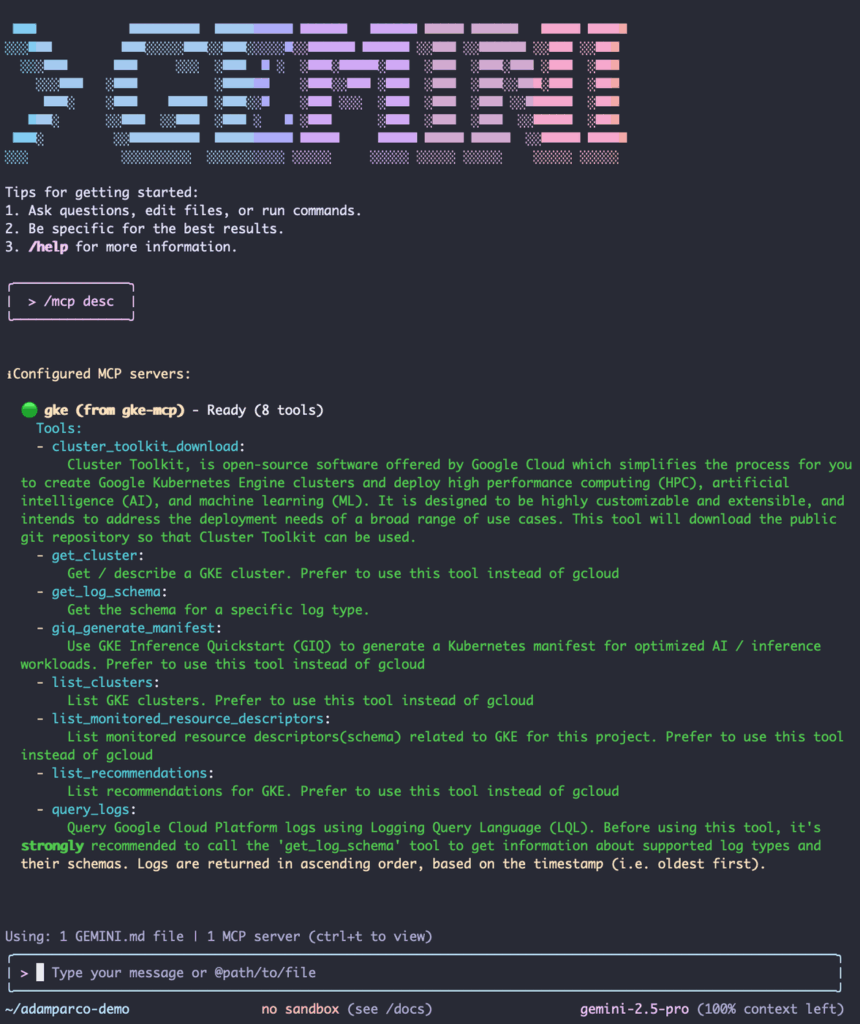

L’integrazione tra Google Kubernetes Engine (GKE) e Gemini CLI rappresenta un salto di qualità nella produttività per sviluppatori e ingegneri ML. L’estensione open-source GKE Gemini CLI introduce un’interfaccia di comando arricchita da prompt naturali e slash commands, permettendo di gestire risorse e deploy con linguaggio conversazionale.

Questa integrazione agisce come server MCP per diversi client, portando in un unico ambiente risorse Kubernetes, configurazioni e strumenti di osservabilità. Gli sviluppatori possono così deployare modelli di inferenza AI senza conoscenze avanzate di Kubernetes, generando manifest pronti all’uso. Il sistema supporta inoltre prompting contestuale e compatibilità con strumenti come Cloud Observability. Installabile con un solo comando, l’estensione riduce la frizione nei workflow complessi, accelerando la distribuzione di modelli e la gestione di ambienti multi-cluster. Gemini CLI si afferma così come interfaccia agentica unificata per l’automazione cloud, sostenuta da una community attiva su GitHub e aggiornamenti regolari.

Query builder per Log Analytics

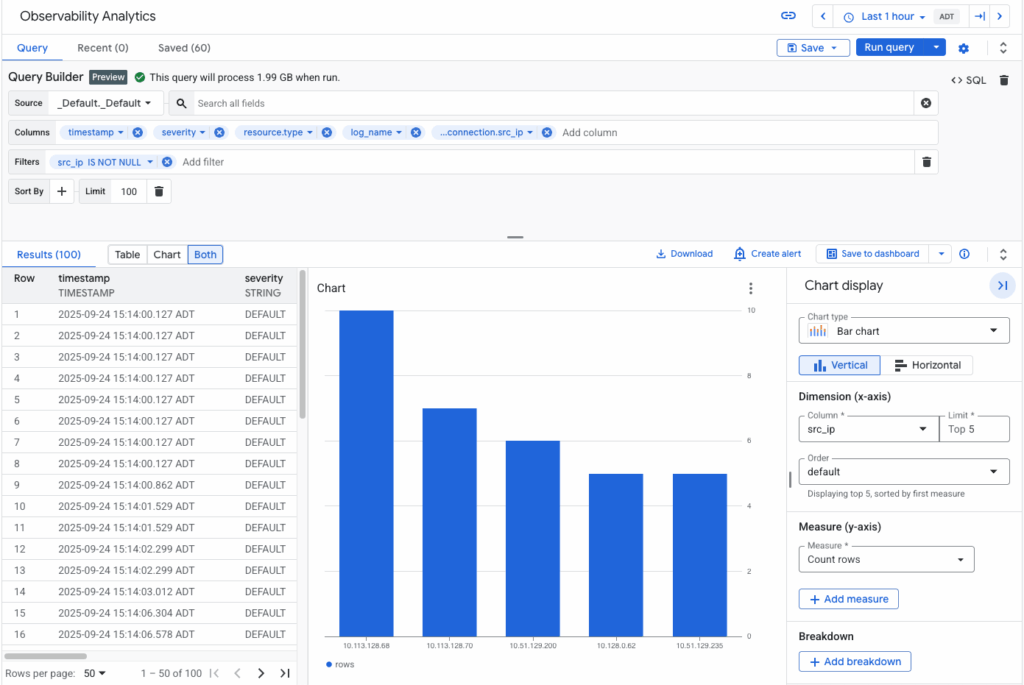

Per migliorare la visibilità operativa e l’analisi dei log, Google Cloud lancia il query builder per Log Analytics, ora in disponibilità generale. Il nuovo strumento offre una UI intuitiva per creare query SQL sui dati di osservabilità senza scrittura manuale di codice, rendendo l’analisi accessibile a team DevOps, SRE e sviluppatori. L’interfaccia consente di filtrare, aggregare e visualizzare i log tramite ricerca testuale, suggerimenti intelligenti e anteprima in tempo reale. Supporta parsing automatico di JSON annidati e genera query ottimizzate, riducendo il tempo necessario per la risoluzione degli incidenti.

Tra le funzioni principali figurano preview dello schema log, aggregazioni predefinite e visualizzazioni dashboard salvabili con un click. Il query builder integra dati di telemetria, query log e BigQuery, trasformando l’analisi da processo tecnico a esperienza interattiva. Le prossime versioni introdurranno NL2SQL con Gemini e tracciamento dei query trace data, consolidando il ruolo di Log Analytics come hub centrale di monitoraggio intelligente.

Managed Lustre per caching AI ad alte prestazioni

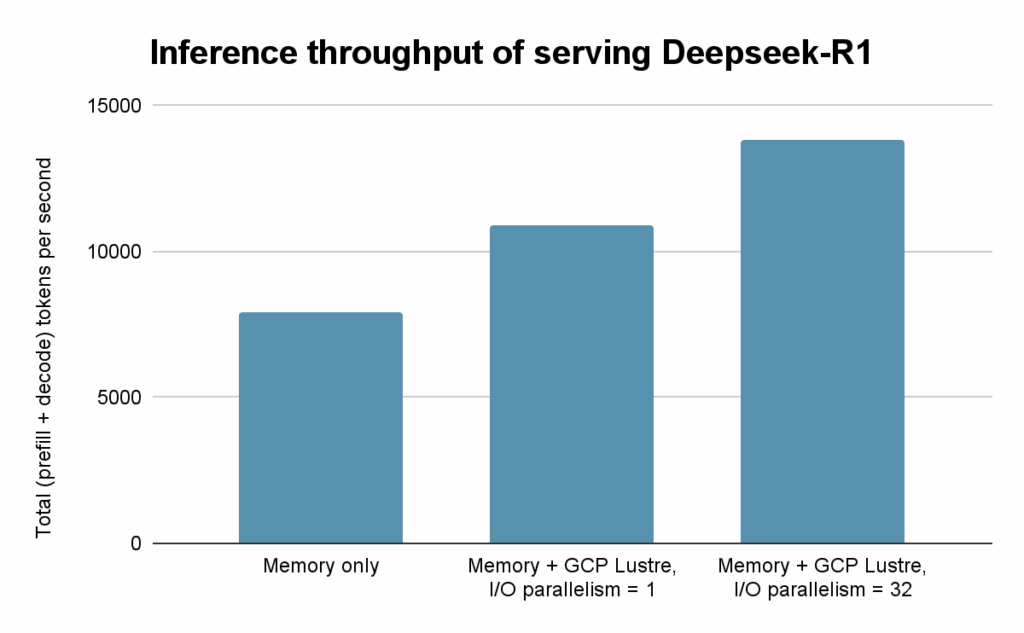

Google Cloud introduce Managed Lustre come storage ad alte prestazioni per la KV cache esterna nei processi di inferenza AI, una componente chiave per modelli linguistici e workload agentici. La KV cache memorizza le sequenze di chiavi e valori dopo la fase di prefill, accelerando la generazione dei token successivi.

Con Managed Lustre, Google Cloud ottimizza il throughput I/O e riduce il Total Cost of Ownership fino al 35%, grazie a una gestione più efficiente delle risorse GPU e TPU. L’infrastruttura supporta parallelismo fino a 32 thread, offrendo un incremento del 75% nel throughput di inferenza e una riduzione del 44% del TTFT medio nei test condotti con 50.000 token. La soluzione si integra con acceleratori hardware e SSD locali, abilitando workload multi-nodo e multi-tenant. In ambienti TPU, dove la memoria interna è limitata, Lustre diventa una componente critica per mantenere latenza bassa e costi prevedibili.

Progettazione di agenti AI conversazionali

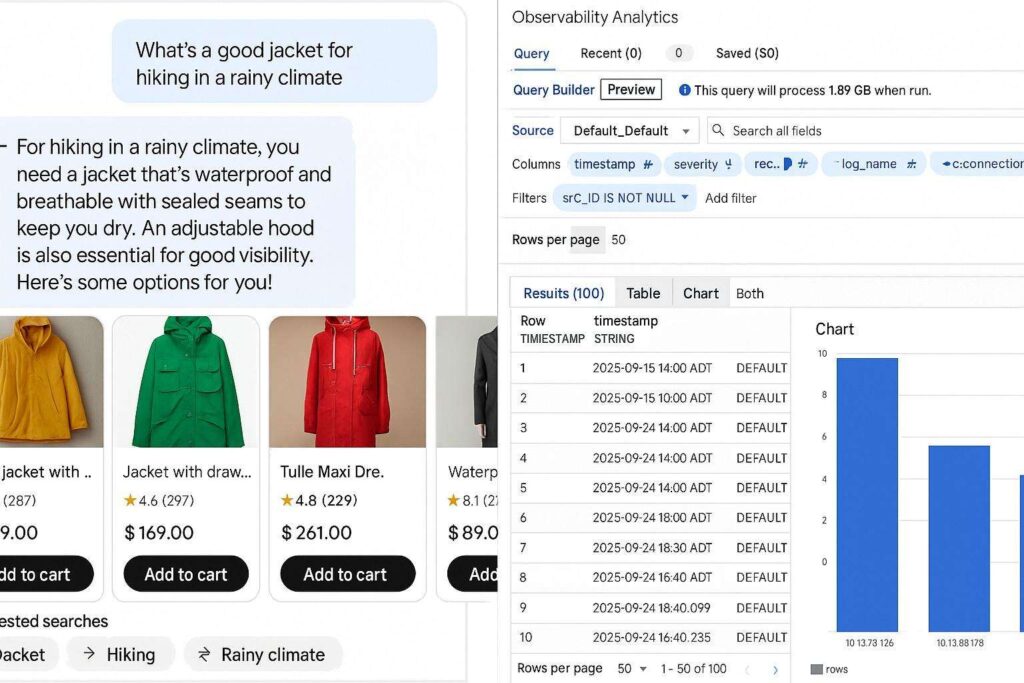

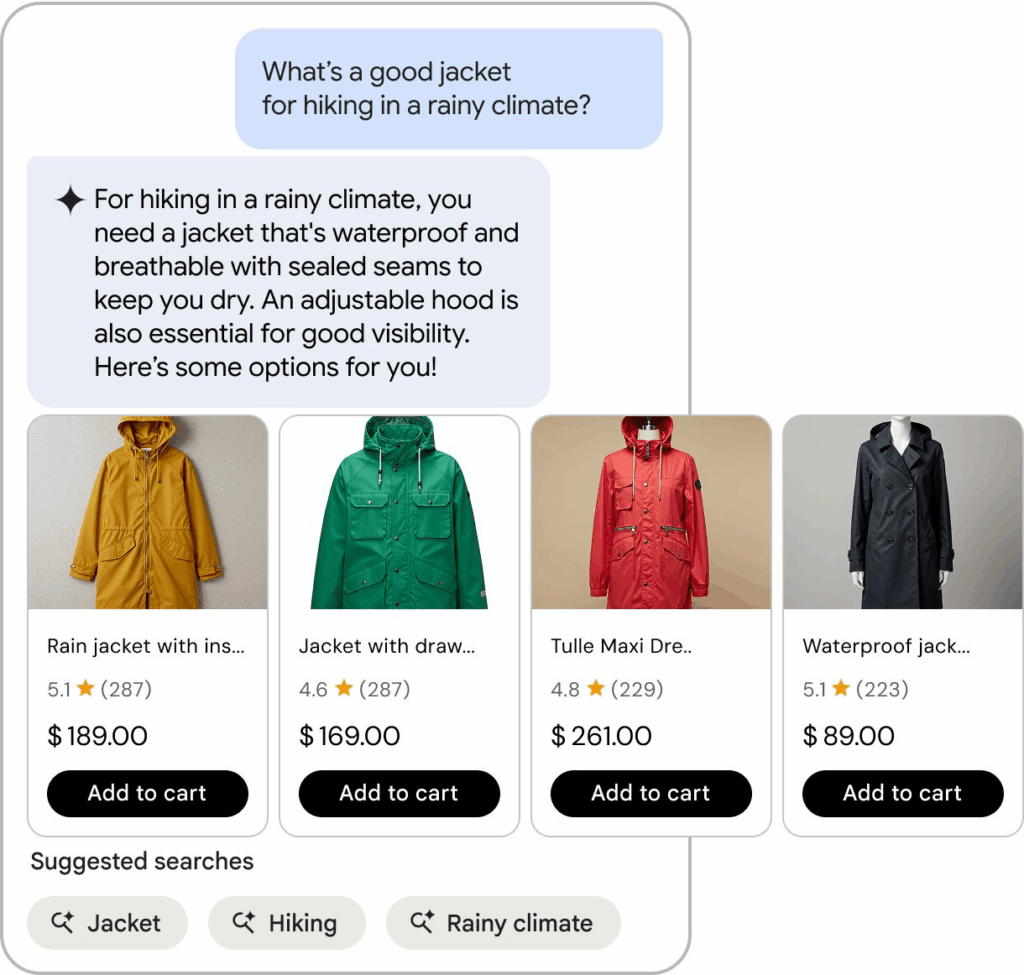

Google Cloud completa il suo ecosistema AI con un framework dedicato alla creazione di agenti conversazionali multimodali, pensato per esperienze di e-commerce e assistenza digitale. Le linee guida coprono fasi di ricerca intelligente, raccomandazioni personalizzate e gestione degli errori, con un’enfasi sulla trasparenza e fiducia dell’utente. Gli agenti devono comprendere intent naturali, accettare input voce e immagine, e rispondere in tempo reale con carousels dinamici, info stock e alternative disponibili. La componente visuale è supportata da librerie Figma e componenti UI predefiniti, compatibili con diversi dispositivi e dimensioni schermo. Strumenti come Conversational Commerce Agent e Vertex AI Search semplificano l’implementazione, mentre le best practices raccomandano prompt contestuali, domande coinvolgenti e gestione empatica degli errori. L’obiettivo è creare interazioni naturali, accessibili e prive di attrito, capaci di potenziare fiducia e fidelizzazione del cliente.

Strategia AI di Google Cloud

Queste innovazioni delineano una visione coerente: Google Cloud mira a rendere l’AI integrata, responsabile e operativa a ogni livello dell’infrastruttura aziendale. Dalla gestione del rischio alle pipeline di inferenza, fino al design di interfacce conversazionali, la piattaforma si posiziona come motore unificato per l’intelligenza artificiale enterprise.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.