Google Cloud annuncia una serie di aggiornamenti che ridefiniscono il ruolo dell’intelligenza artificiale, dello scaling distribuito e della gestione dei costi nel cloud enterprise. Le innovazioni coinvolgono ambiti eterogenei — dal retail globale alla ricerca scientifica, fino al machine learning industriale — integrando componenti di calcolo avanzato, rilevamento predittivo e ottimizzazione economica. Tra i protagonisti dell’adozione figurano realtà come Mercado Libre, che utilizza Spanner per scalabilità globale, e ricercatori che sfruttano Gemini Enterprise per accelerare workflow e simulazioni. Parallelamente, Ray su GKE introduce nuove feature per il training su TPU, mentre il servizio di rilevamento anomalie nei costi raggiunge la disponibilità generale, offrendo insight proattivi a team finanziari e ingegneristici. Questi sviluppi confermano la strategia di Google Cloud verso un ecosistema ibrido, unificato e orientato all’efficienza operativa, dove l’AI agisce come collaboratore tecnico e analitico.

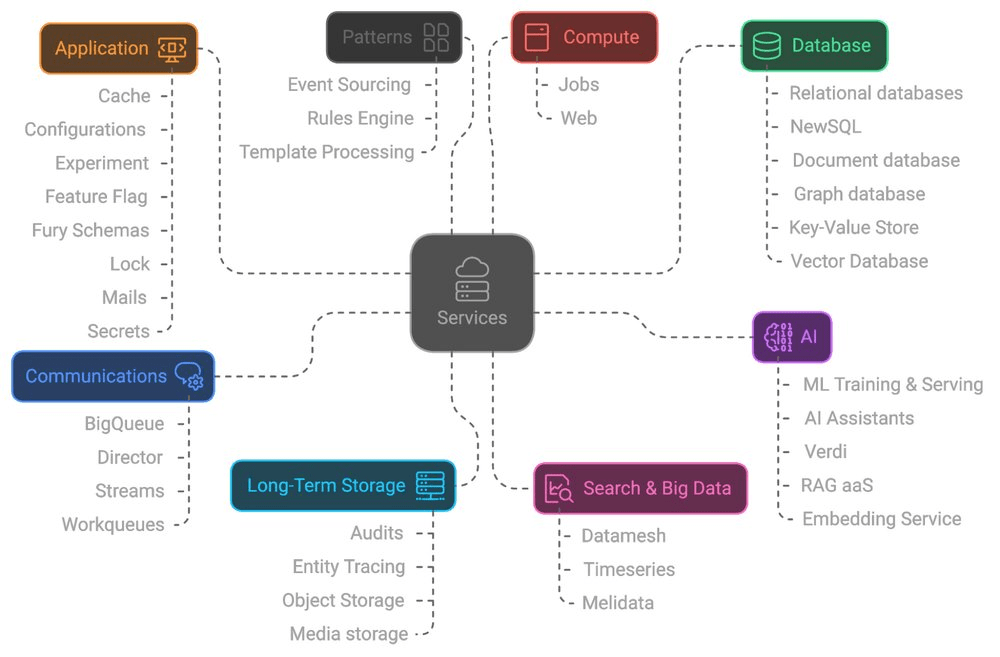

Scalabilità retail con Spanner

Mercado Libre, la principale piattaforma di e-commerce latinoamericana, adotta Google Cloud Spanner come database principale per gestire operazioni su scala continentale. La piattaforma Fury di Mercado Libre astrae la complessità infrastrutturale, permettendo agli sviluppatori di concentrarsi sulla logica di business. Spanner garantisce consistenza globale, transazioni ACID e un modello SQL relazionale capace di gestire oltre 214.000 query al secondo e 30.000 transazioni al secondo.

Durante i picchi di traffico, il sistema scala automaticamente aggiungendo fino al 30% di nodi, assicurando resilienza e continuità. Funzionalità come TrueTime, Data Boost e Change Streams consentono di sincronizzare orologi, isolare query analitiche e inviare flussi di dati in BigQuery per analisi in tempo reale.

L’integrazione con ML.PREDICT consente previsioni dirette sui dati transazionali, mentre il modello Reverse ETL alimenta insight di business direttamente in Spanner. Questa architettura riduce overhead di manutenzione e garantisce uptime costante anche nei settori più regolamentati.

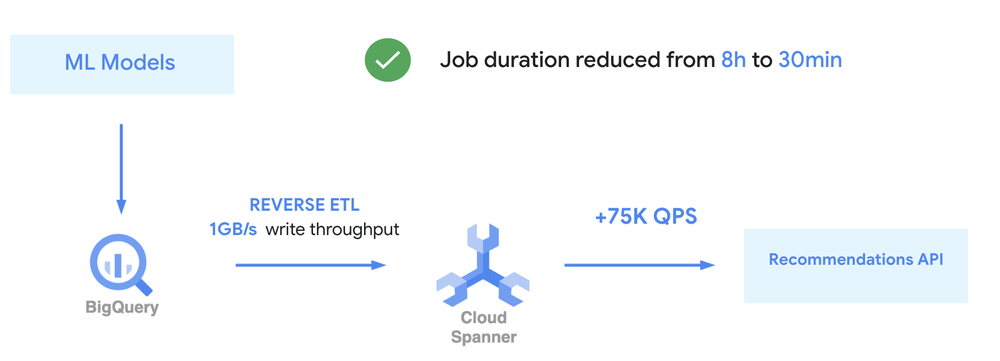

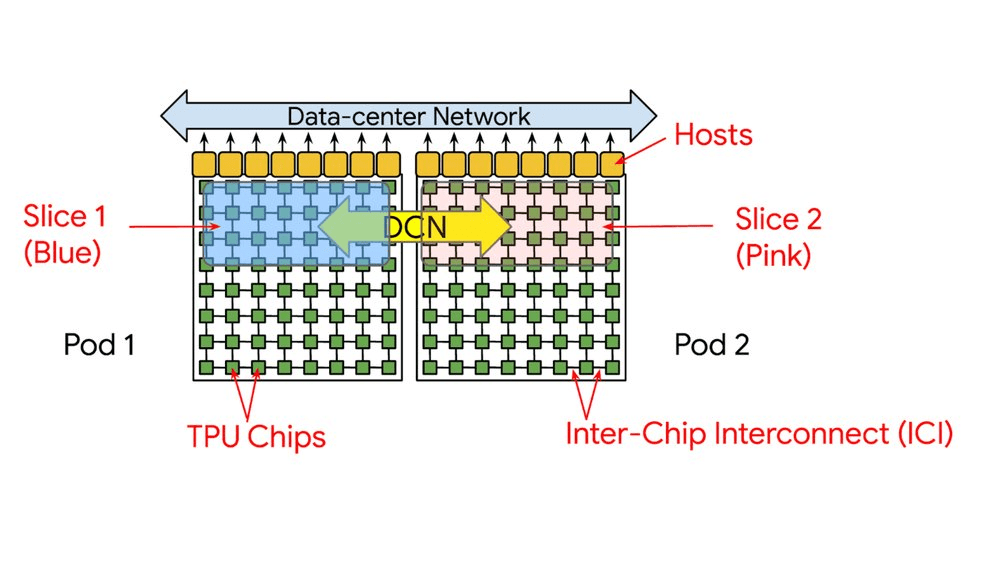

Ray su TPUs con GKE

Google Cloud, in collaborazione con Anyscale, annuncia una versione potenziata di Ray su Google Kubernetes Engine (GKE) con integrazione nativa delle TPUs. La nuova Ray TPU Library gestisce automaticamente la topologia hardware, evitando la frammentazione delle risorse grazie al sistema SlicePlacementGroup.

Il supporto multi-slice consente addestramenti su larga scala, integrando JAX e PyTorch. Le API di scheduling basate su etichette (“label selectors”) permettono di specificare configurazioni hardware in modo dinamico, mentre il Ray Dashboard centralizza metriche e log per il debugging. L’architettura SPMD (Single Program, Multiple Data) connette i chip TPU via ICI (Interconnect Interface), migliorando throughput e riducendo i colli di bottiglia nei training multi-host. Queste innovazioni semplificano la configurazione e aumentano la produttività degli sviluppatori, trasformando Ray e Kubernetes in un vero sistema operativo distribuito per l’AI.

Gemini Enterprise per la ricerca scientifica

La piattaforma Gemini Enterprise emerge come un pilastro per la ricerca scientifica potenziata dall’AI. Gli scienziati sfruttano agenti Gemini 2.5 per analizzare letteratura, formulare ipotesi e generare codice, combinando HPC (High Performance Computing) e machine learning in un ambiente unificato. Le funzioni Deep Research e Idea Generation creano loop di brainstorming assistito, mentre Ensemble AI valuta le ipotesi più promettenti.

Il modulo Code Assist genera e corregge script in tempo reale, automatizzando la configurazione di ambienti virtuali, installazioni e test. Le VM H4D e A4 con GPU NVIDIA gestiscono simulazioni fisiche e addestramenti di modelli ML, mentre lo storage Lustre gestito elimina colli di bottiglia nelle pipeline di calcolo. In questo ecosistema, Gemini Enterprise si conferma come strumento strategico per trasformare i workflow scientifici in processi collaborativi e predittivi, riducendo drasticamente i tempi di ricerca.

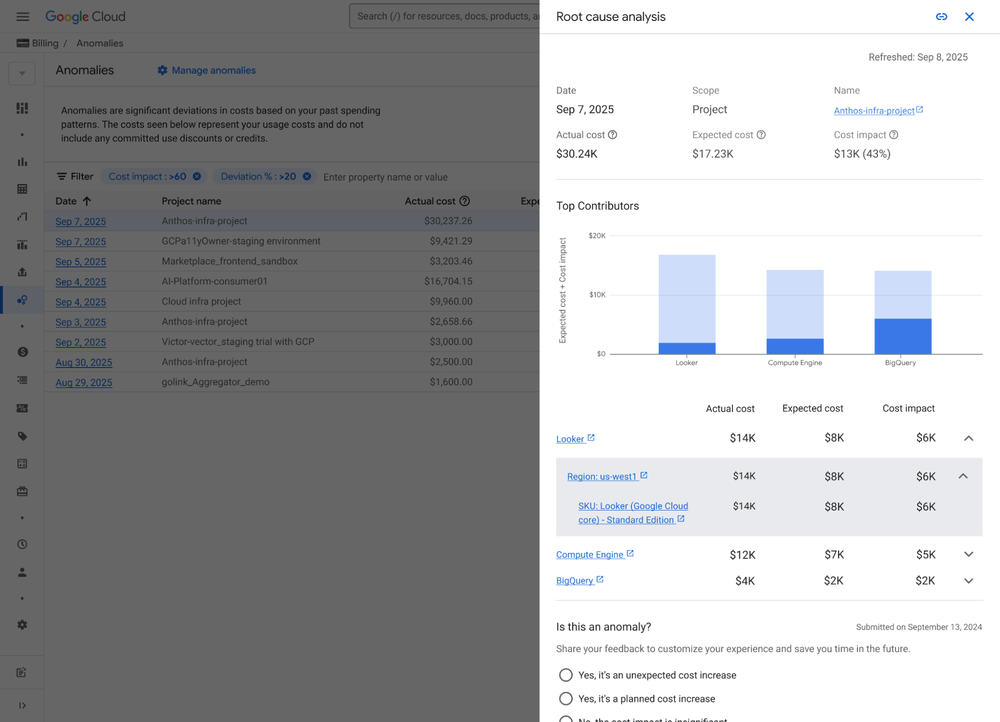

Rilevamento anomalie nei costi

Il servizio Cost Anomaly Detection di Google Cloud è ora disponibile in General Availability (GA), portando funzioni di monitoraggio proattivo dei costi a tutte le organizzazioni cloud. Basato su algoritmi di intelligenza artificiale, il sistema analizza la spesa storica e genera soglie dinamiche, inviando alert automatici agli amministratori di billing. I filtri personalizzabili considerano deviazioni percentuali e variazioni di trend, mentre la dashboard unificata visualizza spike e pattern anomali per progetto. Il servizio si integra nativamente nei flussi FinOps, riducendo il “rumore” di notifiche superflue e prevenendo sorprese di fatturazione. Il setup avviene tramite la console di billing, con configurazioni predefinite gratuite. La protezione immediata contro il “cold start” consente un’analisi predittiva fin dal primo giorno, rendendo il servizio un componente essenziale per il controllo economico del cloud ibrido.

Nuove feature di scaling AI su GKE

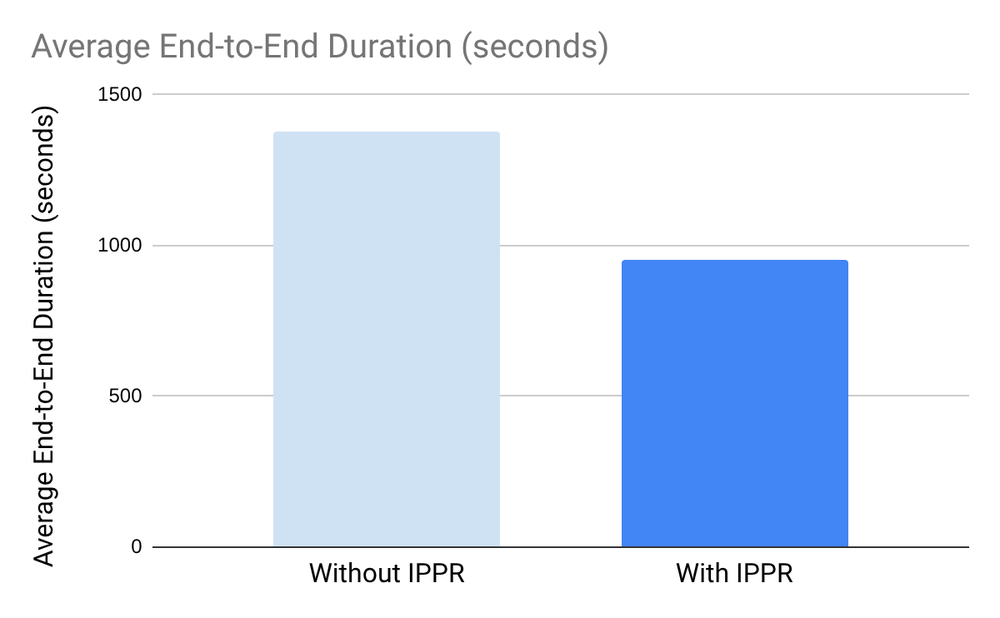

L’ecosistema Ray-GKE introduce ulteriori novità dedicate all’autoscaling e scheduling intelligente di carichi AI. I label selectors consentono di assegnare risorse a zone e acceleratori specifici, mentre i Compute Domain definiscono priorità hardware in cluster complessi. Con l’adozione di Dynamic Resource Allocation (DRA), il sistema supporta istanze avanzate come A4X con GPU GB200 NVL72, ottimizzando la distribuzione delle risorse su rack da 18 nodi.

L’integrazione dei cgroups scrivibili migliora l’isolamento dei processi e il controllo sui task critici. Inoltre, l’autoscaling verticale in-place introdotto in Kubernetes 1.33 riduce i tempi di provisioning da minuti a secondi, aumentando del 30% l’efficienza operativa e riducendo gli errori OOM. Queste funzionalità, combinate con il JAXTrainer di Ray 2.49, rendono GKE uno dei contesti più flessibili per l’addestramento di modelli AI su scala.

Implicazioni e vantaggi per l’ecosistema cloud

Le innovazioni di Google Cloud segnano un’evoluzione verso un modello operativo ibrido e distribuito, dove AI, automazione e ottimizzazione dei costi coesistono in un framework coerente. Sviluppatori riducono i tempi di setup, ricercatori generano insight più rapidi e aziende controllano la spesa in tempo reale. L’integrazione tra Spanner, Ray, Gemini Enterprise e FinOps AI ridefinisce l’efficienza cloud, trasformando l’infrastruttura in un ambiente cognitivo capace di adattarsi autonomamente ai workload. Secondo gli analisti, questa visione accelera la transizione verso un paradigma in cui l’intelligenza artificiale non è solo uno strumento, ma un collaboratore tecnico per la produttività globale.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.