Il panorama tecnologico di novembre 2025 è dominato da due fronti cruciali: la battaglia legale di Microsoft sulle licenze perpetue di Windows e la crescente crisi energetica dell’intelligenza artificiale, con data center che consumano livelli di elettricità paragonabili a quelli di interi Stati. A questo scenario si intrecciano sviluppi geopolitici e industriali: la Cina accelera nella produzione di semiconduttori e nell’hardware quantistico, Tesla punta alla stabilizzazione della rete con i suoi Megapack, Nvidia spinge verso la vertical integration dei server AI, e OpenAI annuncia progetti energetici dal peso planetario.

Microsoft e la battaglia legale sulle licenze perpetue

Microsoft ha presentato appello contro la sentenza del tribunale britannico che consente la rivendita delle licenze perpetue di Windows, decisione che mina uno dei pilastri del modello economico software. Il giudice di primo grado ha stabilito che i termini di licenza post-vendita non possono limitare i diritti dell’acquirente, legittimando di fatto il mercato secondario delle licenze. La causa è nata dal contenzioso con ValueLicensing, azienda specializzata nella rivendita di licenze aziendali usate, che accusa Microsoft di pratiche anticoncorrenziali. Il tribunale ha ordinato un risarcimento per danni e ha definito non vincolanti le clausole che impediscono la rivendita. Microsoft, tuttavia, sostiene che il software rientra tra le opere creative protette da copyright, e che il diritto d’uso non implica la proprietà del codice sorgente. L’esito dell’appello, atteso nel 2026, potrebbe ridefinire il mercato europeo del software enterprise, influenzando le politiche di acquisto delle imprese e il valore delle licenze perpetue. In attesa della sentenza definitiva, Microsoft ha iniziato a rivedere i propri contratti commerciali e le condizioni d’uso globali, mirando a rafforzare il modello cloud di Azure e a ridurre la dipendenza dai prodotti a licenza singola.

Tesla Megapack e la sfida energetica dell’intelligenza artificiale

Mentre il fronte legale si concentra sull’Europa, la crisi energetica dei data center AI assume proporzioni globali. Secondo le ultime stime, la domanda di potenza elettrica generata dai centri di calcolo dedicati all’intelligenza artificiale ha raggiunto i 250 gigawatt, equivalenti all’intero consumo dell’India.

In questo scenario, Tesla entra in campo con la soluzione Megapack, batterie modulari da 3,9 MWh con inverter da 1,5 MW progettate per alimentare data center e mitigare i picchi di consumo. Ogni unità, integrabile con energia solare ed eolica, punta a stabilizzare la rete e ridurre la dipendenza dai combustibili fossili. Elon Musk vede nel boom dell’AI un’occasione per espandere il business energetico di Tesla, che già fornisce soluzioni di microgrid a utility e hyperscaler. L’azienda sta potenziando la produzione dei Megapack in California e Shanghai, integrando software di gestione intelligente per il bilanciamento della domanda. Tuttavia, i critici sollevano dubbi sull’impatto ambientale del mining di litio e sulla sostenibilità a lungo termine dei materiali impiegati.

YMTC accelera la produzione di chip NAND nonostante le sanzioni

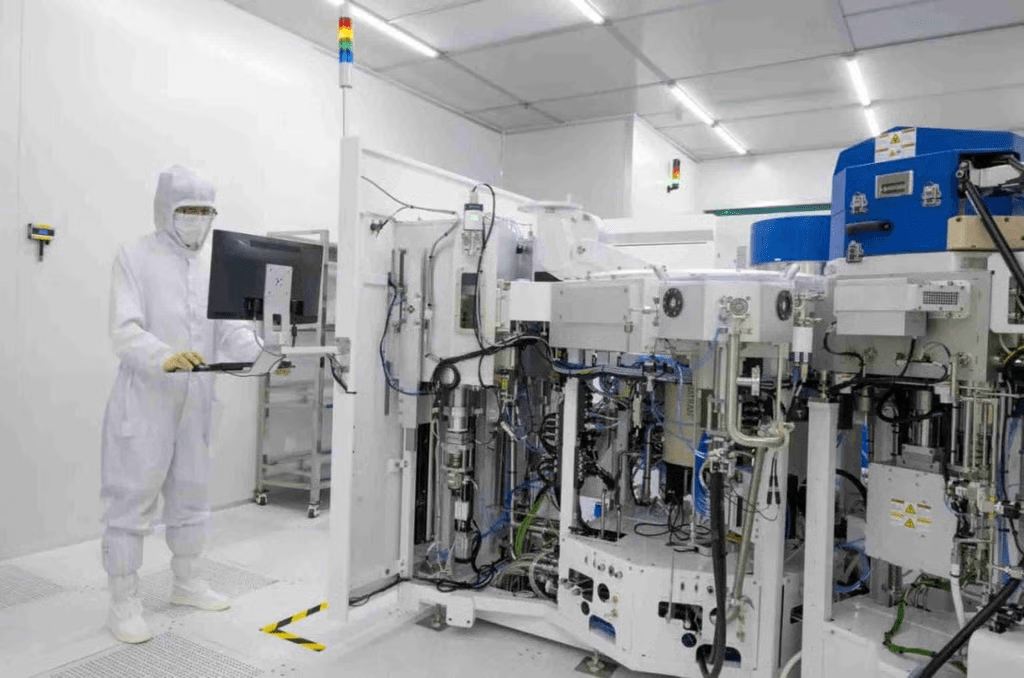

Sul fronte cinese, Yangtze Memory Technologies (YMTC) continua a espandersi nonostante le restrizioni imposte da Washington. La compagnia sta completando la terza fabbrica a Wuhan, con una capacità produttiva di oltre 300.000 wafer al mese.

Il nuovo impianto produce memorie 3D NAND a 232 strati, un traguardo tecnico che rafforza la competitività del settore domestico contro colossi come Samsung e Micron. Pur esclusa dall’accesso alle tecnologie EUV occidentali, YMTC sta adottando alternative locali e collabora con fornitori nazionali per sostituire componenti critici. L’obiettivo è raggiungere il 10% del mercato globale NAND entro il 2027, rendendo la Cina più autonoma nella supply chain dei semiconduttori. Le sanzioni USA, invece di rallentare, hanno spinto l’industria cinese verso una integrazione verticale interna e un massiccio supporto governativo in R&D e produzione.

Loophole cloud: GPU Nvidia Blackwell aggirano le sanzioni

In parallelo, una startup cinese è riuscita ad accedere a 2.300 GPU Nvidia Blackwell — ufficialmente vietate dalla lista export USA — attraverso un loophole cloud che sfrutta una società indonesiana. Quest’ultima fornisce accesso remoto a 32 rack GB200, eludendo i controlli commerciali grazie alla giurisdizione neutrale. La startup, impegnata nello sviluppo di modelli linguistici multimodali, paga per ore di calcolo e utilizza l’infrastruttura per addestrare reti neurali su scala industriale. Nvidia, secondo fonti interne, ha intensificato le verifiche sui partner cloud per evitare sanzioni secondarie da parte di Washington. Il caso mette in luce la difficoltà di applicare in modo uniforme le restrizioni tecnologiche e l’efficacia limitata dei controlli transnazionali su infrastrutture cloud distribuite.

Chip quantistico ottico cinese: mille volte più veloce di una GPU

Un altro annuncio dalla Cina scuote il panorama AI: un chip quantistico ottico in grado di superare di 1.000 volte le prestazioni delle GPU Nvidia in specifici carichi di lavoro di apprendimento automatico.

Il dispositivo, basato su qubit fotonici, consente computazioni parallele estremamente efficienti con un consumo energetico ridotto. Tuttavia, le rese di produzione restano basse, limitando la disponibilità industriale. I ricercatori cinesi puntano a migliorare la stabilità dei qubit e a integrare il chip in architetture ibride classico-quantistiche.

Se i prototipi attuali dovessero scalare entro il 2027, la Cina potrebbe guadagnare un vantaggio significativo nella AI quantistica, settore che promette elaborazioni su larga scala con un impatto energetico minore rispetto alle GPU tradizionali.

Nvidia spinge verso server AI completi con Vera Rubin

Secondo JP Morgan, Nvidia starebbe abbandonando il ruolo di semplice fornitore di GPU per diventare un vendor di sistemi completi. La nuova linea Vera Rubin integrerà CPU Grace, GPU Blackwell, moduli CUDA ottimizzati e infrastrutture di storage e networking in un unico rack proprietario. La strategia punta alla vertical integration, con margini più alti e una riduzione della dipendenza da partner come Dell e Supermicro. Nvidia mira a fornire soluzioni “chiavi in mano” per hyperscaler e istituti di ricerca, consolidando la propria posizione di leader assoluto nell’hardware AI.

DARPA investe 1,286 miliardi per una fonderia 3D in Texas

Negli Stati Uniti, la DARPA annuncia un investimento di 1,286 miliardi di euro per creare una fonderia 3D in Texas, destinata alla produzione di chip stacked ad alte prestazioni. Il progetto, parte del programma “NextGen Microelectronics”, mira a ridurre la dipendenza asiatica e a potenziare la supply chain militare americana. La struttura svilupperà packaging avanzato e nuovi materiali termici, con prototipi previsti per il 2026. L’iniziativa consolida l’ecosistema semiconduttori texano, integrando ricerca universitaria e industria privata in un piano coordinato di rilancio tecnologico.

OpenAI e il consumo energetico equivalente all’India

Nel frattempo, OpenAI annuncia piani per una rete di data center da 250 gigawatt, un consumo equivalente all’intero fabbisogno elettrico dell’India. Il progetto, basato su 30 milioni di GPU annue, solleva allarmi ambientali: le emissioni previste superano del doppio quelle di ExxonMobil. L’azienda promette di utilizzare fonti rinnovabili e sistemi di raffreddamento liquido ad alta efficienza, ma gli analisti temono che l’impatto della corsa all’AI possa superare la capacità di compensazione ecologica. Secondo i dati interni, i nuovi cluster ridurranno la latenza di addestramento e aumenteranno la capacità di modelli da trilioni di parametri, ma a costi energetici insostenibili nel lungo periodo. La corsa globale all’intelligenza artificiale ha dunque un nuovo protagonista: l’energia, divenuta risorsa strategica tanto quanto i chip o i dati.

Iscriviti alla Newsletter

Non perdere le analisi settimanali: Entra nella Matrice Digitale.

Matrice Digitale partecipa al Programma Affiliazione Amazon EU. In qualità di Affiliato Amazon, ricevo un guadagno dagli acquisti idonei. Questo non influenza i prezzi per te.